This the multi-page printable view of this section. Click here to print.

Java 并发

- 1: CH01-并发体系

- 2: CH02-理论基础

- 3: CH03-线程基础-1

- 4: CH04-线程基础-2

- 5: CH05-Synchronized

- 6: CH06-Volatile

- 7: CH07-Final

- 8: CH08-并发概览

- 9: CH09-底层支撑

- 10: CH10-LockSupport

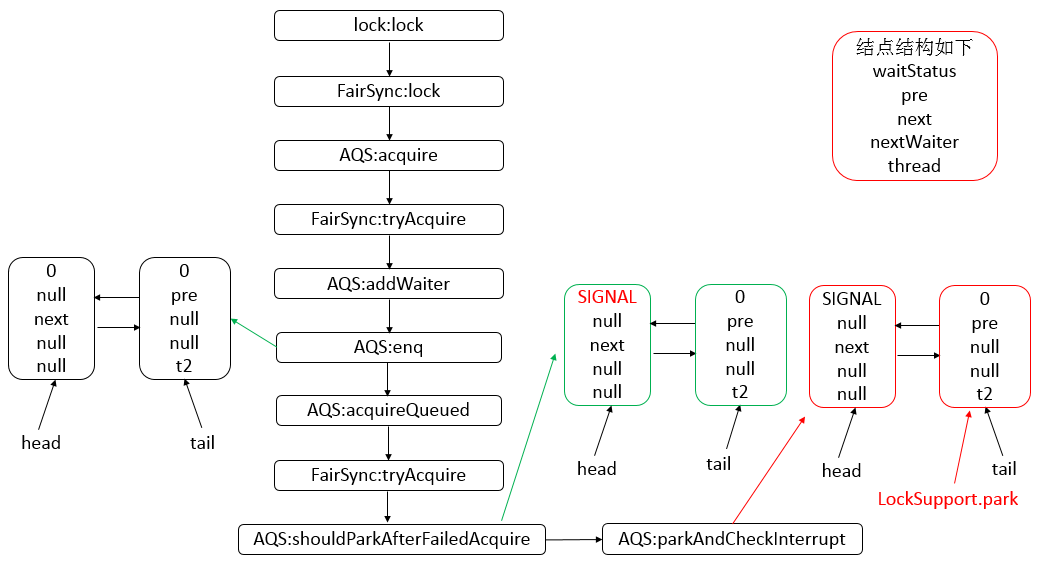

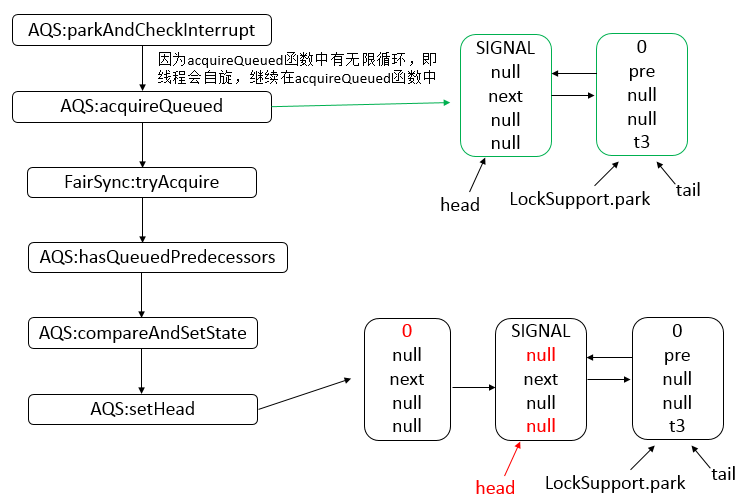

- 11: CH11-AQS-1

- 12: CH12-AQS-2

- 13: CH13-AQS-3

- 14: CH14-AQS-4

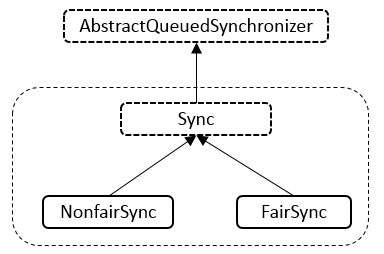

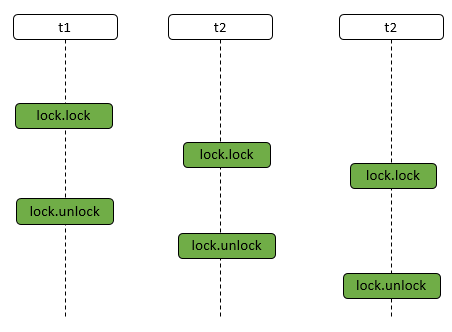

- 15: CH15-ReentrantLock

- 16: CH16-ReentrantReadWriteLock

- 17: CH17-ConcurrentHashMap

- 18: CH18-ConcurrentLinkedQueue

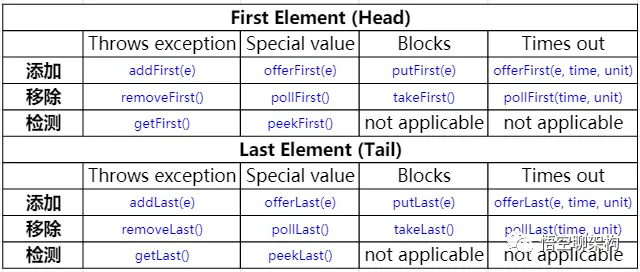

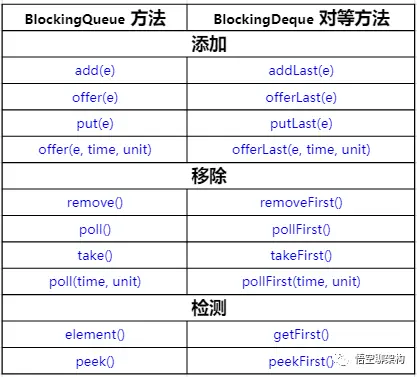

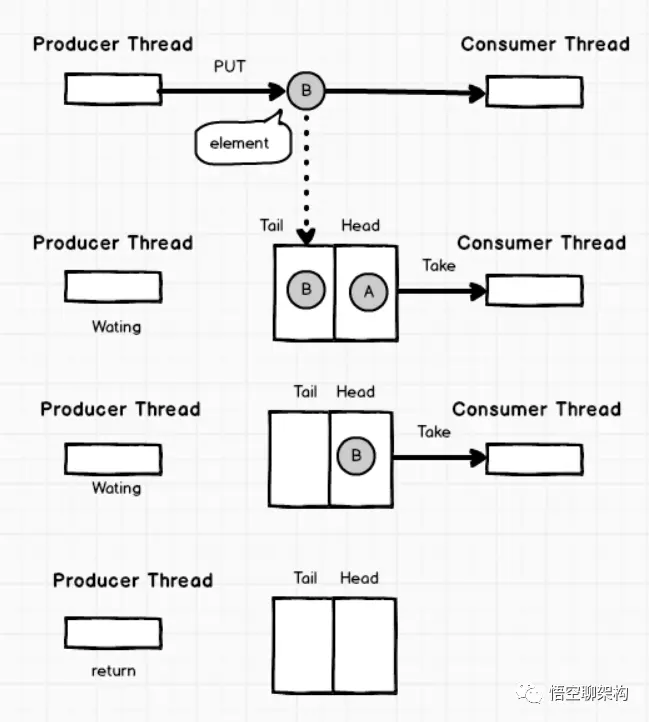

- 19: CH19-BlockingQueue

- 20: CH20-FutureTask

- 21: CH21-ThreadPoolExecutor

- 22: CH22-ScheduledThreadPoolExecutor

- 23: CH23-ForkJoin.md

- 24: CH24-CountDownLatch

- 25: CH25-CyclicBarrier

- 26: CH26-Semaphore

- 27: CH27-Phaser

- 28: CH28-Exchanger

- 29: CH29-ThreadLocal

- 30: CH30-AllLocks

- 31: CH31-AllQueues

- 32: CH32-AllPools

1 - CH01-并发体系

理论基础

- 为什么需要多线程

- 什么是线程不安全

- 并发问题的根源

- 可见性

- 原子性

- 有序性

- Java 提供的方案

- 关键字

- volatile

- synchronized

- final

- 内存模型

- Happens Before 规则

- 锁优化

- 关键字

- 线程安全的范围

- 不可变

- 绝对线程安全

- 相对线程安全

- 线程兼容

- 线程对立

- 实现方法

- 互斥同步

- synchronized

- ReentrantLock

- 非阻塞同步

- CAS

- Atomic Class

- 无同步方案

- 栈封闭

- ThreadLocal

- 可重入代码 Reentrant Code

- 互斥同步

线程基础

- 线程状态转换

- 新建 New

- 可运行 Runnable

- 阻塞 Blocking

- 无限期等待 Waiting

- 限期等待 Timed Waiting

- 终止 Terminated

- 线程使用方式

- 实现 Runnable 接口

- 继承 Thread 类

- 实现 Callable 接口

- 线程基础机制

- Executor

- Daemon

- sleep

- yield

- 线程中断

- InterruptedException

- interrupted()

- Executor 的中断操作

- 线程互斥同步

- synchronized

- ReentrantLock

- 线程协作

- join()

- wait() notify() notifyAll()

- await() signal() signalAll()

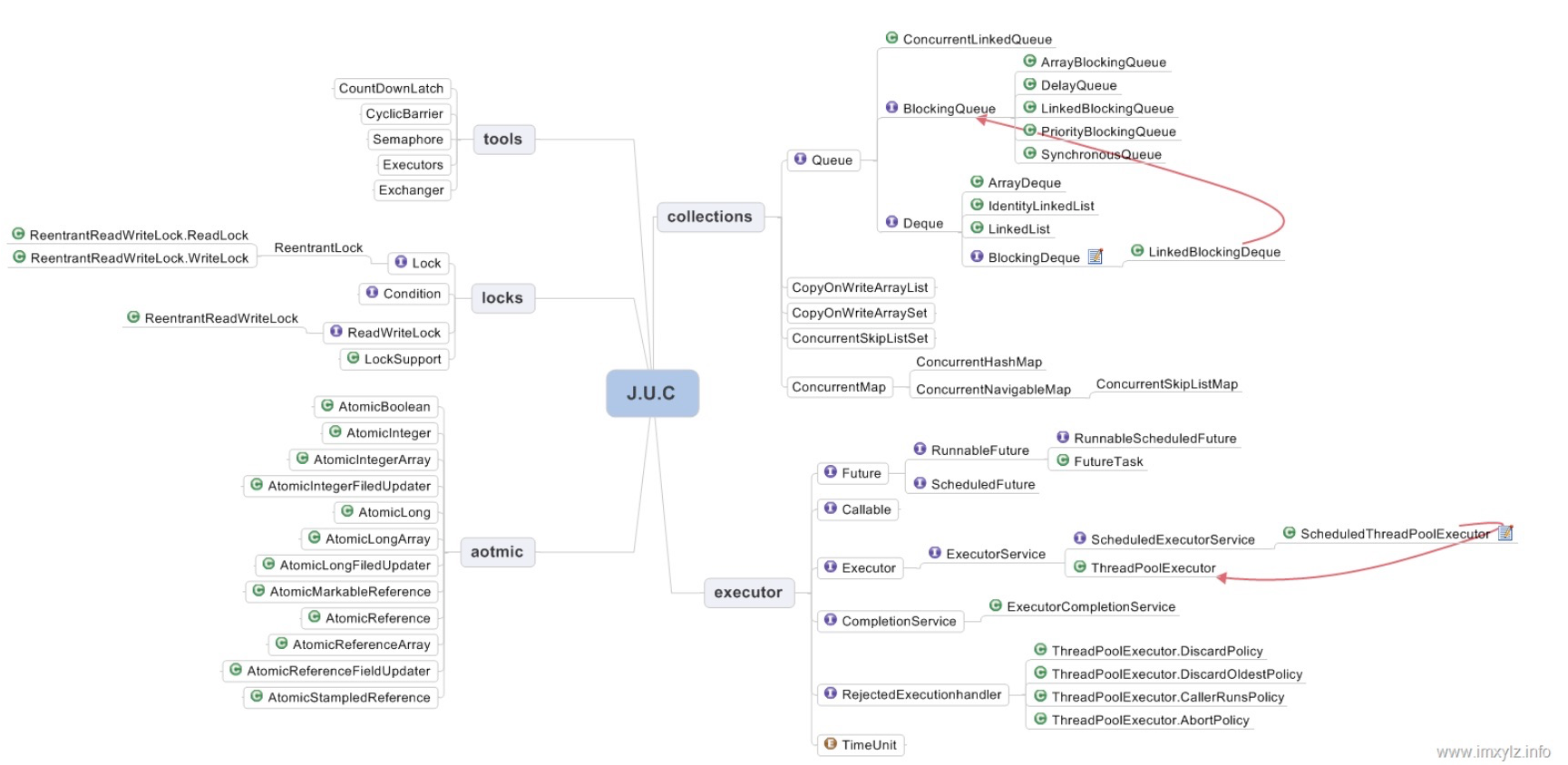

并发工具

- Locks

- Lock 接口

- AQS

- Condition

- LockSupport

- 重入锁 ReentrantLock

- 读写锁 ReadWriteLock

- Collections

- ConcurrentHashMap

- ConcurrentLinkedQueue

- BlockingQueue

- CopyOnWriteArrayList

- Executors

- Executor

- ForkJoin

- ThreadPoolExecutor

- FutureTask

- Atomic

- 基本类型

- AtomicBoolean

- AtomicInteger

- AtomicLong

- Array

- AtomicBooleanArray

- AtomicIntegerArray

- AtomicLongArray

- Reference

- AtomicReference

- AtomicMarkedReference

- AtomicStampedReference

- FieldUpdater

- AtomicIntegerFiledUpdater

- AtomicLongFiledUpdater

- AtomicReferenceFiledUpdater

- 基本类型

- Tools

- CountDownLatch

- CyclicBarrier

- Semaphore

- Excahnger

并发本质

- 协作

- 管理

- Lock & Condition

- synchronized

- 信号量 Semaphone

- CountDownLatch

- CyclicBarrier

- Pharser

- Exchanger

- 管理

- 分工

- Executor 与 ThreadPool

- ForkJoin

- Future

- 模式

- Guarded Suspension

- ThreadPerMessage

- Balking

- Worker Thread

- 两阶段终止

- 生产消费

- 互斥

- 无锁

- CAS

- Atomic

- 模式

- Imutablity

- CopyOnWrite

- ThreadLocal

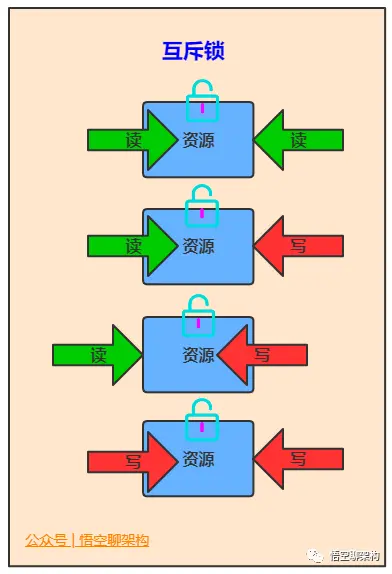

- 互斥锁

- synchronized

- Lock

- ReadWriteLock

- 无锁

并发模式

框架案例

- Guava RateLimitor

- Netty

- Disrutor

- HikariCP

2 - CH02-理论基础

多线程的优势

CPU、内存、IO 设备的速度存在巨大差异,为了合理利用 CPU 的高性能,平衡三者之间的速度差异,计算机体系结构、操作系统、编译程序实现了相关优化:

- CPU 增加了缓存,以平衡与内存的速度差异——导致了可见性问题

- 操作系统提供了进程、线程,以分时复用 CPU,进而均衡 CPU 与 IO 设备之间的速度差异——导致原子性问题

- 编译程序优化了指令执行顺序,使缓存能够得到更合理的利用——导致了有序性问题

线程不安全

如果多个线程对同一份数据执行读写而不采取同步措施的话,可能导致混乱(非预期)的操作结果。

class ThreadUnsafeCounter {

private int count =0;

public void add() {

count++;

}

public int get() {

return count;

}

}

class Bootstrap {

public static void main(String[] args) {

int threadSize=1000;

ThreadUnsafeCounter counter = new ThreadUnsafeCounter();

CountDownLatch latch = new CountDownLatch(threadSize);

ExecutorService executor = Executors.newCachedThreadPool();

for(int i=0;i<threadSize;i++){

executor.execute(() -> {

counter.add();

latch.countDown();

})

}

latch.await();

executor.shutdown();

System.out.println(counter.get()); // will always < 1000

}

}

并发三要素

可见性:CPU 缓存

可见性:一个线程对共享变量的修改,其他线程能够立即看到。

// thread 1

int i=0;

i=10;

// thread 2

j = i;

如果 CPU1 执行 Thread1、CPU2 执行 Thread2。当 Thread1 执行 i=10 时,会首先将 i 的初始值加载到 CPU1 的高速缓存中,然后赋值为 10,那么在 CPU1 的高速缓存中 i 的值变为了 10,却被没有被立即写回主存。

此时 Thread2 执行 j=i,首先去主存读取 i 的值加载到 CPU2 的高速缓存,(这时主存中 i 的值仍未 0),这就导致 j 的值为 0,而非 10。

原子性:分时复用

原子性:一个操作或多个操作那么全都执行,要么全不执行,不会被任何因素打断。

有序性:指令重排序

有序性:程序执行的顺序完全按照代码的先后顺序执行。

程序执行时为了提高性能,编译器和处理器通常会对执行进行重排序,分为三种类型:

编译器优化:编译器再不改变单线程程序语义的前提下,重新安排语句的执行顺序。

指令级并行:现代处理器采用了指令级并行技术来将多条指令重叠执行。如果不存在数据依赖,处理器可以改变语句对应机器指令的执行顺序。

内存系统重排序:由于处理器通过高速缓存读写缓冲区,是的加载和存储操作看上去实在乱序执行。

从 Java 代码到最终要执行的指令序列,会经历以上三种重排序。

- 第一种属于编译器重排序,2、3 属于处理器重排序。

- 这些重排序可能会导致多线程程序出现内存可见性问题。对于编译器,JMM 中的编译器重排序规则会禁止特定类型的重排序操作。

- 对于处理器重排序,JMM 的处理器重排序规则会要求 Java 编译器在生成指令序列时,插入特定类型的内存屏障指令,通过这些内存屏障指令来禁止特定类型的处理器重排序操作。

Java 如何解决并发问题:JMM

核心知识点

Java 内存模型规范了 JVM 如何提供按需禁用编译和缓存优化的方法。

- volatile、synchronized、final 关键字

- Happens Before 规则

可见性、有序性、原子性

- 原子性:Java 中通过 synchronized 和 Lock 实现原子性保证。

- 可见性:Java 中通过 volatie 提供可见性保证。

- synchronized 和 Lock 保证同一时刻只有一个线程获取锁然后执行代码,释放锁前或将数据刷新到主存。

- 有序性:Java 中通过 volatile 保证一定的有序性。

- synchronized 和 Lock 保证同一时刻只有一个线程执行,相当于多个线程顺序执行代码,即有序执行。

volatile、synchronized、final

Happens Before

除了 volatile、synchronized、Lock 能够保证有序性,JVM 还规定了先行发生规则,使一个操作无需显式控制即可保证先于另一个操作发生。

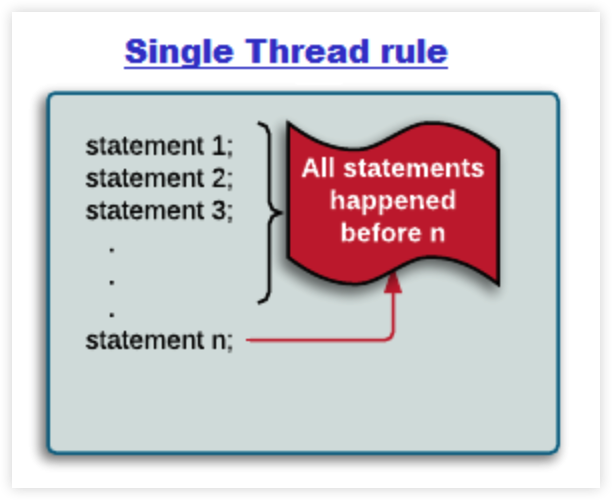

单一线程:Single Thread Rule

在一个线程内,程序中前面的操作先于后面的操作。

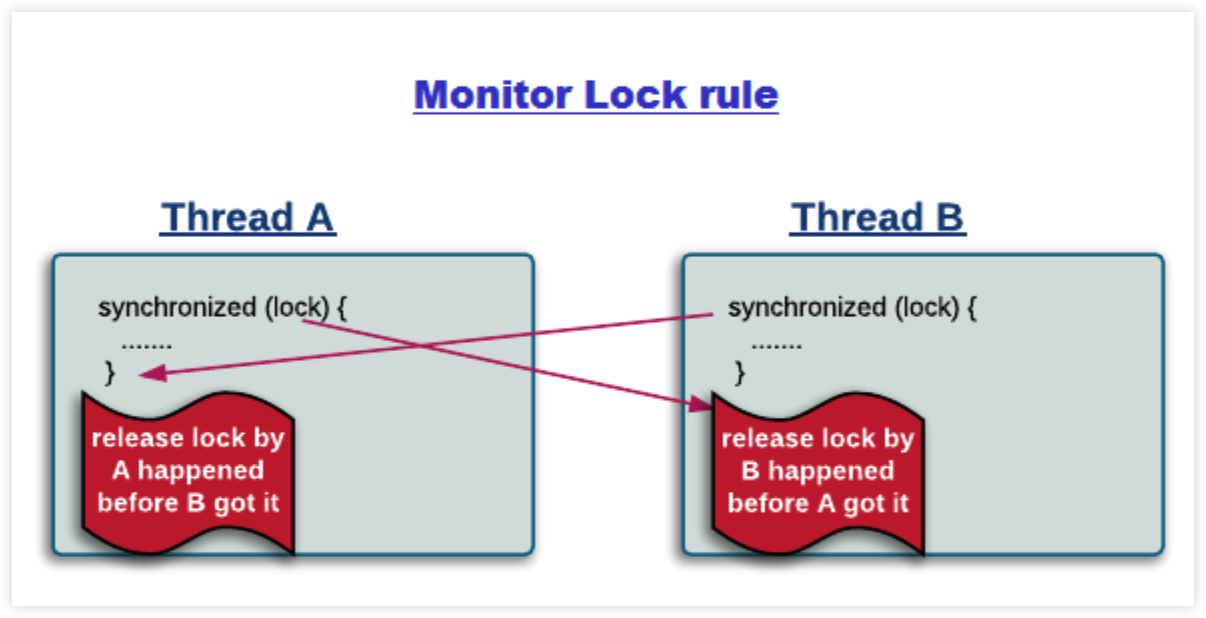

管程锁定:Monitor Lock Rule

- 一个 unlock 操作先于后面对一个锁的 lock 操作。

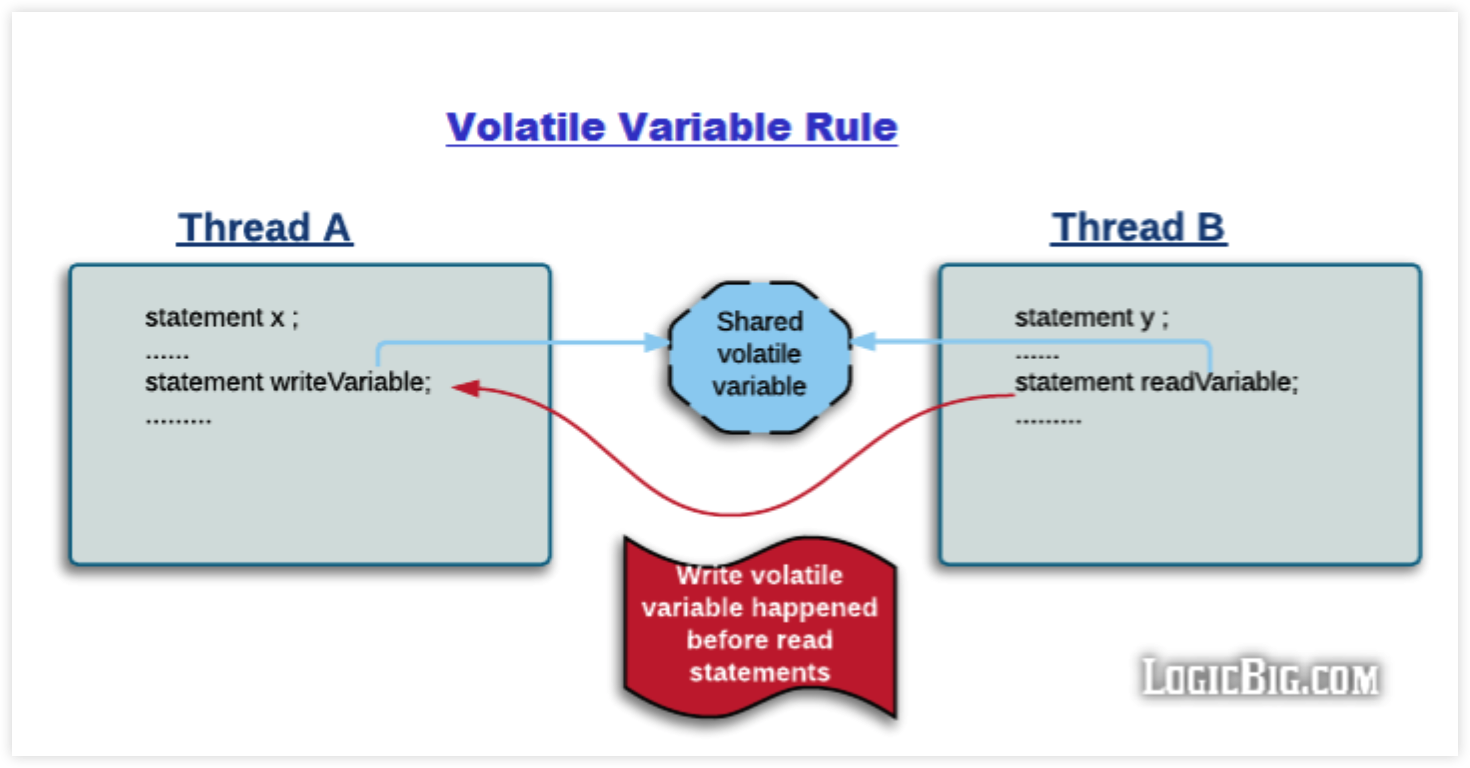

Volatile 变量:Volatile Variable Rule

对一个 volatile 变量的写操作先于对该变量的读操作。

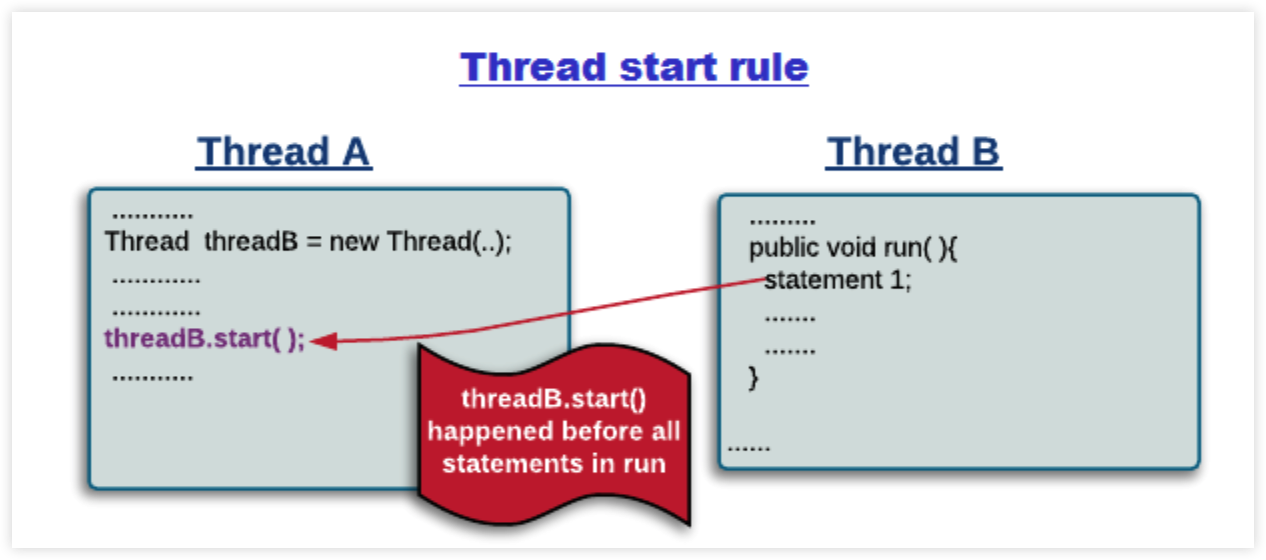

线程启动:Thread Start Rule

Thread 对象的 start 方法先于该线程的每一个动作。

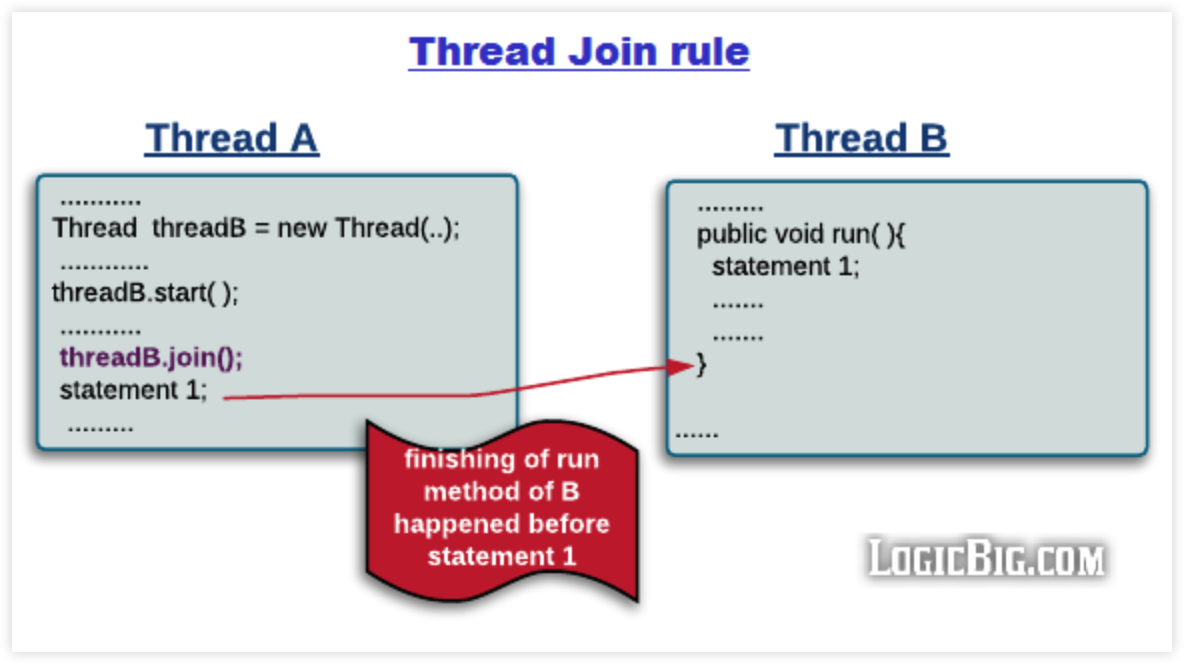

线程加入:Thread Join Rule

Thread 对象的结束先于 join 方法返回。

线程中断:Thread Interruption Rule

- 对线程 interrupt 方法的调用先于检测到中断的代码执行。

对象终结:Finalizer Rule

- 对象构造函数执行完成先于 finalize 方法开始。

传递性:Transitivity

- 如果操作 A 先于 B,B 先于 C,那么 A 先于 C。

线程安全:安全程度

一个类可以被多个线程安全调用时,该类就是线程安全的。

将共享数据按照安全程度的强弱来划分安全强度的等级:

- 不可变

- 绝对线程安全

- 相对线程安全

- 线程兼容

- 线程对立

不可变

不可变(Immutable)的对象一定是线程安全的,不需要再采取任何的线程安全保障措施。只要一个不可变的对象被正确地构建出来,永远也不会看到它在多个线程之中处于不一致的状态。

final 关键字修饰的基本数据类型

String

枚举类型

Number 部分子类,如 Long 和 Double 等数值包装类型,BigInteger 和 BigDecimal 等大数据类型。但同为 Number 的原子类 AtomicInteger 和 AtomicLong 则是可变的。

Collections.unmodifiableXXX() 先对原始的集合进行拷贝,需要对集合进行修改的方法都直接抛出异常。

绝对线程安全

不管运行时环境如何,调用者都不需要任何额外的同步措施。

相对线程安全

相对线程安全需要保证对这个对象单独的操作是线程安全的,在调用的时候不需要做额外的保障措施。但是对于一些特定顺序的连续调用,就可能需要在调用端使用额外的同步手段来保证调用的正确性。

在 Java 语言中,大部分的线程安全类都属于这种类型,例如 Vector、HashTable、Collections 的 synchronizedCollection() 方法包装的集合等。

线程兼容

线程兼容是指对象本身并不是线程安全的,但是可以通过在调用端正确地使用同步手段来保证对象在并发环境中可以安全地使用,我们平常说一个类不是线程安全的,绝大多数时候指的是这一种情况。Java API 中大部分的类都是属于线程兼容的,如与前面的 Vector 和 HashTable 相对应的集合类 ArrayList 和 HashMap 等。

线程对立

线程对立是指无论调用端是否采取了同步措施,都无法在多线程环境中并发使用的代码。由于 Java 语言天生就具备多线程特性,线程对立这种排斥多线程的代码是很少出现的,而且通常都是有害的,应当尽量避免。

线程安全:实现

互斥同步—阻塞同步

- synchronized

- ReentrantLock

非阻塞同步

互斥同步最主要的问题就是线程阻塞和唤醒所带来的性能问题,因此这种同步也称为阻塞同步。

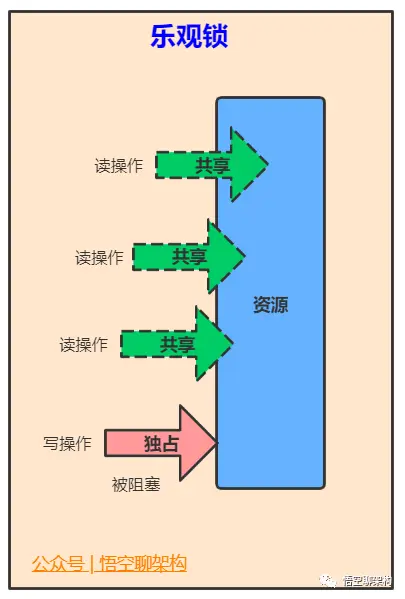

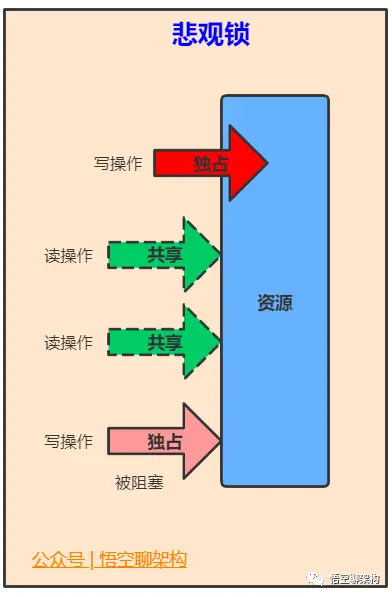

互斥同步属于一种悲观的并发策略,总是认为只要不去做正确的同步措施,那就肯定会出现问题。无论共享数据是否真的会出现竞争,它都要进行加锁(这里讨论的是概念模型,实际上虚拟机会优化掉很大一部分不必要的加锁)、用户态核心态转换、维护锁计数器和检查是否有被阻塞的线程需要唤醒等操作。

- CAS

随着硬件指令集的发展,我们可以使用基于冲突检测的乐观并发策略: 先进行操作,如果没有其它线程争用共享数据,那操作就成功了,否则采取补偿措施(不断地重试,直到成功为止)。这种乐观的并发策略的许多实现都不需要将线程阻塞,因此这种同步操作称为非阻塞同步。

乐观锁需要操作和冲突检测这两个步骤具备原子性,这里就不能再使用互斥同步来保证了,只能靠硬件来完成。硬件支持的原子性操作最典型的是: 比较并交换(Compare-and-Swap,CAS)。CAS 指令需要有 3 个参数,分别是内存地址 V、旧的预期值 A 和新值 B。当执行操作时,只有当 V 的值等于 A,才将 V 的值更新为 B。

- AtomicInteger

J.U.C 包里面的整数原子类 AtomicInteger,其中的 compareAndSet() 和 getAndIncrement() 等方法都使用了 Unsafe 类的 CAS 操作。

public final int incrementAndGet() {

return unsafe.getAndAddInt(this, valueOffset, 1) + 1;

}

public final int getAndAddInt(Object var1, long var2, int var4) {

int var5;

do {

var5 = this.getIntVolatile(var1, var2);

} while(!this.compareAndSwapInt(var1, var2, var5, var5 + var4));

return var5;

}

var1 指示对象内存地址,var2 指示该字段相对对象内存地址的偏移,var4 指示操作需要加的数值,这里为 1。通过 getIntVolatile(var1, var2) 得到旧的预期值,通过调用 compareAndSwapInt() 来进行 CAS 比较,如果该字段内存地址中的值等于 var5,那么就更新内存地址为 var1+var2 的变量为 var5+var4。

可以看到 getAndAddInt() 在一个循环中进行,发生冲突的做法是不断的进行重试。

- ABA

如果一个变量初次读取的时候是 A 值,它的值被改成了 B,后来又被改回为 A,那 CAS 操作就会误认为它从来没有被改变过。

J.U.C 包提供了一个带有标记的原子引用类 AtomicStampedReference 来解决这个问题,它可以通过控制变量值的版本来保证 CAS 的正确性。大部分情况下 ABA 问题不会影响程序并发的正确性,如果需要解决 ABA 问题,改用传统的互斥同步可能会比原子类更高效。

无同步方案

要保证线程安全,并不是一定就要进行同步。如果一个方法本来就不涉及共享数据,那它自然就无须任何同步措施去保证正确性。

- 栈封闭

多个线程访问同一个方法的局部变量时,不会出现线程安全问题,因为局部变量存储在虚拟机栈中,属于线程私有的。

- ThreadLocal

如果一段代码中所需要的数据必须与其他代码共享,那就看看这些共享数据的代码是否能保证在同一个线程中执行。如果能保证,我们就可以把共享数据的可见范围限制在同一个线程之内,这样,无须同步也能保证线程之间不出现数据争用的问题。

符合这种特点的应用并不少见,大部分使用消费队列的架构模式(如“生产者-消费者”模式)都会将产品的消费过程尽量在一个线程中消费完。其中最重要的一个应用实例就是经典 Web 交互模型中的“一个请求对应一个服务器线程”(Thread-per-Request)的处理方式,这种处理方式的广泛应用使得很多 Web 服务端应用都可以使用线程本地存储来解决线程安全问题。

可以使用 java.lang.ThreadLocal 类来实现线程本地存储功能。每个 Thread 都有一个 ThreadLocal.ThreadLocalMap 对象,Thread 类中就定义了 ThreadLocal.ThreadLocalMap 成员。

/* ThreadLocal values pertaining to this thread. This map is maintained

* by the ThreadLocal class. */

ThreadLocal.ThreadLocalMap threadLocals = null;

ThreadLocal 从理论上讲并不是用来解决多线程并发问题的,因为根本不存在多线程竞争。

- 可重入代码

这种代码也叫做纯代码(Pure Code),可以在代码执行的任何时刻中断它,转而去执行另外一段代码(包括递归调用它本身),而在控制权返回后,原来的程序不会出现任何错误。

可重入代码有一些共同的特征,例如不依赖存储在堆上的数据和公用的系统资源、用到的状态量都由参数中传入、不调用非可重入的方法等。

3 - CH03-线程基础-1

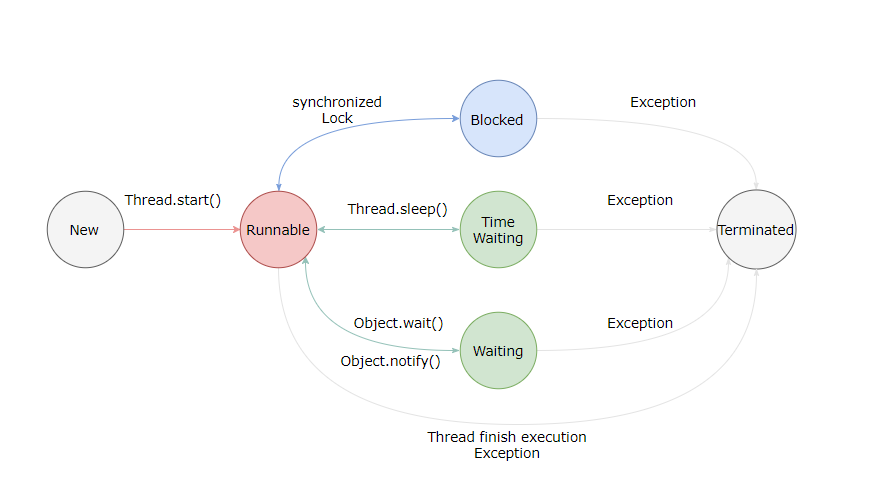

线程状态

- New:新建,创建后尚未启动。

- Runnable:可运行,可能正在运行,也可能在等待 CPU 时间片。

- 包含操作系统线程状态的 Running 和 Ready。

- Blocking:等待获取一个排它锁,如果其他线程释放了锁就会结束该状态。

- Waiting:无限期等待,需要其他线程唤醒,否则不会分配 CPU 时间片。

- 未设置 Timeout 参数的 Object.wait 方法,需要 Object.notify 或 Object.notifyAll 唤醒

- 未设置 Timeout 参数的 Thread.join 方法,被调用的线程执行完毕

- LockSupport.park 调用

- Timed Waiting:限时等待,在一定时间后自动唤醒。

- 调用 Thread.sleep 方法,线程睡眠

- 设置了 Timeout 参数调用 Object.wait 进入限期等待,挂起线程

- 睡眠和挂起用于表述行为,阻塞和等待用于描述状态

- 阻塞和等待的区别在于,阻塞是被动的,等待的是一个排它锁,锁的释放由其他线程决定。

- 等待是祖东的,等待的是一个时间点,是线程自身通过 Thread.sleep 或 Object.wait 主动触发的等待。

- 设置了 Timeout 参数调用 Thread.join 方法

- LockSupport.parkNanos

- LockSupport.parkUntil

- Terminated:死亡,线程结束任务之后自然死亡,或异常导致任务终止而死亡

应用方式

- 实现 Runnable 接口:无返回值

- 实现 Callable 接口:有返回值

- 继承 Thread 类

实现 Runnable 后 Callable 接口的类只能被当做是一个可以在线程中执行的任务,并不是真正意义上的线程实例,因此最后还是需要通过 Thread 类来调用。即任务是通过线程来执行的。

线程机制

Executor

Executor 管理多个异步任务的执行,而无需开发者显式管理线程的生命周期。这里的异步是指多个任务的执行互不干扰,不需要执行同步操作。

- CachedThreadPool:每个任务创建一个线程

- FixedThreadPool:所有任务共用固定数量的线程

- SingleThreadExecutor:仅有一个线程的 FixedThreadPool

Daemon

守护线程是程序运行时在后台提供服务的线程,不属于程序中必要的部分,非必须。

- 当所有非守护线程结束时,程序即终止,同时会杀死所有守护线程。

- main 属于非守护线程。

- 通过 setDaemon 方法将一个线程设置为守护线程。

sleep

Thread.sleep(millisec) 方法会休眠当前正在执行的线程,millisec 单位为毫秒。

sleep() 可能会抛出 InterruptedException,因为异常不能跨线程传播回 main() 中,因此必须在本地进行处理。线程任务可能出现的其它异常也同样需要在本地进行处理。

yield

对静态方法 Thread.yield() 的调用表示当前线程已经完成了生命周期中最重要的部分,可以切换给其它线程来执行。该方法只是对线程调度器的一个建议,而且也只是建议具有相同优先级的其它线程可以运行。

线程中断

一个线程执行完毕之后会自动结束,如果在运行过程中发生异常也会提前结束。

InterruptedException

通过调用一个线程的 interrupt() 来中断该线程,如果该线程处于阻塞、限期等待或者无限期等待状态,那么就会抛出 InterruptedException,从而提前结束该线程。但是不能中断 I/O 阻塞和 synchronized 锁阻塞。

对于以下代码,在 main() 中启动一个线程之后再中断它,由于线程中调用了 Thread.sleep() 方法,因此会抛出一个 InterruptedException,从而提前结束线程,不执行之后的语句。

public class InterruptExample {

private static class MyThread1 extends Thread {

@Override

public void run() {

try {

Thread.sleep(2000);

System.out.println("Thread run");

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

public static void main(String[] args) throws InterruptedException {

Thread thread1 = new MyThread1();

thread1.start();

thread1.interrupt();

System.out.println("Main run");

}

// 在线程 sleep 期间中断,“Thread run” 将不会被打印

Main run

java.lang.InterruptedException: sleep interrupted

at java.lang.Thread.sleep(Native Method)

at InterruptExample.lambda$main$0(InterruptExample.java:5)

at InterruptExample$$Lambda$1/713338599.run(Unknown Source)

at java.lang.Thread.run(Thread.java:745)

}

interrupted

如果一个线程的 run() 方法执行一个无限循环,并且没有执行 sleep() 等会抛出 InterruptedException 的操作,那么调用线程的 interrupt() 方法就无法使线程提前结束。

但是调用 interrupt() 方法会设置线程的中断标记,此时调用 interrupted() 方法会返回 true。因此可以在循环体中使用 interrupted() 方法来判断线程是否处于中断状态,从而提前结束线程。

public class InterruptExample {

private static class MyThread2 extends Thread {

@Override

public void run() {

while (!interrupted()) {

// ..

}

System.out.println("Thread end");

}

}

public static void main(String[] args) throws InterruptedException {

Thread thread2 = new MyThread2();

thread2.start();

thread2.interrupt();

}

// Thread end

}

Executor 中断操作

调用 Executor 的 shutdown() 方法会等待线程都执行完毕之后再关闭,但是如果调用的是 shutdownNow() 方法,则相当于调用每个线程的 interrupt() 方法。

以下使用 Lambda 创建线程,相当于创建了一个匿名内部线程。

ExecutorService executorService = Executors.newCachedThreadPool();

executorService.execute(() -> {

try {

Thread.sleep(2000);

System.out.println("Thread run");

} catch (InterruptedException e) {

e.printStackTrace();

}

});

executorService.shutdownNow();

System.out.println("Main run");

// 在线程 sleep 期间被中断,不会打印 "Thread run"

Main run

java.lang.InterruptedException: sleep interrupted

如果想要中断 Executor 中的一个线程,可以通过 submit 方法提交一个任务,然后返回一个 Future 对象,调用该 Future 对象的 cancel 方法即可中断对应线程:

Future<?> future = executorService.submit(() -> {

// ..

});

future.cancel(true);

线程同步:互斥

Java 提供了两种锁机制来控制多个线程对共享资源的互斥访问,第一个是 JVM 实现的 synchronized,而另一个是 JDK 实现的 ReentrantLock。

synchronized

- 同步代码块

- 只作用于同一个对象实例,比如 new Object(),如果调用两个对象上的同步代码块,就不会进行同步。

- 同步方法

- 它和同步代码块一样,作用于同一个对象。只是作用在了该方法所属的实例。

- 同步类

- 作用于整个类,也就是说两个线程调用同一个类的不同对象上的这种同步语句,也会进行同步。

- 同步静态方法

- 作用于整个类。

ReentrantLock

ReentrantLock 是 java.util.concurrent(J.U.C)包中的锁。

private Lock lock = new ReentrantLock();

public void func() {

lock.lock();

try {

for (int i = 0; i < 10; i++) {

System.out.print(i + " ");

}

} finally {

lock.unlock(); // 确保释放锁,从而避免发生死锁。

}

}

基本对比

- 实现层次:

- synchronized 是 JVM 实现的,而 ReentrantLock 是 JDK 实现的。

- 性能:

- 新版本 Java 对 synchronized 进行了很多优化,例如自旋锁等,synchronized 与 ReentrantLock 大致相同。

- 等待可中断:

- 当持有锁的线程长期不释放锁的时候,正在等待的线程可以选择放弃等待,改为处理其他事情。

- ReentrantLock 可中断,而 synchronized 不行。

- 公平锁

- 公平锁是指多个线程在等待同一个锁时,必须按照申请锁的时间顺序来依次获得锁。

- synchronized 中的锁是非公平的,ReentrantLock 默认情况下也是非公平的,但是也可以是公平的。

- 锁绑定多个条件

- 一个 ReentrantLock 可以同时绑定多个 Condition 对象。

应用选择

除非需要使用 ReentrantLock 的高级功能,否则优先使用 synchronized。这是因为 synchronized 是 JVM 实现的一种锁机制,JVM 原生地支持它,而 ReentrantLock 不是所有的 JDK 版本都支持。并且使用 synchronized 不用担心没有释放锁而导致死锁问题,因为 JVM 会确保锁的释放。

线程协作

当多个线程可以一起工作去解决某个问题时,如果某些部分必须在其它部分之前完成,那么就需要对线程进行协调。

join

在线程中调用另一个线程的 join() 方法,会将当前线程挂起,而不是忙等待,直到目标线程结束。

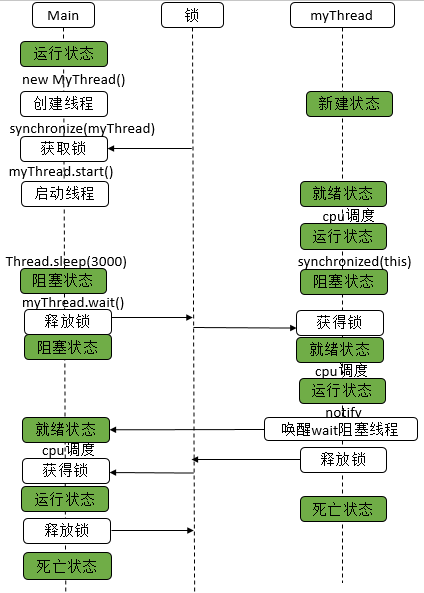

wait、notify、notifyAll

调用 wait() 使得线程等待某个条件满足,线程在等待时会被挂起,当其他线程的运行使得这个条件满足时,其它线程会调用 notify() 或者 notifyAll() 来唤醒挂起的线程。

它们都属于 Object 的一部分,而不属于 Thread。

只能用在同步方法或者同步控制块中使用,否则会在运行时抛出 IllegalMonitorStateExeception。

使用 wait() 挂起期间,线程会释放锁。这是因为,如果没有释放锁,那么其它线程就无法进入对象的同步方法或者同步控制块中,那么就无法执行 notify() 或者 notifyAll() 来唤醒挂起的线程,造成死锁。

public class WaitNotifyExample {

public synchronized void before() {

System.out.println("before");

notifyAll();

}

public synchronized void after() {

try {

wait();

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("after");

}

public static void main(String[] args) {

ExecutorService executorService = Executors.newCachedThreadPool();

WaitNotifyExample example = new WaitNotifyExample();

executorService.execute(() -> example.after());

executorService.execute(() -> example.before());

}

// before

// after

}

wait() 和 sleep() 的区别

- wait() 是 Object 的方法,而 sleep() 是 Thread 的静态方法;

- wait() 会释放锁,sleep() 不会。

await() signal() signalAll()

JUC 类库中提供了 Condition 类来实现线程之间的协调,可以在 Condition 上调用 await() 方法使线程等待,其它线程调用 signal() 或 signalAll() 方法唤醒等待的线程。相比于 wait() 这种等待方式,await() 可以指定等待的条件,因此更加灵活。

使用 Lock 来获取一个 Condition 对象。

public class AwaitSignalExample {

private Lock lock = new ReentrantLock();

private Condition condition = lock.newCondition();

public void before() {

lock.lock();

try {

System.out.println("before");

condition.signalAll();

} finally {

lock.unlock();

}

}

public void after() {

lock.lock();

try {

condition.await();

System.out.println("after");

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

public static void main(String[] args) {

ExecutorService executorService = Executors.newCachedThreadPool();

AwaitSignalExample example = new AwaitSignalExample();

executorService.execute(() -> example.after());

executorService.execute(() -> example.before());

}

// before

// after

}

4 - CH04-线程基础-2

Create Thread

- What happens when creating a Thread instance

Thread thread = new Thread(){

@Override

public void run() {

// code

}

};

// at this point the thread is in NEW state, all you have a simple java object,

// no actual thread is created

thread.start();

// when start() is invoked, at some unspecified point in the near future

// the thread will go into RUNNABLE state, this means an actual thread will be created.

// That can happen before start() returns.

- 通过

new创建线程时,你只是创建了一个 Thread 类的实例,该 Thread 实例的状态为 NEW。 - 通过

thread.start()调用线程时,该 Thread 实例的状态将会在未来某个时刻变为 RUNNABLE,这表示 OS 级别的线程将被创建,这部分工作由 JVM 完成。

用户空间 & 内核空间

在操作系统中,内存通常会被分成用户空间(User space)与内核空间(Kernel space)这两个部分。当进程/线程运行在用户空间时就处于用户态,运行在内核空间时就处于内核态:

- 运行在内核态的程序可以访问用户空间和内核空间,或者说它可以访问计算机的任何资源,不受限制,为所欲为,例如协调 CPU 资源,分配内存资源,提供稳定的环境供应用程序运行等

- 而应用程序基本都是运行在用户态的,或者说用户态就是提供应用程序运行的空间。运行在用户态的程序只能访问用户空间

那为什么要区分用户态和内核态呢?

早期操作系统是不区分用户态和内核态的,也就是说应用程序可以访问任意内存空间,如果程序不稳定常常会让系统崩溃,比如清除了操作系统的内存数据。为此大佬们设计出了一套规则:对于那些比较危险的操作需要切到内核态才能运行,比如 CPU、内存、设备等资源管理器程序就应该在内核态运行,否则安全性没有保证。

用户态的程序不能随意操作内核地址空间,这样有效地防止了操作系统程序受到应用程序的侵害。

那如果处于用户态的程序想要访问内核空间的话怎么办呢?就需要进行系统调用从用户态切换到内核态。

操作系统线程

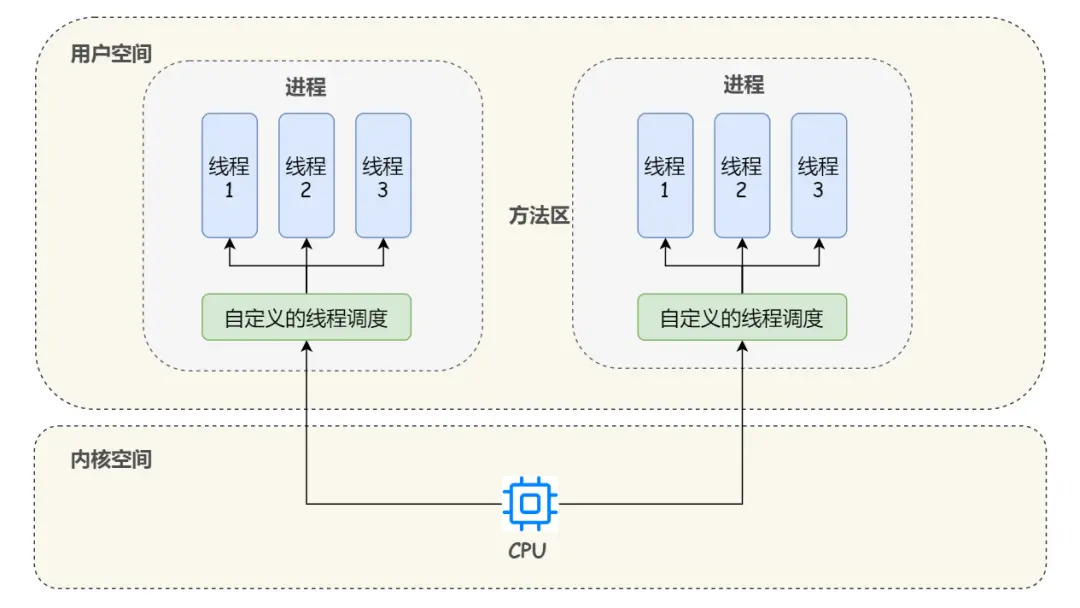

在用户空间实现线程

在早期的操作系统中,所有的线程都是在用户空间下实现的,操作系统只能看到线程所属的进程,而不能看到线程。

从我们开发者的角度来理解用户级线程就是说:在这种模型下,我们需要自己定义线程的数据结构、创建、销毁、调度和维护等,这些线程运行在操作系统的某个进程内,然后操作系统直接对进程进行调度。

这种方式的好处一目了然,首先第一点,就是即使操作系统原生不支持线程,我们也可以通过库函数来支持线程;第二点,线程的调度只发生在用户态,避免了操作系统从内核态到用户态的转换开销。

当然缺点也很明显:由于操作系统看不见线程,不知道线程的存在,而 CPU 的时间片切换是以进程为维度的,所以如果进程中某个线程进行了耗时比较长的操作,那么由于用户空间中没有时钟中断机制,就会导致此进程中的其它线程因为得不到 CPU 资源而长时间的持续等待;另外,如果某个线程进行系统调用时比如缺页中断而导致了线程阻塞,此时操作系统也会阻塞住整个进程,即使这个进程中其它线程还在工作。

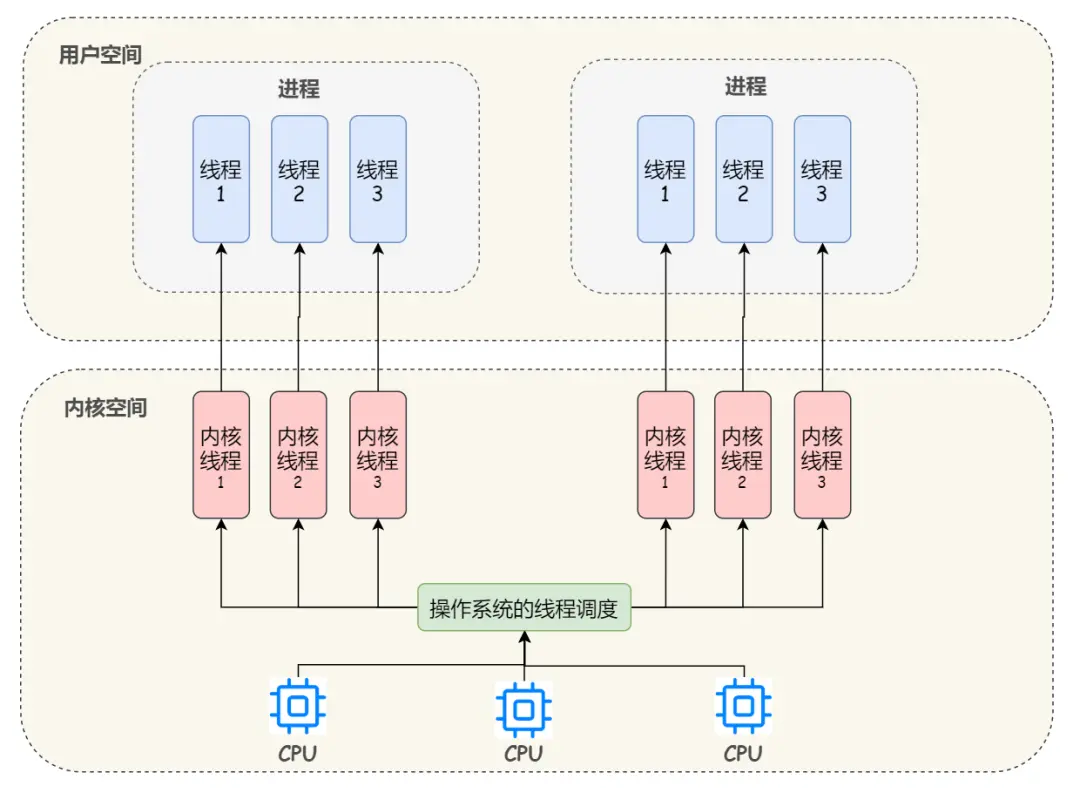

在内核空间中实现线程

所谓内核级线程就是运行在内核空间的线程, 直接由内核负责,只能由内核来完成线程的调度。

每个内核线程可以视为内核的一个分身,这样操作系统就有能力同时处理多件事情,支持多线程的内核就叫做多线程内核(Multi-Threads Kernel)。

从我们开发者的角度来理解内核级线程就是说:我们可以直接使用操作系统中已经内置好的线程,线程的创建、销毁、调度和维护等,都是直接由操作系统的内核来实现,我们只需要使用系统调用就好了,不需要像用户级线程那样自己设计线程调度等。

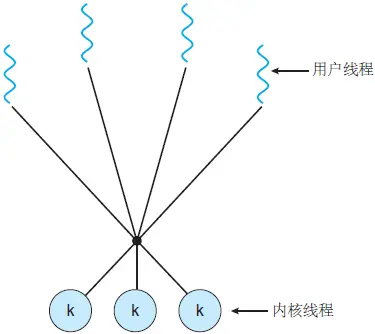

上图画的是 1:1 的线程模型,所谓线程模型,也就是用户线程和内核线程之间的关联方式,线程模型当然不止 1:1 这一种,下面我们来详细解释以下这三种多线程模型:

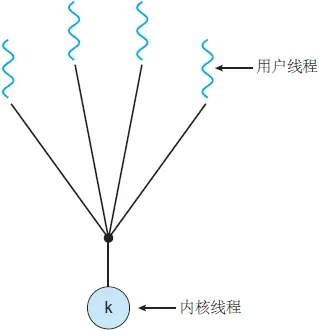

1. 多对一线程模型:

- 在多对一模型中,多个用户级线程映射到某一个内核线程上

- 线程管理由用户空间中的线程库处理,这非常有效

- 但是,如果进行了阻塞系统调用,那么即使其他用户线程能够继续,整个进程也会阻塞

- 由于单个内核线程只能在单个 CPU 上运行,因此多对一模型不允许在多个 CPU 之间拆分单个进程

从并发性角度来总结下,虽然多对一模型允许开发人员创建任意多的用户线程,但是由于内核只能一次调度一个线程,所以并未增加并发性。现在已经几乎没有操作系统来使用这个模型了,因为它无法利用多个处理核。

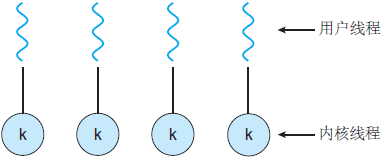

2. 一对一线程模型:

- 一对一模型克服了多对一模型的问题

- 一对一模型创建一个单独的内核线程来处理每个用户线程

- 但是,管理一对一模型的开销更大,涉及更多开销和减慢系统速度

- 此模型的大多数实现都限制了可以创建的线程数

从并发性角度来总结下,虽然一对一模型提供了更大的并发性,但是开发人员应注意不要在应用程序内创建太多线程(有时系统可能会限制创建线程的数量),因为管理一对一模型的开销更大。

3. 多对多线程模型:

- 多对多模型将任意数量的用户线程复用到相同或更少数量的内核线程上,结合了一对一和多对一模型的最佳特性

- 用户对创建的线程数没有限制

- 阻止内核系统调用不会阻止整个进程

- 进程可以分布在多个处理器上

- 可以为各个进程分配可变数量的内核线程,具体取决于存在的 CPU 数量和其他因素

Java Thread

在上面的模型介绍中,我们提到了通过线程库来创建、管理线程,那么什么是线程库呢?

线程库就是为开发人员提供创建和管理线程的一套 API。

当然,线程库不仅可以在用户空间中实现,还可以在内核空间中实现。前者涉及仅在用户空间内实现的 API 函数,没有内核支持。后者涉及系统调用,也就是说调用库中的一个 API 函数将会导致对内核的系统调用,并且需要具有线程库支持的内核。

下面简单介绍下三个主要的线程库:

POSIX Pthreads:可以作为用户或内核库提供,作为 POSIX 标准的扩展

Win32 线程:用于 Window 操作系统的内核级线程库

Java 线程:Java 线程 API 通常采用宿主系统的线程库来实现,也就是说在 Win 系统上,Java 线程 API 通常采用 Win API 来实现,在 UNIX 类系统上,采用 Pthread 来实现。

事实上,在 JDK 1.2 之前,Java 线程是基于称为 “绿色线程”(Green Threads)的用户级线程实现的,也就是说程序员大佬们为 JVM 开发了自己的一套线程库或者说线程管理机制。

而在 JDK 1.2 及以后,JVM 选择了更加稳定且方便使用的操作系统原生的内核级线程,通过系统调用,将线程的调度交给了操作系统内核。而对于不同的操作系统来说,它们本身的设计思路基本上是完全不一样的,因此它们各自对于线程的设计也存在种种差异,所以 JVM 中明确声明了:虚拟机中的线程状态,不反应任何操作系统中的线程状态。

也就是说,在 JDK 1.2 及之后的版本中,Java 的线程很大程度上依赖于操作系统采用什么样的线程模型,这点在不同的平台上没有办法达成一致,JVM 规范中也并未限定 Java 线程需要使用哪种线程模型来实现,可能是一对一,也可能是多对多或多对一。

总结来说,现今 Java 中线程的本质,其实就是操作系统中的线程,其线程库和线程模型很大程度上依赖于操作系统(宿主系统)的具体实现,比如在 Windows 中 Java 就是基于 Wind32 线程库来管理线程,且 Windows 采用的是一对一的线程模型。

Java线程调度

线程调度是指系统为线程分配处理使用权的过程,调度主要方式有两种,分别是协同式(Cooperative Threads-Scheduling)线程调度和抢占式(Preemptive Threads-Scheduling)线程调度。

- 协同式线程调度:线程的执行时间由线程本身来控制,线程把自己的工作执行完了之后,要主动通知系统切换到另外一个线程上去。 优点:实现简单,切换操作对线程自己是可知的,所以一般没有什么线程同步问题。 缺点:线程执行时间不可控制,甚至如果一个线程的代码编写有问题,一直不告知系统进行线程切换,那么程序就会一直阻塞在那里。

- 抢占式线程调度:每个线程将由系统来分配执行时间,线程的切换不由线程本身来决定。

优点:可以主动让出执行时间(例如Java的

Thread::yield()方法),并且线程的执行时间是系统可控的,也不会有一个线程导致整个系统阻塞的问题。 缺点:无法主动获取执行时间。

Java使用的就是抢占式线程调度,虽然这种方式的线程调度是系统自己的完成的,但是我们可以给操作系统一些建议,就是通过设置线程优先级来实现。Java语言一共设置了10个级别的线程优先级。在两个线程同时处于Ready状态时,优先级越高的线程越容易被系统选择执行。

不过由于各个系统的提供的优先级数量不一致,所以导致Java提供的10个级别的线程优先级并不见得能与各系统的优先级都一一对应。

Java 线程状态转换

Java语言定义了6种线程状态,在任意一个时间点钟,一个线程只能有且只有其中的一种状态,并且可以通过特定的方法在不同状态之间切换。

- 新建(New):创建后尚未启动的线程处于这种状态。

- 运行(Runnable):包括操作系统线程状态中的Running和Ready,也就是处理此状态的线程有可能正在执行,也有可能正在等待着操作系统为它分配执行时间。

- 无限期等待(Waiting):处于这种状态的线程不会被分配处理器执行时间,它们要等待被其他线程显示唤醒。

以下方法会让线程陷入无限期等待状态:

1、没有设置Timeout参数的

Object::wait()方法; 2、没有设置Timeout参数的Thread::join()方法; 3、LockSupport::park()方法。 - 限期等待(Timed Waiting):处于这种状态的线程也不会被分配处理器执行时间,不过无须等待被其他线程显式唤醒,在一定时间之后它们会由系统自动唤醒。

以下方法会让线程进入限期等待状态:

1、

Thread::sleep()方法; 2、设置了Timeout参数的Object::wait()方法; 3、设置了Timeout参数的Thread::join()方法; 4、LockSupport::parkNanos()方法; 5、LockSupport::parkUntil()方法; - 阻塞(Blocked):线程被阻塞了,“阻塞状态”与“等待状态”的区别是“阻塞状态”在等待着获取到一个排他锁,这个事件将在另外一个线程放弃这个锁的时候发生;而“等待状态”则是在等待一段时间 ,或者唤醒动作发生。在程序进入同步区域的时候,线程将进入这种状态。

- 结束(Terminated):已终止线程的线程状态,线程已经结束执行。

Thread.sleep

如果执行了 Thread.sleep, 底层的执行流程:

- JVM 调用底层 OS 的线程 API

- 因为 JVM 采用关于内核线性一对一的线程模型, JVM 会要求操作系统在执行的时间内将线程的使用权归还给 CPU

- 一旦休眠时间到期, OS 调度器将会通过中断来唤醒线程, 并为线性分配 CPU 时间片以恢复该线程的执行

这里的关键点是, JVM 层面的这个线程在休眠期间是完全无法被复用的。

但是一个 JVM 内部能够创建的线程数量是有限的的,创建过多则会引起 OOM。

- java.lang.OutOfMemoryError : unable to create new native Thread

JVM 中的每个线程都会带来昂贵的内存开销,它会附带一个线程栈。

太多的 JVM 线程将产生开销,因为上下文切换非常昂贵,而且它们共享有限的硬件资源。

How to Thread.sleep without blocking on the JVM | by Daniel Sebban | Medium

5 - CH05-Synchronized

应用实践

- 一把锁同时只能被一个线程获取,没有获得锁的线程只能等待。

- 每个对象实例都有自己的锁(this),该锁不同实例之间互不影响。

- synchronized 修饰的方法,物理方法成功还是抛出异常,都会释放锁。

对象锁

包含实例方法锁(this)和同步代码块锁(自定义)。

代码块形式:手动设置锁定对象,也可以是 this,也可以是自定义的(对象实例)锁。

syhchronized(this)synchronized(object),比如new Object()作为一个实例锁。

方法锁形式:修饰实例的方法,锁对象是 this。

class Example { public synchronized void show() { System.out.println("example..."); } }

类锁

指 synchronized 修饰静态的方法或指定锁对象为 Class 对象。

静态方法:

class Example { public synchronized static void show() { System.out.println("example..."); } }Class 对象:

class Example { public void show() { synchronized(Example.class) { System.out.println("example..."); } } }

原理分析

加锁-解锁

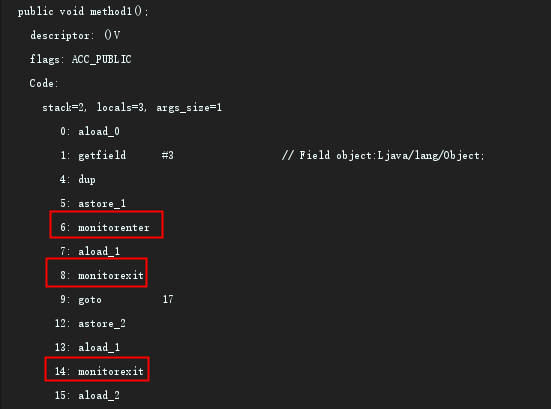

创建如下代码:

public class SynchronizedDemo2 {

Object object = new Object();

public void method1() {

synchronized (object) {

}

}

}

使用 javac 命令编译生成 class 文件:

javac SynchronizedDemo2.java

使用 javap 命令反编译查看 class 文件的信息:

javap -verbose SynchronizedDemo2.class

得到如下信息:

mointorenter 和 moniterexit 指令,会在程序执行时,使其锁计数器加一或减一。每个对象在同一时间只有一个 mointor(锁) 与其相关联,而一个 mointor 在同一时间只能被一个线程获得,一个对象在尝试获得与该对象关联的 monitor 锁的所有权时,monitorenter 指令会发生如下三种情况之一:

- mointor 计数器为 0,意味着目前尚未被某个线程获得,该线程会立即获得锁并将计数器加一,一旦执行加一,别的线程要想再获取就需要等待。

- 如果该线程已经拿到了该 mointor 锁的所有权,又重入了这把锁,锁计数器会继续累加一,值变为 2,随着重入次数的增加,计数值会一直累加。

- 如果该 monitor 锁已经被其他线程获得,当前线程等待锁被释放。

monitorexit 指令将释放对应 monitor 锁的所有权,释放过程很简单,即将 monitor 的计数器减一,如果结果不为 0,则表示当前是重入获得的锁,当前线程还继续持有该锁的所有权,如果计数器为 0,则表示当前线程不再拥有该 monitor 的所有权,即释放了锁。

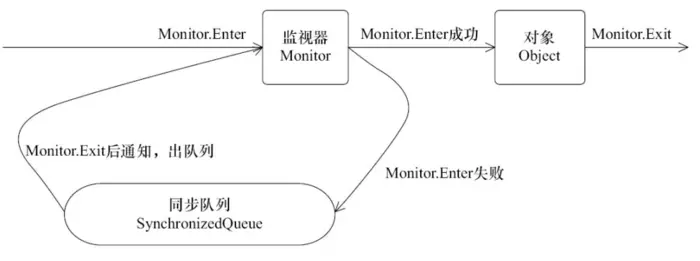

下图描绘了真个过程:

上图可以看出,任意线程对 Object 的访问,首先要获得 Object 的监视锁,如果获取失败,该线程就会进入同步状态,线程状态变为 Blocked,当 Object 的监视器占有者释放后,在同步队列中的线程就有就会获取到该监视器。

可冲入:加锁次数计数器

在同一个线程中,线程不需要再次获取通一把锁。synchronized 先天具有重入性。每个对象拥有一个计数器,当线程获取对象 monitor 锁后,计数器就会加一,释放锁后就会减一。

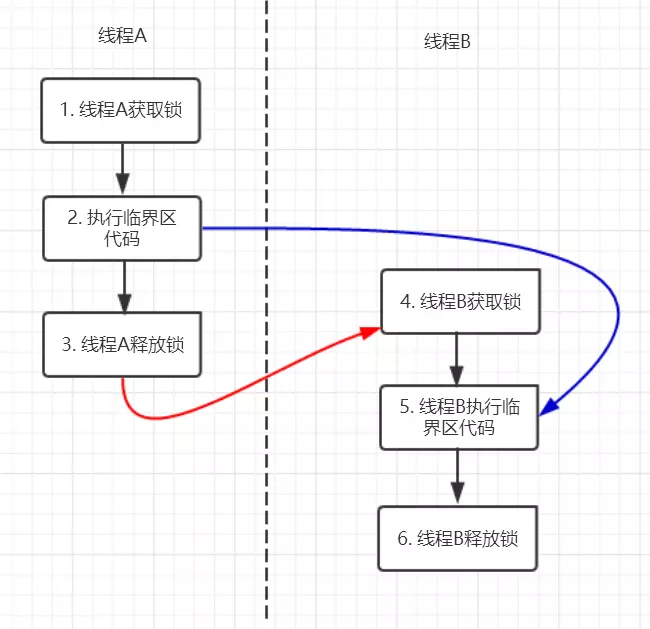

可见性保证:内存模型与 happens-before

synchronized 的 happens-before 规则,即监视器锁规则:(一个线程)对同一个监视器解锁,happens-before 于(另一个线程)对该监视器加锁。

public class MonitorDemo {

private int a = 0;

public synchronized void writer() { // 1

a++; // 2

} // 3

public synchronized void reader() { // 4

int i = a; // 5

} // 6

}

图中每个箭头的两个节点之间都是 happens-before 关系。黑色箭头由程序顺序规则推导得出,红色为监视器锁规则推导而出:线程 A 释放锁先于线程 B 获得锁。蓝色则是通过程序顺序规则和监视器锁规则推测出来的 happens-before 关系,通过传递性规则进一步推导出 happens-before 规则。

根据 happens-before 的定义:如果 A 先于 B,则 A 的执行顺序先于 B,并且 A 的执行结果对 B 可见。

线程 A 先对共享变量 +1,由 2 先于 5 得知线程 A 的执行结果对 B 可见,即 B 读取到 a 的值为 1。

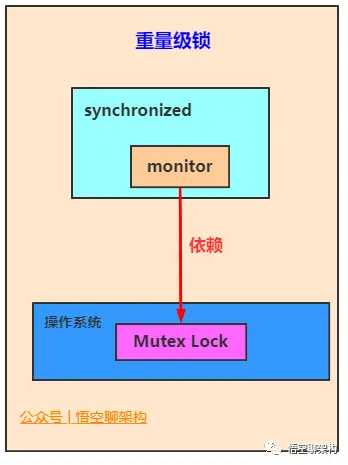

JVM 锁优化

JVM 在执行 monitorenter 和 monitorexit 这些指令时,依赖于底层操作系统的 Mutex Lock(互斥锁),但是由于 Mutex Lock 需要挂起当前线程,并从用户态切换到内核态来执行,这种切换的代价昂贵。然而在大部分的实际情况中,同步方法是运行在单线程环境(无锁竞争环境),如果每次都调用 Mutex Lock 则会严重影响性能。

JDK 1.6 引入了大量优化来提升性能:

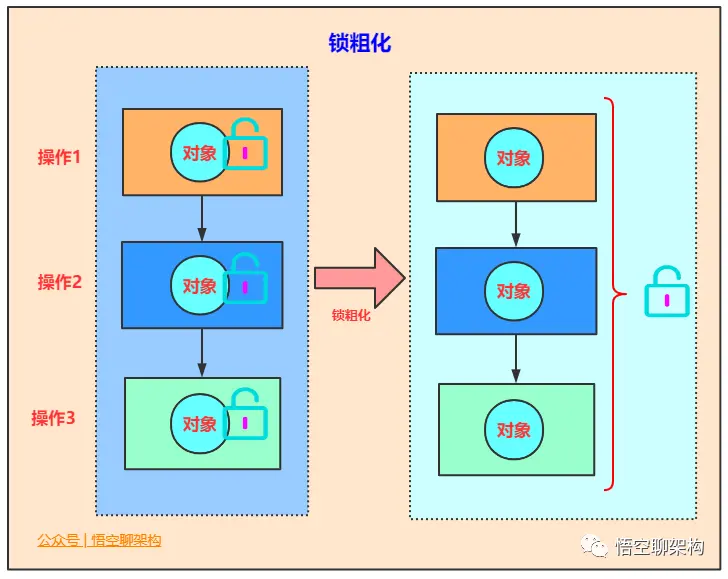

- 锁粗化:减少不必要的紧连在一起的加锁、解锁操作,将多个连续的小锁扩展为一个更大的锁。

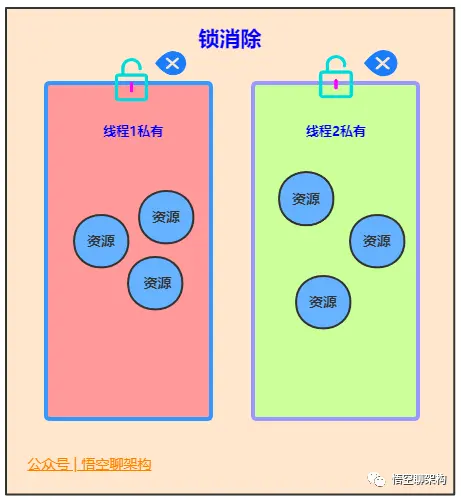

- 锁消除:通过运行时 JIT 编译器的逃逸分析来消除一些没有在当前同步块以外被其他线程共享的数据的锁保护,通过逃逸分析也可以在线程本地 Stack 上进行空间对象的分配(通知还可以减少 Heap 上垃圾收集的开销)。

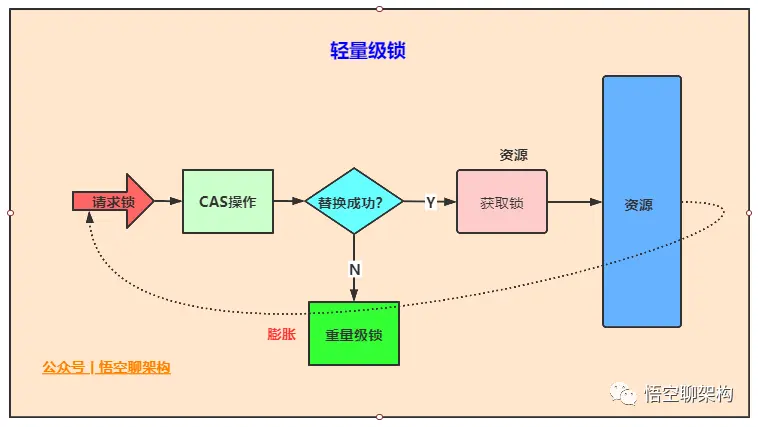

- 轻量级锁:实现的原理是基于这样的假设,即在真是情况下程序中的大部分同步代码一般都属于无锁竞争状态(单线程执行环境),在无锁竞争的情况下完全可以避免调用操作系统层次的重量级互斥锁,取而代之的是在 monitorenter 和 monitorexit 之间依靠一条 CAS 原子指令就可以完成加锁解锁操作。但存在锁竞争时,执行 CAS 指令失败的线程将再去调用操作系统互斥锁进入阻塞状态,当锁被释放时再被唤醒。

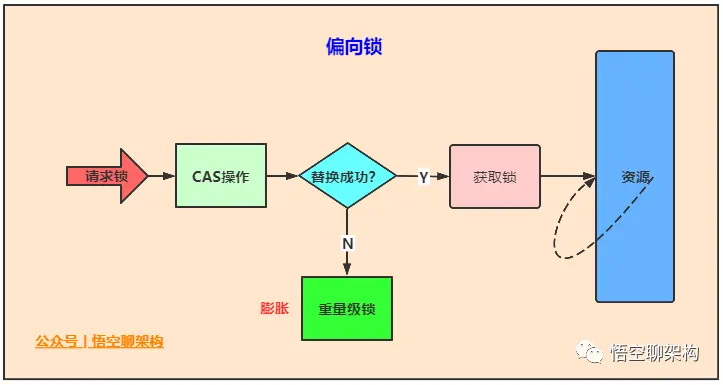

- 偏向锁:为了在无锁竞争的情况下,避免在加锁过程中执行不必要的 CAS 原子指令,因为 CAS 指令虽然轻于OS 互斥锁,但还是存在(相对)可观的本地延迟。

- 适应性自旋:当线程在获取轻量级锁的过程中,如果 CAS 执行失败,在进入与 monitor 相关联的 OS 互斥锁之前,首先进入忙等待(自旋-Spinning),然后再次尝试 CAS,当尝试一定次数知乎仍然失败,再去调用与该 mointor 相关的 OS 互斥锁,进入阻塞状态。

锁的类型

Java 1.6 中 synchronized 同步锁,共有 4 种状态:无锁、偏向锁、轻量锁、重量锁。

会随着竞争状况逐渐升级。锁可以升级但不能降级,目的是为了提高获取锁和释放锁的效率。

自旋锁、自适应自旋

自旋锁

在多线程竞争锁时,当一个线程获取锁时,它会阻塞所有正在竞争的线程,这样对性能带来了极大的影响。在挂起线程和恢复线程的操作都需要转入内核态中完成,这些操作对系统的并发性能带来了很大的压力。同时HotSpot团队注意到在很多情况下,共享数据的锁定状态只会持续很短的一段时间,为了这段时间去挂起和回复阻塞线程并不值得。在如今多处理器环境下,完全可以让另一个没有获取到锁的线程在门外等待一会(自旋),但不放弃CPU的执行时间。等待持有锁的线程是否很快就会释放锁。为了让线程等待,我们只需要让线程执行一个忙循环(自旋),这便是自旋锁由来的原因。

自旋锁早在JDK1.4 中就引入了,只是当时默认时关闭的。在JDK 1.6后默认为开启状态。自旋锁本质上与阻塞并不相同,先不考虑其对多处理器的要求,如果锁占用的时间非常的短,那么自旋锁的新能会非常的好,相反,其会带来更多的性能开销(因为在线程自旋时,始终会占用CPU的时间片,如果锁占用的时间太长,那么自旋的线程会白白消耗掉CPU资源)。因此自旋等待的时间必须要有一定的限度,如果自选超过了限定的次数仍然没有成功获取到锁,就应该使用传统的方式去挂起线程了,在JDK定义中,自旋锁默认的自旋次数为10次,用户可以使用参数-XX:PreBlockSpin来更改。

可是现在又出现了一个问题:如果线程锁在线程自旋刚结束就释放掉了锁,那么是不是有点得不偿失。所以这时候我们需要更加聪明的锁来实现更加灵活的自旋。来提高并发的性能。

自适应自旋

在JDK 1.6中引入了自适应自旋锁。这就意味着自旋的时间不再固定了,而是由前一次在同一个锁上的自旋 时间及锁的拥有者的状态来决定的。如果在同一个锁对象上,自旋等待刚刚成功获取过锁,并且持有锁的线程正在运行中,那么JVM会认为该锁自旋获取到锁的可能性很大,会自动增加等待时间。比如增加到100次循环。相反,如果对于某个锁,自旋很少成功获取锁。那再以后要获取这个锁时将可能省略掉自旋过程,以避免浪费处理器资源。有了自适应自旋,JVM对程序的锁的状态预测会越来越准备,JVM也会越来越聪明。

锁消除

锁消除是指虚拟机即时编译器在运行过冲中,对一些在代码上要求同步、但是被检测到不可能存在共享数据竞争的锁进行消除。锁消除的主要判定依据来源于逃逸分析的数据支持。意思就是:JVM 会判断在一段程序中的同步数据明显不会逃逸出去从而被其他线程访问到,那 JVM 就把它们当作栈上数据对待,认为这些数据是线程独有的,不需要加同步。此时就会进行锁消除。

当然在实际开发中,我们很清楚的知道那些地方是线程独有的,不需要加同步锁,但是在 Java API 中有很多方法都是加了同步的,那么此时 JVM 会判断这段代码是否需要加锁。如果数据并不会逃逸,则会进行锁消除。比如如下操作:在操作 String 类型数据时,由于 String 是一个不可变类,对字符串的连接操作总是通过生成的新的 String 对象。因此 Javac 编译器会对 String 连接做自动优化。在 JDK 1.5 之前会使用 StringBuffer 对象的连续 append() 操作,在 JDK 1.5 及以后的版本中,会转化为 StringBuidler 对象的连续 append() 操作。

锁粗化

原则上,我们都知道在加同步锁时,尽可能的将同步块的作用范围限制到尽量小的范围(只在共享数据的实际作用域中才进行同步,这样是为了使得需要同步的操作数量尽可能变小。在存在锁同步竞争中,也可以使得等待锁的线程尽早的拿到锁。

大部分上述情况是正确的,但是如果存在连串的一系列操作都对同一个对象反复加锁和解锁,甚至加锁操作时出现在循环体中的,那即使没有线程竞争,频繁地进行互斥同步操作也会导致不必要地性能操作。

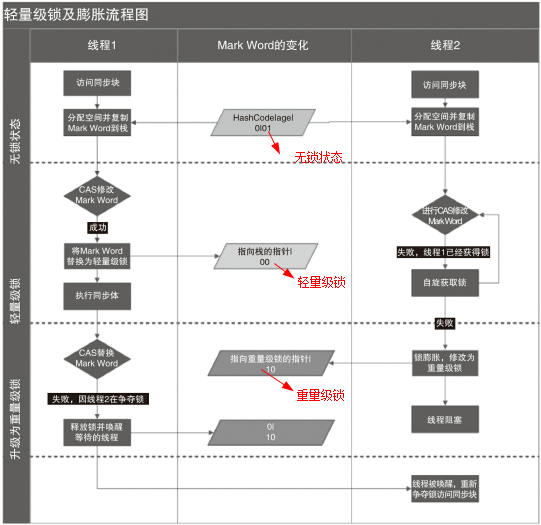

轻量锁

在 JDK 1.6 之后引入的轻量级锁,需要注意的是轻量级锁并不是替代重量级锁的,而是对在大多数情况下同步块并不会有竞争出现时提供的一种优化。它可以减少重量级锁对线程的阻塞带来地线程开销。从而提高并发性能。

如果要理解轻量级锁,那么必须先要了解 HotSpot 虚拟机中对象头地内存布局。在对象头中(Object Header)存在两部分。第一部分用于存储对象自身的运行时数据,HashCode、GC Age、锁标记位、是否为偏向锁等。一般为32位或者64位(视操作系统位数定)。官方称之为Mark Word,它是实现轻量级锁和偏向锁的关键。 另外一部分存储的是指向方法区对象类型数据的指针(Klass Point),如果对象是数组的话,还会有一个额外的部分用于存储数据的长度。

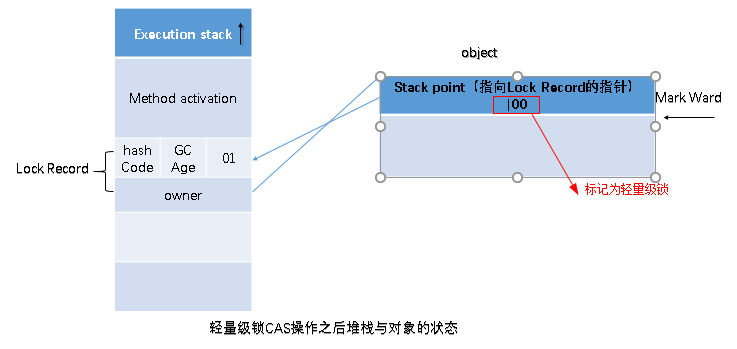

如上图所示,如果当前对象没有被锁定,那么锁标志位为 01 状态,JVM 在指向当前线程时,首先会在当前线程帧栈中创建锁记录 Lock Record 的空间,用于存储锁对象目前的 Mark Word 的拷贝。

然后,虚拟机使用 CAS 操作将标记字段 Mark Word 拷贝到锁记录中,并将 Mark Word 更新为指向 Lock Record 的指针。如果更新成功了,那么这个线程就有了使用该对象的锁,并且对象 Mark Word 的所标志位更新为(Mark Word 中最后为 2 bit) 00,即表示该对象处于轻量级锁定状态,如图:

如果更新操作失败,JVM 会检查当前 Mark Word 中是否存在指向当前线程帧栈的指针,如果有,则表示锁已经被获取,可以直接使用。如果没有,则说明该锁已经被其他线程抢占,如果有两条以上的线程同时经常一个锁,那么轻量级锁就不再有效,直接升级为重量级锁,没有获得锁的线程会被阻塞。此时,锁的标志位为 10,Mark Word 中存储的是指向重量级锁的指针。

轻量级锁解锁时,会使用原子的 CAS 操作将 Displaced Mark Word 替换会对象头中,如果成功,则表示没有发生竞争,如果失败,则表示当前锁存在竞争关系。锁就会升级为重量级锁。

两个线程同时抢占锁,导致锁升级的流程如下:

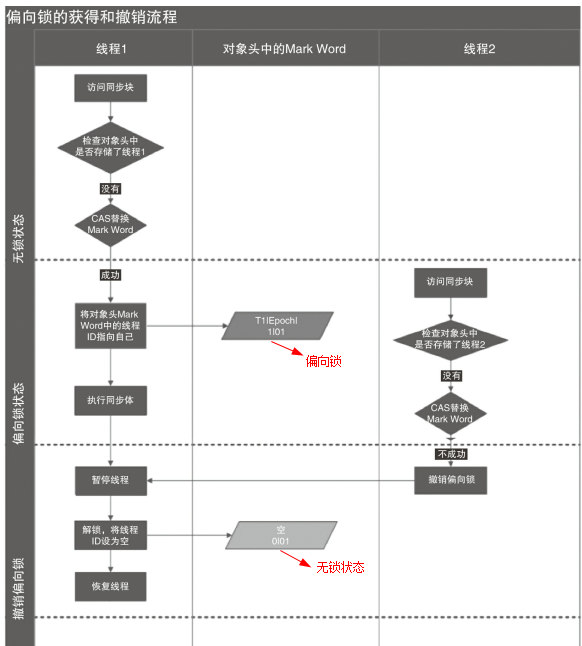

偏向锁

在大多数实际环境中,锁不仅不存在多线程竞争,而且总是由同一个线程多次获取,那么在同一个线程反复加锁解锁的过程中,其中并没有对锁的竞争,这样一来,多次加锁解锁带来了不必要的性能开销。

为了解决这一问题,HotSpot 的作者在 Java SE 1.6 中对 Synchronized 进行了优化,引入了偏向锁。

当一个线程访问同步块并获取锁时,会在对象头和帧栈中的锁记录里存储偏向锁偏向的线程 ID,以后该线程在进入和退出同步块时不需要进行 CAS 操作来加锁和解锁。只需要简单的测试一下对象头的 Mark Word 中是否保存了指向当前线程的偏向锁。如果成功,表示线程已经获得了锁。

偏向锁使用了一种等待竞争出现时才会释放锁的机制。当其他线程尝试获取偏向锁时,持有偏向锁的线程才会释放锁。但是偏向锁的撤销需要等到全局安全点(即当前线程没有正在执行的字节码)。

它首先会暂停拥有偏向锁的线程,然后检查持有偏向锁的线程是否还活着。如果线程不处于活动状态,直接将对象头设置为无锁状态。如果活着,JVM 会遍历帧栈中的锁记录,帧栈中的锁记录和对象头要么偏向于其他线程,要么恢复到无锁状态或者标记对象不适合作为偏向锁。

锁对比

| 锁 | 优点 | 缺点 | 场景 |

|---|---|---|---|

| 偏向锁 | 加锁解锁不需要 CAS,没有额外性能开销 | 如果线程间存在竞争,撤销锁会带来额外开销 | 仅一个线程访问同步块 |

| 轻量锁 | 竞争的线程不会阻塞,提供响应速度 | 如果线程始终得到到锁,自旋会消耗性能 | 同步块执行速度非常快 |

| 重量锁 | 线程竞争不适用自旋,不会消耗 CPU | 线程阻塞、响应慢、频繁加解锁开销大 | 追求吞吐量,同步块执行速度慢 |

Synchronized 与 Lock

Synchronized 的缺陷

- 效率低:锁的释放情况少,只有代码指向完或抛出异常时才会解锁;试图获取锁时不能设置超时,不能中断正在使用锁的线程,而 Lock 可以中断或设置超时。

- 不灵活:加锁和解锁的时机单一,每个锁仅有一个单一的条件(对象实例),Lock 更加灵活。

- 无法感知是否获得锁:Lock 可以显式获取状态,然后基于状态执行判断。

相比 Lock

Lock 的方法:

- lock:加锁

- unlock:解锁

- tryLock:尝试加锁,返回布尔值

- tryLock(long,TimeUnit):尝试加锁,设定超时

多线程竞争锁时,其余未获得锁的线程只能不停的尝试加锁,而不能中断,高并发情况下会导致性能下降。

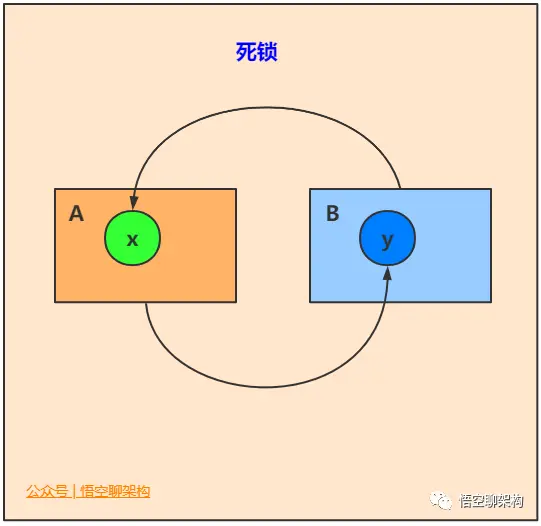

ReentrantLock 的 lockInterruptibly() 方法可以优先考虑响应中断。 一个线程等待时间过长,它可以中断自己,然后 ReentrantLock 响应这个中断,不再让这个线程继续等待。有了这个机制,使用 ReentrantLock 时就不会像 synchronized 那样产生死锁了。

注意事项

Synchronized 由 JVM 实现,无需显式控制加解锁逻辑。

- 锁对象不能为空,因为锁的信息都保存在对象头里

- 作用域不宜过大,影响程序执行的速度,控制范围过大,编写代码也容易出错

- 避免死锁

- 在能选择的情况下,既不要用 Lock 也不要用 synchronized 关键字,用 JUC 包中的各种各样的类,如果不用该包下的类,在满足业务的情况下,可以使用 synchronized 关键,避免手动操作引起错误

- synchronized 是公平锁吗?

- 实际上是非公平的,新来的线程有可能立即获得监视器,而在等待区中等候已久的线程可能再次等待。

- 但这种抢占的方式可以预防饥饿。

6 - CH06-Volatile

基本作用

防止重排序

比如一个对象构造过程的场景,实例化一个对象可以分为 3 个步骤:

- 分配内存空间

- 初始化对象

- 将内存空间的地址赋值给对应的引用

但是由于操作系统可以“对指令进行重排序”,所以上面的过程可能会被转换为:

- 分配内存空间

- 将内存空间的地址赋值给对应的引用

- 初始化对象

这样一来,多线程环境下可能将一个尚未初始化的对象引用暴露到外部,从而导致非预期的行为。

因此为了防止该过程的重排序,我们可以将变量设置为 volatile 类型的变量。

实现可见性

可见性问题主要指一个线程修改了共享变量值,而另一个线程却看不到。引起可见性问题的主要原因是每个线程拥有自己的一个高速缓存区——线程工作内存。volatile 能有效的解决这个问题。

保证原子性:单次读/写

基于 volatile 保证单次的读/写操作具有原子性的理解,你将能够理解如下两个问题:

i++ 为什么不能保证原子性

对 volatile 变量的单次读/写操作可以保证原子性的,如 long 和 double 类型变量,但是并不能保证 i++ 这种操作的原子性,因为本质上 i++ 是读、写两次操作,包括三步骤:

- 读取 i 的值。

- 对 i 加 1。

- 将 i 的值写回内存。 volatile 是无法保证这三个操作是具有原子性的,我们可以通过 AtomicInteger 或者 Synchronized 来保证 +1 操作的原子性。 注:上面几段代码中多处执行了 Thread.sleep() 方法,目的是为了增加并发问题的产生几率,无其他作用。

共享的 long 和 double 变量的为什么要用 volatile?

因为 long 和 double 两种数据类型的操作可分为高 32 位和低 32 位两部分,因此普通的 long 或 double 类型读/写可能不是原子的。因此,鼓励大家将共享的 long 和 double 变量设置为 volatile 类型,这样能保证任何情况下对 long 和 double 的单次读/写操作都具有原子性。

目前各种平台下的商用虚拟机都选择把 64 位数据的读写操作作为原子操作来对待,因此我们在编写代码时一般不把 long 和 double 变量专门声明为 volatile 多数情况下也是不会错的。

实现原理

实现可见性

volatile 变量的内存可见性是基于内存屏障(Memory Barrier)实现。

- 内存屏障,又称内存栅栏,是一个 CPU 指令。

- 在程序运行时,为了提高执行性能,编译器和处理器会对指令进行重排序,JMM 为了保证在不同的编译器和 CPU 上有相同的结果,通过插入特定类型的内存屏障来禁止特定类型的编译器重排序和处理器重排序。

- 插入一条内存屏障会告诉编译器和 CPU:不管什么指令都不能和这条 Memory Barrier 指令执行重排序。

比如代码:

public class Test {

private volatile int a;

public void update() {

a = 1;

}

public static void main(String[] args) {

Test test = new Test();

test.update();

}

}

通过 hsdis 和 jitwatch 工具可以得到编译后的汇编代码:

......

0x0000000002951563: and $0xffffffffffffff87,%rdi

0x0000000002951567: je 0x00000000029515f8

0x000000000295156d: test $0x7,%rdi

0x0000000002951574: jne 0x00000000029515bd

0x0000000002951576: test $0x300,%rdi

0x000000000295157d: jne 0x000000000295159c

0x000000000295157f: and $0x37f,%rax

0x0000000002951586: mov %rax,%rdi

0x0000000002951589: or %r15,%rdi

0x000000000295158c: lock cmpxchg %rdi,(%rdx) //在 volatile 修饰的共享变量进行写操作的时候会多出 lock 前缀的指令

0x0000000002951591: jne 0x0000000002951a15

0x0000000002951597: jmpq 0x00000000029515f8

0x000000000295159c: mov 0x8(%rdx),%edi

0x000000000295159f: shl $0x3,%rdi

0x00000000029515a3: mov 0xa8(%rdi),%rdi

0x00000000029515aa: or %r15,%rdi

......

lock 前缀的指令在多核处理器下会引发两件事情:

- 将当前处理器缓存行的数据写回到系统内存。

- 写回内存的操作会使在其他 CPU 里缓存了该内存地址的额数据无效。

为了提高处理速度,处理器不直接和内存进行通信,而是先将系统内存的数据读到内部缓存(L1,L2 或其他)后再进行操作,但操作完不知道何时会写到内存。

如果对声明了 volatile 的变量进行写操作,JVM 就会向处理器发送一条 lock 前缀的指令,将这个变量所在缓存行的数据写回到系统内存。

为了保证各个处理器的缓存是一致的,实现了缓存一致性协议(MESI),每个处理器通过嗅探在总线上传播的数据来检查自己缓存的值是不是过期了,当处理器发现自己缓存行对应的内存地址被修改,就会将当前处理器的缓存行设置成无效状态,当处理器对这个数据进行修改操作的时候,会重新从系统内存中把数据读到处理器缓存里。

所有多核处理器下还会完成:当处理器发现本地缓存失效后,就会从内存中重读该变量数据,即可以获取当前最新值。

volatile 变量通过这样的机制就使得每个线程都能获得该变量的最新值。

lock 指令

在 Pentium 和早期的 IA-32 处理器中,lock 前缀会使处理器执行当前指令时产生一个 LOCK# 信号,会对总线进行锁定,其它 CPU 对内存的读写请求都会被阻塞,直到锁释放。 后来的处理器,加锁操作是由高速缓存锁代替总线锁来处理。 因为锁总线的开销比较大,锁总线期间其他 CPU 没法访问内存。 这种场景多缓存的数据一致通过缓存一致性协议(MESI)来保证。

缓存一致性

缓存是分段(line)的,一个段对应一块存储空间,称之为缓存行,它是 CPU 缓存中可分配的最小存储单元,大小 32 字节、64 字节、128 字节不等,这与 CPU 架构有关,通常来说是 64 字节。 LOCK# 因为锁总线效率太低,因此使用了多组缓存。 为了使其行为看起来如同一组缓存那样。因而设计了 缓存一致性协议。

缓存一致性协议有多种,但是日常处理的大多数计算机设备都属于 " 嗅探(snooping)" 协议。 所有内存的传输都发生在一条共享的总线上,而所有的处理器都能看到这条总线。 缓存本身是独立的,但是内存是共享资源,所有的内存访问都要经过仲裁(同一个指令周期中,只有一个 CPU 缓存可以读写内存)。 CPU 缓存不仅仅在做内存传输的时候才与总线打交道,而是不停在嗅探总线上发生的数据交换,跟踪其他缓存在做什么。 当一个缓存代表它所属的处理器去读写内存时,其它处理器都会得到通知,它们以此来使自己的缓存保持同步。 只要某个处理器写内存,其它处理器马上知道这块内存在它们的缓存段中已经失效。

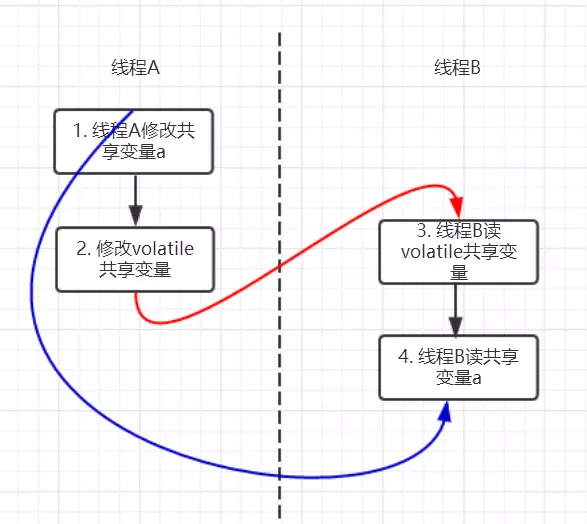

实现有序性

volatile 与 happens-before 的关系

happens-before 规则中有一条是 volatile 变量规则:对一个 volatile 域的写,先于任意后续对这个 volatile 域的读。

//假设线程A执行writer方法,线程B执行reader方法

class VolatileExample {

int a = 0;

volatile boolean flag = false;

public void writer() {

a = 1; // 1 线程A修改共享变量

flag = true; // 2 线程A写volatile变量

}

public void reader() {

if (flag) { // 3 线程B读同一个volatile变量

int i = a; // 4 线程B读共享变量

……

}

}

}

根据 happens-before 规则,上面过程会建立 3 类 happens-before 关系。

- 根据程序次序规则:1 先于 2,且 3 先于 4。

- 根据 volatile 规则:2 先于 3。

- 根据 happens-before 传递性:1 先于 4。

因为以上规则,当线程 A 将 volatile 变量 flag 更改为 true 后,线程 B 能够迅速感知。

volatile 禁止重排序

为了性能优化,JMM 在不改变正确语义的前提下,会允许编译器和处理器对指令序列进行重排序。JMM 提供了内存屏障阻止这种重排序。

Java 编译器会在生成指令系列时在适当的位置会插入内存屏障指令来禁止特定类型的处理器重排序。

JMM 会针对编译器制定 volatile 重排序规则表。

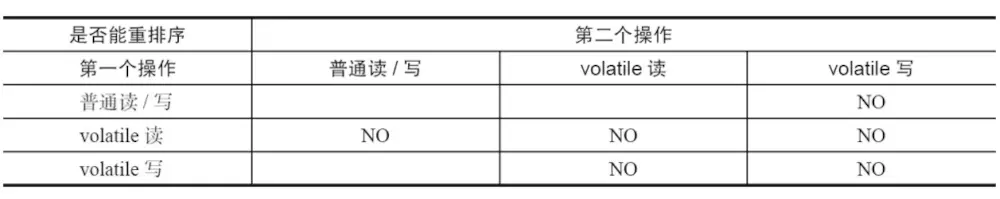

上图中 NO 表示禁止重排序。

为了实现 volatile 内存语义,编译器在生成字节码时,会在指令序列中插入内存屏障来禁止特定类型的重排序。

对于编译器来说,发现一个最优布置来最小化插入内存屏障的总数几乎是不可能的,为此,JVM 采取了保守策略:

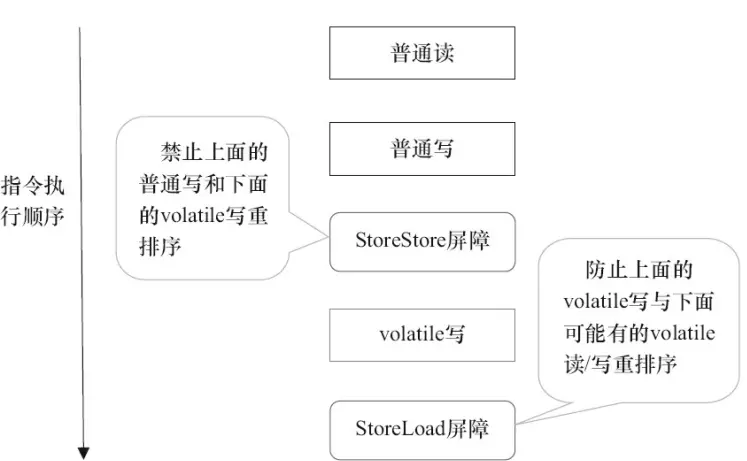

- 在每个 volatile 写操作前插入 StoreStore 屏障。

- 在每个 volatile 写操作后插入 StoreLoad 屏障。

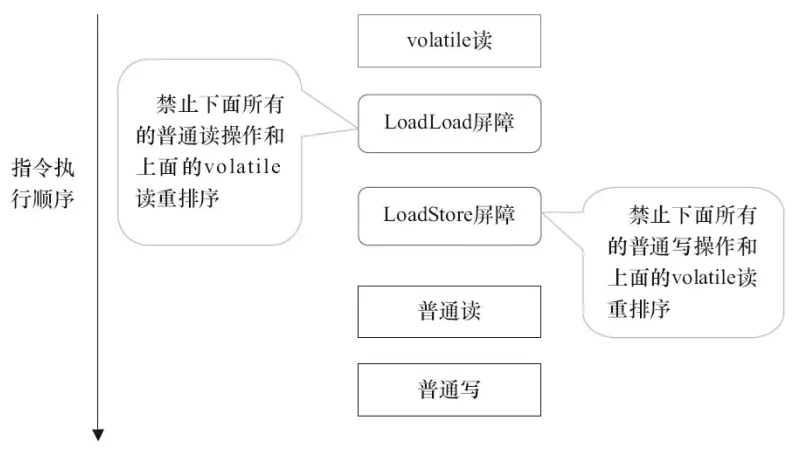

- 在每个 volatile 读操作后插入 LoadLoad 屏障。

- 在每个 volatile 读操作后插入 LoadStore 屏障。

volatile 写是在前后分别插入屏障,而读是在后面插入两个内存屏障。

- StoreStore:禁止上面的普通写和下面的 volatile 写重排序。

- StoreLoad:防止上面的 volatile 写与下面可能出现的 volatile 读/写重排序。

- LoadLoad:禁止下面所有的普通读操作和上面的 volatile 读重排序。

- LoadStore:禁止下面所有的普通下和上面的 volatile 读重排序。

应用场景

使用 volatile 时必须具备的条件:

- 对变量的写操作不依赖于当前值。

- 该变量没有包含在其他变量的不变式中。

- 只有在状态真正独立于成语其他内容时才能使用 volatile。

模式-1:状态标志

或许实现 volatile 变量的规范应用仅仅是通过一个布尔状态标志,用于指示发生了一个重要的一次性事件,比如初始化完成或已经停机,即对变量的简单读写:

volatile boolean shutdownRequested;

...

public void shutdown(){}

public void execute() {

while(!shutdownRequested){

// execute something

}

}

模式-2:一次性安全发布

缺乏同步会导致无法实现可见性,这会使得确定何时写入对象引用而不是原始值变得更加困难。在缺乏同步的情况下,可能会遇到某个对象引用的更新值(由另一个线程写入)和该对象状态的旧值同时存在。

这就是著名的双检锁问题的根源,其中对象引用在没有同步的情况下进行读操作,产生的问题是可能看到一个更新的引用,但是也可能看到尚未构造完成的对象。

public class BackgroundFloobleLoader {

public volatile Flooble theFlooble;

public void initInBackground() {

// do lots of stuff

theFlooble = new Flooble(); // this is the only write to theFlooble

}

}

public class SomeOtherClass {

public void doWork() {

while (true) {

// do some stuff...

// use the Flooble, but only if it is ready

if (floobleLoader.theFlooble != null)

doSomething(floobleLoader.theFlooble);

}

}

}

模式-3:独立观察

安全使用 volatile 的另一种简单模式是定期 发布 观察结果供程序内部使用。例如,假设有一种环境传感器能够感觉环境温度。一个后台线程可能会每隔几秒读取一次该传感器,并更新包含当前文档的 volatile 变量。然后,其他线程可以读取这个变量,从而随时能够看到最新的温度值。

public class UserManager {

public volatile String lastUser;

public boolean authenticate(String user, String password) {

boolean valid = passwordIsValid(user, password);

if (valid) {

User u = new User();

activeUsers.add(u);

lastUser = user;

}

return valid;

}

}

模式-4:volatile bean

在 volatile bean 模式中,JavaBean 的所有数据成员都是 volatile 类型的,并且 getter 和 setter 方法必须非常普通 —— 除了获取或设置相应的属性外,不能包含任何逻辑。此外,对于对象引用的数据成员,引用的对象必须是有效不可变的。(这将禁止具有数组值的属性,因为当数组引用被声明为 volatile 时,只有引用而不是数组本身具有 volatile 语义)。对于任何 volatile 变量,不变式或约束都不能包含 JavaBean 属性。

@ThreadSafe

public class Person {

private volatile String firstName;

private volatile String lastName;

private volatile int age;

public String getFirstName() { return firstName; }

public String getLastName() { return lastName; }

public int getAge() { return age; }

public void setFirstName(String firstName) {

this.firstName = firstName;

}

public void setLastName(String lastName) {

this.lastName = lastName;

}

public void setAge(int age) {

this.age = age;

}

}

模式-5:开销较低的读写锁策略

volatile 的功能还不足以实现计数器。因为 ++x 实际上是三种操作(读、添加、存储)的简单组合,如果多个线程凑巧试图同时对 volatile 计数器执行增量操作,那么它的更新值有可能会丢失。 如果读操作远远超过写操作,可以结合使用内部锁和 volatile 变量来减少公共代码路径的开销。 安全的计数器使用 synchronized 确保增量操作是原子的,并使用 volatile 保证当前结果的可见性。如果更新不频繁的话,该方法可实现更好的性能,因为读路径的开销仅仅涉及 volatile 读操作,这通常要优于一个无竞争的锁获取的开销。

@ThreadSafe

public class CheesyCounter {

// Employs the cheap read-write lock trick

// All mutative operations MUST be done with the 'this' lock held

@GuardedBy("this") private volatile int value;

public int getValue() { return value; }

public synchronized int increment() {

return value++;

}

}

模式-6:双重检查

单例模式的一种实现方式,但很多人会忽略 volatile 关键字,因为没有该关键字,程序也可以很好的运行,只不过代码的稳定性总不是 100%,说不定在未来的某个时刻,隐藏的 bug 就出来了。

class Singleton {

private volatile static Singleton instance;

public static Singleton getInstance() {

if (instance == null) {

syschronized(Singleton.class) {

if (instance == null) {

instance = new Singleton();

}

}

}

return instance;

}

}

7 - CH07-Final

基本用法

修饰类

当某个类的整体定义为 final 时,就表明了你不能打算继承该类,而且也不允许别人这么做。即这个类是不能有子类的。

final 类中的所有方法都隐式为 final,因为无法覆写他们,所以在 final 类中给任何方法添加 final 关键字是没有任何意义的。

修饰方法

- private 方法是隐式的 final,即不能被子类重写

- final 方法是可以被重载的

private final

类中所有 private 方法都隐式地指定为 final 的,由于无法取用 private 方法,所以也就不能覆盖它。可以对 private 方法增添 final 关键字,但这样做并没有什么好处。

final 方法可以被重载

修饰参数

Java 允许在参数列表中以声明的方式将参数指明为 final,这意味这你无法在方法中更改参数引用所指向的对象。这个特性主要用来向匿名内部类传递数据。

修饰字段

并非所有的 fianl 字段都是编译期常量

比如:

class Example {

Random random = new Random();

final int value = random.nextInt();

}

这里的字段 value 并不能在编译期推导出实际的值,而是在运行时由 random 决定。

static final

static final 字段只是占用一段不能改变的存储空间,它必须在定义的时候进行赋值,否则编译期无法同步。

blank final

Java 允许生成空白 final,也就是说被声明为 final 但又没有给出定值的字段,但是必须在该字段被使用之前被赋值,这给予我们两种选择:

- 在定义处进行赋值(这不是空白 final)

- 在构造器中进行赋值,保证了该值在被使用之前赋值。

重排序规则

final 域为基本类型

public class FinalDemo {

private int a; //普通域

private final int b; //final域

private static FinalDemo finalDemo; //静态域

public FinalDemo() {

a = 1; // 1. 写普通域

b = 2; // 2. 写final域

}

public static void writer() {

finalDemo = new FinalDemo();

}

public static void reader() {

FinalDemo demo = finalDemo; // 3.读对象引用

int a = demo.a; //4.读普通域

int b = demo.b; //5.读final域

}

}

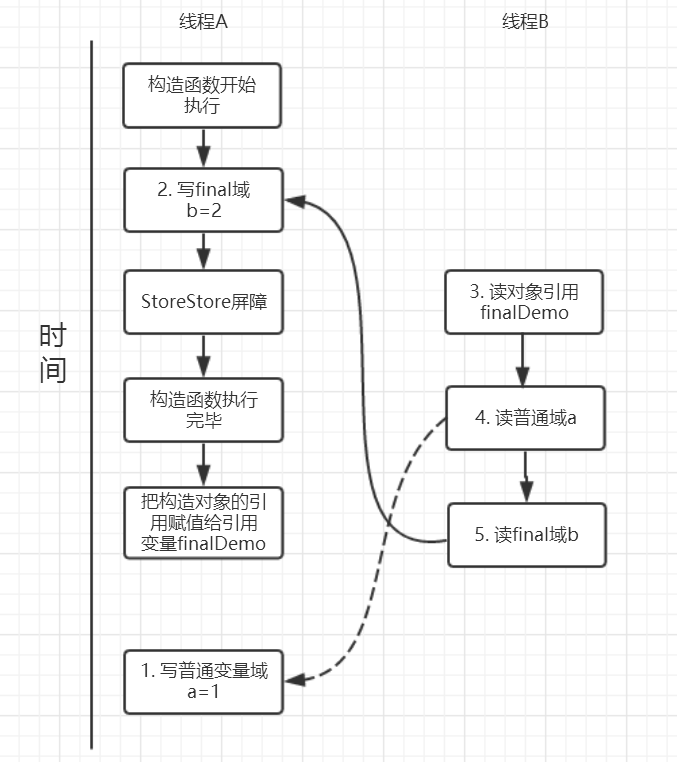

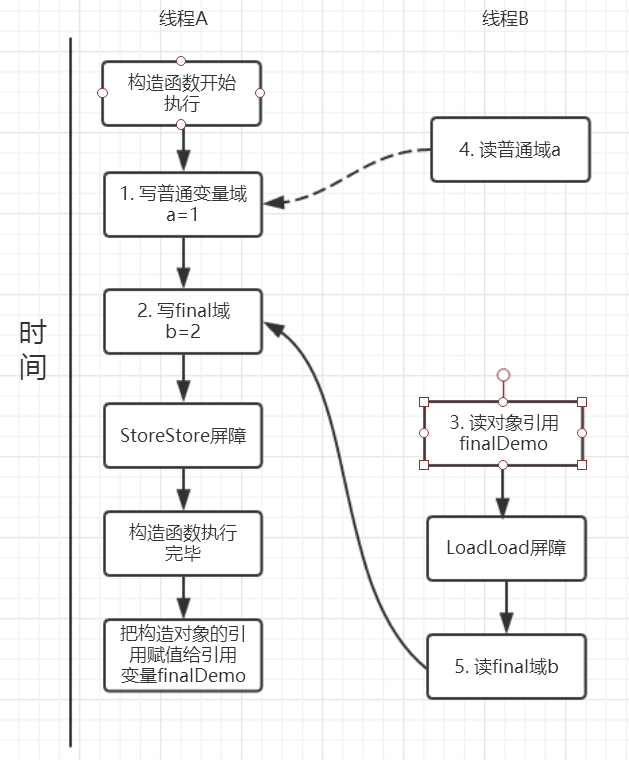

假设线程 A 执行 writer 方法,线程 B 执行 reader 方法。

写操作

写 final 域的重排序规则禁止对 final 域的写操作重排序到构造函数之外,该规则的实现主要包含两个方面:

- JMM 禁止编译器把 final 域的写重排序到构造函数之外。

- 编译器会在 final 域写之后,构造函数 return 之前,插入一个 storestore 屏障。

- 该屏障可以禁止处理器将 final 域的写重排序到构造函数之外。

writer 方法分析:

- 构造了一个 FinalDemo 对象。

- 把这个对象复制给成员变量 finalDemo。

由于 a,b 之间没有依赖,普通域 a 可能会被重排序到构造函数之外,线程 B 肯呢个读到普通变量 a 初始化之前的值(零值),即引起错误。

而 final 域变量 b,根据重排序规则,会禁止 final 修饰的变量 b 被重排序到构造函数之外,因此 b 会在构造函数内完成赋值,线程 B 可以读到正确赋值后的 b 变量。

因此,写 final 域的重排序规则可以确保:在对象引用被任意线程可见之前,对象的 final 域已经被正确初始化过了,而普通域就不具有这个保障。

读操作

读 final 域的重排序规则为:在一个线程中,初次读对象引用和初次读该对象包含的 final 域,JMM 会禁止这两个操作的重排序。(仅针对处理器),处理器会在读 final 域操作之前插入一个 LoadLoad 屏障。

实际上,度对象的引用和读对象的 final 域存在间接依赖性,一般处理器不会对这两个操作执行重排序。但是不能排除有些处理器会执行重排序,因此,该规则就是针对这些处理器设定的。

reader 方法分析:

- 初次读引用变量 finalDemo;

- 初次读引用变量 finalDemo 的普通域;

- 初次读引用变量 finalDemo 的 fianl 域 b;

假设线程A写过程没有重排序,那么线程A和线程B有一种的可能执行时序为下图:

读对象的普通域被排序到读对象引用之前,就会出现线程 B 还未多读到对象引用就在读取该对象的普票域变量,这显然是错误操作。

而 final 域的读操作就限定了在读 final 域变量前就已经读到了该对象的引用,从而避免这种错误。

读 final 域的重排序规则可以保证:在读取一个对象的 fianl 域之前,一定会先读取该 final 域所属的对象引用。

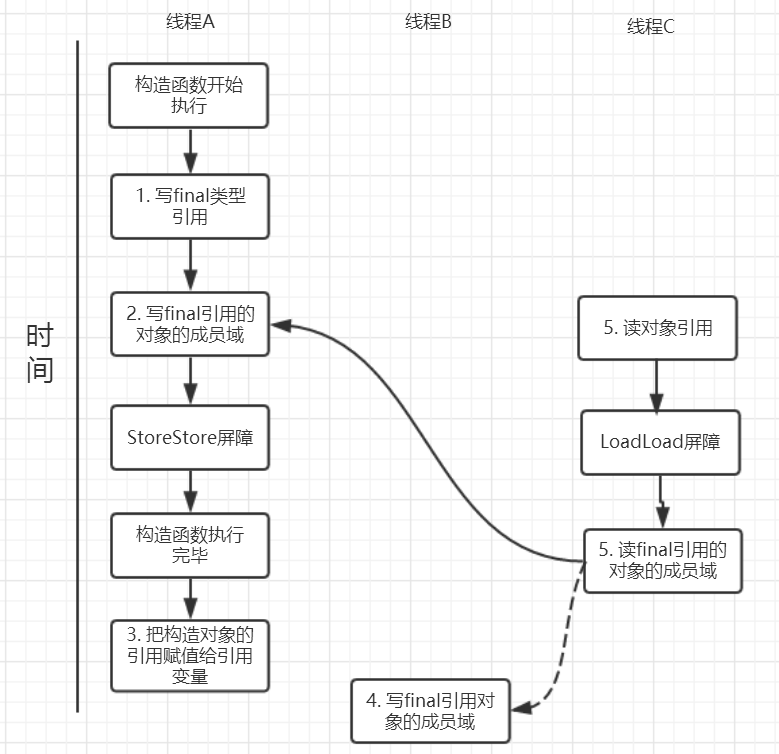

final 域为引用类型

对 final 修饰对象的成员域执行写操作

针对引用数据类型,final域写针对编译器和处理器重排序增加了这样的约束:在构造函数内对一个final修饰的对象的成员域的写入,与随后在构造函数之外把这个被构造的对象的引用赋给一个引用变量,这两个操作是不能被重排序的。注意这里的是“增加”也就说前面对final基本数据类型的重排序规则在这里还是使用。这句话是比较拗口的,下面结合实例来看。

public class FinalReferenceDemo {

final int[] arrays;

private FinalReferenceDemo finalReferenceDemo;

public FinalReferenceDemo() {

arrays = new int[1]; //1

arrays[0] = 1; //2

}

public void writerOne() {

finalReferenceDemo = new FinalReferenceDemo(); //3

}

public void writerTwo() {

arrays[0] = 2; //4

}

public void reader() {

if (finalReferenceDemo != null) { //5

int temp = finalReferenceDemo.arrays[0]; //6

}

}

}

针对上面的实例程序,线程线程A执行wirterOne方法,执行完后线程B执行writerTwo方法,然后线程C执行reader方法。下图就以这种执行时序出现的一种情况来讨论(耐心看完才有收获)。

由于对final域的写禁止重排序到构造方法外,因此1和3不能被重排序。由于一个final域的引用对象的成员域写入不能与随后将这个被构造出来的对象赋给引用变量重排序,因此2和3不能重排序。

对final 修饰的对象的成员域执行读操作

JMM可以确保线程C至少能看到写线程A对final引用的对象的成员域的写入,即能看下 arrays[0] = 1,而写线程B对数组元素的写入可能看到可能看不到。JMM不保证线程B的写入对线程C可见,线程B和线程C之间存在数据竞争,此时的结果是不可预知的。如果可见的,可使用锁或者volatile。

final 重排序总结

- 基本数据类型

- 禁止 final 域写与构造函数重排序,即禁止 final 域重排序到构造方法之外,从而保证该对象对所有线程可见时,该对象的 final 域全部已经初始化过。

- 禁止初次读取该对象的引用与读取该对象 fianl 域的重排序。

- 引用数据类型

- 相比基本数据类型增加额外规则

- 禁止在构造函数对一个 final 修饰的对象的成员域的写入与随后将这个被构造的对象的引用复制给引用变量重排序。

- 即:现在构造函数中完成对 final 修饰的引用类型的字段赋值,再将该引用对象整体复制给 final 修饰的变量。

深入理解

实现原理

- 写 final 域会要求编译器在 final 域写之后,构造函数返回前插入一个 StoreStore 屏障。

- 读 final 域的重排序规则会要求编译器在读 final 域的操作前插入一个 LoadLoad 屏障。

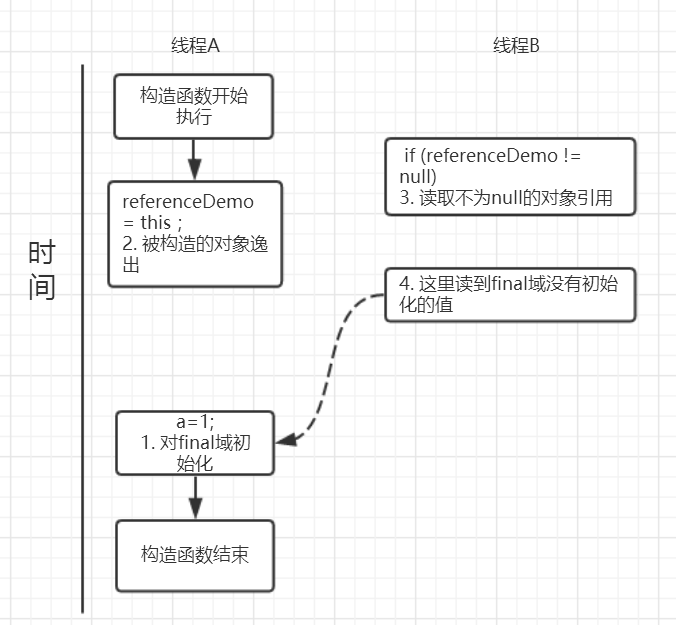

为什么 final 引用不能从构造函数中逸出

上面对final域写重排序规则可以确保我们在使用一个对象引用的时候该对象的final域已经在构造函数被初始化过了。

但是这里其实是有一个前提条件的,也就是:在构造函数,不能让这个被构造的对象被其他线程可见,也就是说该对象引用不能在构造函数中“逸出”。

public class FinalReferenceEscapeDemo {

private final int a;

private FinalReferenceEscapeDemo referenceDemo;

public FinalReferenceEscapeDemo() {

a = 1; //1

referenceDemo = this; //2

}

public void writer() {

new FinalReferenceEscapeDemo();

}

public void reader() {

if (referenceDemo != null) { //3

int temp = referenceDemo.a; //4

}

}

}

假设一个线程A执行writer方法另一个线程执行reader方法。因为构造函数中操作1和2之间没有数据依赖性,1和2可以重排序,先执行了2,这个时候引用对象referenceDemo是个没有完全初始化的对象,而当线程B去读取该对象时就会出错。尽管依然满足了final域写重排序规则:在引用对象对所有线程可见时,其final域已经完全初始化成功。但是,引用对象“this”逸出,该代码依然存在线程安全的问题。

使用 final 的限制条件和局限性

- 当声明一个 final 成员时,必须在构造函数退出前设置它的值。

- 或者,将指向对象的成员声明为 final 只能将该引用设为不可变的,而非所指的对象。

- 如果一个对象将会在多个线程中访问并且你并没有将其成员声明为 final,则必须提供其他方式保证线程安全。

- 比如声明成员为 volatile,使用 synchronized 或者显式 Lock 控制所有该成员的访问。

8 - CH08-并发概览

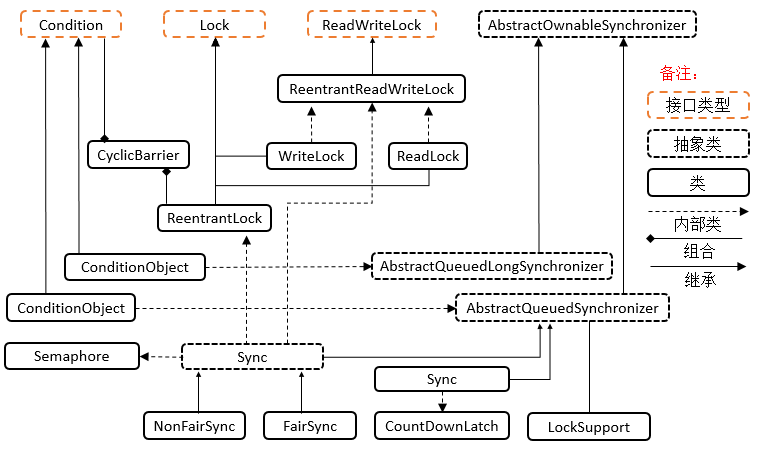

Locks & Tools

层级结构

接口:Condition

Condition 为接口类型,它将 Object 监视器方法(wait、notify 和 notifyAll)分解成截然不同的对象,以便通过将这些对象与任意 Lock 实现组合使用,为每个对象提供多个等待集 (wait-set)。其中,Lock 替代了 synchronized 方法和语句的使用,Condition 替代了 Object 监视器方法的使用。可以通过 await(),signal() 来休眠/唤醒线程。

接口:Lock

Lock 为接口类型,Lock 提供了比使用 synchronized 方法和语句可获得的更广泛的锁定操作。允许更灵活的结构,可以具有差别很大的属性,可以支持多个相关的 Condition 对象。

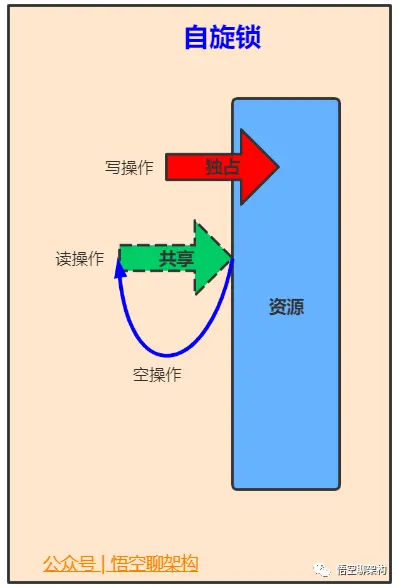

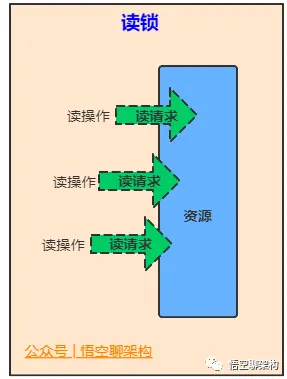

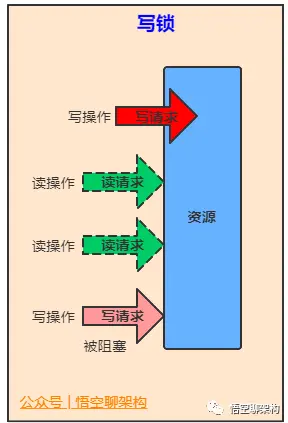

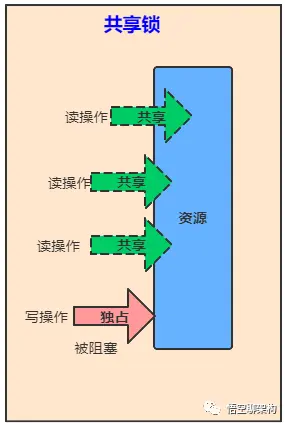

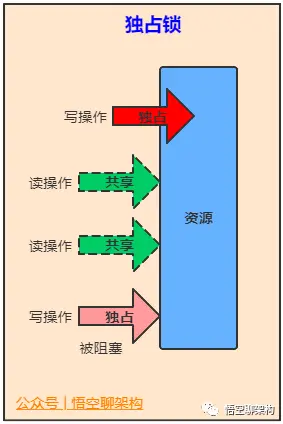

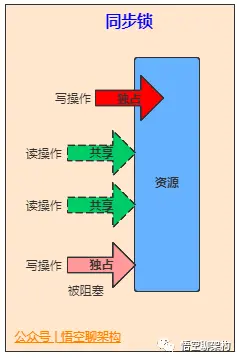

接口:ReadWriteLock

维护了一对相关的锁,一个用于只读操作,另一个用于写入操作。只要没有 writer,读取锁可以由多个 reader 线程同时保持。写入锁是独占的。

抽象类:AbstractOwnableSynchonizer

可以由线程以独占方式拥有的同步器。此类为创建锁和相关同步器(伴随着所有权的概念)提供了基础。AbstractOwnableSynchronizer 类本身不管理或使用此信息。但是,子类和工具可以使用适当维护的值帮助控制和监视访问以及提供诊断。

抽象类(long):AbstractQueuedLongSynchronizer

以 long 形式维护同步状态的一个 AbstractQueuedSynchronizer 版本。此类具有的结构、属性和方法与 AbstractQueuedSynchronizer 完全相同,但所有与状态相关的参数和结果都定义为 long 而不是 int。当创建需要 64 位状态的多级别锁和屏障等同步器时,此类很有用。

抽象类(int):AbstractQueuedSynchonizer

其为实现依赖于先进先出 (FIFO) 等待队列的阻塞锁和相关同步器(信号量、事件,等等)提供一个框架。此类的设计目标是成为依靠单个原子 int 值来表示状态的大多数同步器的一个有用基础。

锁工具类:LockSupport

LockSupport为常用类,用来创建锁和其他同步类的基本线程阻塞原语。LockSupport的功能和"Thread中的 Thread.suspend()和Thread.resume()有点类似",LockSupport中的park() 和 unpark() 的作用分别是阻塞线程和解除阻塞线程。但是park()和unpark()不会遇到“Thread.suspend 和 Thread.resume所可能引发的死锁”问题。

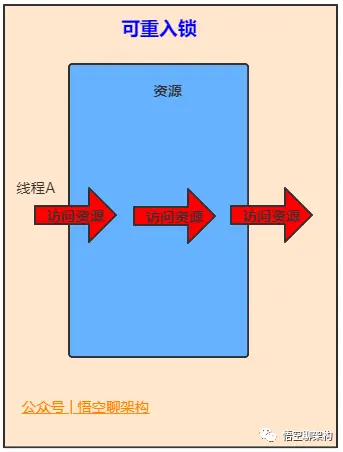

锁常用类:ReentrantLock

它是一个可重入的互斥锁 Lock,它具有与使用 synchronized 方法和语句所访问的隐式监视器锁相同的一些基本行为和语义,但功能更强大。

锁常用类: ReentrantReadWriteLock

ReentrantReadWriteLock是读写锁接口ReadWriteLock的实现类,它包括Lock子类ReadLock和WriteLock。ReadLock是共享锁,WriteLock是独占锁。

锁常用类: StampedLock

它是 java8 在 java.util.concurrent.locks 新增的一个 API。StampedLock 控制锁有三种模式(写,读,乐观读),一个 StampedLock 状态是由版本和模式两个部分组成,锁获取方法返回一个数字作为票据 stamp,它用相应的锁状态表示并控制访问,数字 0 表示没有写锁被授权访问。在读锁上分为悲观锁和乐观锁。

工具常用类: CountDownLatch

它是一个同步辅助类,在完成一组正在其他线程中执行的操作之前,它允许一个或多个线程一直等待。

工具常用类: CyclicBarrier

CyclicBarrier 为常用类,其是一个同步辅助类,它允许一组线程互相等待,直到到达某个公共屏障点 (common barrier point)。在涉及一组固定大小的线程的程序中,这些线程必须不时地互相等待,此时 CyclicBarrier 很有用。因为该 barrier 在释放等待线程后可以重用,所以称它为循环的 barrier。

工具常用类: Phaser

Phaser 是 JDK 7 新增的一个同步辅助类,它可以实现 CyclicBarrier 和 CountDownLatch 类似的功能,而且它支持对任务的动态调整,并支持分层结构来达到更高的吞吐量。

工具常用类: Semaphore

Semaphore 为常用类,其是一个计数信号量,从概念上讲,信号量维护了一个许可集。如有必要,在许可可用前会阻塞每一个 acquire(),然后再获取该许可。每个 release() 添加一个许可,从而可能释放一个正在阻塞的获取者。但是,不使用实际的许可对象,Semaphore 只对可用许可的号码进行计数,并采取相应的行动。通常用于限制可以访问某些资源(物理或逻辑的)的线程数目。

工具常用类: Exchanger

Exchanger 是用于线程协作的工具类, 主要用于两个线程之间的数据交换。它提供一个同步点,在这个同步点,两个线程可以交换彼此的数据。这两个线程通过 exchange() 方法交换数据,当一个线程先执行 exchange() 方法后,它会一直等待第二个线程也执行 exchange() 方法,当这两个线程到达同步点时,这两个线程就可以交换数据了。

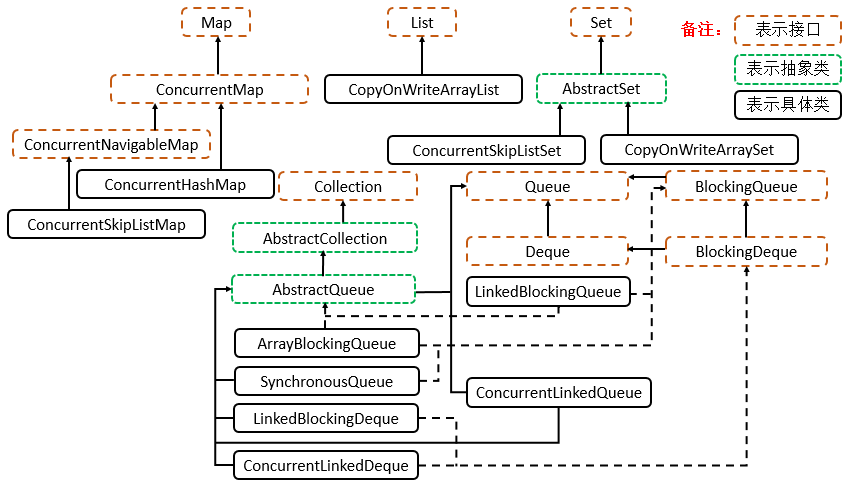

Collections: 并发集合

层级结构

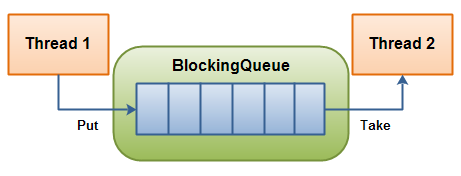

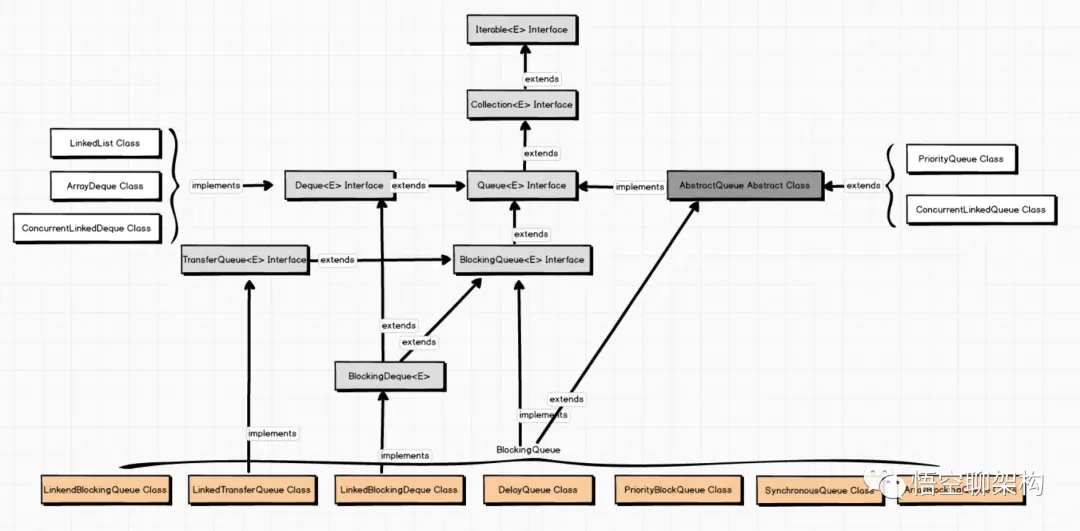

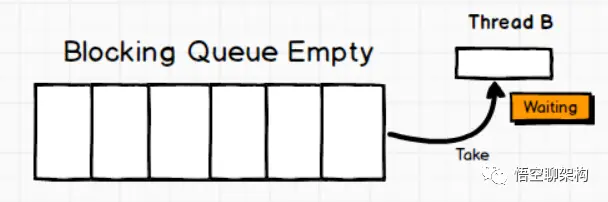

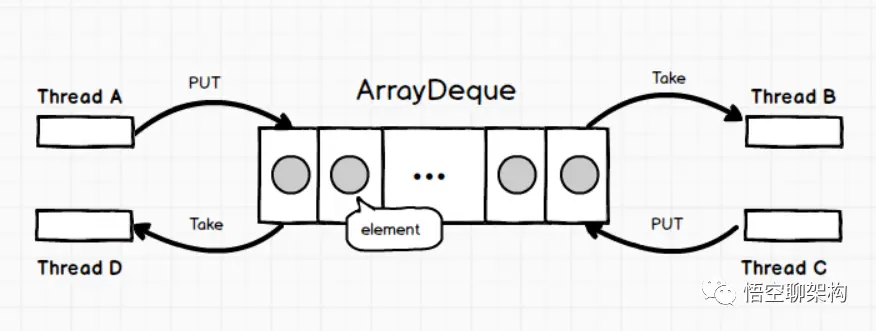

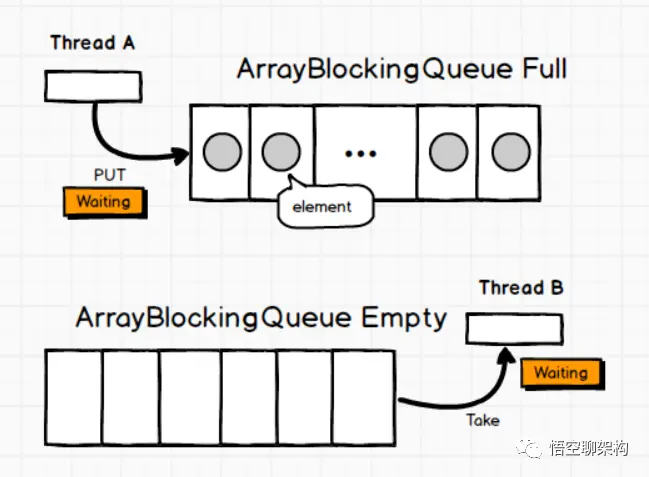

Queue: ArrayBlockingQueue

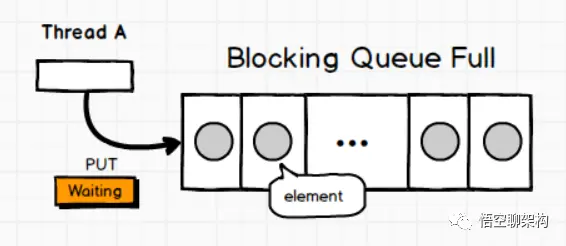

一个由数组支持的有界阻塞队列。此队列按 FIFO(先进先出)原则对元素进行排序。队列的头部是在队列中存在时间最长的元素。队列的尾部是在队列中存在时间最短的元素。新元素插入到队列的尾部,队列获取操作则是从队列头部开始获得元素。

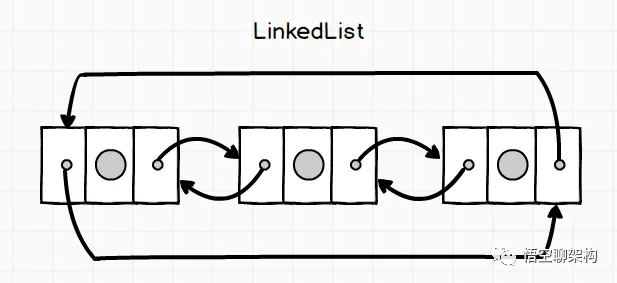

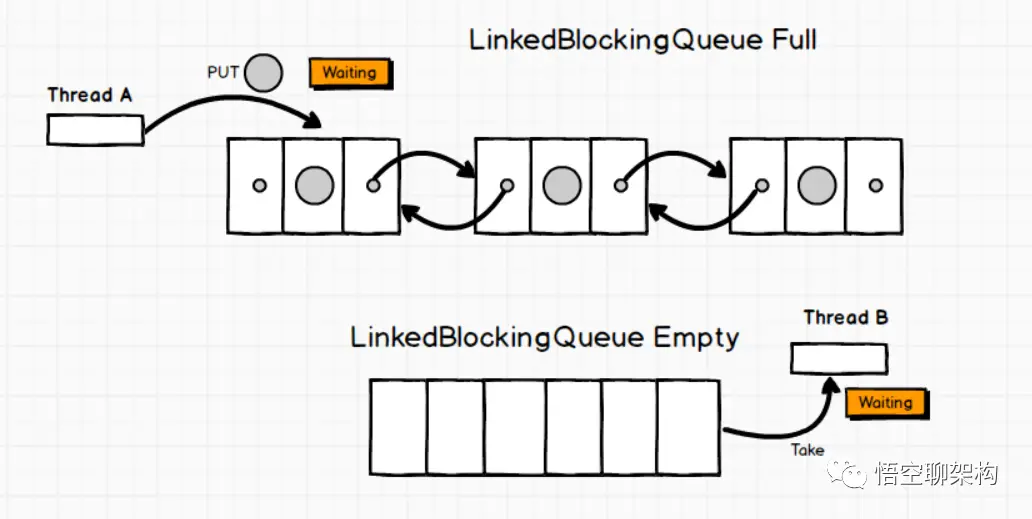

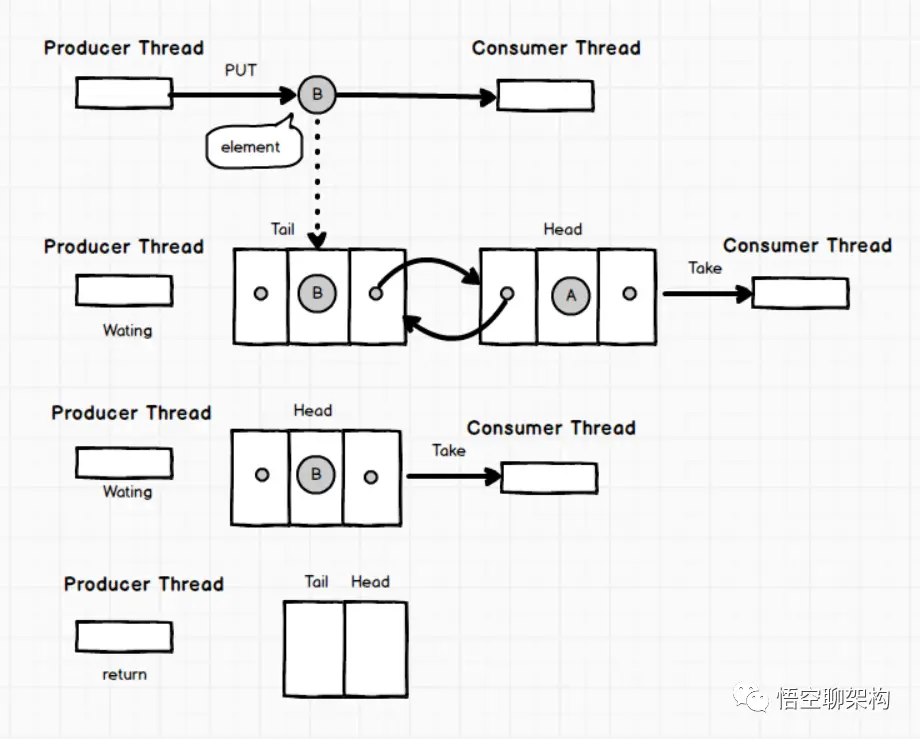

Queue: LinkedBlockingQueue

一个基于已链接节点的、范围任意的 blocking queue。此队列按 FIFO(先进先出)排序元素。队列的头部 是在队列中时间最长的元素。队列的尾部 是在队列中时间最短的元素。新元素插入到队列的尾部,并且队列获取操作会获得位于队列头部的元素。链接队列的吞吐量通常要高于基于数组的队列,但是在大多数并发应用程序中,其可预知的性能要低。

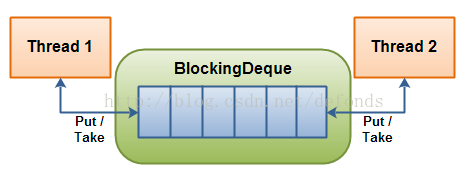

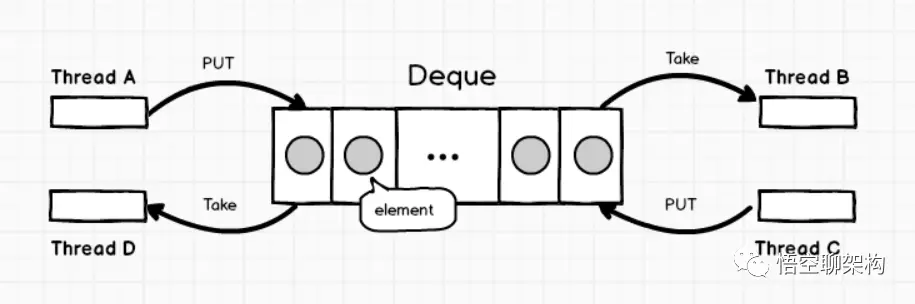

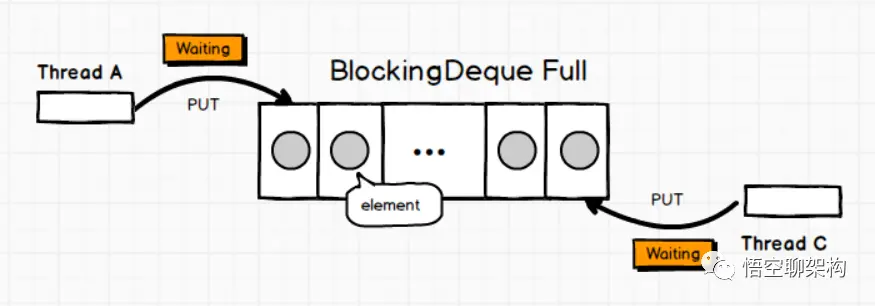

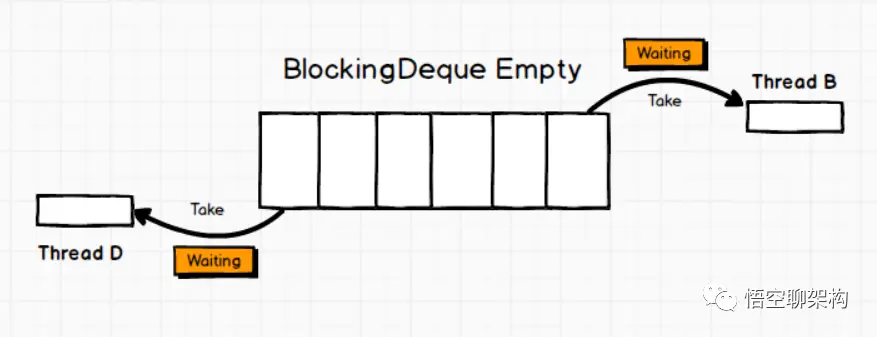

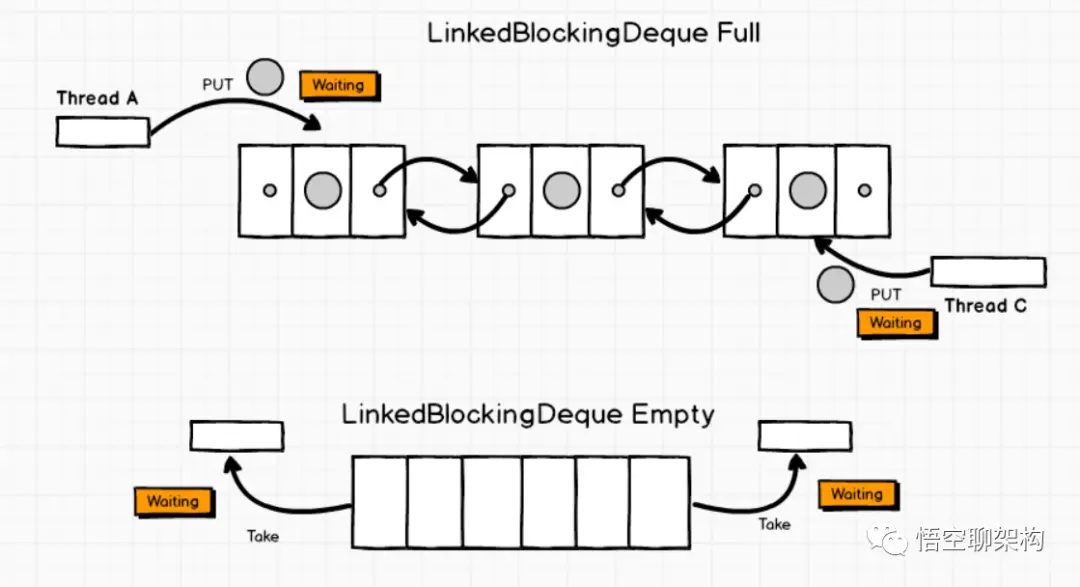

Queue: LinkedBlockingDeque

一个基于已链接节点的、任选范围的阻塞双端队列。

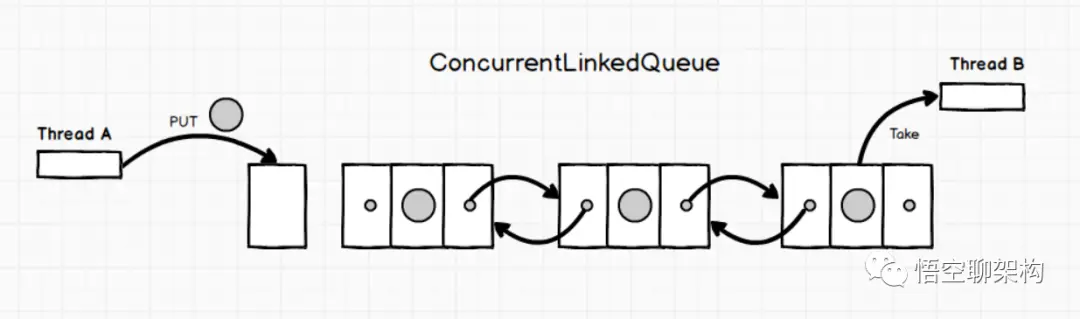

Queue: ConcurrentLinkedQueue

一个基于链接节点的无界线程安全队列。此队列按照 FIFO(先进先出)原则对元素进行排序。队列的头部 是队列中时间最长的元素。队列的尾部 是队列中时间最短的元素。新的元素插入到队列的尾部,队列获取操作从队列头部获得元素。当多个线程共享访问一个公共 collection 时,ConcurrentLinkedQueue 是一个恰当的选择。此队列不允许使用 null 元素。

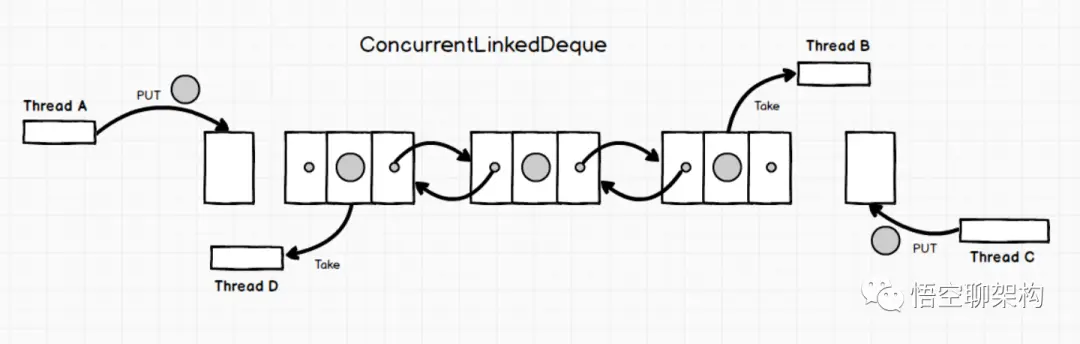

Queue: ConcurrentLinkedDeque

是双向链表实现的无界队列,该队列同时支持FIFO和FILO两种操作方式。

Queue: DelayQueue

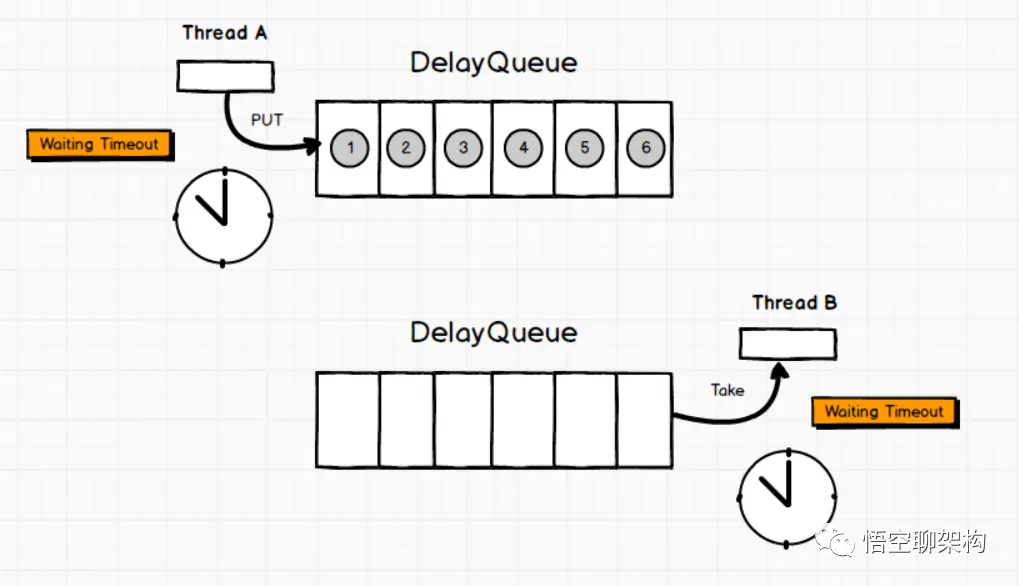

延时无界阻塞队列,使用 Lock 机制实现并发访问。队列里只允许放可以“延期”的元素,队列中的 head 是最先“到期”的元素。如果队里中没有元素到“到期”,那么就算队列中有元素也不能获取到。

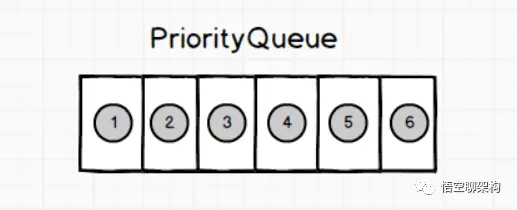

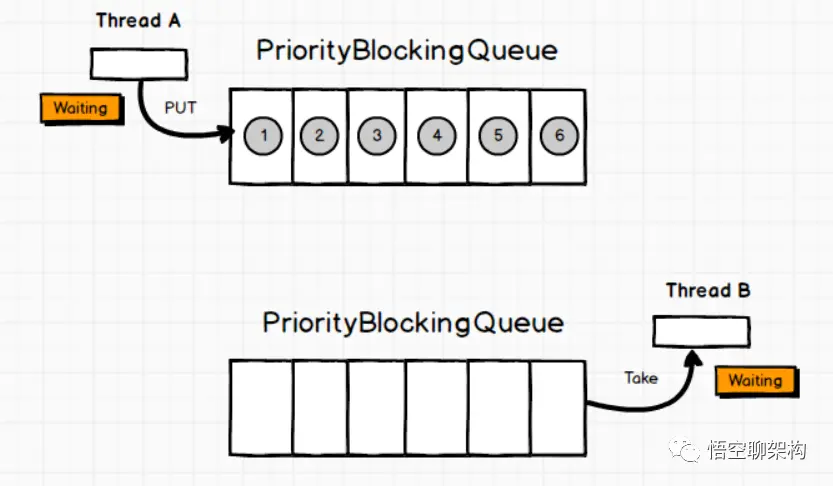

Queue: PriorityBlockingQueue

无界优先级阻塞队列,使用 Lock 机制实现并发访问。priorityQueue 的线程安全版,不允许存放 null 值,依赖于 comparable 的排序,不允许存放不可比较的对象类型。

Queue: SynchronousQueue

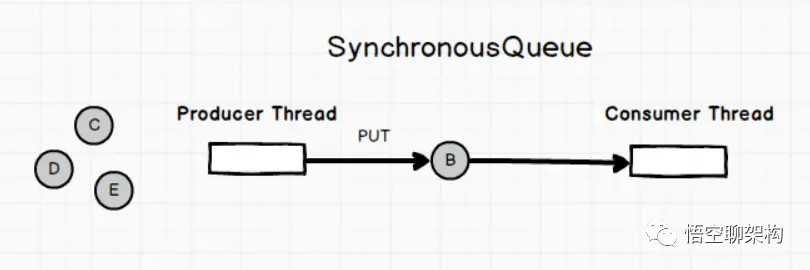

没有容量的同步队列,通过CAS实现并发访问,支持FIFO和FILO

Queue: LinkedTransferQueue

JDK 7新增,单向链表实现的无界阻塞队列,通过CAS实现并发访问,队列元素使用 FIFO(先进先出)方式。LinkedTransferQueue可以说是ConcurrentLinkedQueue、SynchronousQueue(公平模式)和LinkedBlockingQueue的超集, 它不仅仅综合了这几个类的功能,同时也提供了更高效的实现。

List: CopyOnWriteArrayList

ArrayList 的一个线程安全的变体,其中所有可变操作(add、set 等等)都是通过对底层数组进行一次新的复制来实现的。这一般需要很大的开销,但是当遍历操作的数量大大超过可变操作的数量时,这种方法可能比其他替代方法更 有效。在不能或不想进行同步遍历,但又需要从并发线程中排除冲突时,它也很有用。

Set: CopyOnWriteArraySet

对其所有操作使用内部CopyOnWriteArrayList的Set。即将所有操作转发至CopyOnWriteArayList来进行操作,能够保证线程安全。在add时,会调用addIfAbsent,由于每次add时都要进行数组遍历,因此性能会略低于CopyOnWriteArrayList。

Set: ConcurrentSkipListSet

一个基于ConcurrentSkipListMap 的可缩放并发 NavigableSet 实现。set 的元素可以根据它们的自然顺序进行排序,也可以根据创建 set 时所提供的 Comparator 进行排序,具体取决于使用的构造方法。

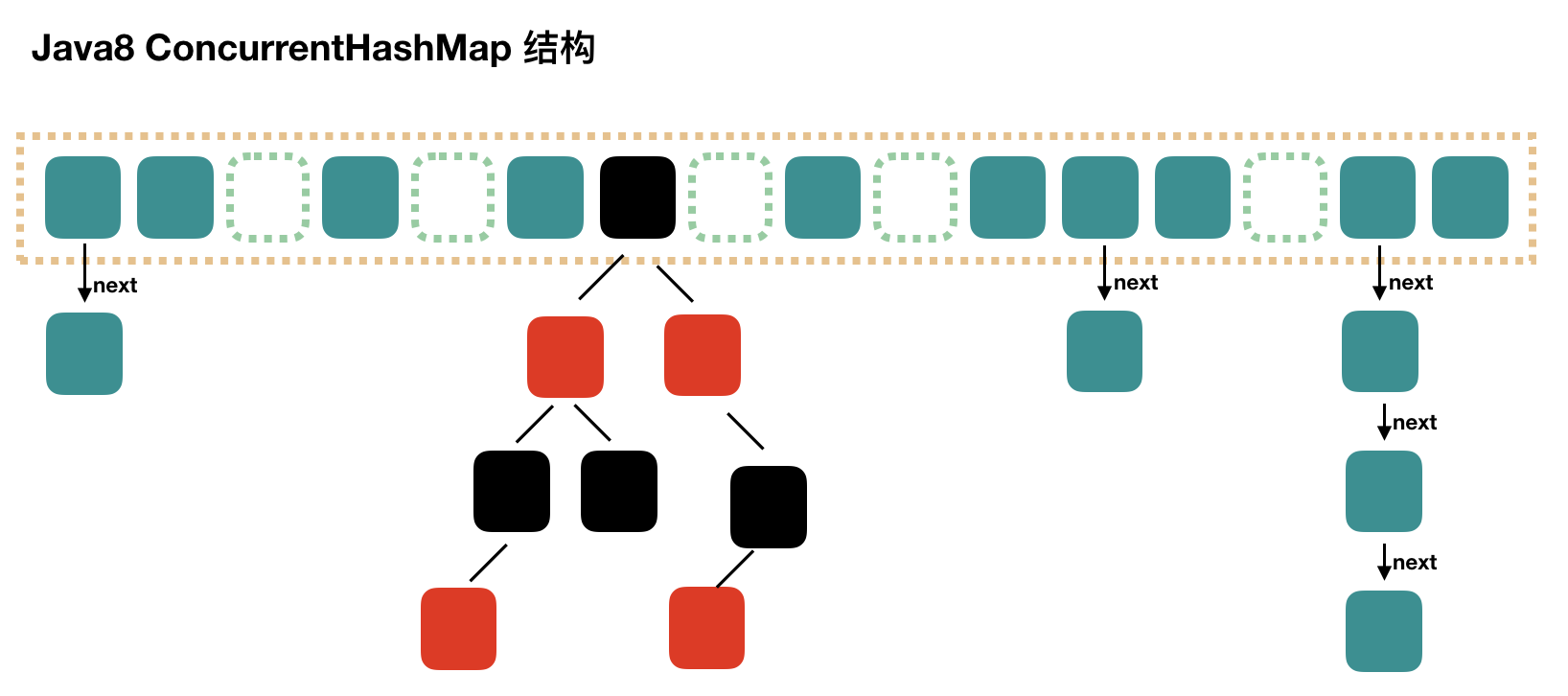

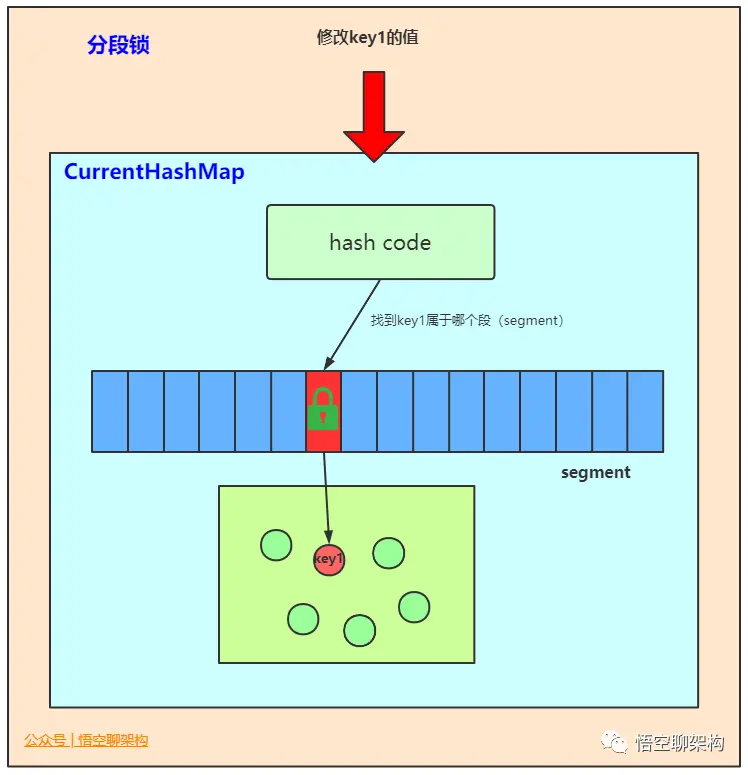

Map: ConcurrentHashMap

是线程安全HashMap的。ConcurrentHashMap在JDK 7之前是通过Lock和segment(分段锁)实现,JDK 8 之后改为CAS+synchronized来保证并发安全。

Map: ConcurrentSkipListMap

线程安全的有序的哈希表(相当于线程安全的TreeMap);映射可以根据键的自然顺序进行排序,也可以根据创建映射时所提供的 Comparator 进行排序,具体取决于使用的构造方法。

Atomic: 原子类

其基本的特性就是在多线程环境下,当有多个线程同时执行这些类的实例包含的方法时,具有排他性,即当某个线程进入方法,执行其中的指令时,不会被其他线程打断,而别的线程就像自旋锁一样,一直等到该方法执行完成,才由JVM从等待队列中选择一个另一个线程进入,这只是一种逻辑上的理解。实际上是借助硬件的相关指令来实现的,不会阻塞线程(或者说只是在硬件级别上阻塞了)。

基础类型:AtomicBoolean、AtomicInteger、AtomicLong

数组:AtomicIntegerArray,AtomicLongArray,BooleanArray

引用:AtomicReference,AtomicMarkedReference,AtomicStampedReference

FieldUpdater:AtomicLongFieldUpdater,AtomicIntegerFieldUpdater,AtomicReferenceFieldUpdater

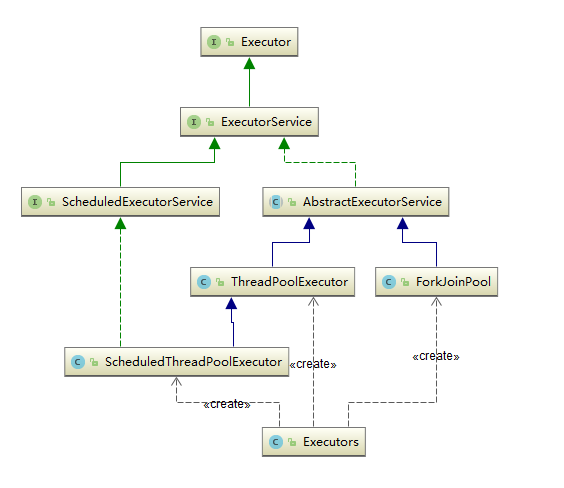

Executors:线程池

层级结构

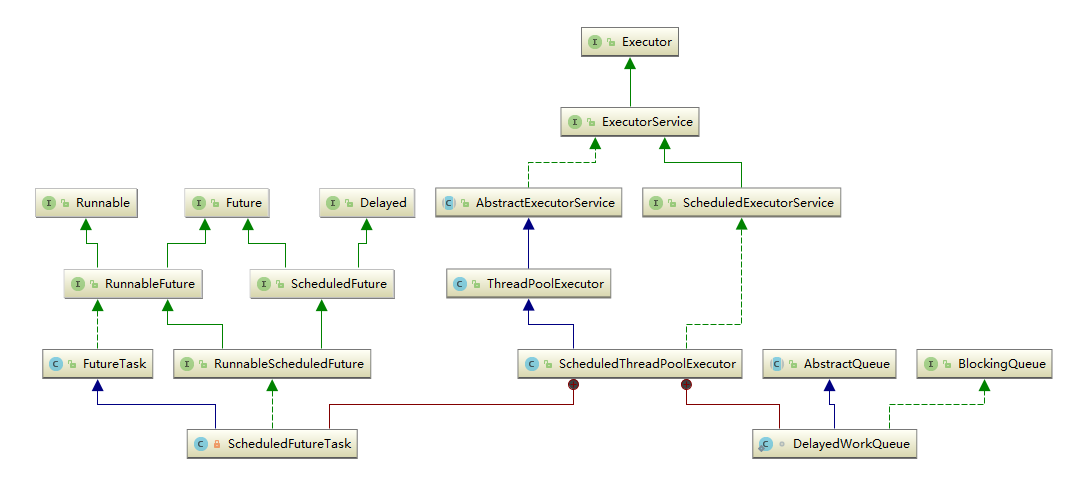

接口:Executor

Executor 接口提供一种将任务提交与每个任务将如何运行的机制(包括线程使用的细节、调度等)分离开来的方法。通常使用 Executor 而不是显式地创建线程。

ExecutorService

ExecutorService 继承自 Executor 接口,ExecutorService 提供了管理终止的方法,以及可为跟踪一个或多个异步任务执行状况而生成 Future 的方法。 可以关闭 ExecutorService,这将导致其停止接受新任务。关闭后,执行程序将最后终止,这时没有任务在执行,也没有任务在等待执行,并且无法提交新任务。

ScheduledExecutorService

ScheduledExecutorService继承自ExecutorService接口,可安排在给定的延迟后运行或定期执行的命令。

AbstractExecutorService

AbstractExecutorService 继承自 ExecutorService 接口,其提供 ExecutorService 执行方法的默认实现。此类使用 newTaskFor 返回的 RunnableFuture 实现 submit、invokeAny 和 invokeAll 方法,默认情况下,RunnableFuture 是此包中提供的 FutureTask 类。

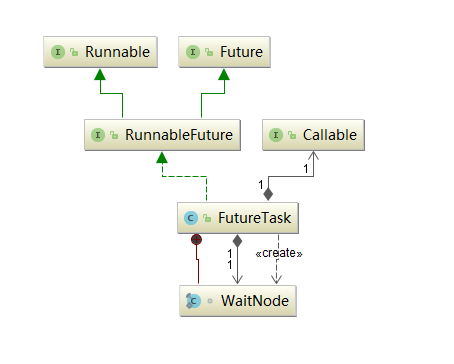

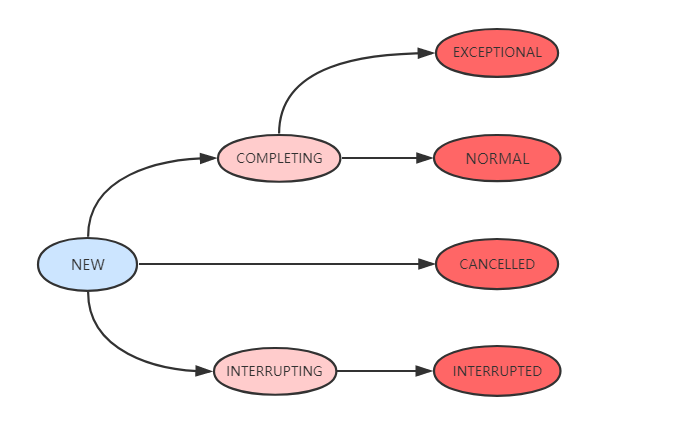

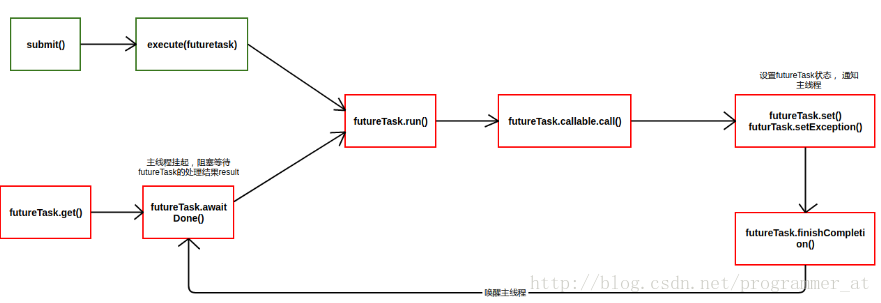

FutureTask

FutureTask 为 Future 提供了基础实现,如获取任务执行结果(get)和取消任务(cancel)等。如果任务尚未完成,获取任务执行结果时将会阻塞。一旦执行结束,任务就不能被重启或取消(除非使用runAndReset执行计算)。FutureTask 常用来封装 Callable 和 Runnable,也可以作为一个任务提交到线程池中执行。除了作为一个独立的类之外,此类也提供了一些功能性函数供我们创建自定义 task 类使用。FutureTask 的线程安全由CAS来保证。

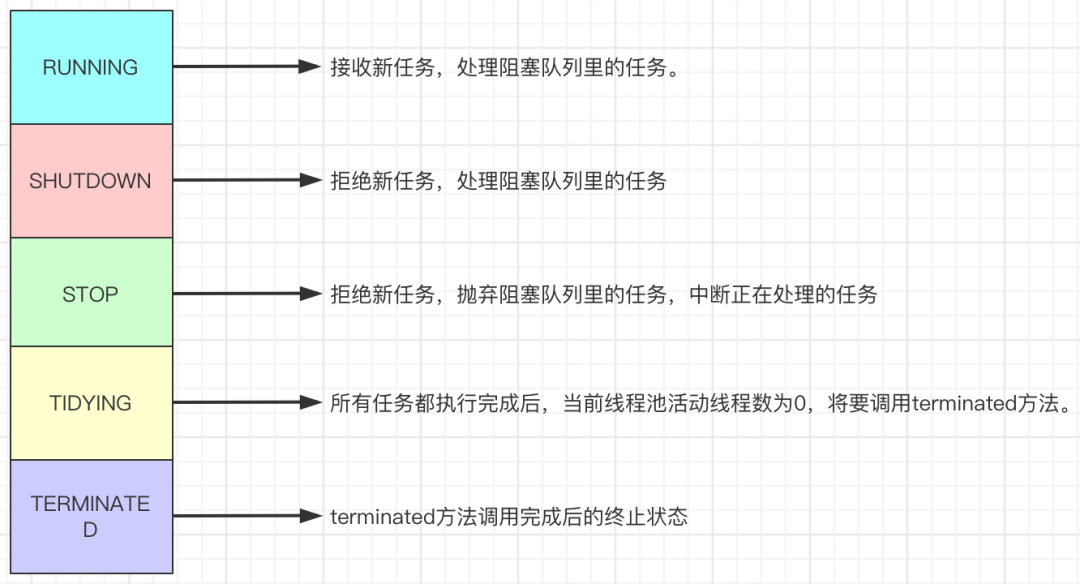

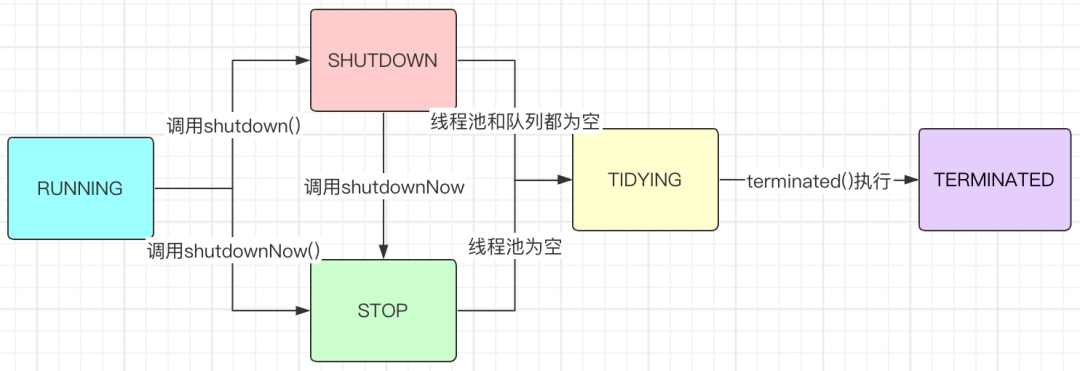

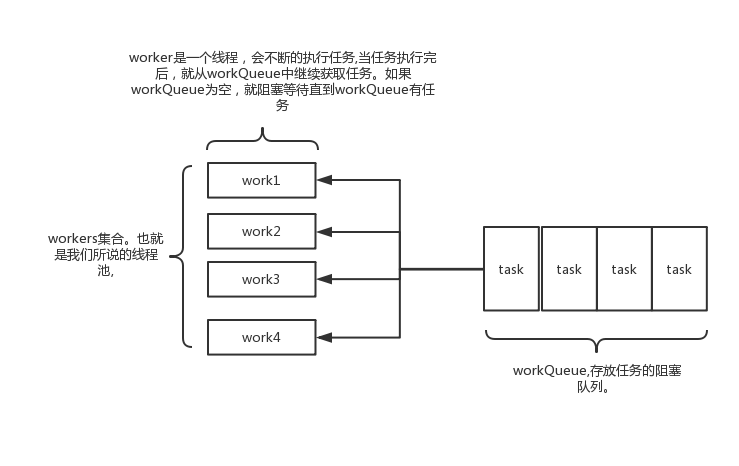

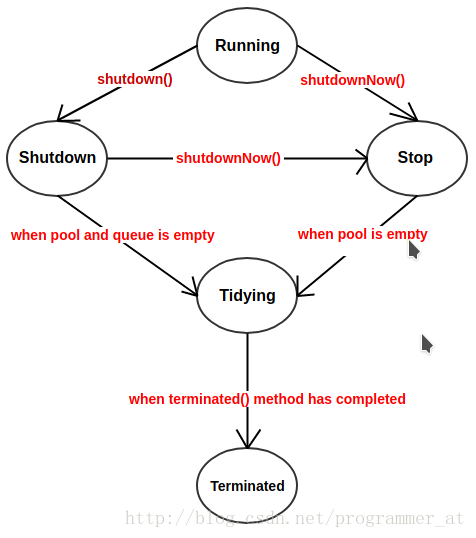

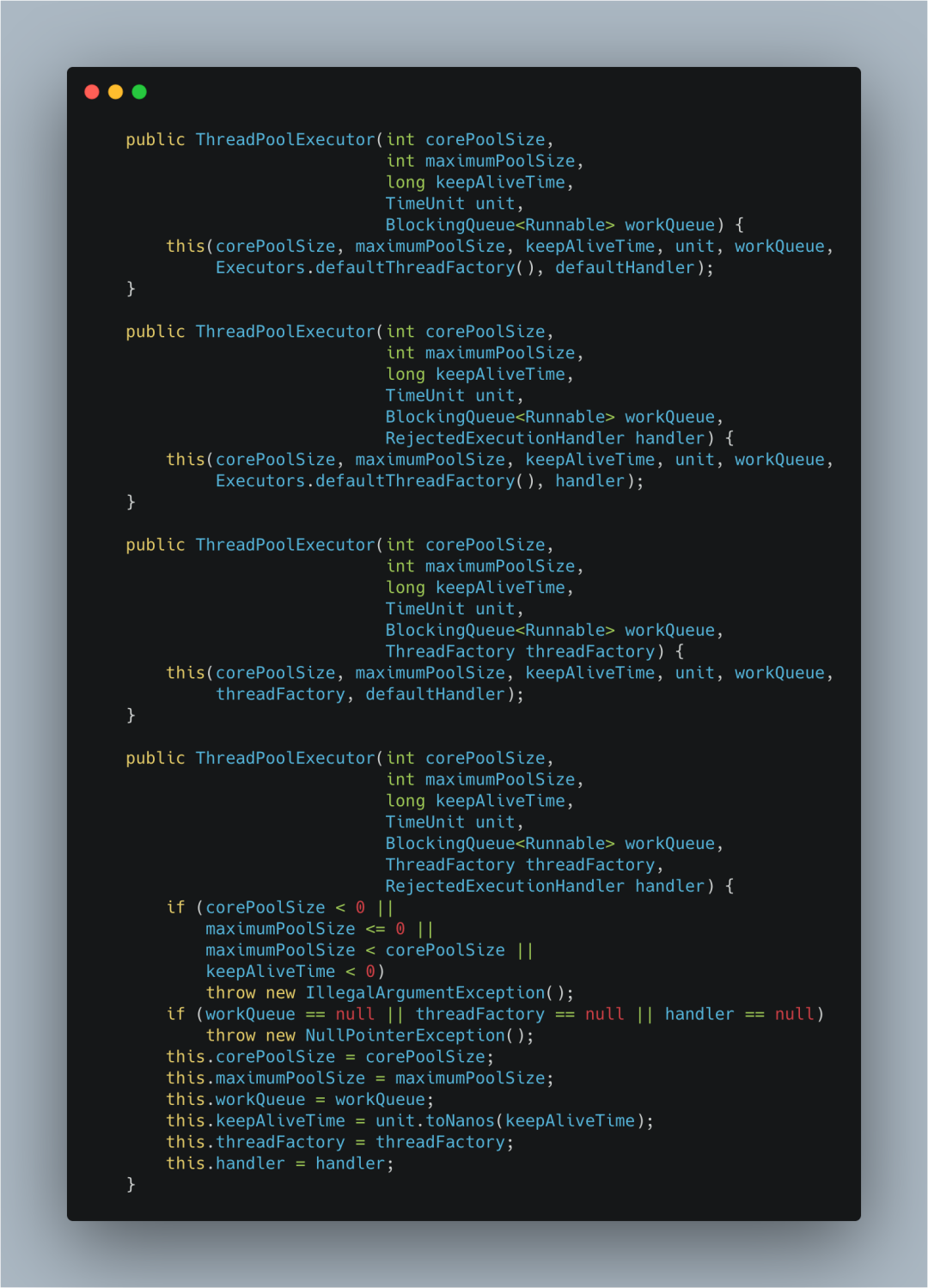

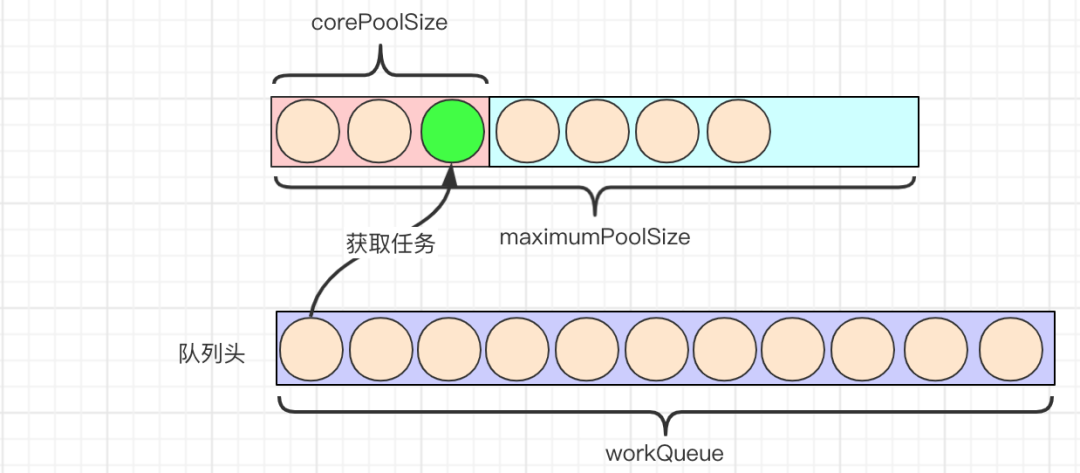

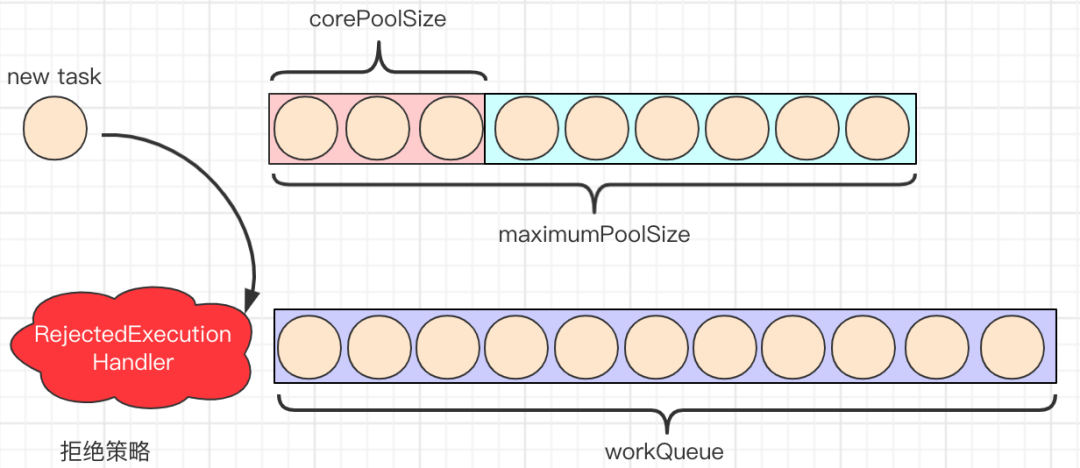

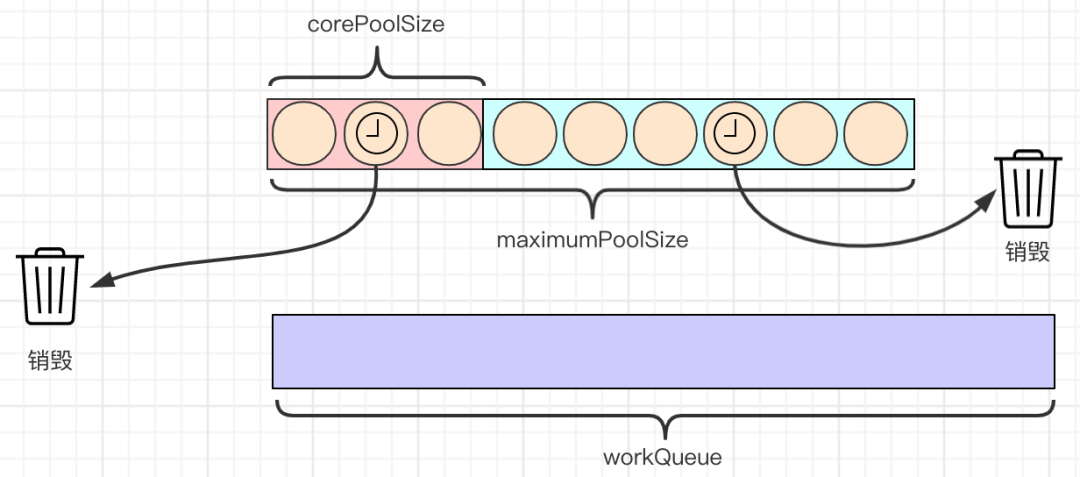

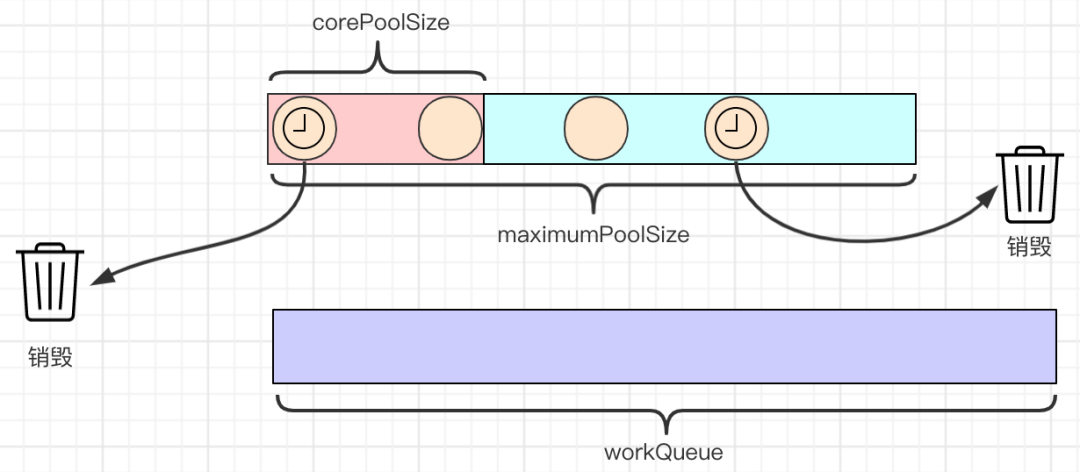

核心: ThreadPoolExecutor

ThreadPoolExecutor 实现了 AbstractExecutorService 接口,也是一个 ExecutorService,它使用可能的几个池线程之一执行每个提交的任务,通常使用 Executors 工厂方法配置。 线程池可以解决两个不同问题: 由于减少了每个任务调用的开销,它们通常可以在执行大量异步任务时提供增强的性能,并且还可以提供绑定和管理资源(包括执行任务集时使用的线程)的方法。每个 ThreadPoolExecutor 还维护着一些基本的统计数据,如完成的任务数。

核心: ScheduledThreadExecutor

ScheduledThreadPoolExecutor 实现 ScheduledExecutorService 接口,可安排在给定的延迟后运行命令,或者定期执行命令。需要多个辅助线程时,或者要求 ThreadPoolExecutor 具有额外的灵活性或功能时,此类要优于 Timer。

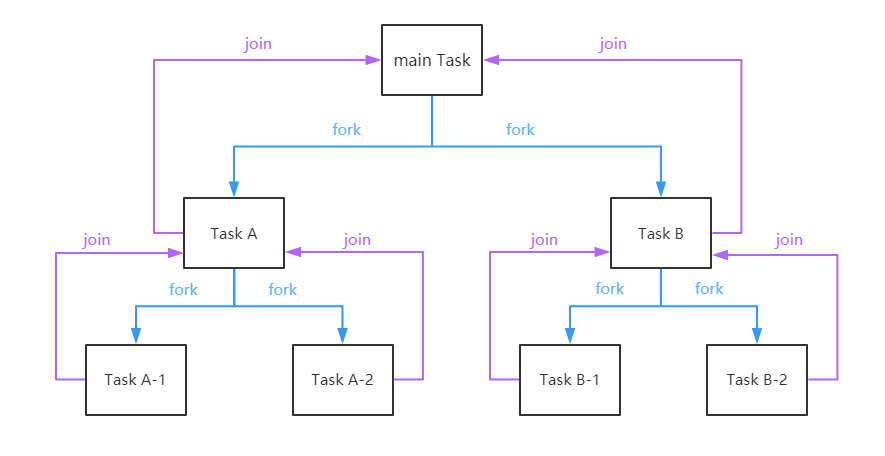

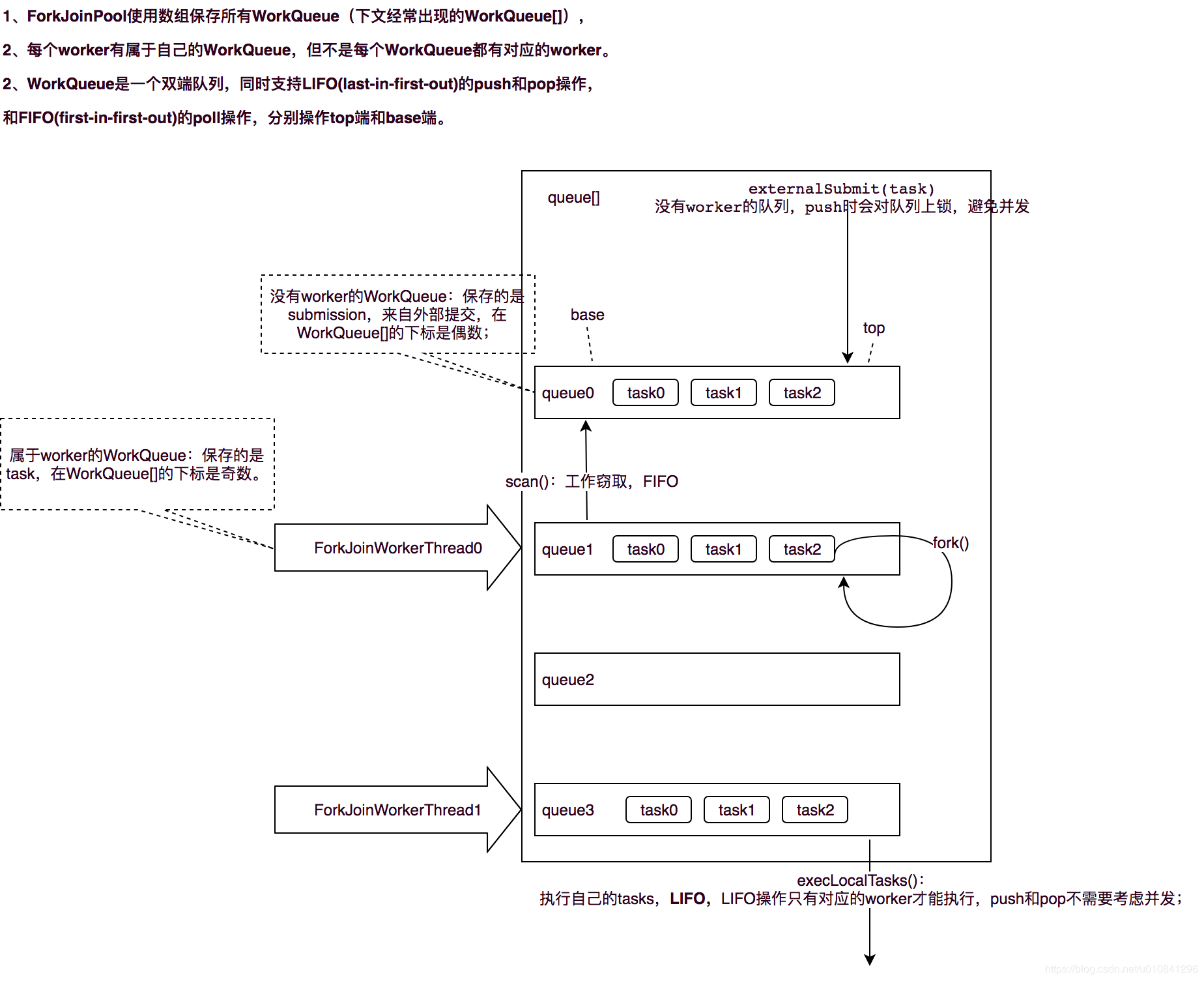

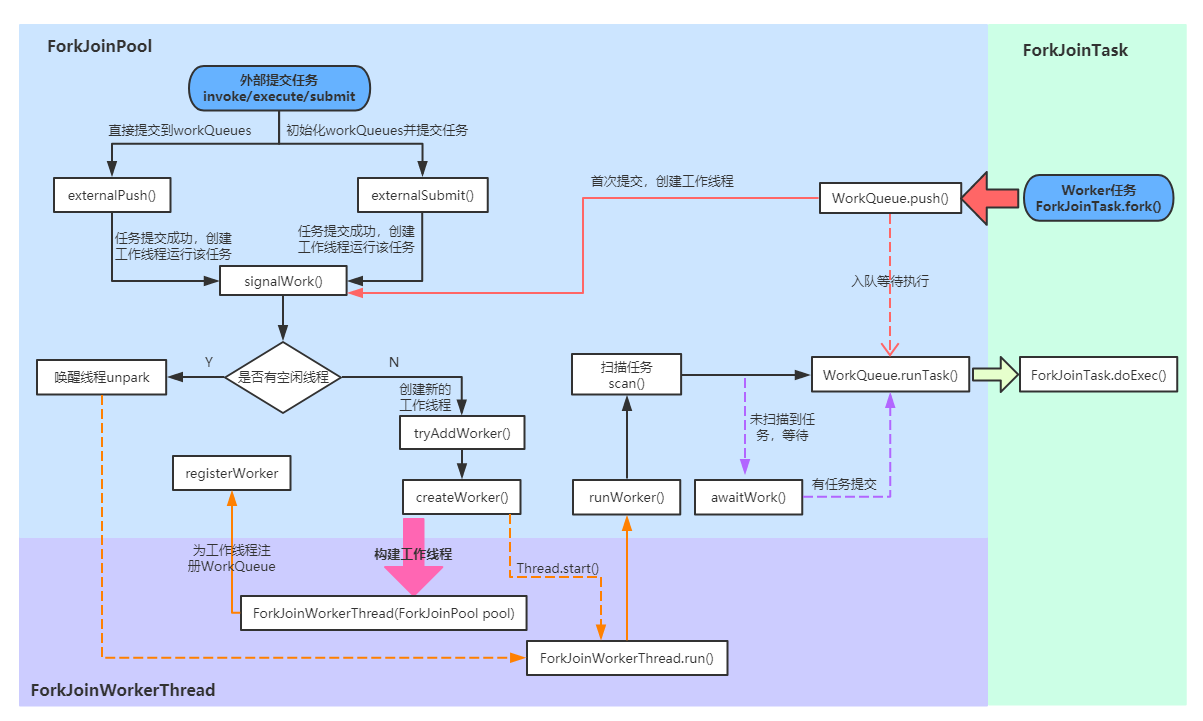

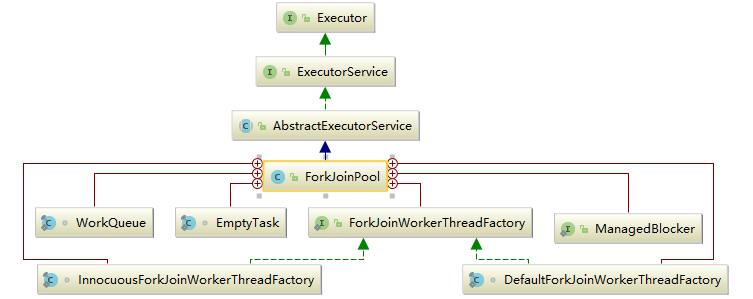

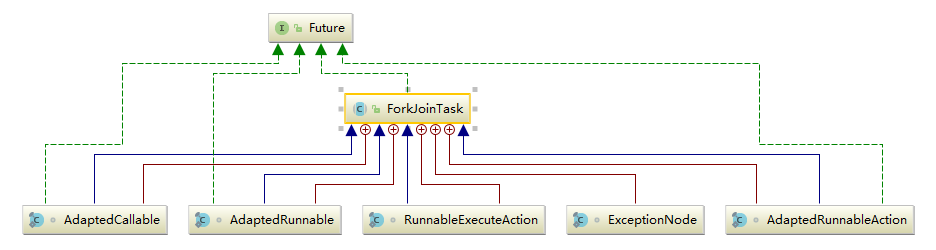

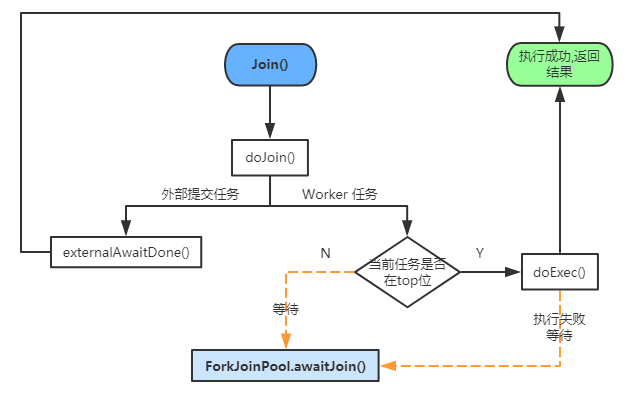

核心: Fork/Join框架

ForkJoinPool 是JDK 7 加入的一个线程池类。Fork/Join 技术是分治算法(Divide-and-Conquer)的并行实现,它是一项可以获得良好的并行性能的简单且高效的设计技术。目的是为了帮助我们更好地利用多处理器带来的好处,使用所有可用的运算能力来提升应用的性能。

工具类: Executors

Executors 是一个工具类,用其可以创建 ExecutorService、ScheduledExecutorService、ThreadFactory、Callable 等对象。它的使用融入到了 ThreadPoolExecutor, ScheduledThreadExecutor 和 ForkJoinPool 中。

9 - CH09-底层支撑

CAS

现在安全的实现方法:

- 互斥同步:synchronized、ReentrantLock

- 非阻塞同步:CAS、Atomic-

- 无同步方案:栈封闭、TreadLocal、可重入代码

什么是 CAS

CAS 的全称为 Compare-And-Swap,直译就是对比交换。是一条 CPU 的原子指令,其作用是让 CPU 先进行比较两个值是否相等,然后原子地更新某个位置的值,经过调查发现,其实现方式是基于硬件平台的汇编指令,就是说 CAS 是靠硬件实现的,JVM 只是封装了汇编调用,那些 AtomicInteger 类便是使用了这些封装后的接口。

简单解释:CAS操作需要输入两个数值,一个旧值(期望操作前的值)和一个新值,在操作期间先比较下在旧值有没有发生变化,如果没有发生变化,才交换成新值,发生了变化则不交换。

CAS 操作是原子性的,所以多线程并发使用 CAS 更新数据时,可以不使用锁。JDK 中大量使用了 CAS 来更新数据而防止加锁(synchronized 重量级锁)来保持原子更新。

应用示例

如果不使用CAS,在高并发下,多线程同时修改一个变量的值我们需要synchronized加锁(可能有人说可以用Lock加锁,Lock底层的AQS也是基于CAS进行获取锁的)。

public class Test {

private int i=0;

public synchronized int add(){

return i++;

}

}

java中为我们提供了AtomicInteger 原子类(底层基于CAS进行更新数据的),不需要加锁就在多线程并发场景下实现数据的一致性。

public class Test {

private AtomicInteger i = new AtomicInteger(0);

public int add(){

return i.addAndGet(1);

}

}

CAS 问题

CAS 方式为乐观锁,synchronized 为悲观锁。因此使用 CAS 解决并发问题通常情况下性能更优。

但使用 CAS 方式也会有几个问题:

ABA 问题

因为 CAS 需要在操作值的时候,检查值有没有发生变化,比如没有发生变化则更新,但是如果一个值原来是 A,变成了 B,又变成了 A,那么使用 CAS 进行检查时则会发现它的值没有发生变化,但是实际上却变化了。

ABA 问题的解决思路就是使用版本号。在变量前面追加上版本号,每次变量更新的时候把版本号加1,那么 A->B->A 就会变成 1A->2B->3A。

从 Java 1.5 开始,JDK 的 Atomic 包里提供了一个类 AtomicStampedReference 来解决 ABA 问题。这个类的 compareAndSet 方法的作用是首先检查当前引用是否等于预期引用,并且检查当前标志是否等于预期标志,如果全部相等,则以原子方式将该引用和该标志的值设置为给定的更新值。

循环时间长开销大

自旋 CAS 如果长时间不成功,会给 CPU 带来非常大的执行开销。如果 JVM 能支持处理器提供的 pause 指令,那么效率会有一定的提升。

pause 指令有两个作用:

- 第一,它可以延迟流水线执行命令(de-pipeline),使 CPU 不会消耗过多的执行资源,延迟的时间取决于具体实现的版本,在一些处理器上延迟时间是零;

- 第二,它可以避免在退出循环的时候因内存顺序冲突(Memory Order Violation)而引起 CPU 流水线被清空(CPU Pipeline Flush),从而提高 CPU 的执行效率。

仅作用于单个变量

当对一个共享变量执行操作时,我们可以使用循环 CAS 的方式来保证原子操作,但是对多个共享变量操作时,循环 CAS 就无法保证操作的原子性,这个时候就可以用锁。

还有一个取巧的办法,就是把多个共享变量合并成一个共享变量来操作。比如,有两个共享变量 i = 2,j = a,合并一下 ij = 2a,然后用 CAS 来操作 ij。

从 Java 1.5 开始,JDK 提供了 AtomicReference 类来保证引用对象之间的原子性,就可以把多个变量放在一个对象里来进行 CAS 操作。

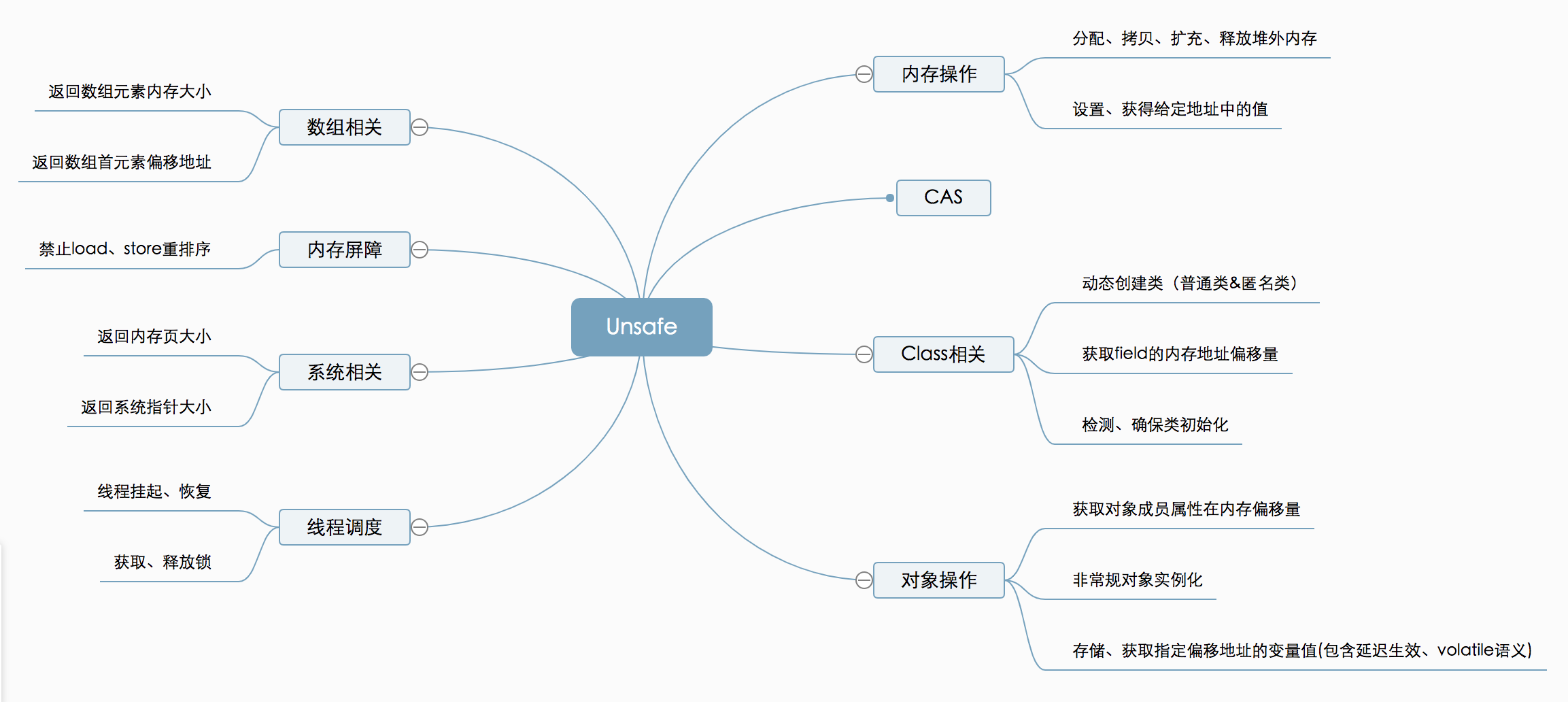

UnSafe 类

Java 原子类是通过 UnSafe 类实现的。

Unsafe 是位于 sun.misc 包下的一个类,主要提供一些用于执行低级别、不安全操作的方法,如直接访问系统内存资源、自主管理内存资源等,这些方法在提升 Java 运行效率、增强 Java 语言底层资源操作能力方面起到了很大的作用。

但由于 Unsafe 类使 Java 语言拥有了类似 C 语言指针一样操作内存空间的能力,这无疑也增加了程序发生相关指针问题的风险。在程序中过度、不正确使用 Unsafe 类会使得程序出错的概率变大,使得 Java 这种安全的语言变得不再“安全”,因此对 Unsafe 的使用一定要慎重。

这个类尽管里面的方法都是 public 的,但是并没有办法使用它们,JDK API 文档也没有提供任何关于这个类的方法的解释。总而言之,对于 Unsafe 类的使用都是受限制的,只有授信的代码才能获得该类的实例,当然 JDK 库里面的类是可以随意使用的。

功能概览:

UnSafe 与 CAS

内部使用自旋的方式进行CAS更新(while循环进行CAS更新,如果更新失败,则循环再次重试)。

public final int getAndAddInt(Object paramObject, long paramLong, int paramInt)

{

int i;

do

i = getIntVolatile(paramObject, paramLong);

while (!compareAndSwapInt(paramObject, paramLong, i, i + paramInt));

return i;

}

public final long getAndAddLong(Object paramObject, long paramLong1, long paramLong2)

{

long l;

do

l = getLongVolatile(paramObject, paramLong1);

while (!compareAndSwapLong(paramObject, paramLong1, l, l + paramLong2));

return l;

}

public final int getAndSetInt(Object paramObject, long paramLong, int paramInt)

{

int i;

do

i = getIntVolatile(paramObject, paramLong);

while (!compareAndSwapInt(paramObject, paramLong, i, paramInt));

return i;

}

public final long getAndSetLong(Object paramObject, long paramLong1, long paramLong2)

{

long l;

do

l = getLongVolatile(paramObject, paramLong1);

while (!compareAndSwapLong(paramObject, paramLong1, l, paramLong2));

return l;

}

public final Object getAndSetObject(Object paramObject1, long paramLong, Object paramObject2)

{

Object localObject;

do

localObject = getObjectVolatile(paramObject1, paramLong);

while (!compareAndSwapObject(paramObject1, paramLong, localObject, paramObject2));

return localObject;

}

从 UnSafe 类中发现,原子操作仅提供了三个方法:

public final native boolean compareAndSwapObject(Object paramObject1, long paramLong, Object paramObject2, Object paramObject3);

public final native boolean compareAndSwapInt(Object paramObject, long paramLong, int paramInt1, int paramInt2);

public final native boolean compareAndSwapLong(Object paramObject, long paramLong1, long paramLong2, long paramLong3);

UnSafe 底层

查看 Unsafe的compareAndSwap- 方法来实现 CAS 操作,它是一个本地方法,实现位于 unsafe.cpp 中。

UNSAFE_ENTRY(jboolean, Unsafe_CompareAndSwapInt(JNIEnv *env, jobject unsafe, jobject obj, jlong offset, jint e, jint x))

UnsafeWrapper("Unsafe_CompareAndSwapInt");

oop p = JNIHandles::resolve(obj);

jint* addr = (jint *) index_oop_from_field_offset_long(p, offset);

return (jint)(Atomic::cmpxchg(x, addr, e)) == e;

UNSAFE_END

可以看到它通过 Atomic::cmpxchg 来实现比较和替换操作。其中参数x是即将更新的值,参数e是原内存的值。

如果是Linux的x86,Atomic::cmpxchg方法的实现如下:

inline jint Atomic::cmpxchg (jint exchange_value, volatile jint* dest, jint compare_value) {

int mp = os::is_MP();

__asm__ volatile (LOCK_IF_MP(%4) "cmpxchgl %1,(%3)"

: "=a" (exchange_value)

: "r" (exchange_value), "a" (compare_value), "r" (dest), "r" (mp)

: "cc", "memory");

return exchange_value;

}

而 windows 的 x86 的实现如下:

inline jint Atomic::cmpxchg (jint exchange_value, volatile jint* dest, jint compare_value) {

int mp = os::isMP(); //判断是否是多处理器

_asm {

mov edx, dest

mov ecx, exchange_value

mov eax, compare_value

LOCK_IF_MP(mp)

cmpxchg dword ptr [edx], ecx

}

}

// Adding a lock prefix to an instruction on MP machine

// VC++ doesn't like the lock prefix to be on a single line

// so we can't insert a label after the lock prefix.

// By emitting a lock prefix, we can define a label after it.

#define LOCK_IF_MP(mp) __asm cmp mp, 0 \

__asm je L0 \

__asm _emit 0xF0 \

__asm L0:

如果是多处理器,为 cmpxchg 指令添加 lock 前缀。反之,就省略 lock 前缀(单处理器会不需要 lock 前缀提供的内存屏障效果)。这里的 lock 前缀就是使用了处理器的总线锁(最新的处理器都使用缓存锁代替总线锁来提高性能)。

cmpxchg(void* ptr, int old, int new),如果 ptr 和 old 的值一样,则把 new 写到 ptr 内存,否则返回 ptr 的值,整个操作是原子的。在 Intel 平台下,会用 lock cmpxchg 来实现,使用 lock 触发缓存锁,这样另一个线程想访问 ptr 的内存,就会被 block 住。

UnSafe 其他功能

Unsafe 提供了硬件级别的操作,比如说获取某个属性在内存中的位置,比如说修改对象的字段值,即使它是私有的。不过 Java 本身就是为了屏蔽底层的差异,对于一般的开发而言也很少会有这样的需求。

举两个例子,比方说:

public native long staticFieldOffset(Field paramField);

这个方法可以用来获取给定的 paramField 的内存地址偏移量,这个值对于给定的 field 是唯一的且是固定不变的。

public native int arrayBaseOffset(Class paramClass);

public native int arrayIndexScale(Class paramClass);

前一个方法是用来获取数组第一个元素的偏移地址,后一个方法是用来获取数组的转换因子即数组中元素的增量地址的。

public native long allocateMemory(long paramLong);

public native long reallocateMemory(long paramLong1, long paramLong2);

public native void freeMemory(long paramLong);

分别用来分配内存,扩充内存和释放内存的。

AtomicInteger

public final int get():获取当前的值

public final int getAndSet(int newValue):获取当前的值,并设置新的值

public final int getAndIncrement():获取当前的值,并自增

public final int getAndDecrement():获取当前的值,并自减

public final int getAndAdd(int delta):获取当前的值,并加上预期的值

void lazySet(int newValue): 最终会设置成newValue,使用lazySet设置值后,可能导致其他线程在之后的一小段时间内还是可以读到旧的值。

源码解析

public class AtomicInteger extends Number implements java.io.Serializable {

private static final Unsafe unsafe = Unsafe.getUnsafe();

private static final long valueOffset;

static {

try {

//用于获取value字段相对当前对象的“起始地址”的偏移量

valueOffset = unsafe.objectFieldOffset(AtomicInteger.class.getDeclaredField("value"));

} catch (Exception ex) { throw new Error(ex); }

}

private volatile int value;

//返回当前值

public final int get() {

return value;

}

//递增加detla

public final int getAndAdd(int delta) {

//三个参数,1、当前的实例 2、value实例变量的偏移量 3、当前value要加上的数(value+delta)。

return unsafe.getAndAddInt(this, valueOffset, delta);

}

//递增加1

public final int incrementAndGet() {

return unsafe.getAndAddInt(this, valueOffset, 1) + 1;

}

...

}

AtomicInteger 底层用的是volatile的变量和CAS来进行更改数据的:

- volatile 保证线程的可见性,多线程并发时,一个线程修改数据,可以保证其它线程立马看到修改后的值

- CAS 保证数据更新的原子性

所有原子类

原子基本类型

使用原子的方式更新基本类型,Atomic 包共有 3 个类:

- AtomicBoolean

- AtomicInteger

- AtomicLong

原子数组

通过原子的方式更新数组里的某个元素,Atomic 包提供了以下的 4 个类:

- AtomicIntegerArray

- AtomicLongArray

- AtomicReferenceArray

常用方法:

get(int index)compareAndSet(int i, E expect, E update)

原子引用

- AtomicReference: 原子更新引用类型。

- AtomicStampedReference: 原子更新引用类型, 内部使用Pair来存储元素值及其版本号。

- AtomicMarkableReferce: 原子更新带有标记位的引用类型。

都是基于 UnSafe 实现,但 AtomicReferenceFieldUpdater 所更新的字段必须使用 volatile 修饰。

原子字段更新

AtomicIntegerFieldUpdater: 原子更新整型的字段的更新器。

AtomicLongFieldUpdater: 原子更新长整型字段的更新器。

AtomicStampedFieldUpdater: 原子更新带有版本号的引用类型。

AtomicReferenceFieldUpdater: 上面已经说过此处不在赘述。

以上均为基于反射的原子更新字段的值,要想原子地更新字段类需要两步:

- 第一步,因为原子更新字段类都是抽象类,每次使用的时候必须使用静态方法newUpdater()创建一个更新器,并且需要设置想要更新的类和属性。

- 第二步,更新类的字段必须使用public volatile修饰。

public class TestAtomicIntegerFieldUpdater {

public static void main(String[] args){

TestAtomicIntegerFieldUpdater tIA = new TestAtomicIntegerFieldUpdater();

tIA.doIt();

}

public AtomicIntegerFieldUpdater<DataDemo> updater(String name){

return AtomicIntegerFieldUpdater.newUpdater(DataDemo.class,name);

}

public void doIt(){

DataDemo data = new DataDemo();

System.out.println("publicVar = "+updater("publicVar").getAndAdd(data, 2));

}

}

class DataDemo{

public volatile int publicVar=3;

protected volatile int protectedVar=4;

private volatile int privateVar=5;

public volatile static int staticVar = 10;

//public final int finalVar = 11;

public volatile Integer integerVar = 19;

public volatile Long longVar = 18L;

}

AtomicIntegerFieldUpdater 应用约束:

- 字段必须是 volatile 类型的,在线程之间共享变量时保证立即可见。

- 字段的描述类型(修饰符public/protected/default/private)是与调用者与操作对象字段的关系一致。

- 也就是说调用者能够直接操作对象字段,那么就可以反射进行原子操作。但是对于父类的字段,子类是不能直接操作的,尽管子类可以访问父类的字段。

- 只能是实例变量,不能是类变量,也就是说不能加 static 关键字。

- 只能是可修改变量,不能使 final 变量,因为 final 的语义就是不可修改。

- 实际上 final 的语义和 volatile 是有冲突的,这两个关键字不能同时存在。

- 对于 AtomicIntegerFieldUpdater 和 AtomicLongFieldUpdater 只能修改 int/long 类型的字段,不能修改其包装类型(Integer/Long)。

- 如果要修改包装类型就需要使用 AtomicReferenceFieldUpdater。

AtomicStampedReference 与 ABA

AtomicStampedReference 主要维护包含一个对象引用以及一个可以自动更新的整数 “stamp” 的 pair 对象来解决 ABA 问题。

public class AtomicStampedReference<V> {

private static class Pair<T> {

final T reference; //维护对象引用

final int stamp; //用于标志版本

private Pair(T reference, int stamp) {

this.reference = reference;

this.stamp = stamp;

}

static <T> Pair<T> of(T reference, int stamp) {

return new Pair<T>(reference, stamp);

}

}

private volatile Pair<V> pair;

....

/**

* expectedReference :更新之前的原始值

* newReference : 将要更新的新值

* expectedStamp : 期待更新的标志版本

* newStamp : 将要更新的标志版本

*/

public boolean compareAndSet(V expectedReference,

V newReference,

int expectedStamp,

int newStamp) {

// 获取当前的(元素值,版本号)对

Pair<V> current = pair;

return

// 引用没变

expectedReference == current.reference &&

// 版本号没变

expectedStamp == current.stamp &&

// 新引用等于旧引用

((newReference == current.reference &&

// 新版本号等于旧版本号

newStamp == current.stamp) ||

// 构造新的Pair对象并CAS更新

casPair(current, Pair.of(newReference, newStamp)));

}

private boolean casPair(Pair<V> cmp, Pair<V> val) {

// 调用Unsafe的compareAndSwapObject()方法CAS更新pair的引用为新引用

return UNSAFE.compareAndSwapObject(this, pairOffset, cmp, val);

}

- 如果元素值和版本号都没有变化,并且和新的也相同,返回true;

- 如果元素值和版本号都没有变化,并且和新的不完全相同,就构造一个新的Pair对象并执行CAS更新pair。

可以看到,java中的实现跟我们上面讲的ABA的解决方法是一致的。

- 首先,使用版本号控制;

- 其次,不重复使用节点(Pair)的引用,每次都新建一个新的Pair来作为CAS比较的对象,而不是复用旧的;

- 最后,外部传入元素值及版本号,而不是节点(Pair)的引用。

AtomicMarkableReference

AtomicMarkableReference,它不是维护一个版本号,而是维护一个boolean类型的标记,标记值有修改。

10 - CH10-LockSupport

功能介绍

LockSupport 是用来创建锁和其他同步类的基本线程阻塞原语。

- 当调用 LockSupport.park 时,当前线程会等待直至获取许可;

- 当调用 LockSupport.unpack 时,必须把扥带获取许可的线程作为参数传递,以使其恢复运行。

源码分析

基本属性

public class LockSupport {

// Hotspot implementation via intrinsics API

private static final sun.misc.Unsafe UNSAFE;

// 表示内存偏移地址

private static final long parkBlockerOffset;

// 表示内存偏移地址

private static final long SEED;

// 表示内存偏移地址

private static final long PROBE;

// 表示内存偏移地址

private static final long SECONDARY;

static {

try {

// 获取Unsafe实例

UNSAFE = sun.misc.Unsafe.getUnsafe();

// 线程类类型

Class<?> tk = Thread.class;

// 获取Thread的parkBlocker字段的内存偏移地址

parkBlockerOffset = UNSAFE.objectFieldOffset

(tk.getDeclaredField("parkBlocker"));

// 获取Thread的threadLocalRandomSeed字段的内存偏移地址

SEED = UNSAFE.objectFieldOffset

(tk.getDeclaredField("threadLocalRandomSeed"));

// 获取Thread的threadLocalRandomProbe字段的内存偏移地址

PROBE = UNSAFE.objectFieldOffset

(tk.getDeclaredField("threadLocalRandomProbe"));

// 获取Thread的threadLocalRandomSecondarySeed字段的内存偏移地址

SECONDARY = UNSAFE.objectFieldOffset

(tk.getDeclaredField("threadLocalRandomSecondarySeed"));

} catch (Exception ex) { throw new Error(ex); }

}

}

构造函数

仅有一个私有构造函数,无法被实例化。

核心函数

LockSupport的核心函数都是基于Unsafe类中定义的park和unpark函数,下面给出两个函数的定义:

public native void park(boolean isAbsolute, long time);

public native void unpark(Thread thread);

- park 函数:阻塞线程,该线程在下列情况发生之前都会被阻塞:

- 调用 unpark 函数,释放该线程的许可。

- 该线程被中断。

- 设置的时间到期,如果 time 为 0 则表示无限等待。

- unpark 函数:释放线程的许可,使调用 park 的线程恢复执行。调用时要确保线性仍然活着。

park

public static void park();

public static void park(Object blocker);

// 第二个函数的实现

public static void park(Object blocker) {

// 获取当前线程

Thread t = Thread.currentThread();

// 设置Blocker

setBlocker(t, blocker);

// 获取许可

UNSAFE.park(false, 0L);

// 重新可运行后再此设置Blocker

setBlocker(t, null);

}

调用 park 函数时,首先获取当前线程,然后设置当前线程的 parkBlocker 字段,即调用 setBlocker 方法,之后调用 UnSafe.park,之后再调用 setBlocker 方法。

调用 park 函数式,当前线程首先设置好 parkBlocker 字段,然后调用 UnSafe.park,此后,当前线程就阻塞了,开始等待该线程的 unpark 函数被调用,所以后面的一个 setBlocker 函数无法执行;unpack 函数被调用后,该线程获得许可,就可以接着执行第二个 setBlocker,把该线程的 parkBlocker 设为 null,即完成了整个 park 函数的逻辑。

如果没有第二个 setBlocker,那么之后没有调用 park(blocker),而直接调用 getBlocker 函数时,会得到原来设置的 blocker,显然不符合逻辑。总之,必须要保证 park 执行完成之后,blocker 被设为 null。

说明: 调用了park函数后,会禁用当前线程,除非许可可用。在以下三种情况之一发生之前,当前线程都将处于休眠状态,即下列情况发生时,当前线程会获取许可,可以继续运行。

- 其他某个线程将当前线程作为目标调用 unpark。

- 其他某个线程中断当前线程。

- 该调用不合逻辑地(即毫无理由地)返回。

parkNanos

此函数表示在许可可用前禁用当前线程,并最多等待指定的等待时间。

public static void parkNanos(Object blocker, long nanos) {

if (nanos > 0) { // 时间大于0

// 获取当前线程

Thread t = Thread.currentThread();

// 设置Blocker

setBlocker(t, blocker);

// 获取许可,并设置了时间

UNSAFE.park(false, nanos);

// 设置许可

setBlocker(t, null);

}

}

parkUntil

此函数表示在指定的时限前禁用当前线程,除非许可可用, 具体函数如下:

public static void parkUntil(Object blocker, long deadline) {

// 获取当前线程

Thread t = Thread.currentThread();

// 设置Blocker

setBlocker(t, blocker);

UNSAFE.park(true, deadline);

// 设置Blocker为null

setBlocker(t, null);

}

unpark

此函数表示如果给定线程的许可尚不可用,则使其可用。如果线程在 park 上受阻塞,则它将解除其阻塞状态。否则,保证下一次调用 park 不会受阻塞。如果给定线程尚未启动,则无法保证此操作有任何效果。

public static void unpark(Thread thread) {

if (thread != null) // 线程为不空

UNSAFE.unpark(thread); // 释放该线程许可

}

应用示例

使用wait/notify实现线程同步

class MyThread extends Thread {

public void run() {

synchronized (this) {

System.out.println("before notify");

notify();

System.out.println("after notify");

}

}

}

public class WaitAndNotifyDemo {

public static void main(String[] args) throws InterruptedException {

MyThread myThread = new MyThread();

synchronized (myThread) {

try {

myThread.start();

// 主线程睡眠3s

Thread.sleep(3000);

System.out.println("before wait");

// 阻塞主线程

myThread.wait();

System.out.println("after wait");

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

before wait

before notify

after notify

after wait

使用wait/notify实现同步时,必须先调用wait,后调用notify,如果先调用notify,再调用wait,将起不了作用。

使用park/unpark实现线程同步

import java.util.concurrent.locks.LockSupport;

class MyThread extends Thread {

private Object object;

public MyThread(Object object) {

this.object = object;

}

public void run() {

System.out.println("before unpark");

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

// 获取blocker

System.out.println("Blocker info " + LockSupport.getBlocker((Thread) object));

// 释放许可

LockSupport.unpark((Thread) object);

// 休眠500ms,保证先执行park中的setBlocker(t, null);

try {

Thread.sleep(500);

} catch (InterruptedException e) {

e.printStackTrace();

}

// 再次获取blocker

System.out.println("Blocker info " + LockSupport.getBlocker((Thread) object));

System.out.println("after unpark");

}

}

public class test {

public static void main(String[] args) {

MyThread myThread = new MyThread(Thread.currentThread());

myThread.start();

System.out.println("before park");

// 获取许可

LockSupport.park("ParkAndUnparkDemo");

System.out.println("after park");

}

}

before park

before unpark

Blocker info ParkAndUnparkDemo

after park

Blocker info null

after unpark

本程序先执行park,然后在执行unpark,进行同步,并且在unpark的前后都调用了getBlocker,可以看到两次的结果不一样,并且第二次调用的结果为null,这是因为在调用unpark之后,执行了Lock.park(Object blocker)函数中的setBlocker(t, null)函数,所以第二次调用getBlocker时为null。

中断响应

import java.util.concurrent.locks.LockSupport;

class MyThread extends Thread {

private Object object;

public MyThread(Object object) {

this.object = object;

}

public void run() {

System.out.println("before interrupt");

try {

// 休眠3s

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

Thread thread = (Thread) object;

// 中断线程

thread.interrupt();

System.out.println("after interrupt");

}

}

public class InterruptDemo {

public static void main(String[] args) {

MyThread myThread = new MyThread(Thread.currentThread());

myThread.start();

System.out.println("before park");

// 获取许可

LockSupport.park("ParkAndUnparkDemo");

System.out.println("after park");

}

}

before park

before interrupt

after interrupt

after park

可以看到,在主线程调用park阻塞后,在myThread线程中发出了中断信号,此时主线程会继续运行,也就是说明此时interrupt起到的作用与unpark一样。

深入理解

Thread.sleep() 和 Object.wait() 的区别

- Thread.sleep()不会释放占有的锁,Object.wait()会释放占有的锁;

- Thread.sleep()必须传入时间,Object.wait()可传可不传,不传表示一直阻塞下去;

- Thread.sleep()到时间了会自动唤醒,然后继续执行;

- Object.wait()不带时间的,需要另一个线程使用Object.notify()唤醒;

- Object.wait()带时间的,假如没有被notify,到时间了会自动唤醒,这时又分好两种情况:

- 一是立即获取到了锁,线程自然会继续执行;

- 二是没有立即获取锁,线程进入同步队列等待获取锁;

他们俩最大的区别就是Thread.sleep()不会释放锁资源,Object.wait()会释放锁资源。

Object.wait() 和 Condition.await() 的区别

Object.wait()和Condition.await()的原理是基本一致的,不同的是Condition.await()底层是调用LockSupport.park()来实现阻塞当前线程的。

实际上,它在阻塞当前线程之前还干了两件事,一是把当前线程添加到条件队列中,二是“完全”释放锁,也就是让state状态变量变为0,然后才是调用LockSupport.park()阻塞当前线程。

Thread.sleep()和LockSupport.park()的区别

LockSupport.park()还有几个兄弟方法——parkNanos()、parkUtil()等,我们这里说的park()方法统称这一类方法。

- 从功能上来说,Thread.sleep()和LockSupport.park()方法类似,都是阻塞当前线程的执行,且都不会释放当前线程占有的锁资源;

- Thread.sleep()没法从外部唤醒,只能自己醒过来;

- LockSupport.park()方法可以被另一个线程调用LockSupport.unpark()方法唤醒;

- Thread.sleep()方法声明上抛出了InterruptedException中断异常,所以调用者需要捕获这个异常或者再抛出;

- LockSupport.park()方法不需要捕获中断异常;

- Thread.sleep()本身就是一个native方法;

- LockSupport.park()底层是调用的Unsafe的native方法;

Object.wait()和LockSupport.park()的区别

二者都会阻塞当前线程的运行:

- Object.wait()方法需要在synchronized块中执行;

- LockSupport.park()可以在任意地方执行;

- Object.wait()方法声明抛出了中断异常,调用者需要捕获或者再抛出;

- LockSupport.park()不需要捕获中断异常;

- Object.wait()不带超时的,需要另一个线程执行notify()来唤醒,但不一定继续执行后续内容;

- LockSupport.park()不带超时的,需要另一个线程执行unpark()来唤醒,一定会继续执行后续内容;

- 如果在wait()之前执行了notify()会怎样? 抛出IllegalMonitorStateException异常;

- 如果在park()之前执行了unpark()会怎样? 线程不会被阻塞,直接跳过park(),继续执行后续内容;

park()/unpark()底层的原理是“二元信号量”,你可以把它相像成只有一个许可证的Semaphore,只不过这个信号量在重复执行unpark()的时候也不会再增加许可证,最多只有一个许可证。

LockSupport.park()会释放锁资源吗?

不会,它只负责阻塞当前线程,释放锁资源实际上是在Condition的await()方法中实现的。

11 - CH11-AQS-1

AbstractQueuedSynchronizer

AQS 是一个用来构建锁和同步器的框架,使用 AQS 能够简单高效的构造出应用广泛的同步器,比如 ReentrantLock、Semaphore,其他诸如 ReentrantReadWriteLock、SynchronousQueue、FutureTask 等也是基于 AQS 实现的。我们自己也可以基于 AQS 构造满足自己需要的同步器。

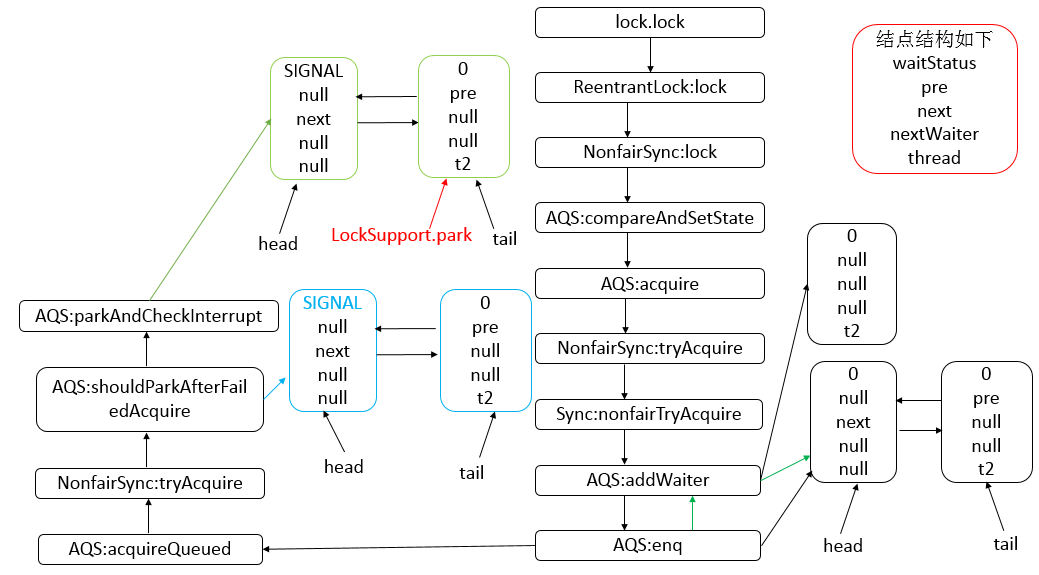

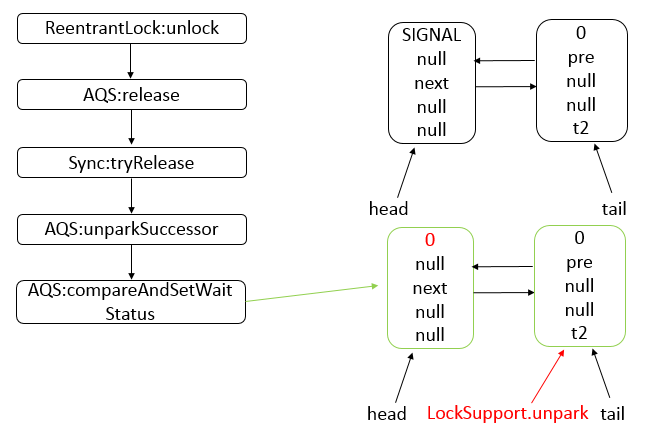

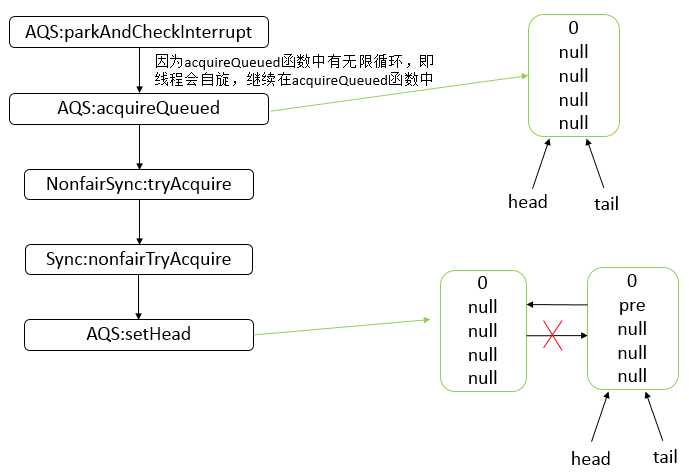

核心思想

- 如果被请求的共享资源空闲,则将当前请求资源的线程设置为有效的工作线程,并且将共享资源设置为锁定状态。

- 如果被请求的共享资源被占用,那么就需要一套线程阻塞等待以及被唤醒时锁分配的机制。

- AQS 使用 CLH 队列锁实现了该机制,将暂时获取不到锁的线程加入到队列中。

- AQS 使用一个 int 成员变量表示同步状态,通过内置的 FIFO 队列来完成获取资源线程的排队工作。

- AQS 使用 CAS 对该同步状态执行原子操作以实现值的修改,并使用 volatile 保证该状态的可见性。

CLH(Craig,Landin,and Hagersten) 队列是一个虚拟的双向队列(即不存在队列实例、仅存在结点之间的关联关系)。AQS是将每条请求共享资源的线程封装成一个 CLH 锁队列的一个结点(Node)来实现锁的分配。

状态信息通过 protected 范围的方法执行操作:

private volatile int state;

//返回同步状态的当前值

protected final int getState() {

return state;

}

// 设置同步状态的值

protected final void setState(int newState) {

state = newState;

}

//原子地(CAS操作)将同步状态值设置为给定值update如果当前同步状态的值等于expect(期望值)

protected final boolean compareAndSetState(int expect, int update) {

return unsafe.compareAndSwapInt(this, stateOffset, expect, update);

}

资源共享方式

- 独占(Exclusive):只有一个线程能够执行,如 ReentrantLock。又可以分为公平锁和非公平锁:

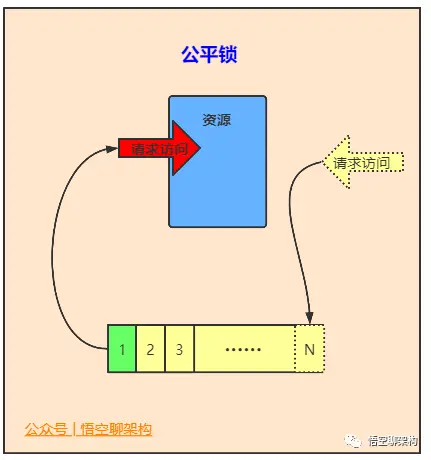

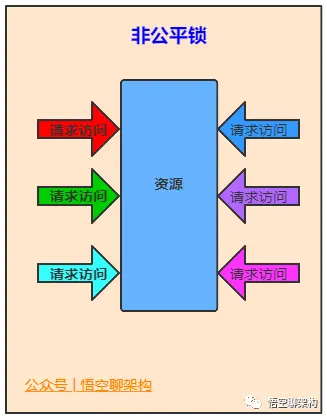

- 公平锁:按照线程在队列中的排队顺序,先到者先获得锁。

- 非公平锁:当线程要获得锁时,无视队列顺序直接抢锁,谁抢到随获取。

- 共享(Share):多个线程可以同时执行,如 Semaphore、CountDownLatch。

而 ReentrantReadWriteLock 可以看做是对以上两种方式的组合,因为它允许多个线程同时对一个资源执行读,但仅能有一个线程执行写。

不同的自定义同步器争用共享资源的方式不同。自定义同步器在实现时只需要实现共享资源 state 的获取与释放方式即可,至于具体线程等待队列的维护(如获取资源失败后入队/唤醒出队等),AQS 已经在上层实现了。

AQS 底层使用的模板方法模式

同步器的设计基于模板方法模式,自定义同步器时继承 AQS 并重写指定的方法即可:

- isHeldExclusively:判断线程是否正在独占资源,只有用到 condition 才需要实现。

- tryAcquire(int):独占获取资源,成功失败返回 ture、false。

- tryRelease(int):独占释放资源,成功失败返回 true、false。

- tryAcquireShared(int):共享获取资源,失败为负,为 0 表示成功但没有剩余可用资源,为正表示成且有可用资源。

- tryReleaseShared(int):共享释放资源,成功失败返回 true、false。

相关细节:

- 默认情况下,每个方法都能抛出 UnsupportedException。

- 所有方法的实现必须是内部线程安全的,并且应该简短且不阻塞。

- 其他方法均为 final,所以仅有以上方法可以被其他类使用。

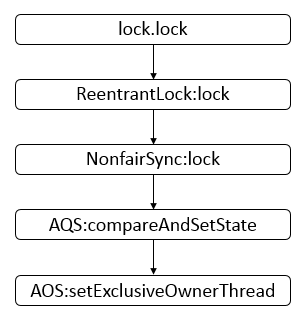

以 ReentrantLock 为例:

- 初始状态 state 为 0,表示未锁定状态。

- A 线程 lock 时,会调用 tryAcquire 独占锁定并将 state+1。

- 此后其他线程再 tryAcquire 时会失败,直到 A 线程 unlock 并将 state=0(释放锁)为止。

- 在 A 线程释放锁之前,A 线程可以重复获取此锁(state 累加),即可重入。

- 获取多次就要释放多次,直至 state 为 0 才表示释放锁。

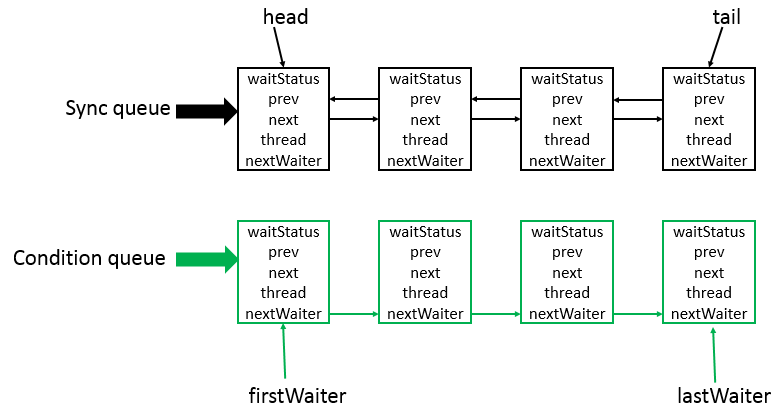

数据结构

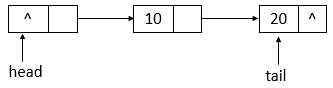

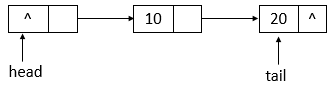

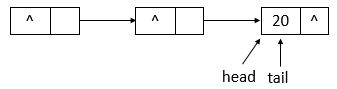

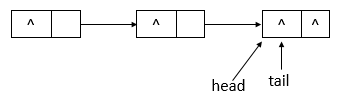

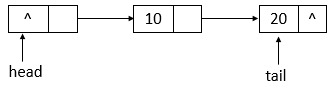

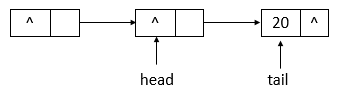

- AQS 底层使用 CLH,将每条请求共享资源的线程封装为 CLH 队列的一个节点。

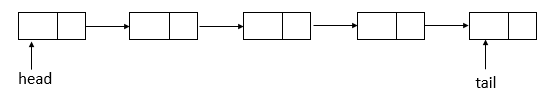

- 其中同步队列 Sync Queue 为双向链表,包括 head 和 tail 节点,head 节点主要用作后续的调度。

- 其中 Condition Queue 不是必须,是一个单向链表,只有使用 Condition 时,才会使用该队列。

- 并且可能会有多个 Condition Queue。

源码分析

层级结构

AQS 继承抽象类 AbstractOwnableSynchronizer,实现了 Serializable 接口,支持序列化。

public abstract class AbstractOwnableSynchronizer implements java.io.Serializable {

// 版本序列号

private static final long serialVersionUID = 3737899427754241961L;

// 构造方法

protected AbstractOwnableSynchronizer() { }

// 独占模式下的线程

private transient Thread exclusiveOwnerThread;

// 设置独占线程

protected final void setExclusiveOwnerThread(Thread thread) {

exclusiveOwnerThread = thread;

}

// 获取独占线程

protected final Thread getExclusiveOwnerThread() {

return exclusiveOwnerThread;

}

}

- 其中可以“设置独占资源线程”和“获取独占资源线程”,分别为 setExclusiveOwnerThread 与 getExclusiveOwnerThread 方法,这两个方法会被子类调用。

- 其中有两个内部类,Node、ConditionObject。

内部类:Node

static final class Node {

// 模式,分为共享与独占

// 共享模式

static final Node SHARED = new Node();

// 独占模式

static final Node EXCLUSIVE = null;

// 结点状态

// CANCELLED,值为1,表示当前的线程被取消

// SIGNAL,值为-1,表示当前节点的后继节点包含的线程需要运行,也就是unpark

// CONDITION,值为-2,表示当前节点在等待condition,也就是在condition队列中

// PROPAGATE,值为-3,表示当前场景下后续的acquireShared能够得以执行

// 值为0,表示当前节点在sync队列中,等待着获取锁

static final int CANCELLED = 1;

static final int SIGNAL = -1;

static final int CONDITION = -2;

static final int PROPAGATE = -3;

// 结点状态

volatile int waitStatus;

// 前驱结点

volatile Node prev;

// 后继结点

volatile Node next;

// 结点所对应的线程

volatile Thread thread;

// 下一个等待者

Node nextWaiter;

// 结点是否在共享模式下等待

final boolean isShared() {

return nextWaiter == SHARED;

}

// 获取前驱结点,若前驱结点为空,抛出异常

final Node predecessor() throws NullPointerException {

// 保存前驱结点

Node p = prev;

if (p == null) // 前驱结点为空,抛出异常

throw new NullPointerException();

else // 前驱结点不为空,返回

return p;

}

// 无参构造方法

Node() { // Used to establish initial head or SHARED marker

}

// 构造方法

Node(Thread thread, Node mode) { // Used by addWaiter

this.nextWaiter = mode;

this.thread = thread;

}

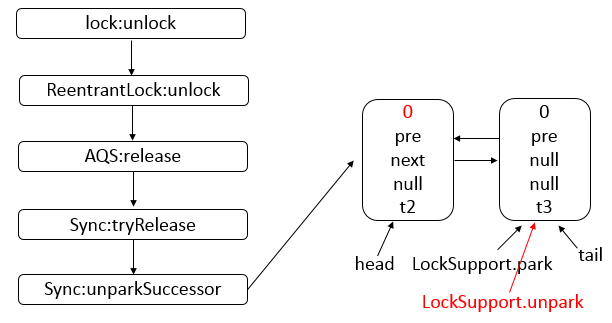

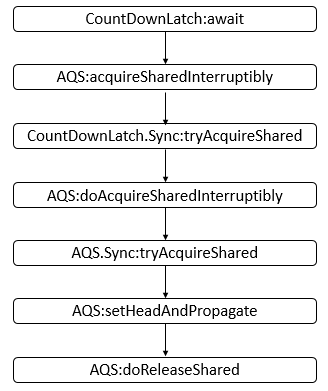

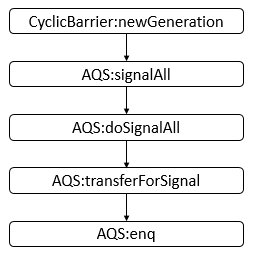

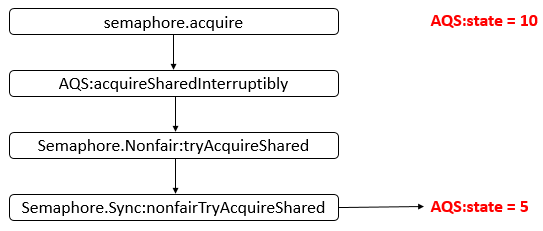

// 构造方法