This the multi-page printable view of this section. Click here to print.

Java 集合

1 - CH01-集合结构

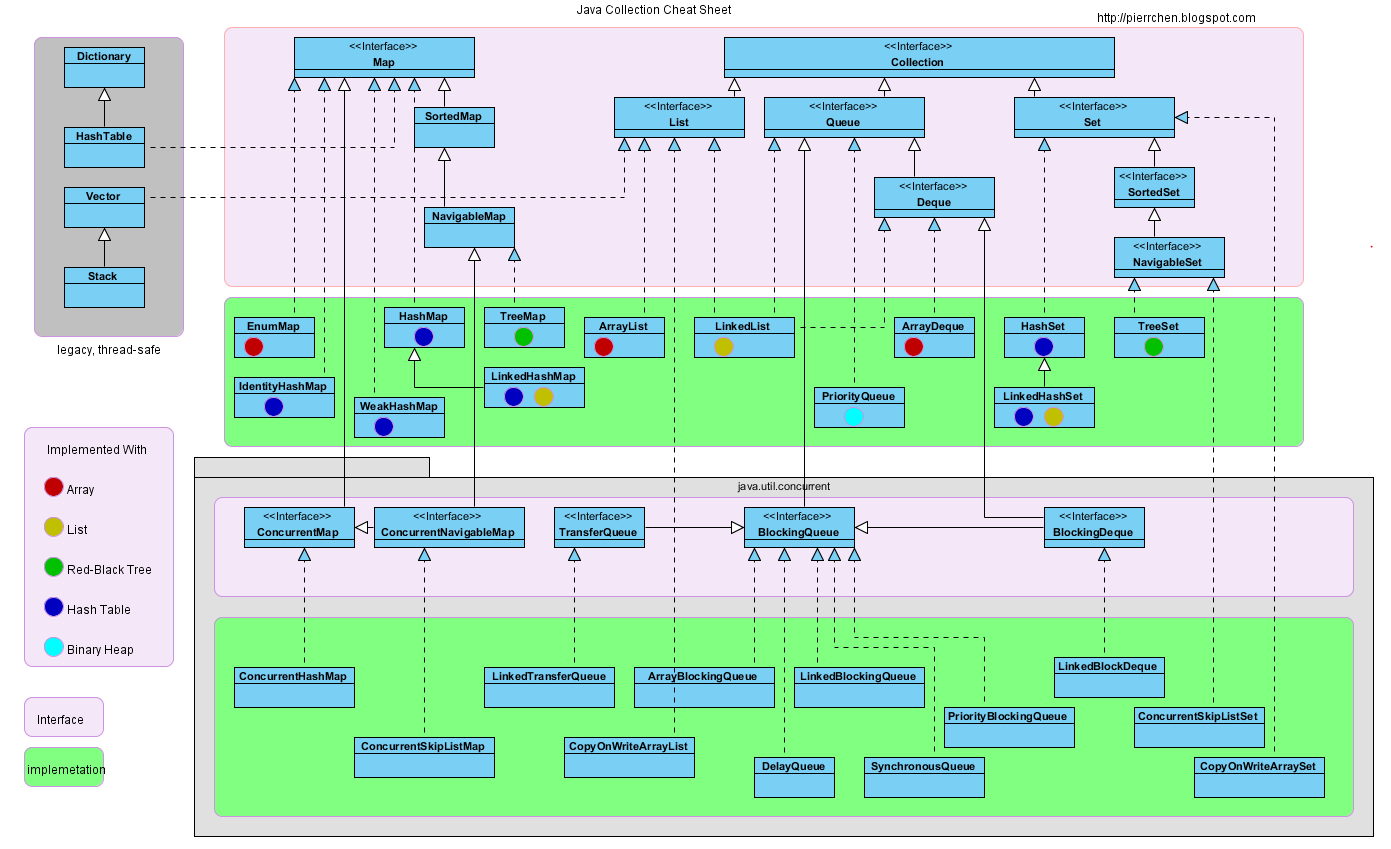

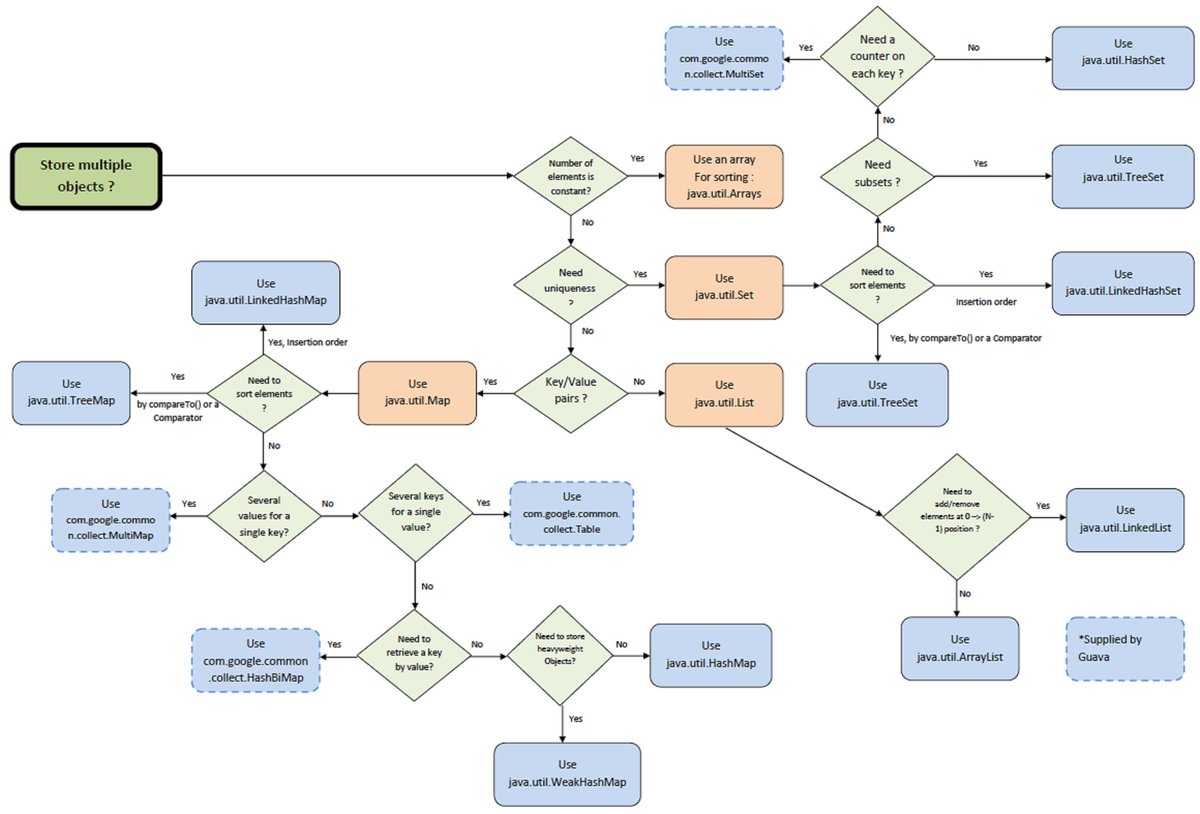

层级结构

选择参考

2 - CH02-ArrayList

概述

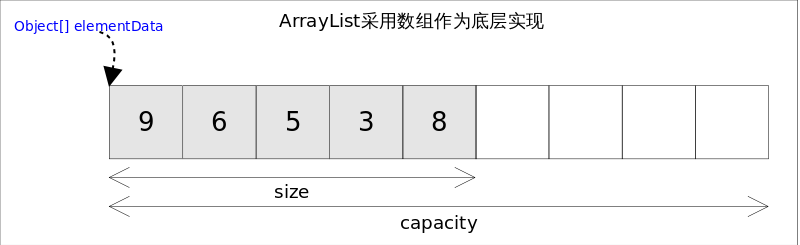

- ArrayList 实现了 List 接口,是顺序型容器,允许 NULL 元素,底层结构为数组。

- 除了没有实现线程安全,其余实现与 Vector 类似。

- 拥有容量(capacity)属性,表示底层数组大小,实际元素个数不能大于容量。

- 容量不足以承载更多元素时,会执行扩容。

- size、isEmpty、get、set 均可在常数时间内完成。

- add 的时间开销与插入位置有关。

- addAll 的时间开销与所要添加元素的个数成正比。

- 其余方法大多为线性时间。

内部实现

数据结构

transient Object[] elementData;

private int size;

构造函数

public ArrayList(int initialCapacity) {

if (initialCapacity > 0) {

this.elementData = new Object[initialCapacity];

} else if (initialCapacity == 0) {

this.elementData = EMPTY_ELEMENTDATA;

} else {

throw new IllegalArgumentException("Illegal Capacity: "+

initialCapacity);

}

}

public ArrayList() {

this.elementData = DEFAULTCAPACITY_EMPTY_ELEMENTDATA; // 10

}

public ArrayList(Collection<? extends E> c) {

elementData = c.toArray();

if ((size = elementData.length) != 0) {

// c.toArray might (incorrectly) not return Object[] (see 6260652)

if (elementData.getClass() != Object[].class)

elementData = Arrays.copyOf(elementData, size, Object[].class);

} else {

// replace with empty array.

this.elementData = EMPTY_ELEMENTDATA;

}

}

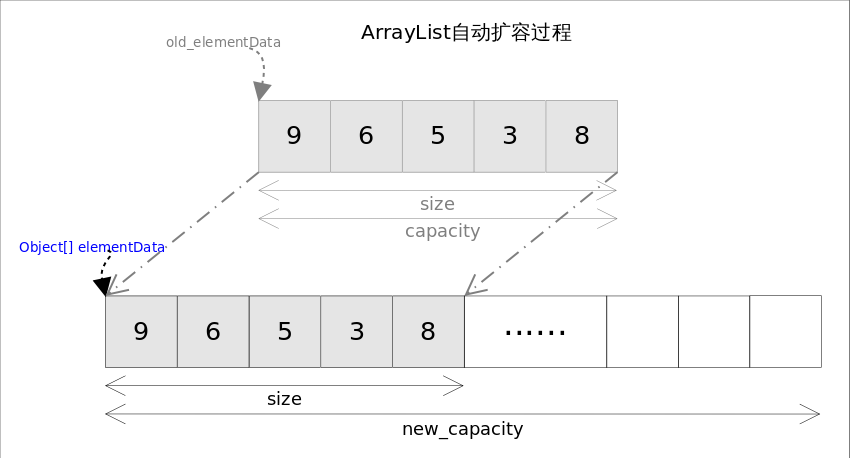

自动扩容

每当向数组中添加元素时,都要去检查添加后元素的个数是否会超出当前数组的长度,如果超出,数组将会进行扩容,以满足添加数据的需求。数组扩容通过一个公开的方法ensureCapacity(int minCapacity)来实现。在实际添加大量元素前,我也可以使用ensureCapacity来手动增加ArrayList实例的容量,以减少递增式再分配的数量。

数组进行扩容时,会将老数组中的元素重新拷贝一份到新的数组中,每次数组容量的增长大约是其原容量的 1.5 倍。这种操作的代价是很高的,因此在实际使用时,我们应该尽量避免数组容量的扩张。当我们可预知要保存的元素的多少时,要在构造ArrayList实例时,就指定其容量,以避免数组扩容的发生。或者根据实际需求,通过调用ensureCapacity方法来手动增加ArrayList实例的容量。

/**

* Increases the capacity of this <tt>ArrayList</tt> instance, if

* necessary, to ensure that it can hold at least the number of elements

* specified by the minimum capacity argument.

*

* @param minCapacity the desired minimum capacity

*/

public void ensureCapacity(int minCapacity) {

int minExpand = (elementData != DEFAULTCAPACITY_EMPTY_ELEMENTDATA)

// any size if not default element table

? 0

// larger than default for default empty table. It's already

// supposed to be at default size.

: DEFAULT_CAPACITY;

if (minCapacity > minExpand) {

ensureExplicitCapacity(minCapacity);

}

}

private void ensureCapacityInternal(int minCapacity) {

if (elementData == DEFAULTCAPACITY_EMPTY_ELEMENTDATA) {

minCapacity = Math.max(DEFAULT_CAPACITY, minCapacity);

}

ensureExplicitCapacity(minCapacity);

}

private void ensureExplicitCapacity(int minCapacity) {

modCount++;

// overflow-conscious code

if (minCapacity - elementData.length > 0)

grow(minCapacity);

}

/**

* The maximum size of array to allocate.

* Some VMs reserve some header words in an array.

* Attempts to allocate larger arrays may result in

* OutOfMemoryError: Requested array size exceeds VM limit

*/

private static final int MAX_ARRAY_SIZE = Integer.MAX_VALUE - 8;

/**

* Increases the capacity to ensure that it can hold at least the

* number of elements specified by the minimum capacity argument.

*

* @param minCapacity the desired minimum capacity

*/

private void grow(int minCapacity) {

// overflow-conscious code

int oldCapacity = elementData.length;

int newCapacity = oldCapacity + (oldCapacity >> 1);

if (newCapacity - minCapacity < 0)

newCapacity = minCapacity;

if (newCapacity - MAX_ARRAY_SIZE > 0)

newCapacity = hugeCapacity(minCapacity);

// minCapacity is usually close to size, so this is a win:

elementData = Arrays.copyOf(elementData, newCapacity);

}

private static int hugeCapacity(int minCapacity) {

if (minCapacity < 0) // overflow

throw new OutOfMemoryError();

return (minCapacity > MAX_ARRAY_SIZE) ?

Integer.MAX_VALUE :

MAX_ARRAY_SIZE;

}

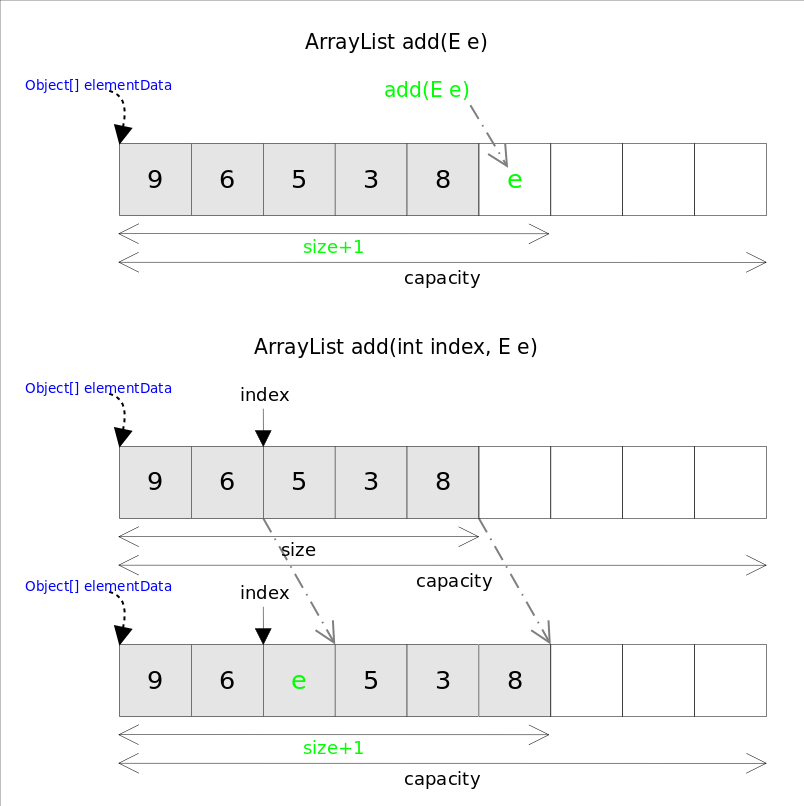

add/addAll

添加单个元素的方法 add(E e) 和 add(int index, E e),在执行之前都需要检查剩余容量,如果需要则自动扩容,即执行 grow 方法。

public boolean add(E e) {

ensureCapacityInternal(size + 1); // Increments modCount!!

elementData[size++] = e;

return true;

}

public void add(int index, E element) {

rangeCheckForAdd(index);

ensureCapacityInternal(size + 1); // Increments modCount!!

System.arraycopy(elementData, index, elementData, index + 1,

size - index);

elementData[index] = element;

size++;

}

add(int index, E e) 首先需要移动元素,然后完成插入操作,因此具有线性时间的复杂度。

addAll() 能够一次添加多个元素,根据添加的位置拥有两种版本的实现:

- 向末尾添加:

addAll(Collection<? extends E> c) - 向指定位置添加:

addAll(int index, Collection<? extends E> c)

在插入之前也需要扩容检查,如果需要就执行扩容。如果插入指定位置,也需要移动元素。因此同时与插入元素的数据和插入的位置相关。

set

首先执行越界检查,然后对数组指定位置的元素赋值。

get

首先执行越界检查,然后数组指定位置的元素值,最后转换类型。

remove

remove(int index)删除指定位置的元素remove(Object o)删除第一满足 equals 条件的元素

remove 是 add 的逆操作,需要将删除位置之后的元素向前移动。

为了让 GC 起作用,必须显式的为最后一个位置赋值为 null,即解除引用。如果不设为 null,那么该位置将会继续引用原有的对象,除非被一个新的对象覆盖。

trimToSize

该方法可以将数组的容量调整为当前实际元素的个数。

/**

* Trims the capacity of this <tt>ArrayList</tt> instance to be the

* list's current size. An application can use this operation to minimize

* the storage of an <tt>ArrayList</tt> instance.

*/

public void trimToSize() {

modCount++;

if (size < elementData.length) {

elementData = (size == 0)

? EMPTY_ELEMENTDATA

: Arrays.copyOf(elementData, size);

}

}

indexOf, lastIndexOf

分别获取第一次和最后一次出现的元素位置:

public int indexOf(Object o) {

if (o == null) {

for (int i = 0; i < size; i++)

if (elementData[i]==null)

return i;

} else {

for (int i = 0; i < size; i++)

if (o.equals(elementData[i]))

return i;

}

return -1;

}

public int lastIndexOf(Object o) {

if (o == null) {

for (int i = size-1; i >= 0; i--)

if (elementData[i]==null)

return i;

} else {

for (int i = size-1; i >= 0; i--)

if (o.equals(elementData[i]))

return i;

}

return -1;

}

fail-fast 机制

通过记录 modCount 的值,在面对并发修改时,迭代器很快就会完全失败,避免在将来某个不确定时间发生任意不确定行为。

3 - CH03-LinkedList

概述

- LinkedList 同时实现了 List 接口和 Deque 接口,也就是说它既可以看作一个顺序容器,又可以看作一个队列(Queue),同时又可以看作一个栈(Stack)。

- 栈或队列,现在的首选是 ArrayDeque,它有着比 LinkedList (当作栈或队列使用时)有着更好的性能。

- 所有跟下标相关的操作都是线性时间。

- 在首段或者末尾删除元素只需要常数时间。

- 为追求效率 LinkedList 没有实现同步(synchronized)。

内部实现

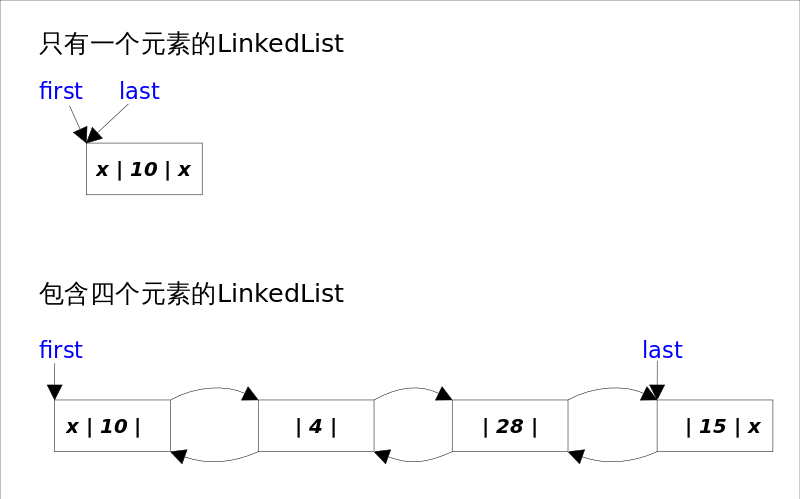

数据结构

- 底层通过双向链表实现。

- 双向链表的每个节点用内部类 Node 表示。

- LinkedList 通过

first和last引用分别指向链表的第一个和最后一个元素。 - 当链表为空的时候

first和last都指向null。

transient int size = 0;

/**

* Pointer to first node.

* Invariant: (first == null && last == null) ||

* (first.prev == null && first.item != null)

*/

transient Node<E> first;

/**

* Pointer to last node.

* Invariant: (first == null && last == null) ||

* (last.next == null && last.item != null)

*/

transient Node<E> last;

private static class Node<E> {

E item;

Node<E> next;

Node<E> prev;

Node(Node<E> prev, E element, Node<E> next) {

this.item = element;

this.next = next;

this.prev = prev;

}

}

构造函数

/**

* Constructs an empty list.

*/

public LinkedList() {

}

/**

* Constructs a list containing the elements of the specified

* collection, in the order they are returned by the collection's

* iterator.

*

* @param c the collection whose elements are to be placed into this list

* @throws NullPointerException if the specified collection is null

*/

public LinkedList(Collection<? extends E> c) {

this();

addAll(c);

}

getFirst, getLast

/**

* Returns the first element in this list.

*

* @return the first element in this list

* @throws NoSuchElementException if this list is empty

*/

public E getFirst() {

final Node<E> f = first;

if (f == null)

throw new NoSuchElementException();

return f.item;

}

/**

* Returns the last element in this list.

*

* @return the last element in this list

* @throws NoSuchElementException if this list is empty

*/

public E getLast() {

final Node<E> l = last;

if (l == null)

throw new NoSuchElementException();

return l.item;

}

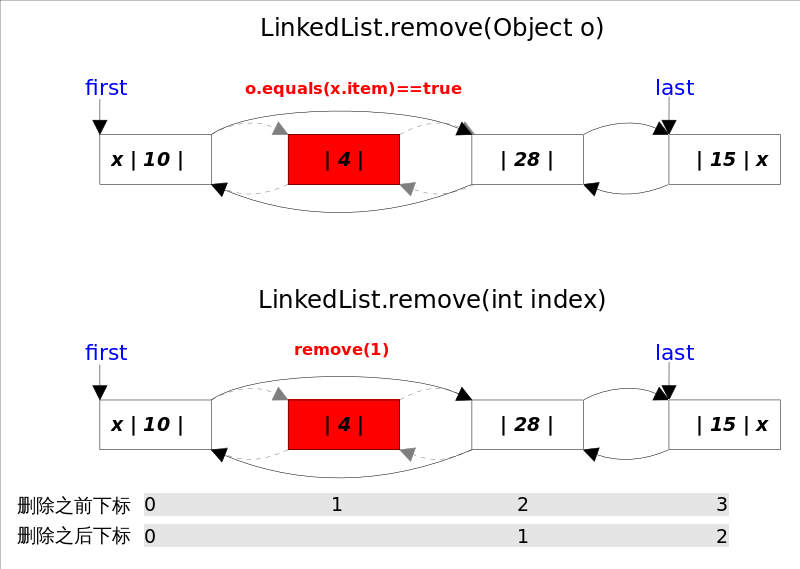

removeFirest(), removeLast(), remove(e), remove(index)

remove 可以删除首个 equals 指定对象的元素,或者删除指定位置的元素。

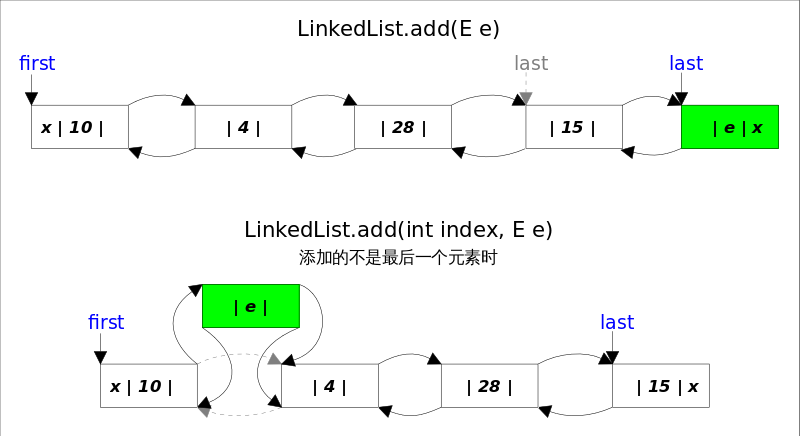

add

add(E e) 将在末尾添加元素,因为 last 指向链表的末尾元素,因此操作为常数时间,仅需修改几个相关的引用即可。

add(int index, E element) 是在指定位置插入元素,首选需要线性查找到具体位置,然后修改相关引用,完成操作。

addAll

addAll(index, c) 实现方式并不是直接调用add(index,e)来实现,主要是因为效率的问题,另一个是fail-fast中modCount只会增加1次;

/**

* Appends all of the elements in the specified collection to the end of

* this list, in the order that they are returned by the specified

* collection's iterator. The behavior of this operation is undefined if

* the specified collection is modified while the operation is in

* progress. (Note that this will occur if the specified collection is

* this list, and it's nonempty.)

*

* @param c collection containing elements to be added to this list

* @return {@code true} if this list changed as a result of the call

* @throws NullPointerException if the specified collection is null

*/

public boolean addAll(Collection<? extends E> c) {

return addAll(size, c);

}

/**

* Inserts all of the elements in the specified collection into this

* list, starting at the specified position. Shifts the element

* currently at that position (if any) and any subsequent elements to

* the right (increases their indices). The new elements will appear

* in the list in the order that they are returned by the

* specified collection's iterator.

*

* @param index index at which to insert the first element

* from the specified collection

* @param c collection containing elements to be added to this list

* @return {@code true} if this list changed as a result of the call

* @throws IndexOutOfBoundsException {@inheritDoc}

* @throws NullPointerException if the specified collection is null

*/

public boolean addAll(int index, Collection<? extends E> c) {

checkPositionIndex(index);

Object[] a = c.toArray();

int numNew = a.length;

if (numNew == 0)

return false;

Node<E> pred, succ;

if (index == size) {

succ = null;

pred = last;

} else {

succ = node(index);

pred = succ.prev;

}

for (Object o : a) {

@SuppressWarnings("unchecked") E e = (E) o;

Node<E> newNode = new Node<>(pred, e, null);

if (pred == null)

first = newNode;

else

pred.next = newNode;

pred = newNode;

}

if (succ == null) {

last = pred;

} else {

pred.next = succ;

succ.prev = pred;

}

size += numNew;

modCount++;

return true;

}

clear

为了让GC更快可以回收放置的元素,需要将node之间的引用关系赋值为 null。

/**

* Removes all of the elements from this list.

* The list will be empty after this call returns.

*/

public void clear() {

// Clearing all of the links between nodes is "unnecessary", but:

// - helps a generational GC if the discarded nodes inhabit

// more than one generation

// - is sure to free memory even if there is a reachable Iterator

for (Node<E> x = first; x != null; ) {

Node<E> next = x.next;

x.item = null;

x.next = null;

x.prev = null;

x = next;

}

first = last = null;

size = 0;

modCount++;

}

Positional Access 方法

通过 index 获取元素:

public E get(int index) {

checkElementIndex(index);

return node(index).item;

}

通过 index 赋值元素:

public E set(int index, E element) {

checkElementIndex(index);

Node<E> x = node(index);

E oldVal = x.item;

x.item = element;

return oldVal;

}

通过 index 插入元素:

public void add(int index, E element) {

checkPositionIndex(index);

if (index == size)

linkLast(element);

else

linkBefore(element, node(index));

}

通过 index 删除元素:

public E remove(int index) {

checkElementIndex(index);

return unlink(node(index));

}

查找

即查找元素的下标,查找第一次出现元素值相等的 index,否则返回 -1:

public int indexOf(Object o) {

int index = 0;

if (o == null) {

for (Node<E> x = first; x != null; x = x.next) {

if (x.item == null)

return index;

index++;

}

} else {

for (Node<E> x = first; x != null; x = x.next) {

if (o.equals(x.item))

return index;

index++;

}

}

return -1;

}

查找最后一次出现的元素则类似,区别是从 last 开始向前查找。

Queue 方法

- peek

- element

- poll

- remove

- offer

Deque 方法

- offerFirst

- offerLast

- peekFirst

- peekLast

- pollFirst

- pollLast

- push

- pop

4 - CH04-Stack-Queue

概述

- Java 中存在 Stack 实现类,但没有提供 Queue 实现类,仅有一个 Queue 接口。

- 但是在需要使用栈时,Java 推荐的结果是更加高效的 ArrayQueue。

- 在需要使用队列时,首选是 ArrayQueue,其次是 LinkedList。

Queue

Queue 接口继承自 Collection 接口,除了最基本的 Collection 方法之外,还额外支持 insertion、extraction、inspection 操作。这里有两组格式共 6 个方法,一组是抛出异常的实现,一组是返回值的实现(或 null)。

| Throws Exception | Returns special Value | |

|---|---|---|

| Insert | add(e) | offer(e) |

| Remove | remove() | poll() |

| Examine | element() | peek() |

Deque

Deque 是 “double ended queue”,表示双向队列,英文读作 deck。Deque 继承自 Queue 接口,除了支持 Queue 的方法外,还支持 insert、remove、examine 操作。

由于 Deque 是双向的,所以可以支持队列的头尾操作,同时支持两种格式共 12 个方法:

| First Element-Head | Last Element-Tail | |||

|---|---|---|---|---|

| Throws Exception | Special Value | Throws Exception | Speicial Value | |

| Insert | addFirst(e) | offerFirst(e) | addLast(e) | offerLast(e) |

| Remove | removeFirst() | pollFirst() | removeLast() | pollLast() |

| Examine | getFirst() | peekFirst() | getLast() | peekLast() |

当把 Deque 当做 FIFO 来使用时,元素是从 deque 的尾部添加,从头部进行删除。所谓 Deque 的部分方法和 Queue 是等同的。

| Queue Method | Equivalent Deque Method | 说明 |

|---|---|---|

| add(e) | addLast(e) | 向队尾添加元素,失败时抛异常 |

| offer(e) | offerLast(e) | 向队尾添加元素,失败时返回 false |

| remove() | removeFirst() | 获取并删除队首元素,失败时抛异常 |

| poll() | pollFirst() | 获取并删除队首元素,失败时返回 null |

| element() | getFirst() | 获取但不删除队首元素,失败时抛异常 |

| peek() | peekFirst() | 获取但不删除队首元素,失败时返回 null |

Deque 与 Stack 的对应方法:

| Stack Method | Equivalent Deque Method | 说明 |

|---|---|---|

| push(e) | addFirst(e) | 向栈顶插入元素,失败则抛出异常 |

| 无 | offerFirst(e) | 向栈顶插入元素,失败则返回false |

| pop() | removeFirst() | 获取并删除栈顶元素,失败则抛出异常 |

| 无 | pollFirst() | 获取并删除栈顶元素,失败则返回null |

| peek() | peekFirst() | 获取但不删除栈顶元素,失败则抛出异常 |

| 无 | peekFirst() | 获取但不删除栈顶元素,失败则返回null |

以上操作中,除非对容量有限制,否则添加操作是不会失败的。

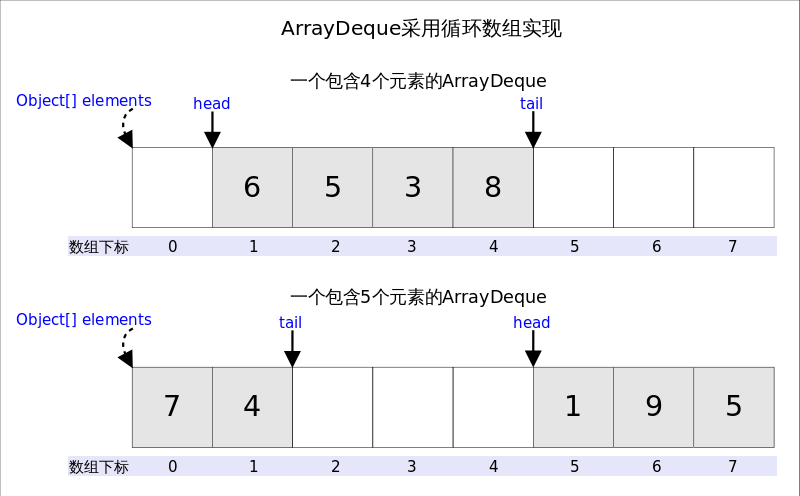

ArrayDeque

ArrayDeque 底层为数组结构,为了满足可以同时在数组两端添加或删除元素,该数组必须是循环数组,即数组的任何一点都可能被看做起点或终点。

ArrayDeque 非线程安全,不能添加 null 元素。

head 指向首端第一个有效元素,tail 指向尾端第一个可以插入元素的空位。

因为是循环数组,所谓 head 的位置不一定是 0,tail 的位置也不一定总是比 head 的位置大。

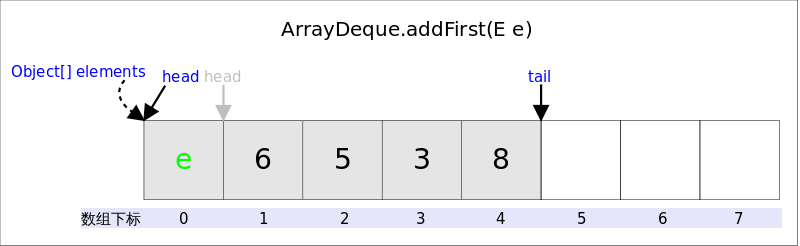

addFirst

在 Deque 首端添加元素,也就是在 head 前面添加元素,在空间足够且下标没有越界的情况下,只需要将 elements[--head]=e 即可。即将 head 的索引递减 1 的位置赋值为新加的元素。

//addFirst(E e)

public void addFirst(E e) {

if (e == null)//不允许放入null

throw new NullPointerException();

elements[head = (head - 1) & (elements.length - 1)] = e;//2.下标是否越界

if (head == tail)//1.空间是否够用

doubleCapacity();//扩容

}

上述代码中可以发现,空间问题是在插入之后开始解决的,因为 tail 总是指向下一个可插入的空位,也就意味着 elements 数组至少会存在一个空位,所以插入元素时不用先考虑空间问题。

下标越界的解决方法很简单,head = (head -1) & (elements.length -1)即可,这段代码相当于取余,同时解决了 head 值为负的情况。因为 elements.length 必须是 2 的指数倍,elements -1 就是二进制低位全为 1,跟 head-1 相与之后就起到了取模的作用,如果 head-1为负(-1),则相当于对其取 elements.length 的补码。

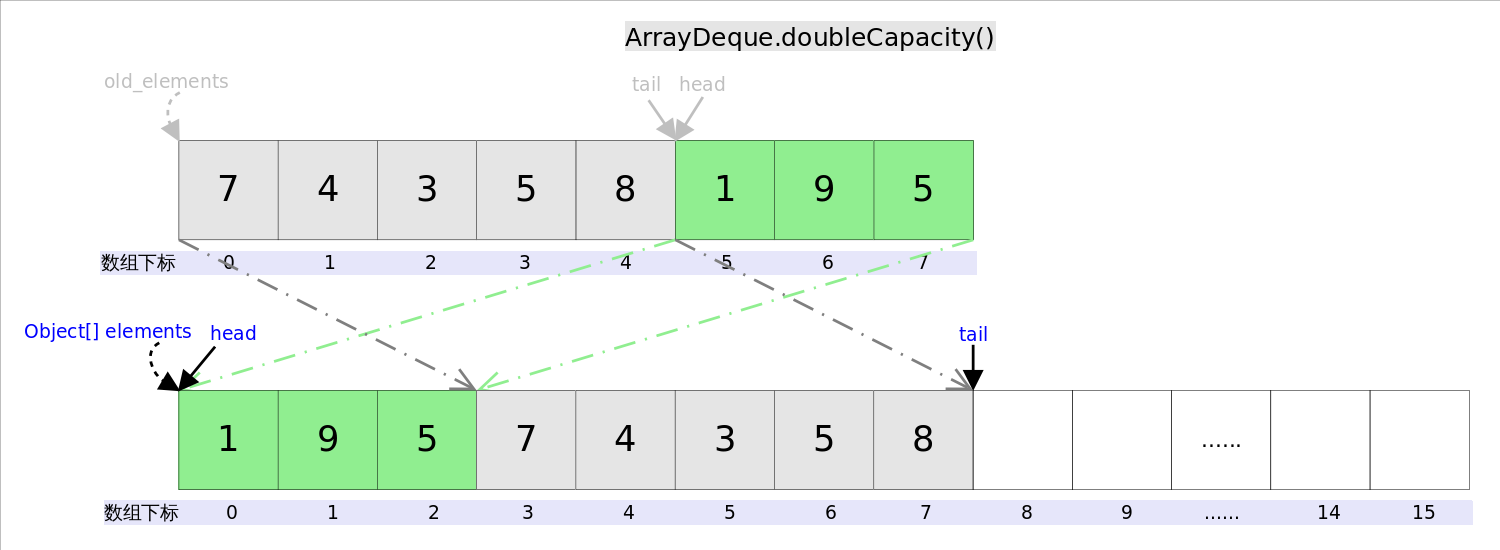

对于扩容函数 doubleCapacity,其逻辑就是申请一个更大的数组(原数据的两倍空间),然后复制原来的元素。

复制分为两次,第一次复制 head 右边的元素,第二次复制 head 左边的数据。

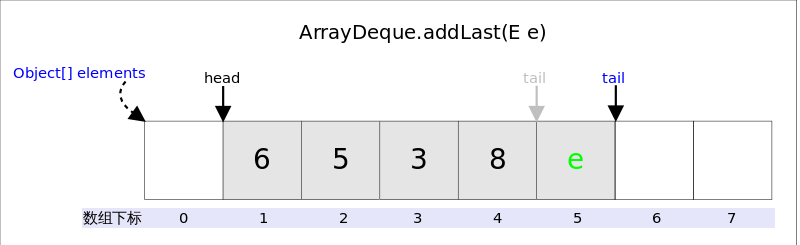

addLast

作用是在 Deque 的尾端插入元素,也就是在tail的位置插入元素,由于tail总是指向下一个可以插入的空位,因此只需要elements[tail] = e;即可。插入完成后再检查空间,如果空间已经用光,则调用doubleCapacity()进行扩容。

poolFirst

作用是删除并返回 Deque 首端元素,也即是head位置处的元素。如果容器不空,只需要直接返回elements[head]即可,当然还需要处理下标的问题。由于ArrayDeque中不允许放入null,当elements[head] == null时,意味着容器为空。

pollLast

作用是删除并返回Deque尾端元素,也即是tail位置前面的那个元素。

peekFirst

作用是返回但不删除Deque首端元素,也即是head位置处的元素,直接返回elements[head]即可。

peekLast

作用是返回但不删除Deque尾端元素,也即是tail位置前面的那个元素。

5 - CH05-PriorityQueue

概览

- 优先队列的作用是能保证每次取出的元素都是队列中权值最小的。

- 元素大小的评判可以通过元素本身的自然顺序(natural ordering),也可以通过构造时传入的比较器。

- Java 中 PriorityQueue 实现了 Queue 接口,不允许放入

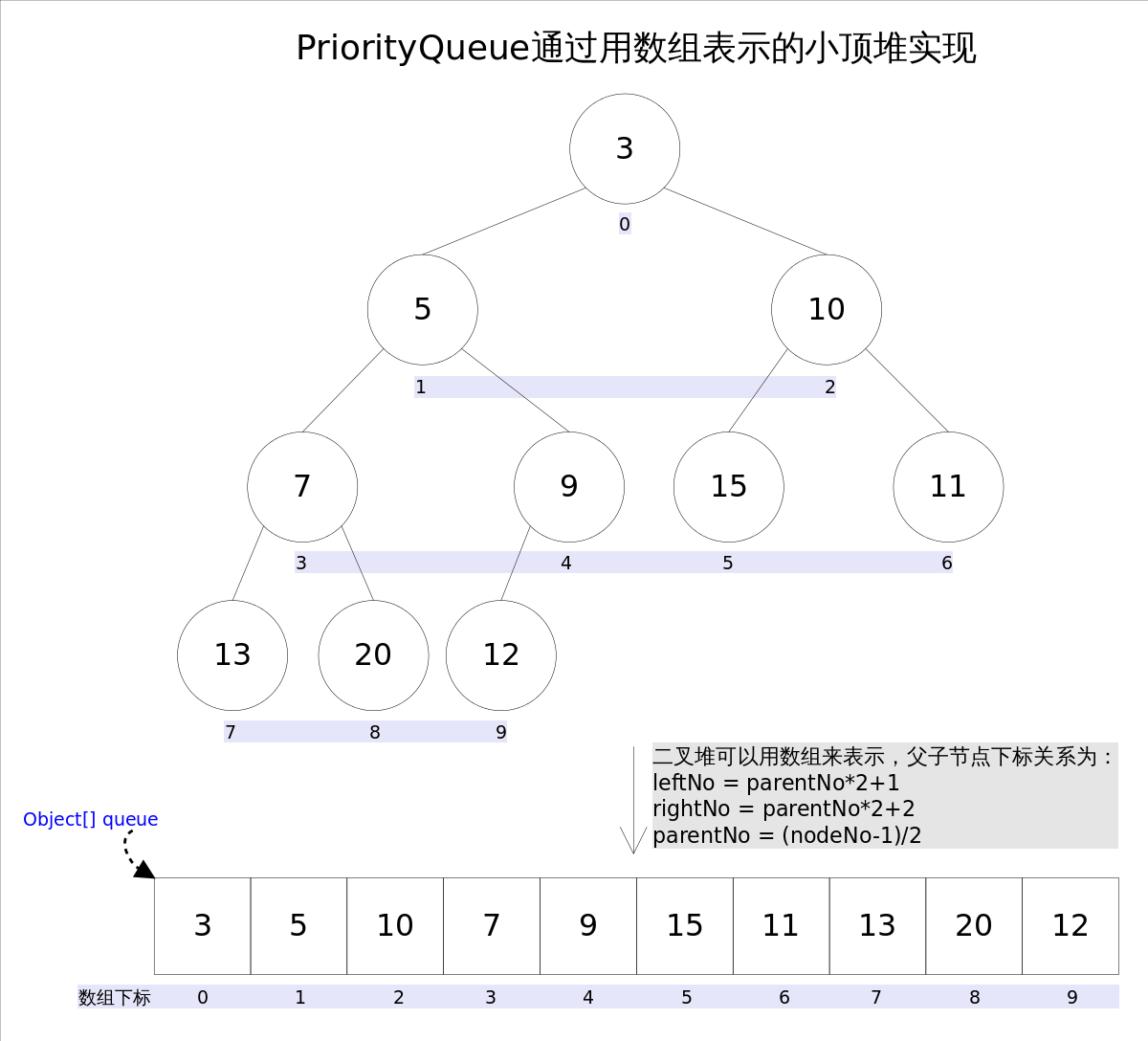

null元素。 - 底层结构为堆,通过完全二叉树实现的小顶堆,表示可以通过数组作为实现结构。

- PriorityQueue 的

peek()和element()操作是常数时间,add(),offer(), 无参数的remove()以及poll()方法的时间复杂度都是log(N)。

观察上图中每个元素的索引编号,会发现父节点与子节点的编号存在联系:

- leftNo = parentNo*2+1

- rightNo = parentNo*2+2

- parentNo = (nodeNo-1)/2

通过这三个公式,可以轻易计算出某个节点的父节点以及子节点的索引编号。即可以通过数组来实现存储堆。

方法实现

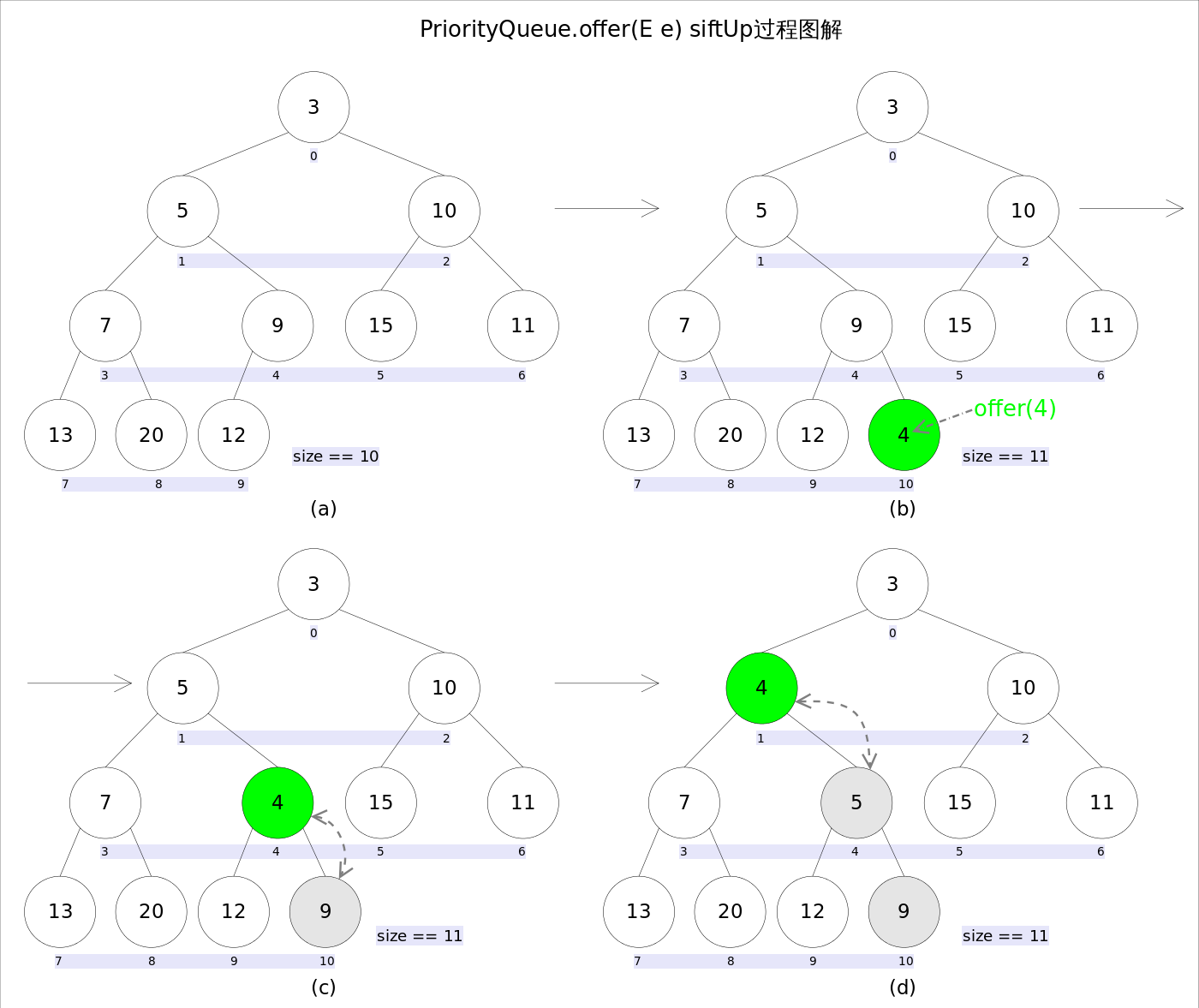

add & offer

两者语义相同,都是相对列中添加元素,只是 Queue 接口规定二者对插入失败是的处理方式不同,前者抛出异常,后者返回 false。

新加入的元素可能会破坏小顶堆的性质,因此需要进行必要的调整。

//offer(E e)

public boolean offer(E e) {

if (e == null)//不允许放入null元素

throw new NullPointerException();

modCount++;

int i = size;

if (i >= queue.length)

grow(i + 1);//自动扩容

size = i + 1;

if (i == 0)//队列原来为空,这是插入的第一个元素

queue[0] = e;

else

siftUp(i, e);//调整

return true;

}

扩容函数 grow 类似于 ArrayList 中的 grow 函数,申请更大空间的数组并复制数据。

siftUp(int k, E x) 方法用于插入元素 x 同时维持堆的特性:

//siftUp()

private void siftUp(int k, E x) {

while (k > 0) {

int parent = (k - 1) >>> 1;//parentNo = (nodeNo-1)/2

Object e = queue[parent];

if (comparator.compare(x, (E) e) >= 0)//调用比较器的比较方法

break;

queue[k] = e;

k = parent;

}

queue[k] = x;

}

调整过程为:从 k 指定的位置开始,将 x 逐层与当前点的 parent 进行比较并交换,直到满足 x >= queue[parent] 为止。

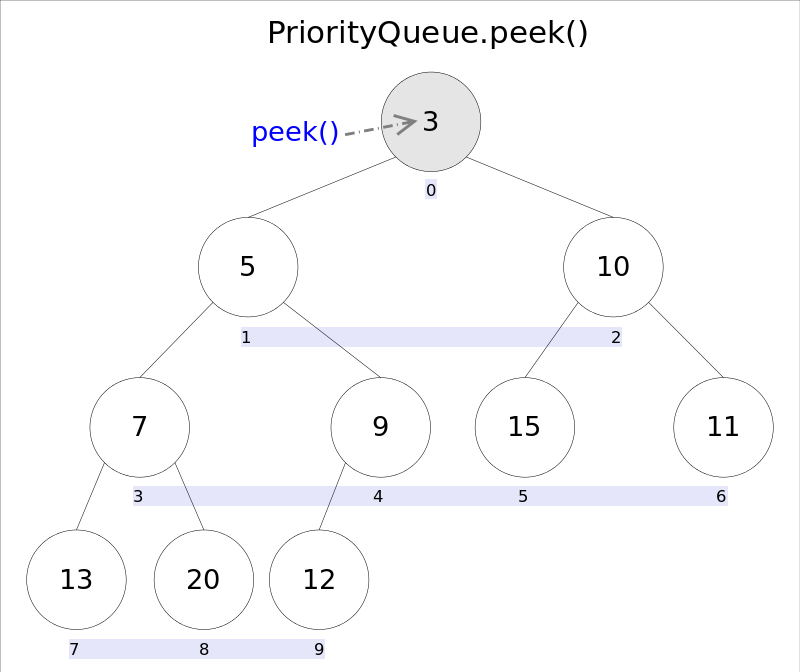

element & peek

语义完全相同,都是获取但不删除队首元素,也就是队列中权值最小的那个元素,二者唯一的区别是当方法失败时前者抛出异常,后者返回null。

根据小顶堆的性质,堆顶那个元素就是全局最小的那个;由于堆用数组表示,根据下标关系,0下标处的那个元素既是堆顶元素。所以直接返回数组0下标处的那个元素即可。

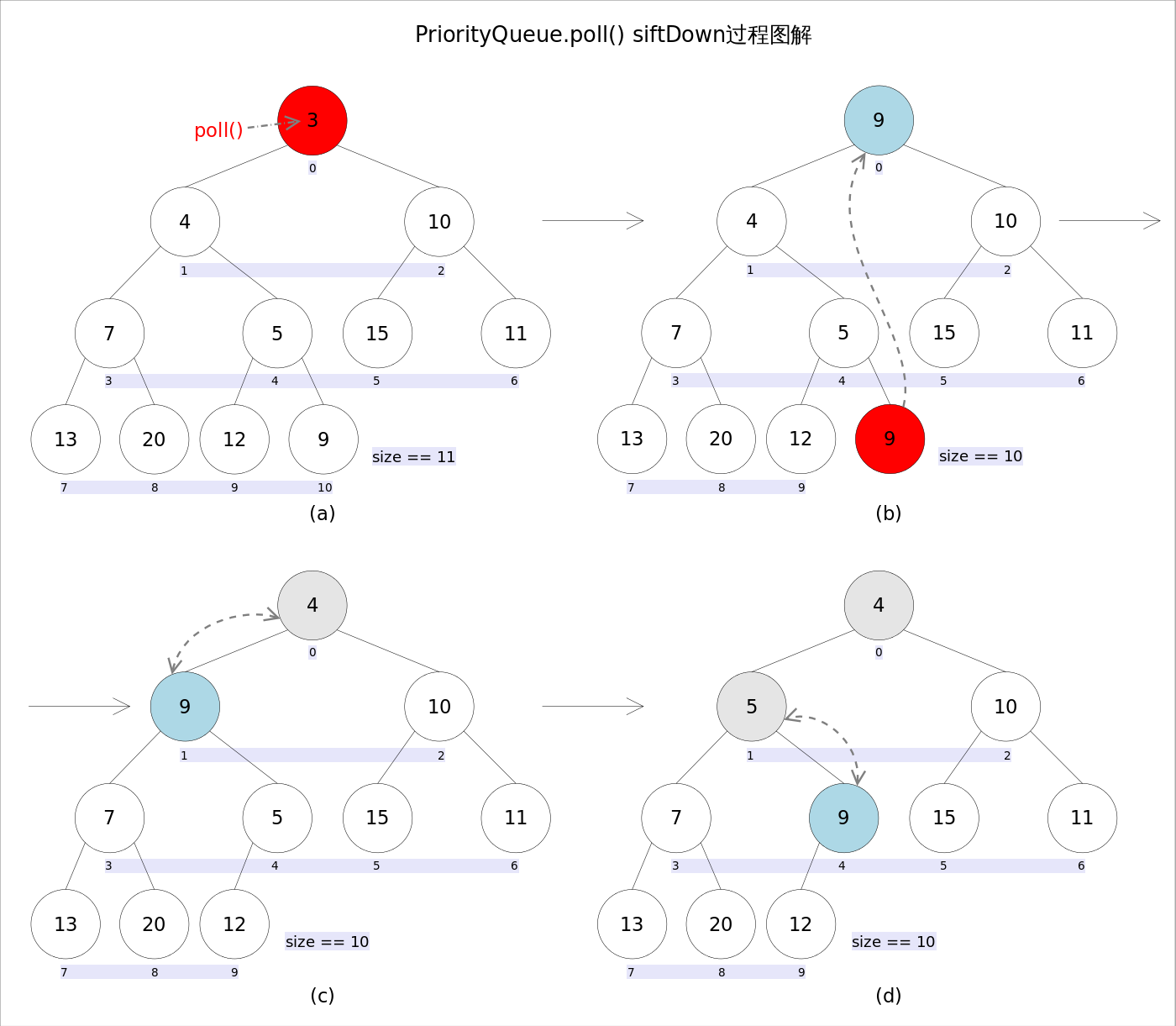

remove & poll

语义也完全相同,都是获取并删除队首元素,区别是当方法失败时前者抛出异常,后者返回null。

由于删除操作会改变队列的结构,为维护小顶堆的性质,需要进行必要的调整。

public E poll() {

if (size == 0)

return null;

int s = --size;

modCount++;

E result = (E) queue[0];//0下标处的那个元素就是最小的那个

E x = (E) queue[s];

queue[s] = null;

if (s != 0)

siftDown(0, x);//调整

return result;

}

上述代码首先记录0下标处的元素,并用最后一个元素替换0下标位置的元素,之后调用siftDown()方法对堆进行调整,最后返回原来0下标处的那个元素(也就是最小的那个元素)。

重点是siftDown(int k, E x)方法,该方法的作用是从k指定的位置开始,将x逐层向下与当前点的左右孩子中较小的那个交换,直到x小于或等于左右孩子中的任何一个为止。

//siftDown()

private void siftDown(int k, E x) {

int half = size >>> 1;

while (k < half) {

//首先找到左右孩子中较小的那个,记录到c里,并用child记录其下标

int child = (k << 1) + 1;//leftNo = parentNo*2+1

Object c = queue[child];

int right = child + 1;

if (right < size &&

comparator.compare((E) c, (E) queue[right]) > 0)

c = queue[child = right];

if (comparator.compare(x, (E) c) <= 0)

break;

queue[k] = c;//然后用c取代原来的值

k = child;

}

queue[k] = x;

}

remove

用于删除队列中跟o相等的某一个元素(如果有多个相等,只删除一个),该方法不是Queue接口内的方法,而是Collection接口的方法。由于删除操作会改变队列结构,所以要进行调整;又由于删除元素的位置可能是任意的,所以调整过程比其它函数稍加繁琐。具体来说,remove(Object o)可以分为2种情况: 1. 删除的是最后一个元素。直接删除即可,不需要调整。2. 删除的不是最后一个元素,从删除点开始以最后一个元素为参照调用一次siftDown()即可。此处不再赘述。

//remove(Object o)

public boolean remove(Object o) {

//通过遍历数组的方式找到第一个满足o.equals(queue[i])元素的下标

int i = indexOf(o);

if (i == -1)

return false;

int s = --size;

if (s == i) //情况1

queue[i] = null;

else {

E moved = (E) queue[s];

queue[s] = null;

siftDown(i, moved);//情况2

......

}

return true;

}

6 - CH06-HashSet-Map

概述

- HashSet 与 HashMap 在 Java 内部的实现类似,前者仅仅是对后者进行了封装。

- HashMap 实现了 Map 接口,允许放入 null key 和 null value。

- 与 HashTable 的区别在于没有实现同步。

- 与 TreeMap 的区别在于不保证元素顺序。

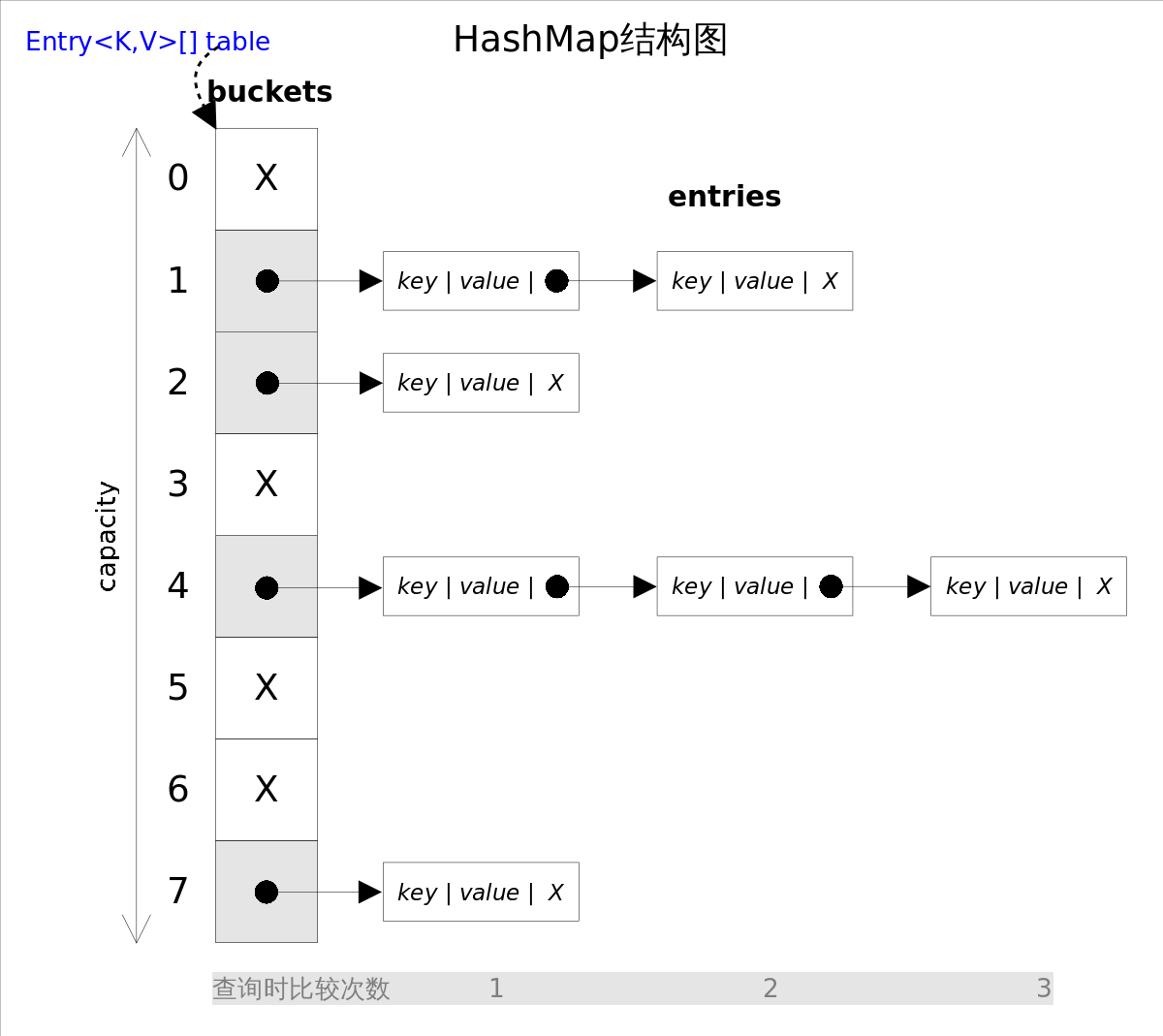

- 采用冲突链表(Sepratate chaining with linked lists)解决哈希冲突。

- 另一种实现是开放地址方式(Open Addressing)。

如果选择合适的哈希函数,put 与 get 方法可以在常数内完成。但是在对 HashMap 执行迭代时,需要遍历整个 table 以及后边跟的冲突链表。因此对于迭代频繁的场景,不宜将 HashMap 的初始大小设置的过大。

有两个参数可以影响 HashMap 的性能:初始容量(inital capacity)和负载系数(load factor)。

初始容量指定了初始 table 的大小,负载系数用来指定自动扩容的临界值。当 entry 的数量超过 capacity * load-factor 时,容器将自动扩容并重新哈希。对于插入元素较多的场景,将初始容量设置较大可以减少重新哈希的次数。

将对象放入到 HashSet 和 HashMap 时,有两个方法要格外留意:hashCode 和 equals。

hashCode 方法决定了对象会被放到哪个 bucket 中,当多个对象的哈希值冲突,equals 方法决定了这些对象是否是同一个对象。因此,如果要将自定义的对象放入到 HashMap 或 HashSet,需要重写 hashCode 和 equals 方法。

HashMap

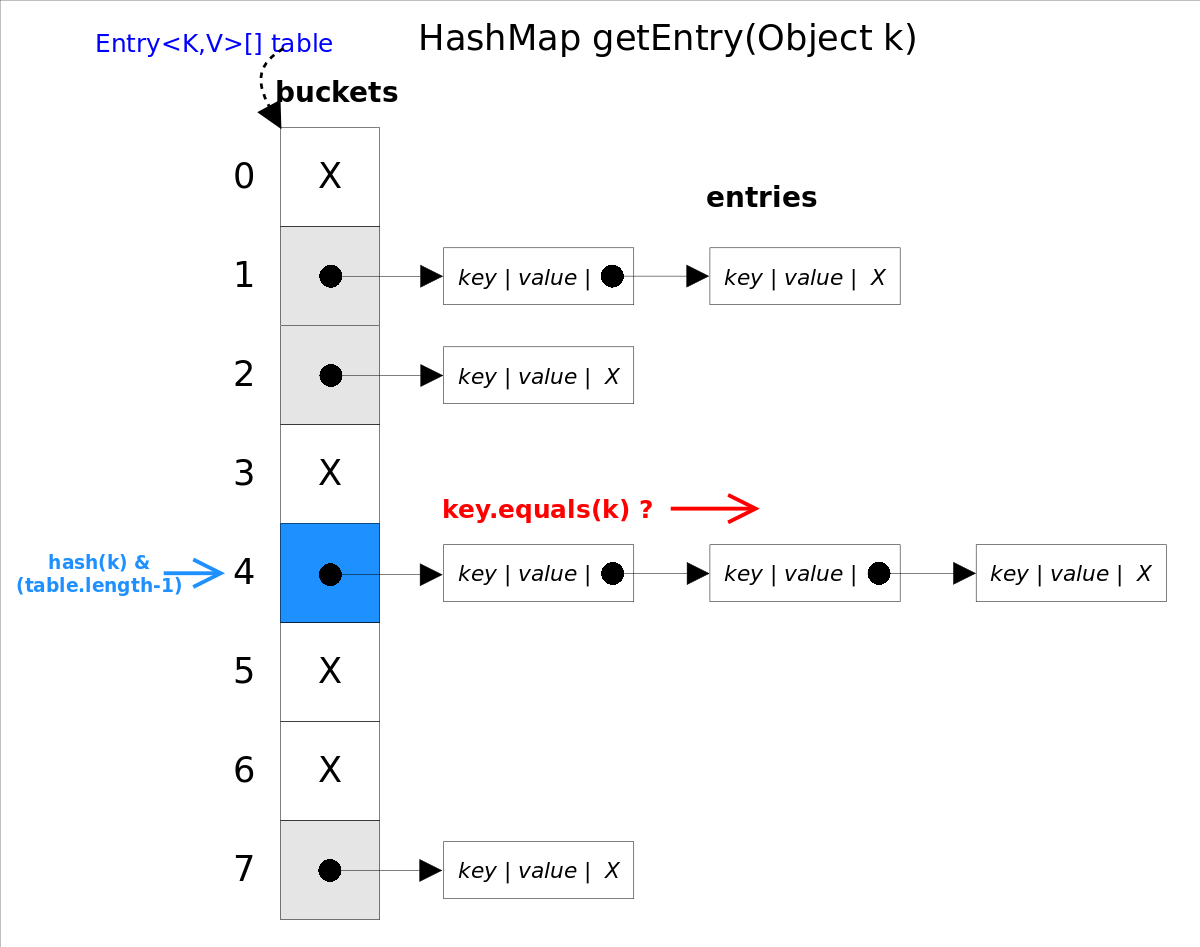

get

get(Object key)方法根据指定的key值返回对应的value,该方法调用了getEntry(Object key)得到相应的entry,然后返回entry.getValue()。因此getEntry()是算法的核心。 算法思想是首先通过hash()函数得到对应bucket的下标,然后依次遍历冲突链表,通过key.equals(k)方法来判断是否是要找的那个entry。

上图中 hash(k) & (table.length-1) 等价于 hash(k) % table.length,原因是 HashMap 要求 table.length 均为 2 的指数,因此 table.length -1 就是二进制低位全是 1,跟 hash(k) 相与会将哈希值的高位全部抹掉,剩下的就是余数了。

//getEntry()方法

final Entry<K,V> getEntry(Object key) {

......

int hash = (key == null) ? 0 : hash(key);

for (Entry<K,V> e = table[hash&(table.length-1)];//得到冲突链表

e != null; e = e.next) {//依次遍历冲突链表中的每个entry

Object k;

//依据equals()方法判断是否相等

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

}

return null;

}

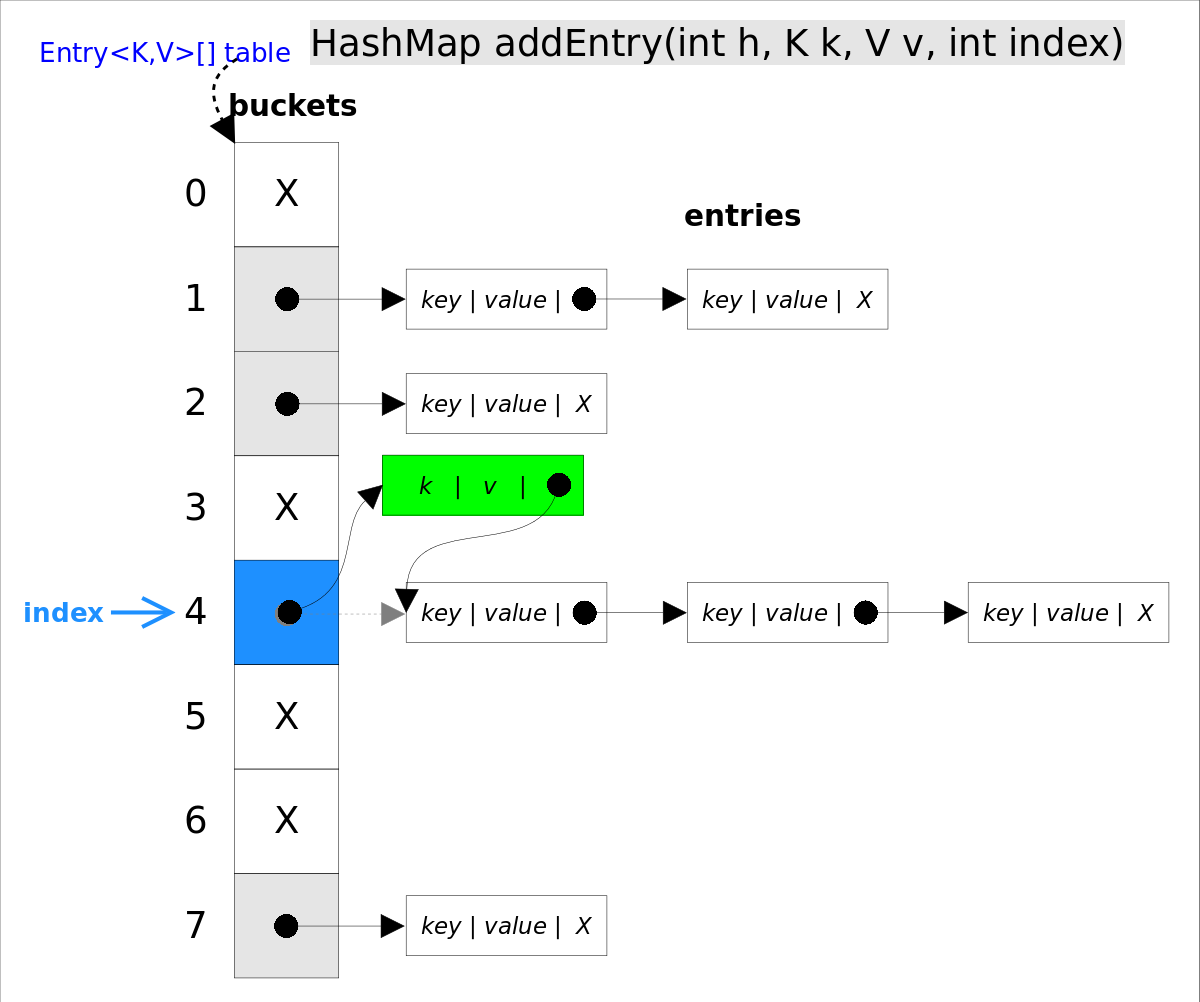

put

put(K key, V value)方法是将指定的key, value对添加到map里。该方法首先会对map做一次查找,看是否包含该元组,如果已经包含则直接返回,查找过程类似于getEntry()方法;如果没有找到,则会通过addEntry(int hash, K key, V value, int bucketIndex)方法插入新的entry,插入方式为头插法。

//addEntry()

void addEntry(int hash, K key, V value, int bucketIndex) {

if ((size >= threshold) && (null != table[bucketIndex])) {

resize(2 * table.length);//自动扩容,并重新哈希

hash = (null != key) ? hash(key) : 0;

bucketIndex = hash & (table.length-1);//hash%table.length

}

//在冲突链表头部插入新的entry

Entry<K,V> e = table[bucketIndex];

table[bucketIndex] = new Entry<>(hash, key, value, e);

size++;

}

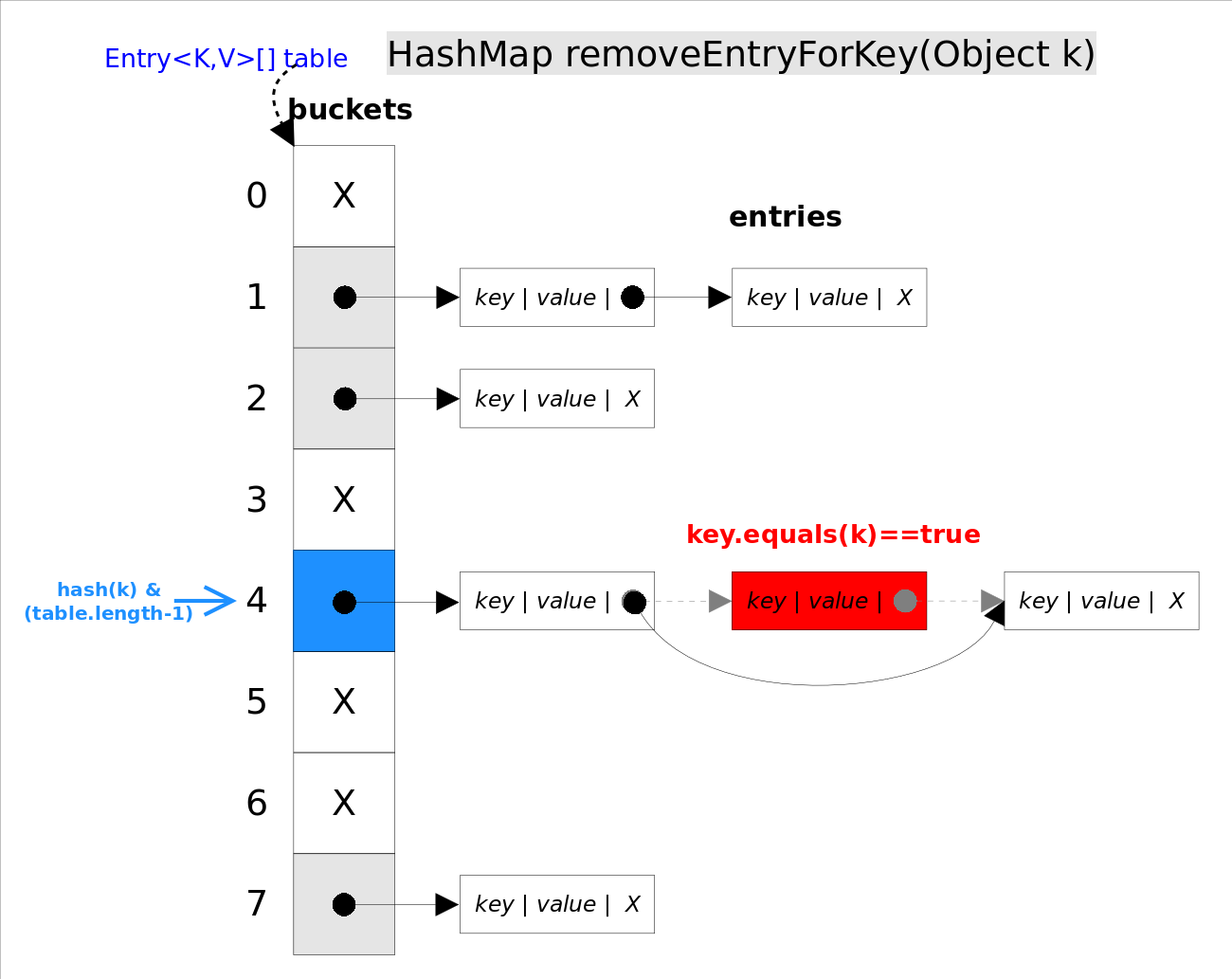

remove

remove(Object key)的作用是删除key值对应的entry,该方法的具体逻辑是在removeEntryForKey(Object key)里实现的。removeEntryForKey()方法会首先找到key值对应的entry,然后删除该entry(修改链表的相应引用)。查找过程跟getEntry()过程类似。

//removeEntryForKey()

final Entry<K,V> removeEntryForKey(Object key) {

......

int hash = (key == null) ? 0 : hash(key);

int i = indexFor(hash, table.length);//hash&(table.length-1)

Entry<K,V> prev = table[i];//得到冲突链表

Entry<K,V> e = prev;

while (e != null) {//遍历冲突链表

Entry<K,V> next = e.next;

Object k;

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k)))) {//找到要删除的entry

modCount++; size--;

if (prev == e) table[i] = next;//删除的是冲突链表的第一个entry

else prev.next = next;

return e;

}

prev = e; e = next;

}

return e;

}

HashSet

HashSet是对HashMap的简单包装,对HashSet的函数调用都会转换成合适的HashMap方法。

//HashSet是对HashMap的简单包装

public class HashSet<E>

{

......

//HashSet里面有一个HashMap

private transient HashMap<E,Object> map;

// Dummy value to associate with an Object in the backing Map

private static final Object PRESENT = new Object();

public HashSet() {

map = new HashMap<>();

}

......

public boolean add(E e) {//简单的方法转换

return map.put(e, PRESENT)==null;

}

......

}

7 - CH07-LinkedHashSet-Map

概述

- LinkedHashSet 和 LinkedHashMap 在 Java 中也是类似的实现,前者只是对后者的简单封装。

- LinkedHashMap 实现了 Map 接口,允许放入 null key 和 null value。

- 同时满足 HashMap 和 linked list 的一些特性。

- 可以将 LinkedHashMap 看做是通过 linked list 增强的 HashMap。

- LinkedHashMap 是 HashMap 的直接子类,二者唯一的区别是 LinkedHashMap 在 HashMap 的基础上,采用双向链表的形式将所有 entry 连接起来,以保证元素的迭代顺序和插入顺序相同。

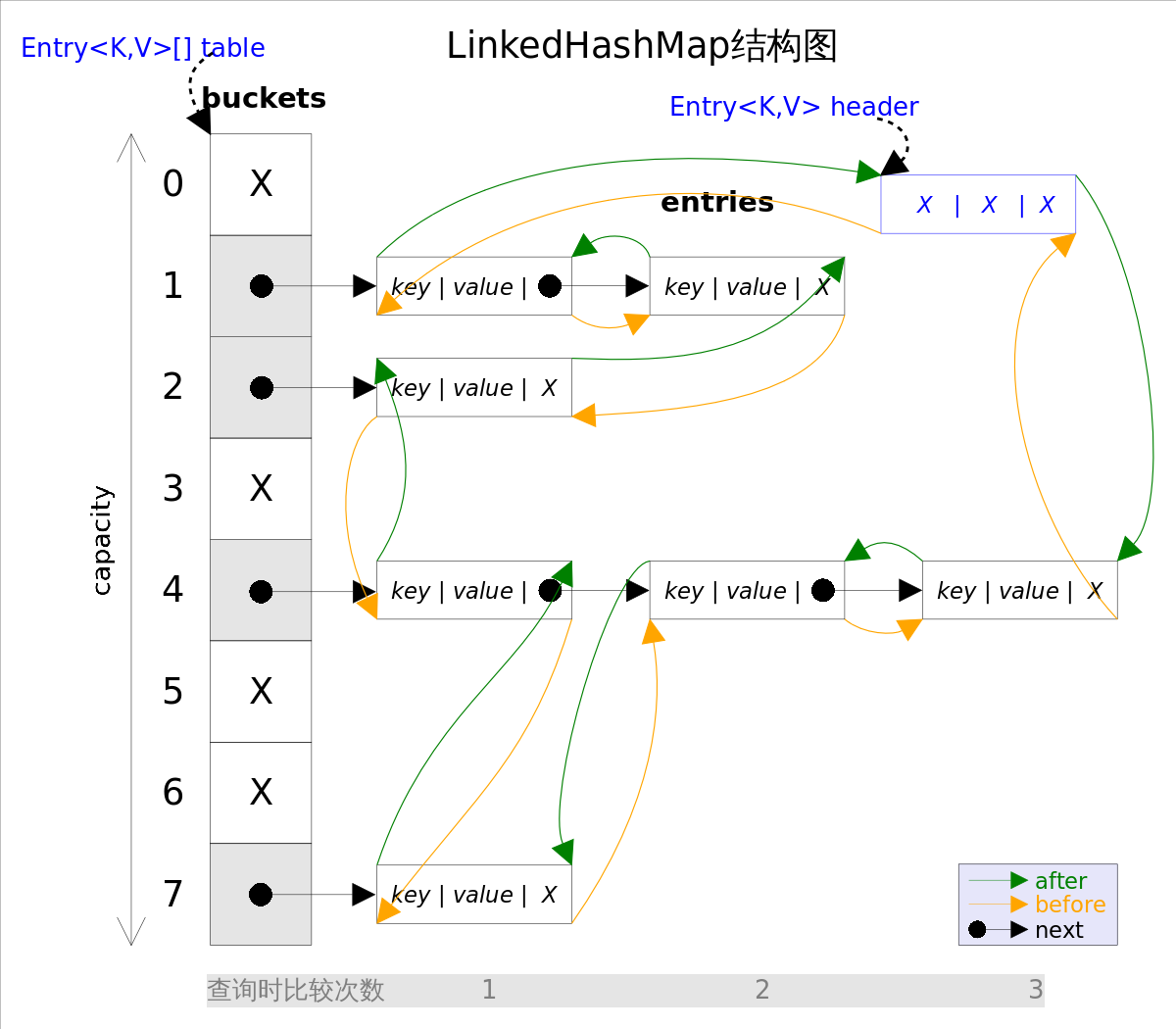

如上图,相比 HashMap,在 entry 部分多了个属性用于连接所有 entry。而 header 用于指向双向链表的头部。

这种结构体还有一个好处,迭代时不需要像 HashMap 那样遍历整个 table,只需要遍历 header 指向的双向链表即可。也就是说,LinkedHashMap 的迭代时间只和 entry 的数量相关,与 table 的大小无关。

有两个参数可以影响 LinkedHashMap 的性能:初始容量(inital capacity)和负载系数(load factor)。初始容量指定了 table 的大小,负载系数用来指定自动扩容的临界值。当entry的数量超过capacity*load_factor时,容器将自动扩容并重新哈希。对于插入元素较多的场景,将初始容量设大可以减少重新哈希的次数。

将对象放入到LinkedHashMap或LinkedHashSet中时,有两个方法需要特别关心: hashCode()和equals()。hashCode()方法决定了对象会被放到哪个bucket里,当多个对象的哈希值冲突时,equals()方法决定了这些对象是否是“同一个对象”。所以,如果要将自定义的对象放入到LinkedHashMap或LinkedHashSet中,需要重写 hashCode()和equals()方法。

内部实现

get

get(Object key)方法根据指定的key值返回对应的value。该方法跟HashMap.get()方法的流程几乎完全一样。

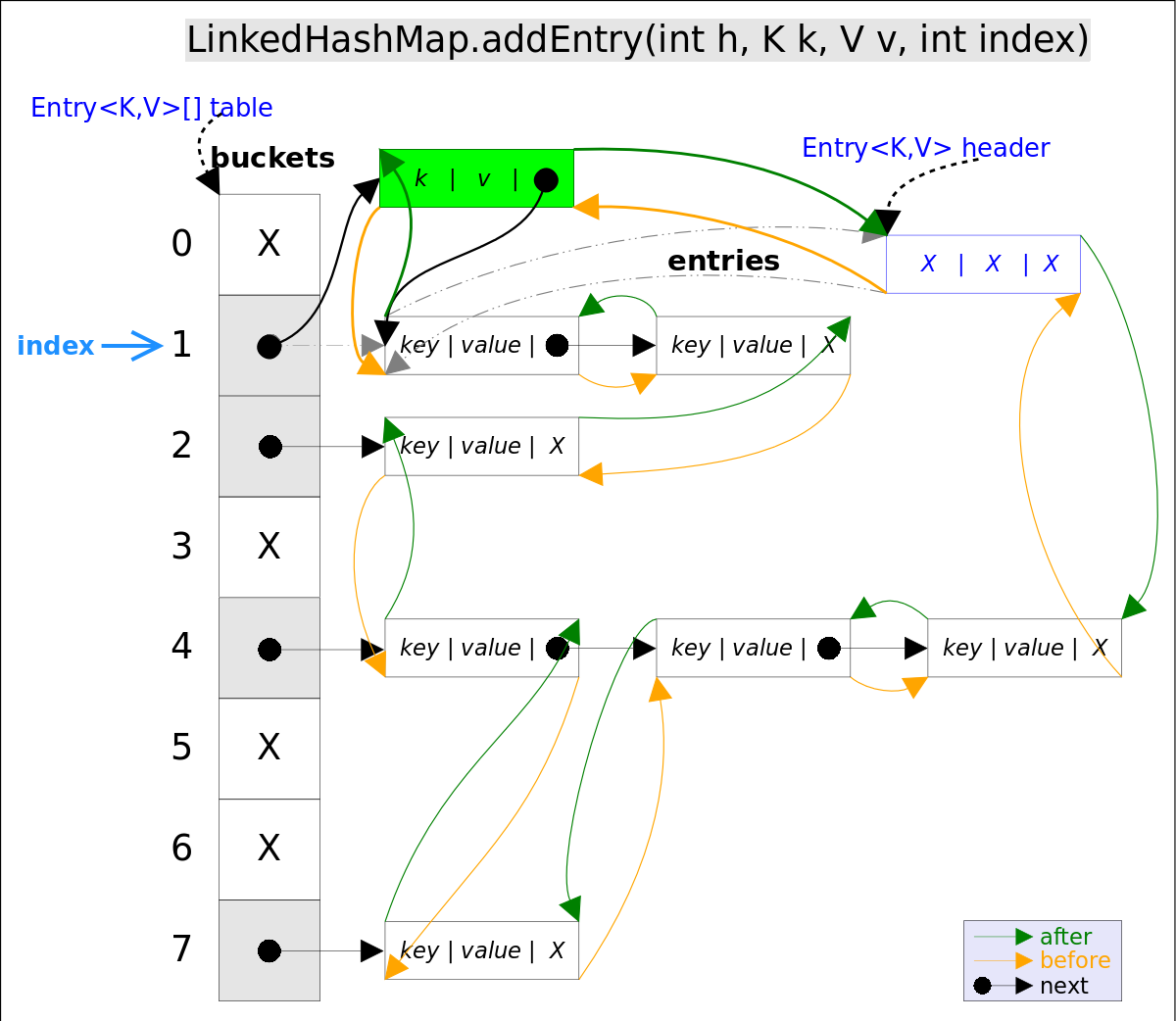

put

put(K key, V value)方法是将指定的key, value对添加到map里。该方法首先会对map做一次查找,看是否包含该元组,如果已经包含则直接返回,查找过程类似于get()方法;如果没有找到,则会通过addEntry(int hash, K key, V value, int bucketIndex)方法插入新的entry。

注意这里的插入有两重含义:

- 从 table 的角度看,新的 entry 需要插入到对应的 bucket 中,当有哈希冲突时,采用头插法将新的 entry 插入到冲突链表的头部。

- 从 header 的角度看,新的 entry 需要插入到双向链表大尾部。

addEntry 的实现逻辑:

// LinkedHashMap.addEntry()

void addEntry(int hash, K key, V value, int bucketIndex) {

if ((size >= threshold) && (null != table[bucketIndex])) {

resize(2 * table.length);// 自动扩容,并重新哈希

hash = (null != key) ? hash(key) : 0;

bucketIndex = hash & (table.length-1);// hash%table.length

}

// 1.在冲突链表头部插入新的entry

HashMap.Entry<K,V> old = table[bucketIndex];

Entry<K,V> e = new Entry<>(hash, key, value, old);

table[bucketIndex] = e;

// 2.在双向链表的尾部插入新的entry

e.addBefore(header);

size++;

}

上述代码中用到了 addBefore 方法将新的 entry 插入到双向链表头引用的 header 的前面,这样 e 就称为双向链表中的最后一个元素。addBefore 的实现逻辑如下:

// LinkedHashMap.Entry.addBefor(),将this插入到existingEntry的前面

private void addBefore(Entry<K,V> existingEntry) {

after = existingEntry;

before = existingEntry.before;

before.after = this;

after.before = this;

}

上述到吗只是简单的修改 entry 的引用就实现了整个逻辑。

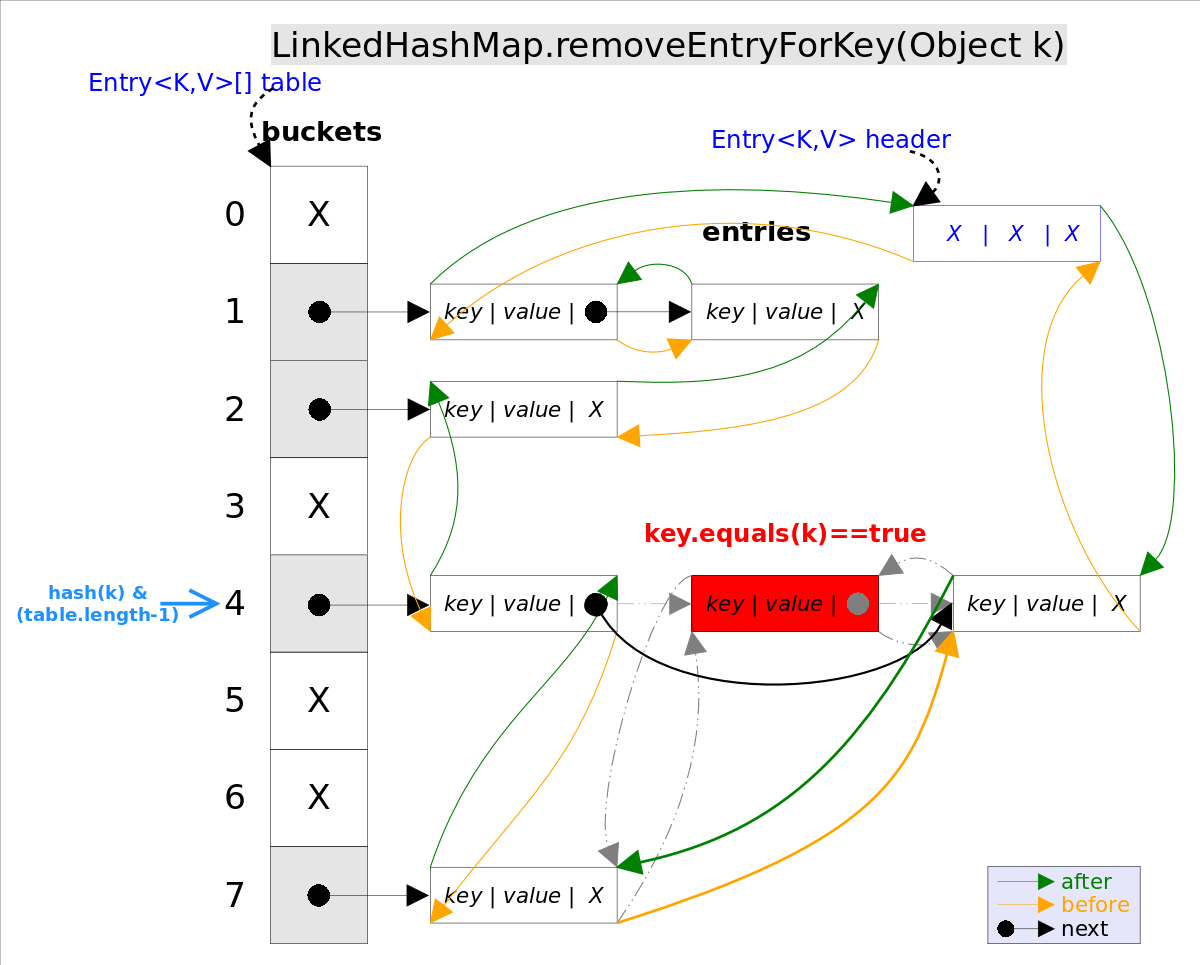

remove

remove(Object key)的作用是删除key值对应的entry,该方法的具体逻辑是在removeEntryForKey(Object key)里实现的。removeEntryForKey()方法会首先找到key值对应的entry,然后删除该entry(修改链表的相应引用)。查找过程跟get()方法类似。

注意这里的删除也有两重含义:

- 从 table 的角度看,需要将 entry 从对应的 bucket 中删除,如果对应的冲突链表不为空,需要修改冲突链表的引用。

- 从 header 的角度看,需要将该 entry 从双向链表中删除,同时修改链表中前置和后置元素的引用。

removeEntryForKey 的实现逻辑如下:

// LinkedHashMap.removeEntryForKey(),删除key值对应的entry

final Entry<K,V> removeEntryForKey(Object key) {

......

int hash = (key == null) ? 0 : hash(key);

int i = indexFor(hash, table.length);// hash&(table.length-1)

Entry<K,V> prev = table[i];// 得到冲突链表

Entry<K,V> e = prev;

while (e != null) {// 遍历冲突链表

Entry<K,V> next = e.next;

Object k;

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k)))) {// 找到要删除的entry

modCount++; size--;

// 1. 将e从对应bucket的冲突链表中删除

if (prev == e) table[i] = next;

else prev.next = next;

// 2. 将e从双向链表中删除

e.before.after = e.after;

e.after.before = e.before;

return e;

}

prev = e; e = next;

}

return e;

}

LinkedHashSet

LinkedHashSet是对LinkedHashMap的简单包装,对LinkedHashSet的函数调用都会转换成合适的LinkedHashMap方法。

public class LinkedHashSet<E>

extends HashSet<E>

implements Set<E>, Cloneable, java.io.Serializable {

......

// LinkedHashSet里面有一个LinkedHashMap

public LinkedHashSet(int initialCapacity, float loadFactor) {

map = new LinkedHashMap<>(initialCapacity, loadFactor);

}

......

public boolean add(E e) {//简单的方法转换

return map.put(e, PRESENT)==null;

}

......

}

常用场景

LinkedHashMap除了可以保证迭代顺序外,还有一个非常有用的用法: 可以轻松实现一个采用了FIFO替换策略的缓存。具体说来,LinkedHashMap有一个子类方法protected boolean removeEldestEntry(Map.Entry<K,V> eldest),该方法的作用是告诉Map是否要删除“最老”的Entry,所谓最老就是当前Map中最早插入的Entry,如果该方法返回true,最老的那个元素就会被删除。在每次插入新元素的之后LinkedHashMap会自动询问removeEldestEntry()是否要删除最老的元素。这样只需要在子类中重载该方法,当元素个数超过一定数量时让removeEldestEntry()返回true,就能够实现一个固定大小的FIFO策略的缓存。示例代码如下:

class FifoCache<K,V> extends LinkedHashMap<K,v> {

private final int size;

public FifoCache(int size){

this.size = size;

}

@Override

protected boolean removeEldestEntry(Map.Entry<K,V> eldest){

return size() > size;

}

}

8 - CH08-TreeSet-Map

概述

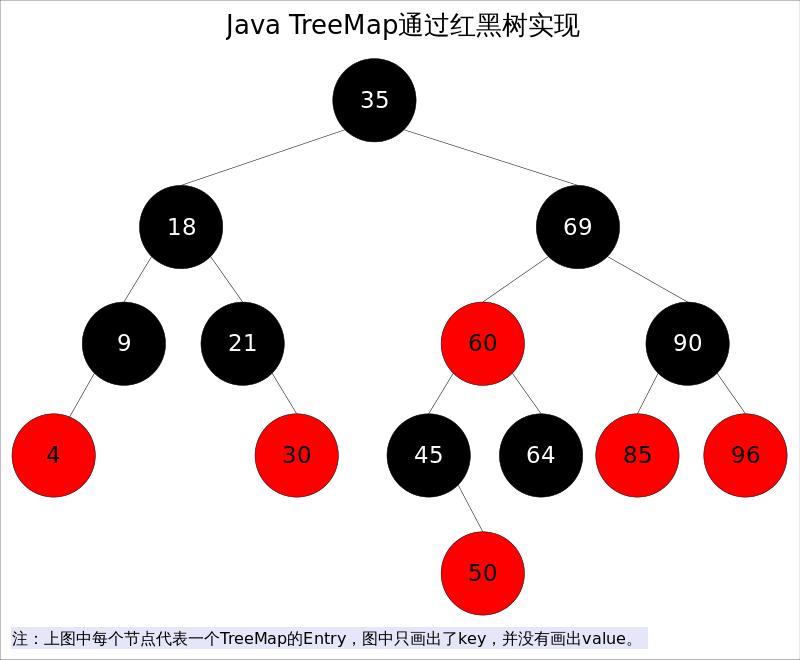

- TreeSet 和 TreeMap 在 Java 中具有类似的实现,前者仅仅是对后者的简单封装。

- TreeMap实现了SortedMap接口,也就是说会按照

key的大小顺序对Map中的元素进行排序,key大小的评判可以通过其本身的自然顺序(natural ordering),也可以通过构造时传入的比较器(Comparator)。 - *TreeMap*底层通过红黑树(Red-Black tree)实现,也就意味着

containsKey(),get(),put(),remove()都有着log(n)的时间复杂度。 - 出于性能原因,TreeMap是非同步的(not synchronized)。

红黑树是一种近似平衡的二叉查找树,它能保证任何一个节点的左右子树的高度差不会超过二者中较低那个的一倍。

具体来说,红黑树是满足如下条件的二叉查找树:

- 每个节点要么是红色,要么是黑色。

- 根节点必须是黑色。

- 红色节点不能有连续(父子节点均不能为红色)。

- 对于每个节点,从该节点至 null(树尾)的任何路径,都含有相同个数的黑色节点。

在树的结构发生改变时(插入或删除),往往会破坏上面的 3 和 4,需要执行调整以使得重新满足所有条件。

树操作

调整可以分为两类,颜色调整和结构调整。

结构调整:左旋

左旋的过程就是想 X 的右子树绕 X 向左方向(逆时针)旋转,使 X 的右子树称为 X 的父亲,同时修改相关节点的引用。旋转之后,二叉查找树的条件仍然满足。

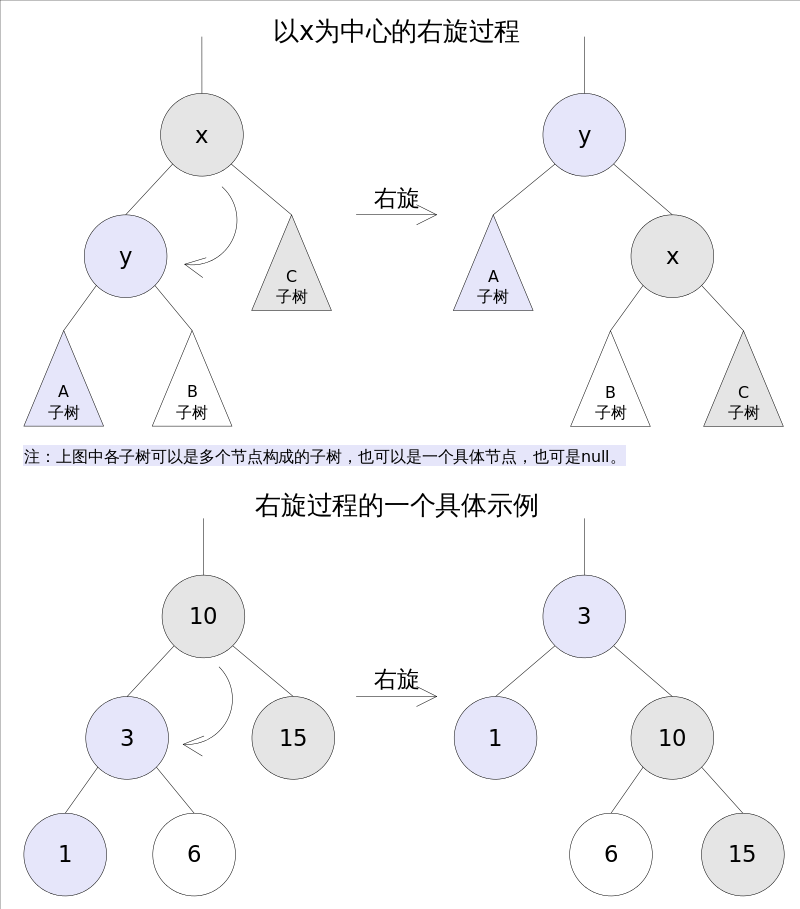

结构调整:右旋

右旋的过程是将 X 的左子树绕 X 向右方向(顺时针)旋转,使 X 的左子树称为 X 的父亲,同时修改相关的引用。旋转之后,二叉查找树的条件仍然满足。

寻找节点后继

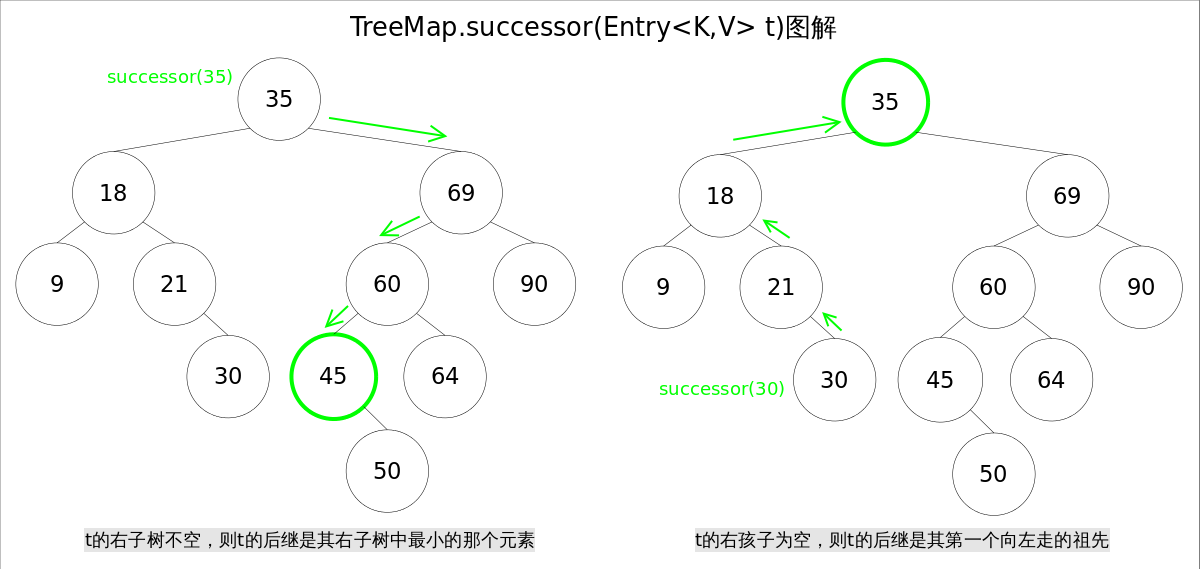

对二叉查找树,给定节点 T,其后继(树中大于 T 的最小元素)可以通过如下方式找到:

- T 的右子树不空,则 T 的后继是其右子树中最小的按个元素。

- T 的右子树为空,则 T 的后继是其第一个向左走的父亲。

该操作用于删除红黑树中的删除操作。

// 寻找节点后继函数successor()

static <K,V> TreeMap.Entry<K,V> successor(Entry<K,V> t) {

if (t == null)

return null;

else if (t.right != null) {// 1. t的右子树不空,则t的后继是其右子树中最小的那个元素

Entry<K,V> p = t.right;

while (p.left != null)

p = p.left;

return p;

} else {// 2. t的右孩子为空,则t的后继是其第一个向左走的祖先

Entry<K,V> p = t.parent;

Entry<K,V> ch = t;

while (p != null && ch == p.right) {

ch = p;

p = p.parent;

}

return p;

}

}

内部实现

get

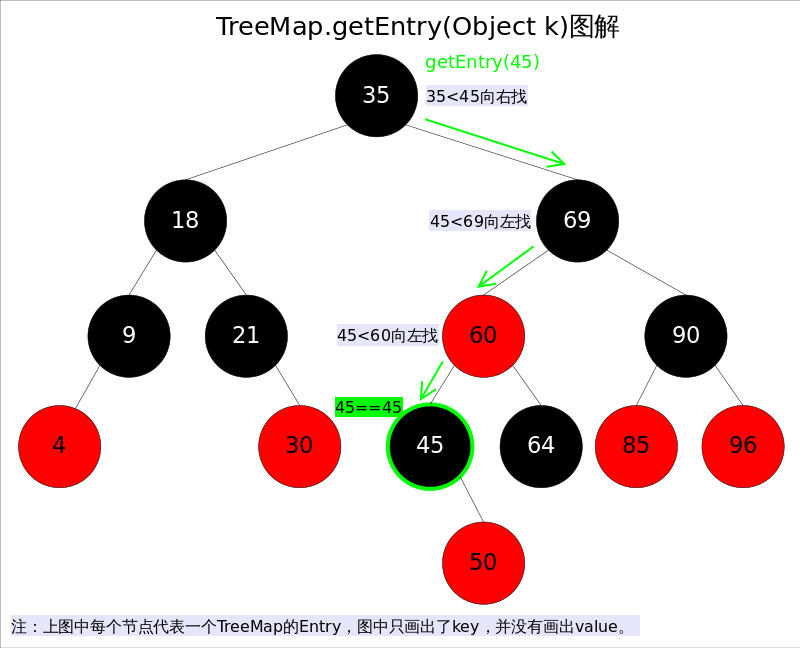

get(Object key)方法根据指定的key值返回对应的value,该方法调用了getEntry(Object key)得到相应的entry,然后返回entry.value。因此getEntry()是算法的核心。算法思想是根据key的自然顺序(或者比较器顺序)对二叉查找树进行查找,直到找到满足k.compareTo(p.key) == 0的entry。

//getEntry()方法

final Entry<K,V> getEntry(Object key) {

......

if (key == null)//不允许key值为null

throw new NullPointerException();

Comparable<? super K> k = (Comparable<? super K>) key;//使用元素的自然顺序

Entry<K,V> p = root;

while (p != null) {

int cmp = k.compareTo(p.key);

if (cmp < 0)//向左找

p = p.left;

else if (cmp > 0)//向右找

p = p.right;

else

return p;

}

return null;

}

put

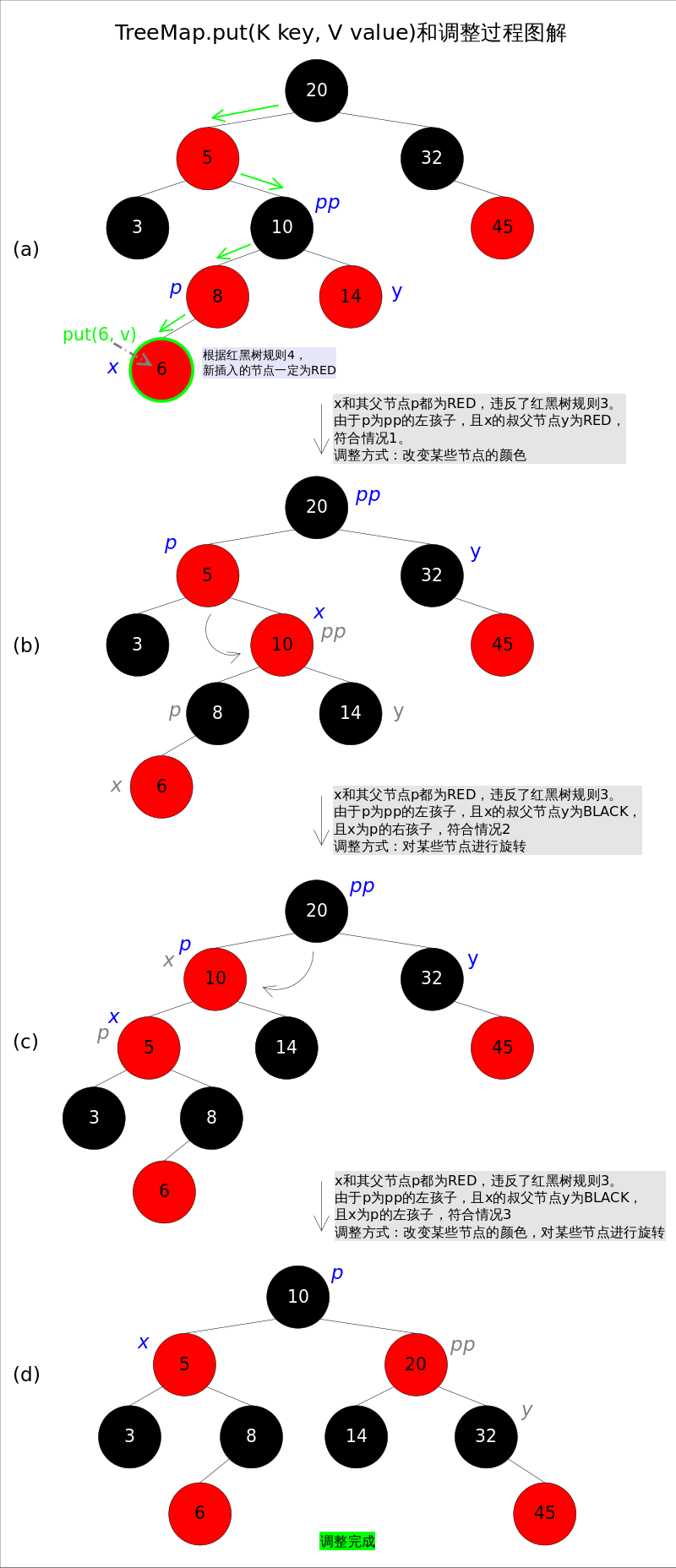

put(K key, V value)方法是将指定的key, value对添加到map里。该方法首先会对map做一次查找,看是否包含该元组,如果已经包含则直接返回,查找过程类似于getEntry()方法;如果没有找到则会在红黑树中插入新的entry,如果插入之后破坏了红黑树的约束条件,还需要进行调整(旋转,改变某些节点的颜色)。

public V put(K key, V value) {

......

int cmp;

Entry<K,V> parent;

if (key == null)

throw new NullPointerException();

Comparable<? super K> k = (Comparable<? super K>) key;//使用元素的自然顺序

do {

parent = t;

cmp = k.compareTo(t.key);

if (cmp < 0) t = t.left;//向左找

else if (cmp > 0) t = t.right;//向右找

else return t.setValue(value);

} while (t != null);

Entry<K,V> e = new Entry<>(key, value, parent);//创建并插入新的entry

if (cmp < 0) parent.left = e;

else parent.right = e;

fixAfterInsertion(e);//调整

size++;

return null;

}

上述代码首先在红黑树上找到合适的位置,然后创建新的 entry 并插入(插入的节点一定是叶子)。难点是调整函数 fixAfterInsertion,需要执行颜色调整和结构调整。

调整函数的具体实现如下,其中用到了前面提到的 rotateLeft 和 rotateRight 函数。通过代码我们可以看到,情况 2 其实是落在情况 3 内。情况 4~6 跟前三种情况是对称的,因此图解中没有展示后 3 种情况。

//红黑树调整函数fixAfterInsertion()

private void fixAfterInsertion(Entry<K,V> x) {

x.color = RED;

while (x != null && x != root && x.parent.color == RED) {

if (parentOf(x) == leftOf(parentOf(parentOf(x)))) {

Entry<K,V> y = rightOf(parentOf(parentOf(x)));

if (colorOf(y) == RED) {

setColor(parentOf(x), BLACK); // 情况1

setColor(y, BLACK); // 情况1

setColor(parentOf(parentOf(x)), RED); // 情况1

x = parentOf(parentOf(x)); // 情况1

} else {

if (x == rightOf(parentOf(x))) {

x = parentOf(x); // 情况2

rotateLeft(x); // 情况2

}

setColor(parentOf(x), BLACK); // 情况3

setColor(parentOf(parentOf(x)), RED); // 情况3

rotateRight(parentOf(parentOf(x))); // 情况3

}

} else {

Entry<K,V> y = leftOf(parentOf(parentOf(x)));

if (colorOf(y) == RED) {

setColor(parentOf(x), BLACK); // 情况4

setColor(y, BLACK); // 情况4

setColor(parentOf(parentOf(x)), RED); // 情况4

x = parentOf(parentOf(x)); // 情况4

} else {

if (x == leftOf(parentOf(x))) {

x = parentOf(x); // 情况5

rotateRight(x); // 情况5

}

setColor(parentOf(x), BLACK); // 情况6

setColor(parentOf(parentOf(x)), RED); // 情况6

rotateLeft(parentOf(parentOf(x))); // 情况6

}

}

}

root.color = BLACK;

}

remove

remove(Object key)的作用是删除key值对应的entry,该方法首先通过上文中提到的getEntry(Object key)方法找到key值对应的entry,然后调用deleteEntry(Entry<K,V> entry)删除对应的entry。由于删除操作会改变红黑树的结构,有可能破坏红黑树的约束条件,因此有可能要进行调整。

getEntry()函数前面已经讲解过,这里重点放deleteEntry()上,该函数删除指定的entry并在红黑树的约束被破坏时进行调用fixAfterDeletion(Entry<K,V> x)进行调整。

由于红黑树是一棵增强版的二叉查找树,红黑树的删除操作跟普通二叉查找树的删除操作也就非常相似,唯一的区别是红黑树在节点删除之后可能需要进行调整。现在考虑一棵普通二叉查找树的删除过程,可以简单分为两种情况:

删除节点 P 的左右子树都为空,或者只有一个子树为空。

删除节点 P 的左右子树都非空。

对于上述情况1,处理起来比较简单,直接将p删除(左右子树都为空时),或者用非空子树替代p(只有一棵子树非空时);对于情况2,可以用p的后继s(树中大于x的最小的那个元素)代替p,然后使用情况1删除s(此时s一定满足情况1.可以画画看)。

基于以上逻辑,红黑树的节点删除函数deleteEntry()代码如下:

// 红黑树entry删除函数deleteEntry()

private void deleteEntry(Entry<K,V> p) {

modCount++;

size--;

if (p.left != null && p.right != null) {// 2. 删除点p的左右子树都非空。

Entry<K,V> s = successor(p);// 后继

p.key = s.key;

p.value = s.value;

p = s;

}

Entry<K,V> replacement = (p.left != null ? p.left : p.right);

if (replacement != null) {// 1. 删除点p只有一棵子树非空。

replacement.parent = p.parent;

if (p.parent == null)

root = replacement;

else if (p == p.parent.left)

p.parent.left = replacement;

else

p.parent.right = replacement;

p.left = p.right = p.parent = null;

if (p.color == BLACK)

fixAfterDeletion(replacement);// 调整

} else if (p.parent == null) {

root = null;

} else { // 1. 删除点p的左右子树都为空

if (p.color == BLACK)

fixAfterDeletion(p);// 调整

if (p.parent != null) {

if (p == p.parent.left)

p.parent.left = null;

else if (p == p.parent.right)

p.parent.right = null;

p.parent = null;

}

}

}

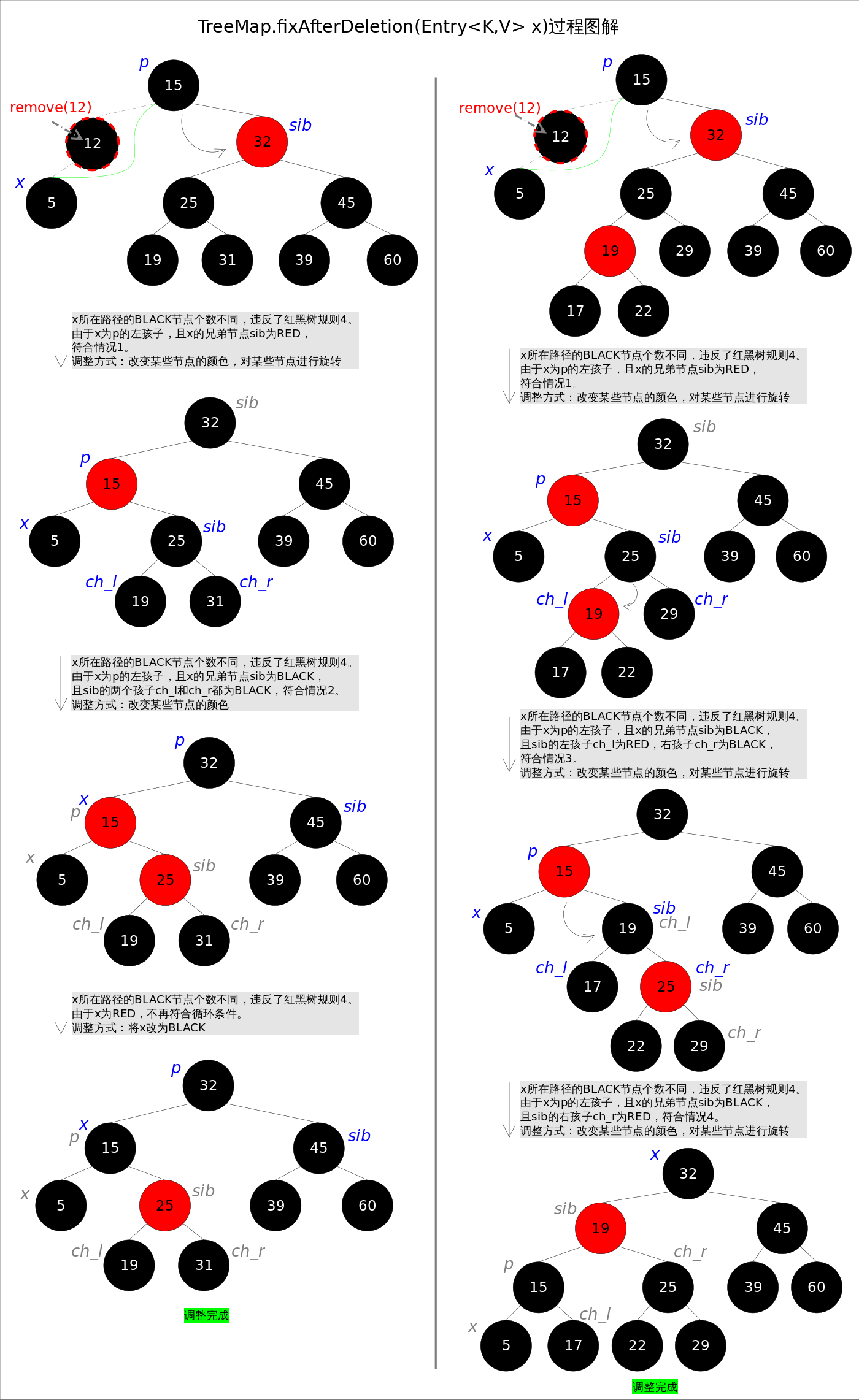

上述代码中占据大量代码行的,是用来修改父子节点间引用关系的代码,其逻辑并不难理解。下面着重讲解删除后调整函数fixAfterDeletion()。首先请思考一下,删除了哪些点才会导致调整?只有删除点是BLACK的时候,才会触发调整函数,因为删除RED节点不会破坏红黑树的任何约束,而删除BLACK节点会破坏规则4。

跟上文中讲过的fixAfterInsertion()函数一样,这里也要分成若干种情况。记住,无论有多少情况,具体的调整操作只有两种: 1.改变某些节点的颜色,2.对某些节点进行旋转。

上图的整体思路为:将情况 1 首先转换为情况 2,或者转换成 3 或 4。当然,该图解并不意味着调整情况一定是从情况 1 开始的。通过后续的代码我们会发现一些规则:

- 如果是由情况 1 之后紧接着进入情况 2,那么情况 2 之后一定会退出循环(因为 X 为红色)。

- 一旦进入情况 3 和 4,一定会退出循环(因为 X 为 root)。

删除后跳转函数 fixAfterDeletion 的具体实现如下,其中用到了上文中提到的rotateLeft()和rotateRight()函数。通过代码我们能够看到,情况3其实是落在情况4内的。情况5~情况8跟前四种情况是对称的,因此图解中并没有画出后四种情况,读者可以参考代码自行理解。

private void fixAfterDeletion(Entry<K,V> x) {

while (x != root && colorOf(x) == BLACK) {

if (x == leftOf(parentOf(x))) {

Entry<K,V> sib = rightOf(parentOf(x));

if (colorOf(sib) == RED) {

setColor(sib, BLACK); // 情况1

setColor(parentOf(x), RED); // 情况1

rotateLeft(parentOf(x)); // 情况1

sib = rightOf(parentOf(x)); // 情况1

}

if (colorOf(leftOf(sib)) == BLACK &&

colorOf(rightOf(sib)) == BLACK) {

setColor(sib, RED); // 情况2

x = parentOf(x); // 情况2

} else {

if (colorOf(rightOf(sib)) == BLACK) {

setColor(leftOf(sib), BLACK); // 情况3

setColor(sib, RED); // 情况3

rotateRight(sib); // 情况3

sib = rightOf(parentOf(x)); // 情况3

}

setColor(sib, colorOf(parentOf(x))); // 情况4

setColor(parentOf(x), BLACK); // 情况4

setColor(rightOf(sib), BLACK); // 情况4

rotateLeft(parentOf(x)); // 情况4

x = root; // 情况4

}

} else { // 跟前四种情况对称

Entry<K,V> sib = leftOf(parentOf(x));

if (colorOf(sib) == RED) {

setColor(sib, BLACK); // 情况5

setColor(parentOf(x), RED); // 情况5

rotateRight(parentOf(x)); // 情况5

sib = leftOf(parentOf(x)); // 情况5

}

if (colorOf(rightOf(sib)) == BLACK &&

colorOf(leftOf(sib)) == BLACK) {

setColor(sib, RED); // 情况6

x = parentOf(x); // 情况6

} else {

if (colorOf(leftOf(sib)) == BLACK) {

setColor(rightOf(sib), BLACK); // 情况7

setColor(sib, RED); // 情况7

rotateLeft(sib); // 情况7

sib = leftOf(parentOf(x)); // 情况7

}

setColor(sib, colorOf(parentOf(x))); // 情况8

setColor(parentOf(x), BLACK); // 情况8

setColor(leftOf(sib), BLACK); // 情况8

rotateRight(parentOf(x)); // 情况8

x = root; // 情况8

}

}

}

setColor(x, BLACK);

}

TreeSet

前面已经说过TreeSet是对TreeMap的简单包装,对TreeSet的函数调用都会转换成合适的TreeMap方法。

// TreeSet是对TreeMap的简单包装

public class TreeSet<E> extends AbstractSet<E>

implements NavigableSet<E>, Cloneable, java.io.Serializable

{

......

private transient NavigableMap<E,Object> m;

// Dummy value to associate with an Object in the backing Map

private static final Object PRESENT = new Object();

public TreeSet() {

this.m = new TreeMap<E,Object>();// TreeSet里面有一个TreeMap

}

......

public boolean add(E e) {

return m.put(e, PRESENT)==null;

}

......

}

9 - CH09-WeakHashMap

概述

它的特殊之处在于 WeakHashMap 里的entry可能会被GC自动删除,即使程序员没有调用remove()或者clear()方法。

当使用 WeakHashMap 时,即使没有显式的添加或删除任何元素,也可能发生如下情况:

- 调用两次 size 方法所返回的结果不同。

- 调用两次 isEmpty 方法,第一次返回 false,第二次返回 true。

- 调用两次 containskey 方法,首次返回 true,第二次返回 false,尽管两次使用相同的 key。

- 调用两次 get 方法,首次返回 value,第二次返回 null,尽管两次使用相同的对象。

这些特性尤其适用于需要缓存的场景。在缓存场景中,由于内存的局限,不能缓存所有对象,对象缓存命中可以提供系统效率,但缓存 MISS 也不会引起错误,因为可以通过计算重新得到。

Java 内存是通过 GC 自动管理的,GC 会在程序运行过程中自动判断哪些对象是可以被回收的,并在合适的时机执行内存释放。GC 判断某个对象释放可以被回收的依据是,释放有有效的引用指向该对象。如果没有有效引用指向该对象(即基本意味着不存在访问该对象的方式),那么该对象就是可以被回收的。这里的有效应用并不包括弱引用。也就是说,虽然弱引用可以用来访问对象,但进行垃圾回收时弱引用并不会被考虑在内,仅有弱引用指向的对象仍然会被 GC 回收。

WeakHashMap 内部是通过弱引用来管理 entry 的,弱引用的特性应用到 WeakHashMap 上意味着什么呢?将一对 key value 放入到 WeakHashMap 中并不能避免该 key 被 GC 回收,除非在 WeakHashMap 在外还有对该 key 的强引用。

具体实现

类似于 HashMap 和 HashSet。

WeakHashSet

Set<Object> weakHashSet = Collections

.newSetFromMap(new WeakHashMap<Object, Boolean>());

该工具方法可以直接将 Map 包装为 Set,只是对 Map 的简单封装。

// Collections.newSetFromMap()用于将任何Map包装成一个Set

public static <E> Set<E> newSetFromMap(Map<E, Boolean> map) {

return new SetFromMap<>(map);

}

private static class SetFromMap<E> extends AbstractSet<E>

implements Set<E>, Serializable

{

private final Map<E, Boolean> m; // The backing map

private transient Set<E> s; // Its keySet

SetFromMap(Map<E, Boolean> map) {

if (!map.isEmpty())

throw new IllegalArgumentException("Map is non-empty");

m = map;

s = map.keySet();

}

public void clear() { m.clear(); }

public int size() { return m.size(); }

public boolean isEmpty() { return m.isEmpty(); }

public boolean contains(Object o) { return m.containsKey(o); }

public boolean remove(Object o) { return m.remove(o) != null; }

public boolean add(E e) { return m.put(e, Boolean.TRUE) == null; }

public Iterator<E> iterator() { return s.iterator(); }

public Object[] toArray() { return s.toArray(); }

public <T> T[] toArray(T[] a) { return s.toArray(a); }

public String toString() { return s.toString(); }

public int hashCode() { return s.hashCode(); }

public boolean equals(Object o) { return o == this || s.equals(o); }

public boolean containsAll(Collection<?> c) {return s.containsAll(c);}

public boolean removeAll(Collection<?> c) {return s.removeAll(c);}

public boolean retainAll(Collection<?> c) {return s.retainAll(c);}

// addAll is the only inherited implementation

......

}

10 - CH10-Stream

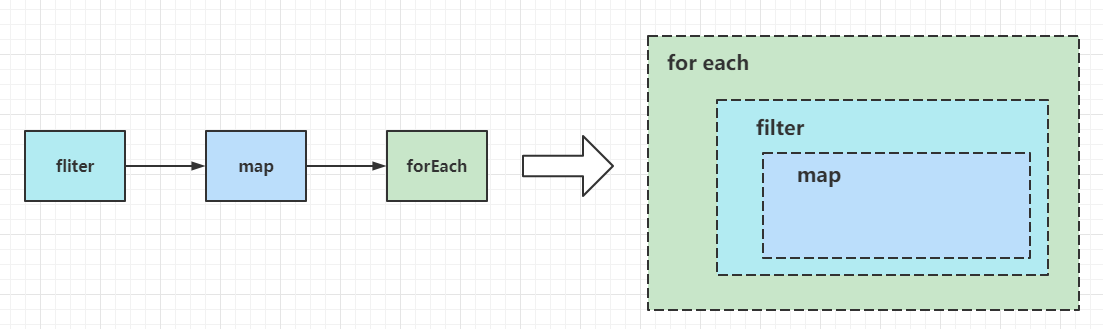

Stream 是 JDK1.8 中首次引入的,距今已经过去了接近8年时间(JDK1.8正式版是2013年底发布的)。Stream 的引入一方面极大地简化了某些开发场景,另一方面也可能降低了编码的可读性(确实有不少人说到Stream会降低代码的可读性,但是在笔者看来,熟练使用之后反而觉得代码的可读性提高了)。这篇文章会花巨量篇幅,详细分析 Stream 的底层实现原理,参考的源码是 JDK11 的源码,其他版本 JDK 可能不适用于本文中的源码展示和相关例子。

向前兼容

Stream是JDK1.8引入的,如要需要JDK1.7或者以前的代码也能在JDK1.8或以上运行,那么Stream的引入必定不能在原来已经发布的接口方法进行修改,否则必定会因为兼容性问题导致老版本的接口实现无法在新版本中运行(方法签名出现异常),猜测是基于这个问题引入了接口默认方法,也就是default关键字。查看源码可以发现,ArrayList的超类Collection和Iterable分别添加了数个default方法:

// java.util.Collection部分源码

public interface Collection<E> extends Iterable<E> {

// 省略其他代码

@Override

default Spliterator<E> spliterator() {

return Spliterators.spliterator(this, 0);

}

default Stream<E> stream() {

return StreamSupport.stream(spliterator(), false);

}

default Stream<E> parallelStream() {

return StreamSupport.stream(spliterator(), true);

}

}

// java.lang.Iterable部分源码

public interface Iterable<T> {

// 省略其他代码

default void forEach(Consumer<? super T> action) {

Objects.requireNonNull(action);

for (T t : this) {

action.accept(t);

}

}

default Spliterator<T> spliterator() {

return Spliterators.spliteratorUnknownSize(iterator(), 0);

}

}

从直觉来看,这些新增的方法应该就是Stream实现的关键方法(后面会印证这不是直觉,而是查看源码的结果)。接口默认方法在使用上和实例方法一致,在实现上可以直接在接口方法中编写方法体,有点静态方法的意味,但是子类可以覆盖其实现(也就是接口默认方法在本接口中的实现有点像静态方法,可以被子类覆盖,使用上和实例方法一致)。这种实现方式,有可能是一种突破,也有可能是一种妥协,但是无论是妥协还是突破,都实现了向前兼容:

// JDK1.7中的java.lang.Iterable

public interface Iterable<T> {

Iterator<T> iterator();

}

// JDK1.7中的Iterable实现

public MyIterable<Long> implements Iterable<Long>{

public Iterator<Long> iterator(){

....

}

}

如上,MyIterable在JDK1.7中定义,如果该类在JDK1.8中运行,那么调用其实例中的forEach()和spliterator()方法,相当于直接调用JDK1.8中的Iterable中的接口默认方法forEach()和spliterator()。当然受限于JDK版本,这里只能确保编译通过,旧功能正常使用,而无法在JDK1.7中使用Stream相关功能或者使用default方法关键字。总结这么多,就是想说明为什么使用JDK7开发和编译的代码可以在JDK8环境下运行。

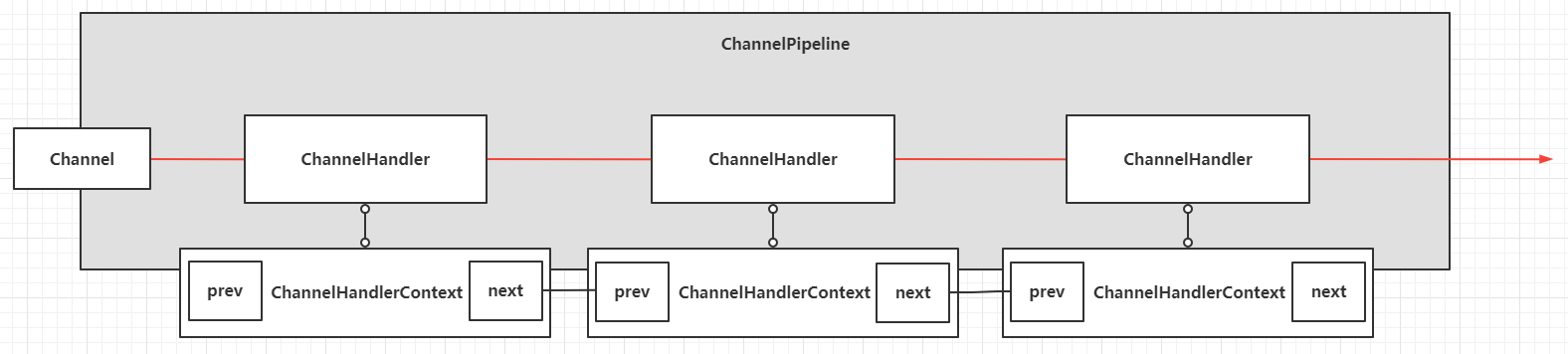

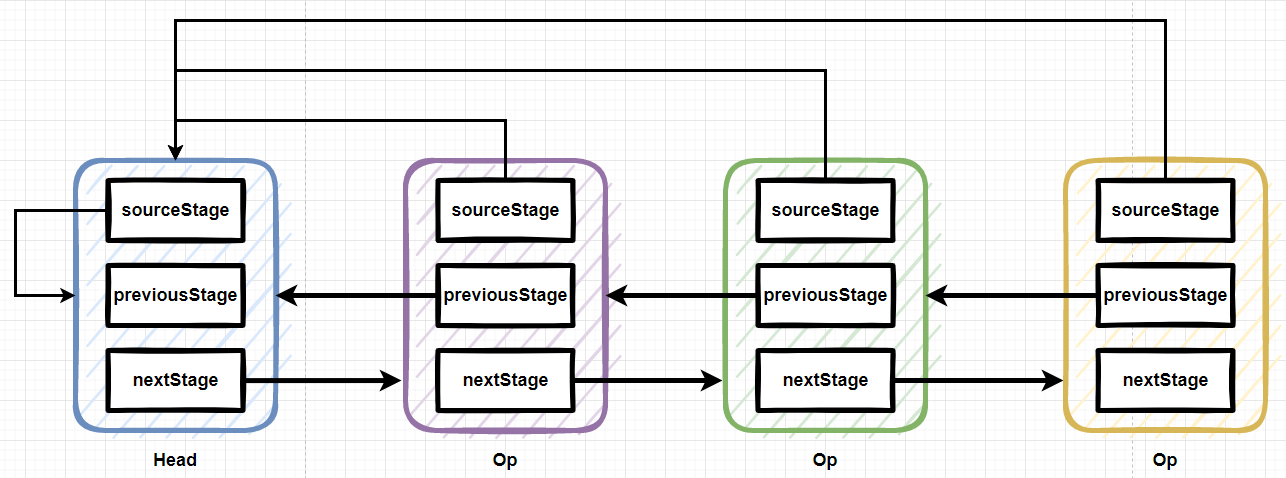

可拆分迭代器 Spliterator

Stream实现的基石是Spliterator,Spliterator是splitable iterator的缩写,意为"可拆分迭代器",用于遍历指定数据源(例如数组、集合或者IO Channel等)中的元素,在设计上充分考虑了串行和并行的场景。上一节提到了Collection存在接口默认方法spliterator(),此方法会生成一个Spliterator<E>实例,意为着所有的集合子类都具备创建Spliterator实例的能力。Stream的实现在设计上和Netty中的ChannelHandlerContext十分相似,本质是一个链表,而Spliterator就是这个链表的Head节点(Spliterator实例就是一个流实例的头节点,后面分析具体的源码时候再具体展开)。

Spliterator 接口方法

接着看Spliterator接口定义的方法:

public interface Spliterator<T> {

// 暂时省略其他代码

boolean tryAdvance(Consumer<? super T> action);

default void forEachRemaining(Consumer<? super T> action) {

do { } while (tryAdvance(action));

}

Spliterator<T> trySplit();

long estimateSize();

default long getExactSizeIfKnown() {

return (characteristics() & SIZED) == 0 ? -1L : estimateSize();

}

int characteristics();

default boolean hasCharacteristics(int characteristics) {

return (characteristics() & characteristics) == characteristics;

}

default Comparator<? super T> getComparator() {

throw new IllegalStateException();

}

// 暂时省略其他代码

}

tryAdvance

- 方法签名:

boolean tryAdvance(Consumer<? super T> action) - 功能:如果

Spliterator中存在剩余元素,则对其中的某个元素执行传入的action回调,并且返回true,否则返回false。如果Spliterator启用了ORDERED特性,会按照顺序(这里的顺序值可以类比为ArrayList中容器数组元素的下标,ArrayList中添加新元素是天然有序的,下标由零开始递增)处理下一个元素 - 例子:

public static void main(String[] args) throws Exception {

List<Integer> list = new ArrayList<>();

list.add(2);

list.add(1);

list.add(3);

Spliterator<Integer> spliterator = list.stream().spliterator();

final AtomicInteger round = new AtomicInteger(1);

final AtomicInteger loop = new AtomicInteger(1);

while (spliterator.tryAdvance(num -> System.out.printf("第%d轮回调Action,值:%d\n", round.getAndIncrement(), num))) {

System.out.printf("第%d轮循环\n", loop.getAndIncrement());

}

}

// 控制台输出

第1轮回调Action,值:2

第1轮循环

第2轮回调Action,值:1

第2轮循环

第3轮回调Action,值:3

第3轮循环

forEachRemaining

- 方法签名:

default void forEachRemaining(Consumer<? super T> action) - 功能:如果

Spliterator中存在剩余元素,则对其中的所有剩余元素在当前线程中执行传入的action回调。如果Spliterator启用了ORDERED特性,会按照顺序处理剩余所有元素。这是一个接口默认方法,方法体比较粗暴,直接是一个死循环包裹着tryAdvance()方法,直到false退出循环 - 例子:

public static void main(String[] args) {

List<Integer> list = new ArrayList<>();

list.add(2);

list.add(1);

list.add(3);

Spliterator<Integer> spliterator = list.stream().spliterator();

final AtomicInteger round = new AtomicInteger(1);

spliterator.forEachRemaining(num -> System.out.printf("第%d轮回调Action,值:%d\n", round.getAndIncrement(), num));

}

// 控制台输出

第1轮回调Action,值:2

第2轮回调Action,值:1

第3轮回调Action,值:3

trySplit

- 方法签名:

Spliterator<T> trySplit() - 功能:如果当前的

Spliterator是可分区(可分割)的,那么此方法将会返回一个全新的Spliterator实例,这个全新的Spliterator实例里面的元素不会被当前Spliterator实例中的元素覆盖(这里是直译了API注释,实际要表达的意思是:当前的Spliterator实例X是可分割的,trySplit()方法会分割X产生一个全新的Spliterator实例Y,原来的X所包含的元素(范围)也会收缩,类似于X = [a,b,c,d] => X = [a,b], Y = [c,d];如果当前的Spliterator实例X是不可分割的,此方法会返回NULL),具体的分割算法由实现类决定 - 例子:

public static void main(String[] args) throws Exception {

List<Integer> list = new ArrayList<>();

list.add(2);

list.add(3);

list.add(4);

list.add(1);

Spliterator<Integer> first = list.stream().spliterator();

Spliterator<Integer> second = first.trySplit();

first.forEachRemaining(num -> {

System.out.printf("first spliterator item: %d\n", num);

});

second.forEachRemaining(num -> {

System.out.printf("second spliterator item: %d\n", num);

});

}

// 控制台输出

first spliterator item: 4

first spliterator item: 1

second spliterator item: 2

second spliterator item: 3

estimateSize

- 方法签名:

long estimateSize() - 功能:返回

forEachRemaining()方法需要遍历的元素总量的估计值,如果样本个数是无限、计算成本过高或者未知,会直接返回Long.MAX_VALUE - 例子:

public static void main(String[] args) throws Exception {

List<Integer> list = new ArrayList<>();

list.add(2);

list.add(3);

list.add(4);

list.add(1);

Spliterator<Integer> spliterator = list.stream().spliterator();

System.out.println(spliterator.estimateSize());

}

// 控制台输出

4

getExactSizeIfKnown

- 方法签名:

default long getExactSizeIfKnown() - 功能:如果当前的

Spliterator具备SIZED特性(关于特性,下文再展开分析),那么直接调用estimateSize()方法,否则返回-1 - 例子:

public static void main(String[] args) throws Exception {

List<Integer> list = new ArrayList<>();

list.add(2);

list.add(3);

list.add(4);

list.add(1);

Spliterator<Integer> spliterator = list.stream().spliterator();

System.out.println(spliterator.getExactSizeIfKnown());

}

// 控制台输出

4

int characteristics()

- 方法签名:

long estimateSize() - 功能:当前的

Spliterator具备的特性(集合),采用位运算,存储在32位整数中(关于特性,下文再展开分析)

hasCharacteristics

- 方法签名:

default boolean hasCharacteristics(int characteristics) - 功能:判断当前的

Spliterator是否具备传入的特性

getComparator

- 方法签名:

default Comparator<? super T> getComparator() - 功能:如果当前的

Spliterator具备SORTED特性,则需要返回一个Comparator实例;如果Spliterator中的元素是天然有序(例如元素实现了Comparable接口),则返回NULL;其他情况直接抛出IllegalStateException异常

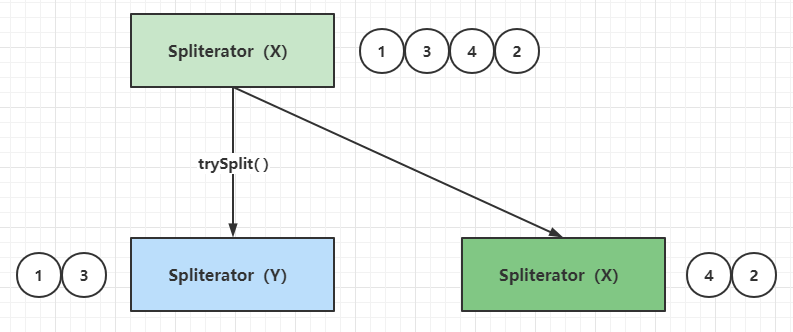

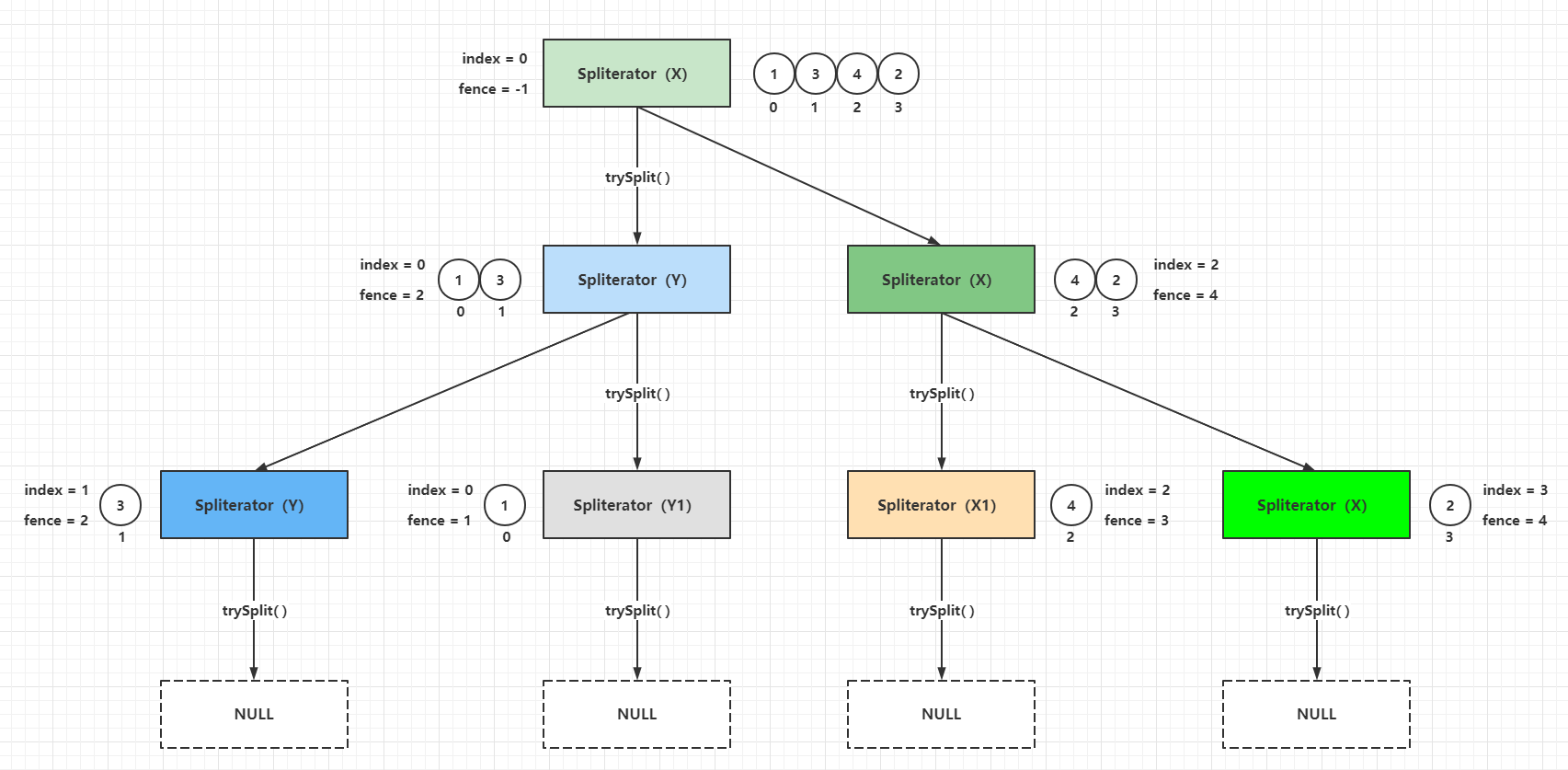

Spliterator自分割

Spliterator#trySplit()可以把一个既有的Spliterator实例分割为两个Spliterator实例,笔者这里把这种方式称为Spliterator自分割,示意图如下:

这里的分割在实现上可以采用两种方式:

- 物理分割:对于

ArrayList而言,把底层数组拷贝并且进行分割,用上面的例子来说相当于X = [1,3,4,2] => X = [4,2], Y = [1,3],这样实现加上对于ArrayList中本身的元素容器数组,相当于多存了一份数据,显然不是十分合理 - 逻辑分割:对于

ArrayList而言,由于元素容器数组天然有序,可以采用数组的索引(下标)进行分割,用上面的例子来说相当于X = 索引表[0,1,2,3] => X = 索引表[2,3], Y = 索引表[0,1],这种方式是共享底层容器数组,只对元素索引进行分割,实现上比较简单而且相对合理

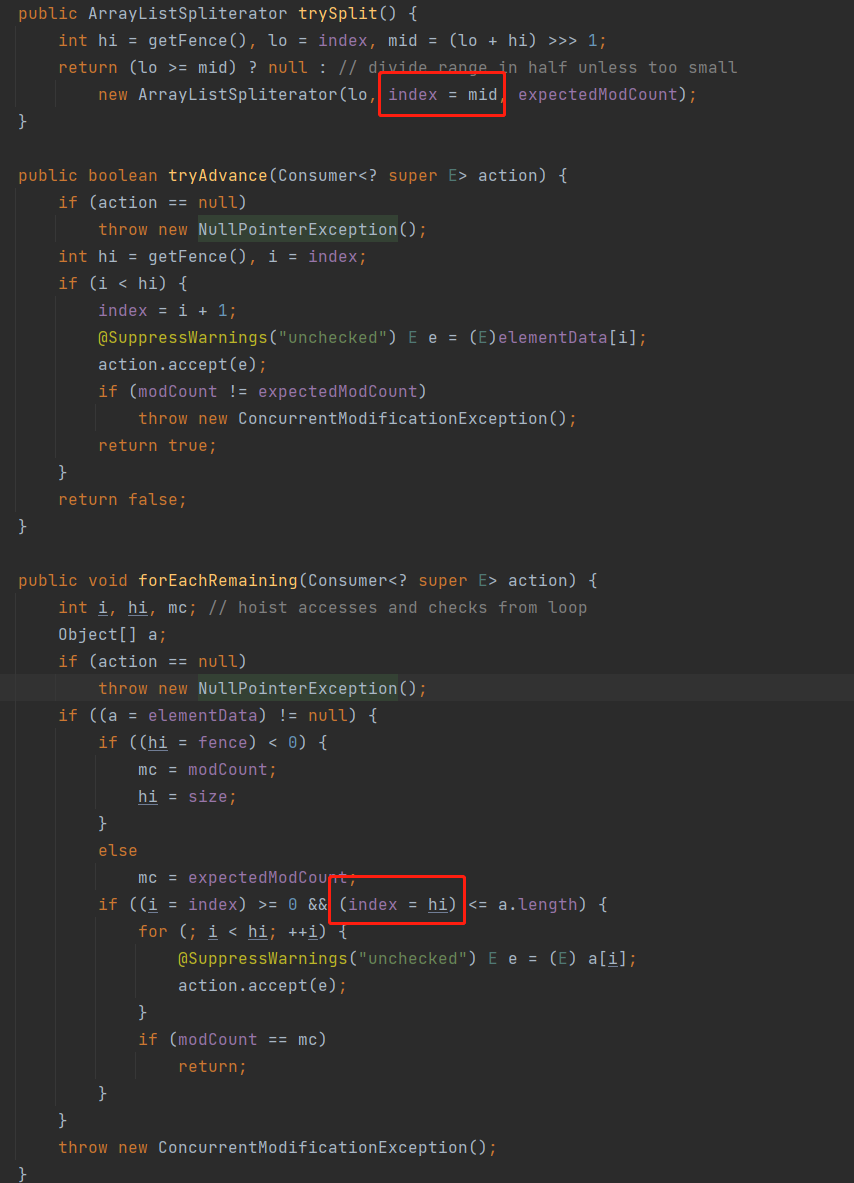

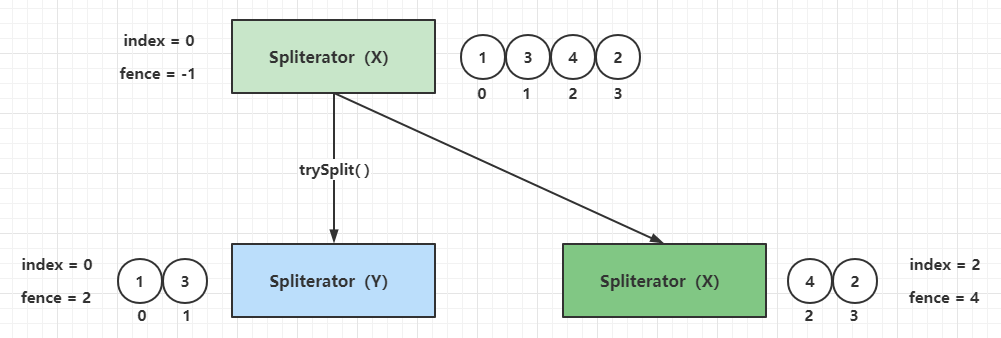

参看ArrayListSpliterator的源码,可以分析其分割算法实现:

// ArrayList#spliterator()

public Spliterator<E> spliterator() {

return new ArrayListSpliterator(0, -1, 0);

}

// ArrayList中内部类ArrayListSpliterator

final class ArrayListSpliterator implements Spliterator<E> {

// 当前的处理的元素索引值,其实是剩余元素的下边界值(包含),在tryAdvance()或者trySplit()方法中被修改,一般初始值为0

private int index;

// 栅栏,其实是元素索引值的上边界值(不包含),一般初始化的时候为-1,使用时具体值为元素索引值上边界加1

private int fence;

// 预期的修改次数,一般初始化值等于modCount

private int expectedModCount;

ArrayListSpliterator(int origin, int fence, int expectedModCount) {

this.index = origin;

this.fence = fence;

this.expectedModCount = expectedModCount;

}

// 获取元素索引值的上边界值,如果小于0,则把hi和fence都赋值为(ArrayList中的)size,expectedModCount赋值为(ArrayList中的)modCount,返回上边界值

// 这里注意if条件中有赋值语句hi = fence,也就是此方法调用过程中临时变量hi总是重新赋值为fence,fence是ArrayListSpliterator实例中的成员属性

private int getFence() {

int hi;

if ((hi = fence) < 0) {

expectedModCount = modCount;

hi = fence = size;

}

return hi;

}

// Spliterator自分割,这里采用了二分法

public ArrayListSpliterator trySplit() {

// hi等于当前ArrayListSpliterator实例中的fence变量,相当于获取剩余元素的上边界值

// lo等于当前ArrayListSpliterator实例中的index变量,相当于获取剩余元素的下边界值

// mid = (lo + hi) >>> 1,这里的无符号右移动1位运算相当于(lo + hi)/2

int hi = getFence(), lo = index, mid = (lo + hi) >>> 1;

// 当lo >= mid的时候为不可分割,返回NULL,否则,以index = lo,fence = mid和expectedModCount = expectedModCount创建一个新的ArrayListSpliterator

// 这里有个细节之处,在新的ArrayListSpliterator构造参数中,当前的index被重新赋值为index = mid,这一点容易看漏,老程序员都喜欢做这样的赋值简化

// lo >= mid返回NULL的时候,不会创建新的ArrayListSpliterator,也不会修改当前ArrayListSpliterator中的参数

return (lo >= mid) ? null : new ArrayListSpliterator(lo, index = mid, expectedModCount);

}

// tryAdvance实现

public boolean tryAdvance(Consumer<? super E> action) {

if (action == null)

throw new NullPointerException();

// 获取迭代的上下边界

int hi = getFence(), i = index;

// 由于前面分析下边界是包含关系,上边界是非包含关系,所以这里要i < hi而不是i <= hi

if (i < hi) {

index = i + 1;

// 这里的elementData来自ArrayList中,也就是前文经常提到的元素数组容器,这里是直接通过元素索引访问容器中的数据

@SuppressWarnings("unchecked") E e = (E)elementData[i];

// 对传入的Action进行回调

action.accept(e);

// 并发修改异常判断

if (modCount != expectedModCount)

throw new ConcurrentModificationException();

return true;

}

return false;

}

// forEachRemaining实现,这里没有采用默认实现,而是完全覆盖实现一个新方法

public void forEachRemaining(Consumer<? super E> action) {

// 这里会新建所需的中间变量,i为index的中间变量,hi为fence的中间变量,mc为expectedModCount的中间变量

int i, hi, mc;

Object[] a;

if (action == null)

throw new NullPointerException();

// 判断容器数组存在性

if ((a = elementData) != null) {

// hi、fence和mc初始化

if ((hi = fence) < 0) {

mc = modCount;

hi = size;

}

else

mc = expectedModCount;

// 这里就是先做参数合法性校验,再遍历临时数组容器a中中[i,hi)的剩余元素对传入的Action进行回调

// 这里注意有一处隐蔽的赋值(index = hi),下界被赋值为上界,意味着每个ArrayListSpliterator实例只能调用一次forEachRemaining()方法

if ((i = index) >= 0 && (index = hi) <= a.length) {

for (; i < hi; ++i) {

@SuppressWarnings("unchecked") E e = (E) a[i];

action.accept(e);

}

// 这里校验ArrayList的modCount和mc是否一致,理论上在forEachRemaining()遍历期间,不能对数组容器进行元素的新增或者移除,一旦发生modCount更变会抛出异常

if (modCount == mc)

return;

}

}

throw new ConcurrentModificationException();

}

// 获取剩余元素估计值,就是用剩余元素索引上边界直接减去下边界

public long estimateSize() {

return getFence() - index;

}

// 具备ORDERED、SIZED和SUBSIZED特性

public int characteristics() {

return Spliterator.ORDERED | Spliterator.SIZED | Spliterator.SUBSIZED;

}

}

在阅读源码的时候务必注意,老一辈的程序员有时候会采用比较隐蔽的赋值方式,笔者认为需要展开一下:

第一处红圈位置在构建新的ArrayListSpliterator的时候,当前ArrayListSpliterator的index属性也被修改了,过程如下图:

第二处红圈位置,在forEachRemaining()方法调用时候做参数校验,并且if分支里面把index(下边界值)赋值为hi(上边界值),那么一个ArrayListSpliterator实例中的forEachRemaining()方法的遍历操作必定只会执行一次。可以这样验证一下:

public static void main(String[] args) {

List<Integer> list = new ArrayList<>();

list.add(2);

list.add(1);

list.add(3);

Spliterator<Integer> spliterator = list.stream().spliterator();

final AtomicInteger round = new AtomicInteger(1);

spliterator.forEachRemaining(num -> System.out.printf("[第一次遍历forEachRemaining]第%d轮回调Action,值:%d\n", round.getAndIncrement(), num));

round.set(1);

spliterator.forEachRemaining(num -> System.out.printf("[第二次遍历forEachRemaining]第%d轮回调Action,值:%d\n", round.getAndIncrement(), num));

}

// 控制台输出

[第一次遍历forEachRemaining]第1轮回调Action,值:2

[第一次遍历forEachRemaining]第2轮回调Action,值:1

[第一次遍历forEachRemaining]第3轮回调Action,值:3

对于ArrayListSpliterator的实现可以确认下面几点:

- 一个新的

ArrayListSpliterator实例中的forEachRemaining()方法只能调用一次 ArrayListSpliterator实例中的forEachRemaining()方法遍历元素的边界是[index, fence)ArrayListSpliterator自分割的时候,分割出来的新ArrayListSpliterator负责处理元素下标小的分段(类比fork的左分支),而原ArrayListSpliterator负责处理元素下标大的分段(类比fork的右分支)ArrayListSpliterator提供的estimateSize()方法得到的分段元素剩余数量是一个准确值

如果把上面的例子继续分割,可以得到下面的过程:

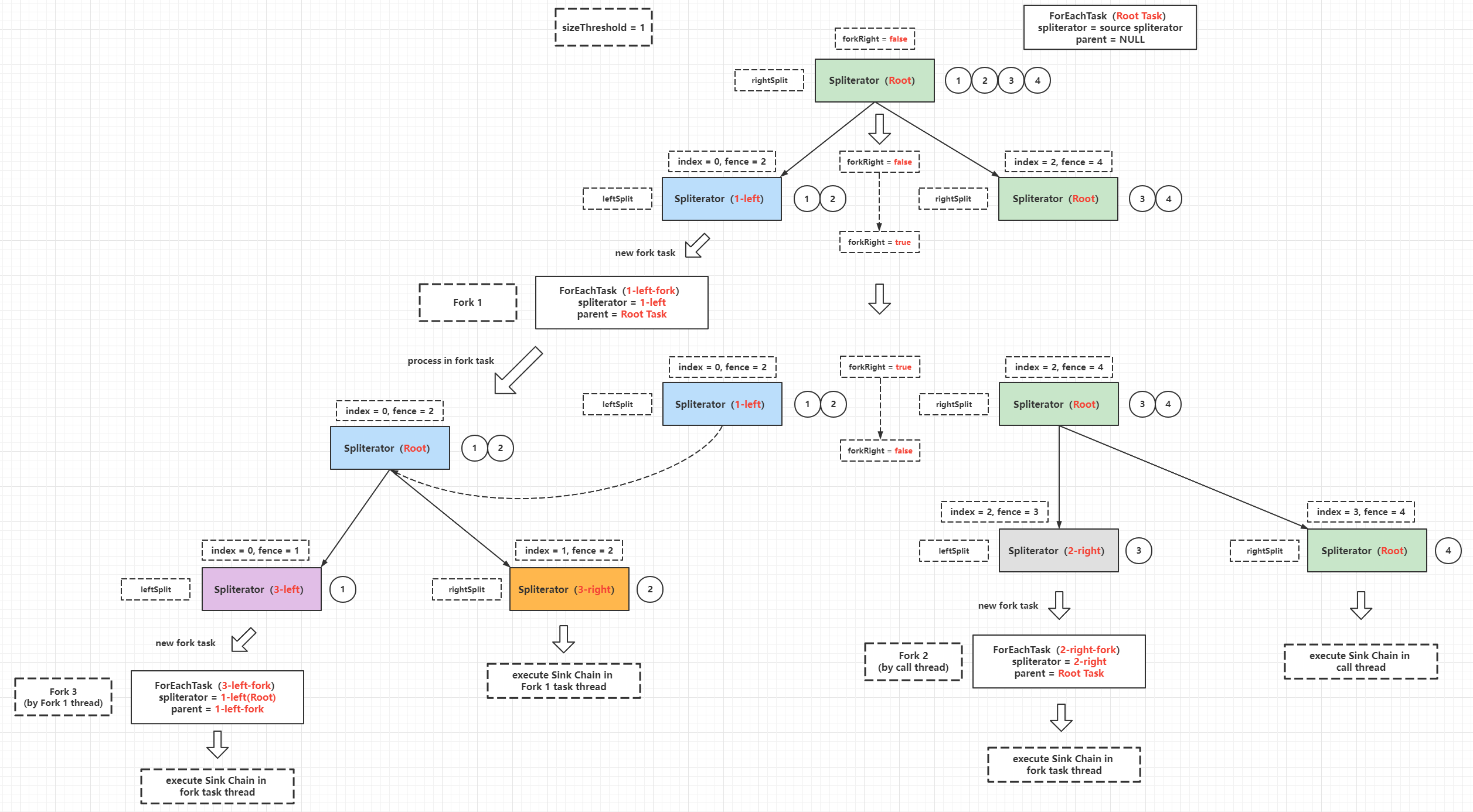

Spliterator自分割是并行流实现的基础,并行流计算过程其实就是fork-join的处理过程,trySplit()方法的实现决定了fork任务的粒度,每个fork任务进行计算的时候是并发安全的,这一点由线程封闭(线程栈封闭)保证,每一个fork任务计算完成最后的结果再由单个线程进行join操作,才能得到正确的结果。下面的例子是求整数1 ~ 100的和:

public class ConcurrentSplitCalculateSum {

private static class ForkTask extends Thread {

private int result = 0;

private final Spliterator<Integer> spliterator;

private final CountDownLatch latch;

public ForkTask(Spliterator<Integer> spliterator,

CountDownLatch latch) {

this.spliterator = spliterator;

this.latch = latch;

}

@Override

public void run() {

long start = System.currentTimeMillis();

spliterator.forEachRemaining(num -> result = result + num);

long end = System.currentTimeMillis();

System.out.printf("线程[%s]完成计算任务,当前段计算结果:%d,耗时:%d ms\n",

Thread.currentThread().getName(), result, end - start);

latch.countDown();

}

public int result() {

return result;

}

}

private static int join(List<ForkTask> tasks) {

int result = 0;

for (ForkTask task : tasks) {

result = result + task.result();

}

return result;

}

private static final int THREAD_NUM = 4;

public static void main(String[] args) throws Exception {

List<Integer> source = new ArrayList<>();

for (int i = 1; i < 101; i++) {

source.add(i);

}

Spliterator<Integer> root = source.stream().spliterator();

List<Spliterator<Integer>> spliteratorList = new ArrayList<>();

Spliterator<Integer> x = root.trySplit();

Spliterator<Integer> y = x.trySplit();

Spliterator<Integer> z = root.trySplit();

spliteratorList.add(root);

spliteratorList.add(x);

spliteratorList.add(y);

spliteratorList.add(z);

List<ForkTask> tasks = new ArrayList<>();

CountDownLatch latch = new CountDownLatch(THREAD_NUM);

for (int i = 0; i < THREAD_NUM; i++) {

ForkTask task = new ForkTask(spliteratorList.get(i), latch);

task.setName("fork-task-" + (i + 1));

tasks.add(task);

}

tasks.forEach(Thread::start);

latch.await();

int result = join(tasks);

System.out.println("最终计算结果为:" + result);

}

}

// 控制台输出结果

线程[fork-task-4]完成计算任务,当前段计算结果:1575,耗时:0 ms

线程[fork-task-2]完成计算任务,当前段计算结果:950,耗时:1 ms

线程[fork-task-3]完成计算任务,当前段计算结果:325,耗时:1 ms

线程[fork-task-1]完成计算任务,当前段计算结果:2200,耗时:1 ms

最终计算结果为:5050

当然,最终并行流的计算用到了ForkJoinPool,并不像这个例子中这么粗暴地进行异步执行。关于并行流的实现下文会详细分析。

Spliterator 支持特性

某一个Spliterator实例支持的特性由方法characteristics()决定,这个方法返回的是一个32位数值,实际使用中会展开为bit数组,所有的特性分配在不同的位上,而hasCharacteristics(int characteristics)就是通过输入的具体特性值通过位运算判断该特性是否存在于characteristics()中。下面简化characteristics为byte分析一下这个技巧:

假设:byte characteristics() => 也就是最多8个位用于表示特性集合,如果每个位只表示一种特性,那么可以总共表示8种特性

特性X:0000 0001

特性Y:0000 0010

以此类推

假设:characteristics = X | Y = 0000 0001 | 0000 0010 = 0000 0011

那么:characteristics & X = 0000 0011 & 0000 0001 = 0000 0001

判断characteristics是否包含X:(characteristics & X) == X

上面推断的过程就是Spliterator中特性判断方法的处理逻辑:

// 返回特性集合

int characteristics();

// 基于位运算判断特性集合中是否存在输入的特性

default boolean hasCharacteristics(int characteristics) {

return (characteristics() & characteristics) == characteristics;

}

这里可以验证一下:

public class CharacteristicsCheck {

public static void main(String[] args) {

System.out.printf("是否存在ORDERED特性:%s\n", hasCharacteristics(Spliterator.ORDERED));

System.out.printf("是否存在SIZED特性:%s\n", hasCharacteristics(Spliterator.SIZED));

System.out.printf("是否存在DISTINCT特性:%s\n", hasCharacteristics(Spliterator.DISTINCT));

}

private static int characteristics() {

return Spliterator.ORDERED | Spliterator.SIZED | Spliterator.SORTED;

}

private static boolean hasCharacteristics(int characteristics) {

return (characteristics() & characteristics) == characteristics;

}

}

// 控制台输出

是否存在ORDERED特性:true

是否存在SIZED特性:true

是否存在DISTINCT特性:false

目前Spliterator支持的特性一共有8个,如下:

| 特性 | 十六进制值 | 二进制值 | 功能 |

|---|---|---|---|

DISTINCT | 0x00000001 | 0000 0000 0000 0001 | 去重,例如对于每对要处理的元素(x,y),使用!x.equals(y)比较,Spliterator中去重实际上基于Set处理 |

ORDERED | 0x00000010 | 0000 0000 0001 0000 | (元素)顺序处理,可以理解为trySplit()、tryAdvance()和forEachRemaining()方法对所有元素处理都保证一个严格的前缀顺序 |

SORTED | 0x00000004 | 0000 0000 0000 0100 | 排序,元素使用getComparator()方法提供的Comparator进行排序,如果定义了SORTED特性,则必须定义ORDERED特性 |

SIZED | 0x00000040 | 0000 0000 0100 0000 | (元素)预估数量,启用此特性,那么Spliterator拆分或者迭代之前,estimateSize()返回的是元素的准确数量 |

NONNULL | 0x00000040 | 0000 0001 0000 0000 | (元素)非NULL,数据源保证Spliterator需要处理的元素不能为NULL,最常用于并发容器中的集合、队列和Map |

IMMUTABLE | 0x00000400 | 0000 0100 0000 0000 | (元素)不可变,数据源不可被修改,也就是处理过程中元素不能被添加、替换和移除(更新属性是允许的) |

CONCURRENT | 0x00001000 | 0001 0000 0000 0000 | (元素源)的修改是并发安全的,意味着多线程在数据源中添加、替换或者移除元素在不需要额外的同步条件下是并发安全的 |

SUBSIZED | 0x00004000 | 0100 0000 0000 0000 | (子Spliterator元素)预估数量,启用此特性,意味着通过trySplit()方法分割出来的所有子Spliterator(当前Spliterator分割后也属于子Spliterator)都启用SIZED特性 |

细心点观察可以发现:所有特性采用32位的整数存储,使用了隔1位存储的策略,位下标和特性的映射是:(0 => DISTINCT)、(3 => SORTED)、(5 => ORDERED)、(7=> SIZED)、(9 => NONNULL)、(11 => IMMUTABLE)、(13 => CONCURRENT)、(15 => SUBSIZED)

所有特性的功能这里只概括了核心的定义,还有一些小字或者特例描述限于篇幅没有完全加上,这一点可以参考具体的源码中的API注释。这些特性最终会转化为StreamOpFlag再提供给Stream中的操作判断使用,由于StreamOpFlag会更加复杂,下文再进行详细分析。

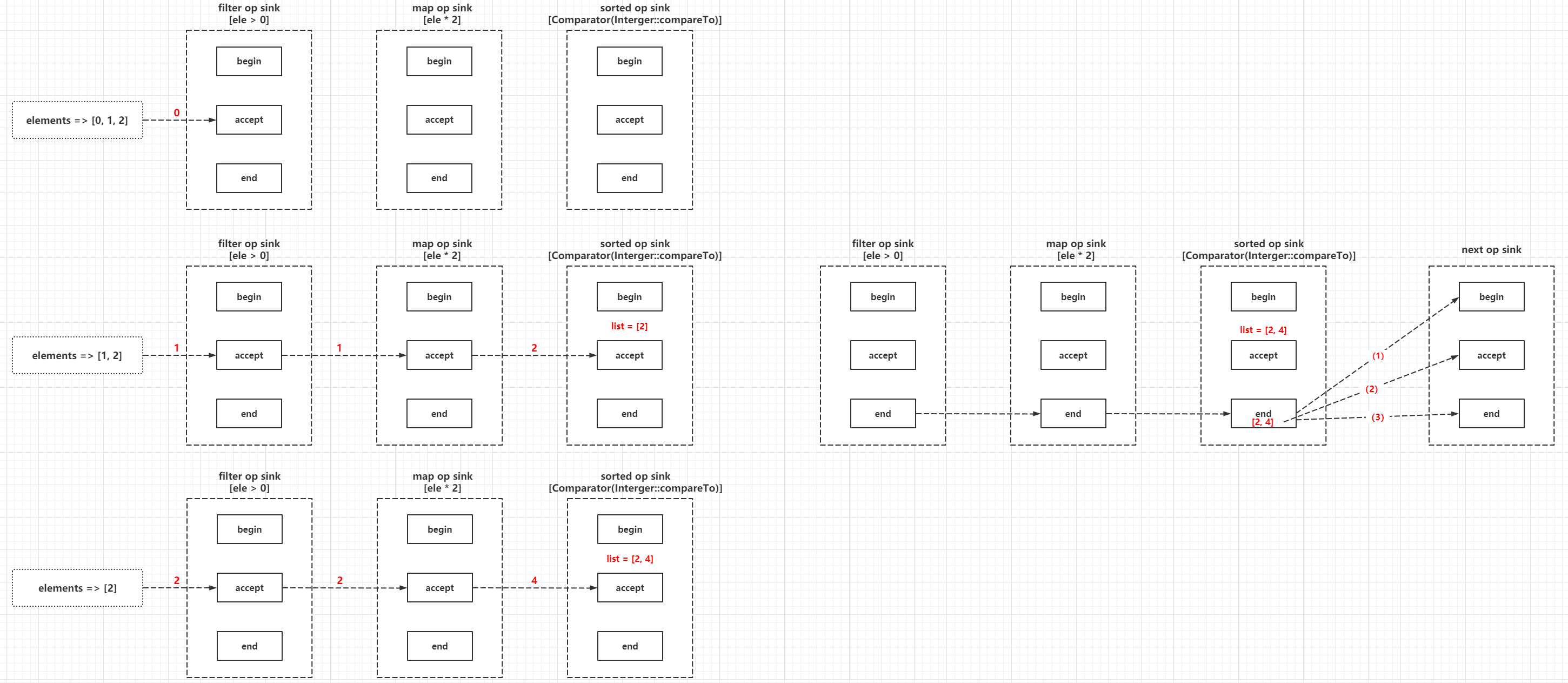

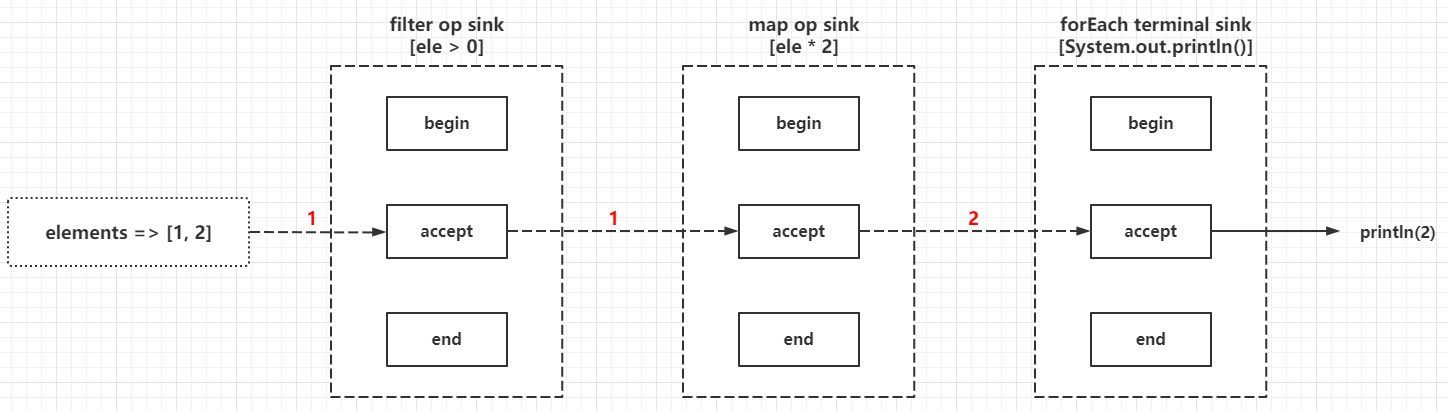

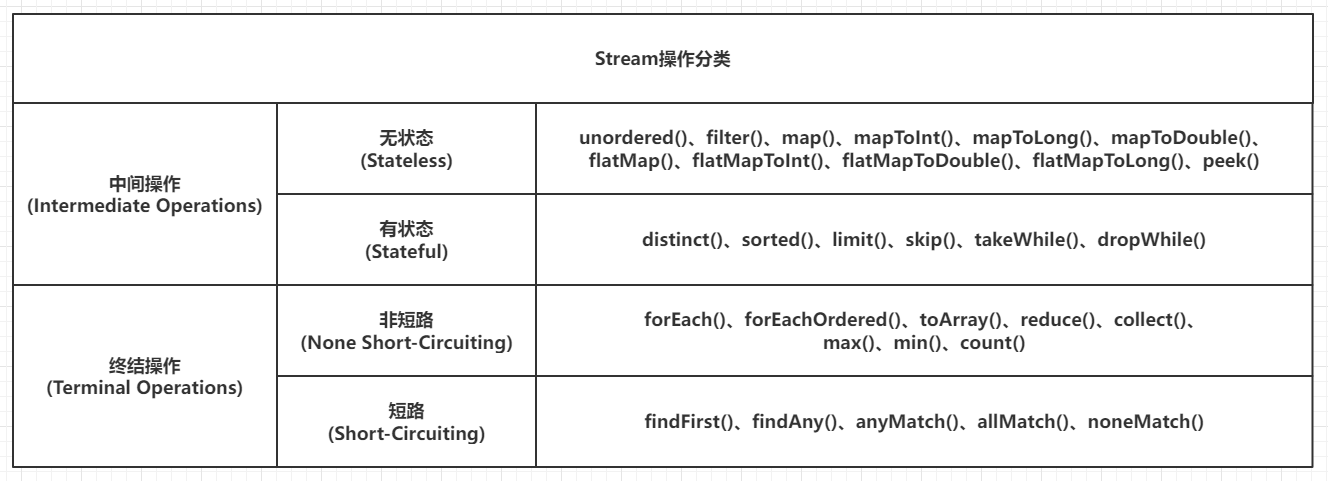

流的实现原理以及源码分析

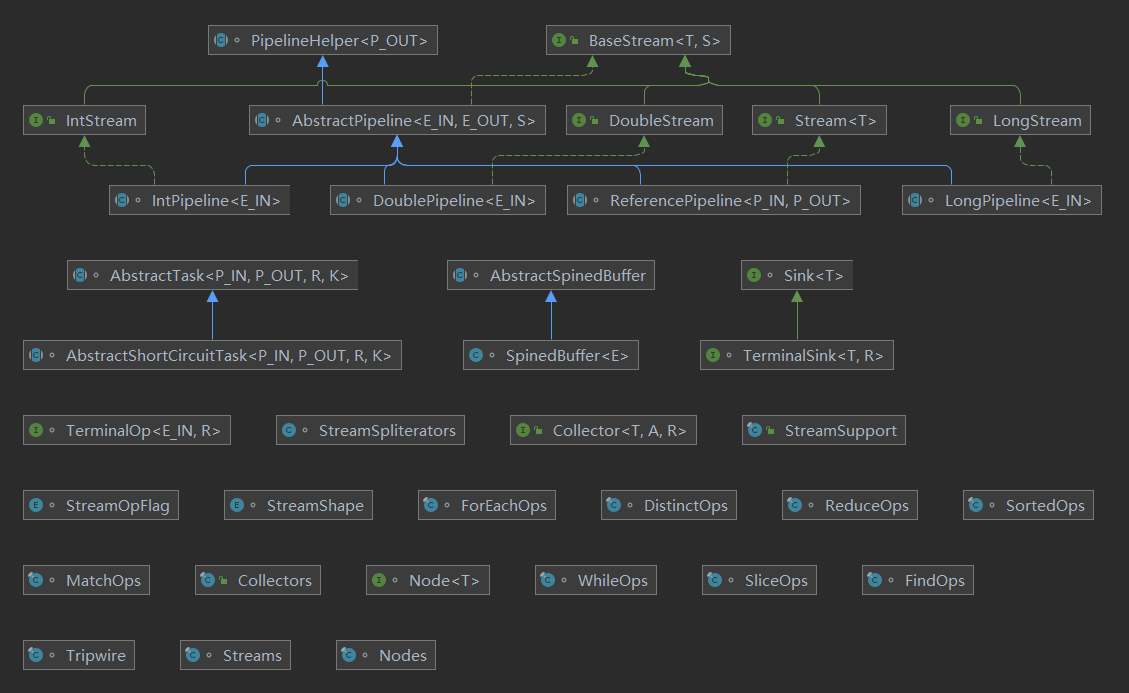

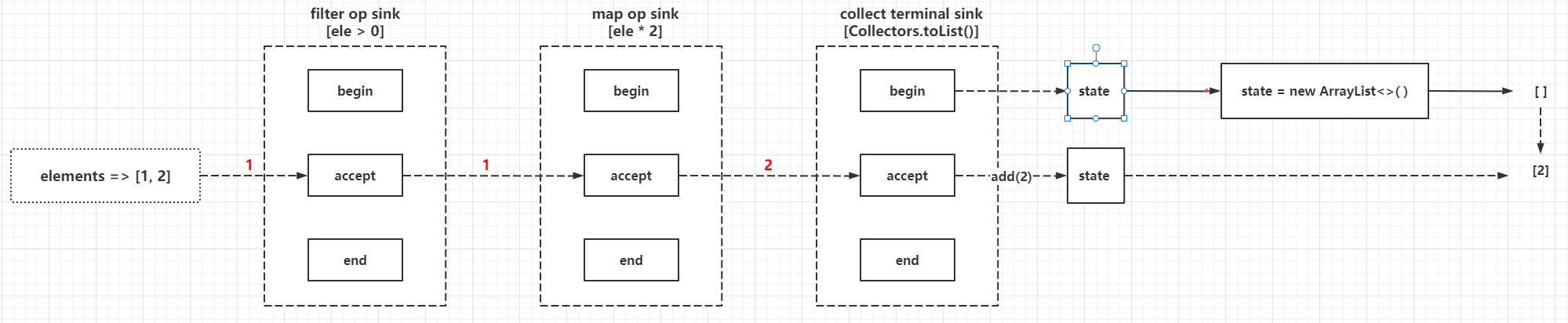

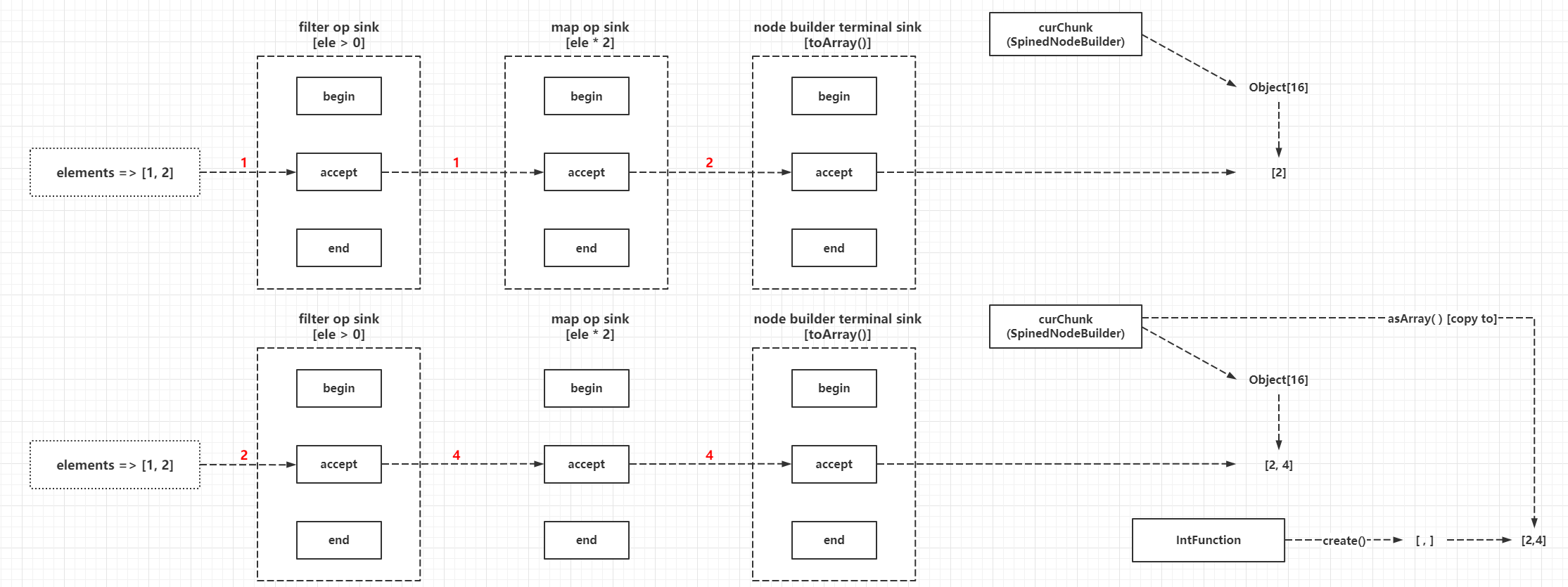

由于流的实现是高度抽象的工程代码,所以在源码阅读上会有点困难。整个体系涉及到大量的接口、类和枚举,如下图:

图中的顶层类结构图描述的就是流的流水线相关类继承关系,其中IntStream、LongStream和DoubleStream都是特化类型,分别针对于Integer、Long和Double三种类型,其他引用类型构建的Pipeline都是ReferencePipeline实例,因此笔者认为,ReferencePipeline(引用类型流水线)是流的核心数据结构,下面会基于ReferencePipeline的实现做深入分析。

StreamOpFlag源码分析

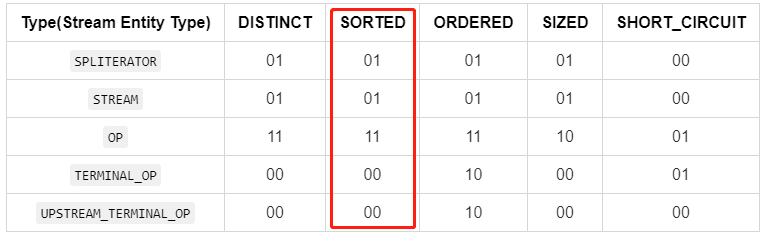

StreamOpFlag是一个枚举,功能是存储Stream和操作的标志(Flags corresponding to characteristics of streams and operations,下称Stream标志),这些标志提供给Stream框架用于控制、定制化和优化计算。Stream标志可以用于描述与流相关联的若干不同实体的特征,这些实体包括:Stream的源、Stream的中间操作(Op)和Stream的终端操作(Terminal Op)。但是并非所有的Stream标志对所有的Stream实体都具备意义,目前这些实体和标志映射关系如下:

| Type(Stream Entity Type) | DISTINCT | SORTED | ORDERED | SIZED | SHORT_CIRCUIT |

|---|---|---|---|---|---|

SPLITERATOR | 01 | 01 | 01 | 01 | 00 |

STREAM | 01 | 01 | 01 | 01 | 00 |

OP | 11 | 11 | 11 | 10 | 01 |

TERMINAL_OP | 00 | 00 | 10 | 00 | 01 |

UPSTREAM_TERMINAL_OP | 00 | 00 | 10 | 00 | 00 |

其中:

- 01:表示设置/注入

- 10:表示清除

- 11:表示保留

- 00:表示初始化值(默认填充值),这是一个关键点,

0值表示绝对不会是某个类型的标志

StreamOpFlag的顶部注释中还有一个表格如下:

| - | DISTINCT | SORTED | ORDERED | SIZED | SHORT_CIRCUIT |

|---|---|---|---|---|---|

Stream source(Stream的源) | Y | Y | Y | Y | N |

| Intermediate operation(中间操作) | PCI | PCI | PCI | PC | PI |

| Terminal operation(终结操作) | N | N | PC | N | PI |

标记 -> 含义:

Y:允许N:非法P:保留C:清除I:注入- 组合

PCI:可以保留、清除或者注入 - 组合

PC:可以保留或者清除 - 组合

PI:可以保留或者注入

两个表格其实是在描述同一个结论,可以相互对照和理解,但是最终实现参照于第一个表的定义。注意一点:这里的preserved(P)表示保留的意思,如果Stream实体某个标志被赋值为preserved,意味着该实体可以使用此标志代表的特性。例如此小节第一个表格中的OP的DISTINCT、SORTED和ORDERED都赋值为11(preserved),意味着OP类型的实体允许使用去重、自然排序和顺序处理特性。回到源码部分,先看StreamOpFlag的核心属性和构造器:

enum StreamOpFlag {

// 暂时忽略其他代码

// 类型枚举,Stream相关实体类型

enum Type {

// SPLITERATOR类型,关联所有和Spliterator相关的特性

SPLITERATOR,

// STREAM类型,关联所有和Stream相关的标志

STREAM,

// STREAM类型,关联所有和Stream中间操作相关的标志

OP,

// TERMINAL_OP类型,关联所有和Stream终结操作相关的标志

TERMINAL_OP,

// UPSTREAM_TERMINAL_OP类型,关联所有在最后一个有状态操作边界上游传播的终止操作标志

// 这个类型的意义直译有点拗口,不过实际上在JDK11源码中,这个类型没有被流相关功能引用,暂时可以忽略

UPSTREAM_TERMINAL_OP

}

// 设置/注入标志的bit模式,二进制数0001,十进制数1

private static final int SET_BITS = 0b01;

// 清除标志的bit模式,二进制数0010,十进制数2

private static final int CLEAR_BITS = 0b10;

// 保留标志的bit模式,二进制数0011,十进制数3

private static final int PRESERVE_BITS = 0b11;

// 掩码建造器工厂方法,注意这个方法用于实例化MaskBuilder

private static MaskBuilder set(Type t) {

return new MaskBuilder(new EnumMap<>(Type.class)).set(t);

}

// 私有静态内部类,掩码建造器,里面的map由上面的set(Type t)方法得知是EnumMap实例

private static class MaskBuilder {

// Type -> SET_BITS|CLEAR_BITS|PRESERVE_BITS|0

final Map<Type, Integer> map;

MaskBuilder(Map<Type, Integer> map) {

this.map = map;

}

// 设置类型和对应的掩码

MaskBuilder mask(Type t, Integer i) {

map.put(t, i);

return this;

}

// 对类型添加/inject

MaskBuilder set(Type t) {

return mask(t, SET_BITS);

}

MaskBuilder clear(Type t) {

return mask(t, CLEAR_BITS);

}

MaskBuilder setAndClear(Type t) {

return mask(t, PRESERVE_BITS);

}

// 这里的build方法对于类型中的NULL掩码填充为0,然后把map返回

Map<Type, Integer> build() {

for (Type t : Type.values()) {

map.putIfAbsent(t, 0b00);

}

return map;

}

}

// 类型->掩码映射

private final Map<Type, Integer> maskTable;

// bit的起始偏移量,控制下面set、clear和preserve的起始偏移量

private final int bitPosition;

// set/inject的bit set(map),其实准确来说应该是一个表示set/inject的bit map

private final int set;

// clear的bit set(map),其实准确来说应该是一个表示clear的bit map

private final int clear;

// preserve的bit set(map),其实准确来说应该是一个表示preserve的bit map

private final int preserve;

private StreamOpFlag(int position, MaskBuilder maskBuilder) {

// 这里会基于MaskBuilder初始化内部的EnumMap

this.maskTable = maskBuilder.build();

// Two bits per flag <= 这里会把入参position放大一倍

position *= 2;

this.bitPosition = position;

this.set = SET_BITS << position; // 设置/注入标志的bit模式左移2倍position

this.clear = CLEAR_BITS << position; // 清除标志的bit模式左移2倍position

this.preserve = PRESERVE_BITS << position; // 保留标志的bit模式左移2倍position

}

// 省略中间一些方法

// 下面这些静态变量就是直接返回标志对应的set/injec、清除和保留的bit map

/**

* The bit value to set or inject {@link #DISTINCT}.

*/

static final int IS_DISTINCT = DISTINCT.set;

/**

* The bit value to clear {@link #DISTINCT}.

*/

static final int NOT_DISTINCT = DISTINCT.clear;

/**

* The bit value to set or inject {@link #SORTED}.

*/

static final int IS_SORTED = SORTED.set;

/**

* The bit value to clear {@link #SORTED}.

*/

static final int NOT_SORTED = SORTED.clear;

/**

* The bit value to set or inject {@link #ORDERED}.

*/

static final int IS_ORDERED = ORDERED.set;

/**

* The bit value to clear {@link #ORDERED}.

*/

static final int NOT_ORDERED = ORDERED.clear;

/**

* The bit value to set {@link #SIZED}.

*/

static final int IS_SIZED = SIZED.set;

/**

* The bit value to clear {@link #SIZED}.

*/

static final int NOT_SIZED = SIZED.clear;

/**

* The bit value to inject {@link #SHORT_CIRCUIT}.

*/

static final int IS_SHORT_CIRCUIT = SHORT_CIRCUIT.set;

}

又因为StreamOpFlag是一个枚举,一个枚举成员是一个独立的标志,而一个标志会对多个Stream实体类型产生作用,所以它的一个成员描述的是上面实体和标志映射关系的一个列(竖着看):

// 纵向看

DISTINCT Flag:

maskTable: {

SPLITERATOR: 0000 0001,

STREAM: 0000 0001,

OP: 0000 0011,

TERMINAL_OP: 0000 0000,

UPSTREAM_TERMINAL_OP: 0000 0000

}

position(input): 0

bitPosition: 0

set: 1 => 0000 0000 0000 0000 0000 0000 0000 0001

clear: 2 => 0000 0000 0000 0000 0000 0000 0000 0010

preserve: 3 => 0000 0000 0000 0000 0000 0000 0000 0011

SORTED Flag:

maskTable: {

SPLITERATOR: 0000 0001,

STREAM: 0000 0001,

OP: 0000 0011,

TERMINAL_OP: 0000 0000,

UPSTREAM_TERMINAL_OP: 0000 0000

}

position(input): 1

bitPosition: 2

set: 4 => 0000 0000 0000 0000 0000 0000 0000 0100

clear: 8 => 0000 0000 0000 0000 0000 0000 0000 1000

preserve: 12 => 0000 0000 0000 0000 0000 0000 0000 1100

ORDERED Flag:

maskTable: {

SPLITERATOR: 0000 0001,

STREAM: 0000 0001,

OP: 0000 0011,

TERMINAL_OP: 0000 0010,

UPSTREAM_TERMINAL_OP: 0000 0010

}

position(input): 2

bitPosition: 4

set: 16 => 0000 0000 0000 0000 0000 0000 0001 0000

clear: 32 => 0000 0000 0000 0000 0000 0000 0010 0000

preserve: 48 => 0000 0000 0000 0000 0000 0000 0011 0000

SIZED Flag:

maskTable: {

SPLITERATOR: 0000 0001,

STREAM: 0000 0001,

OP: 0000 0010,

TERMINAL_OP: 0000 0000,

UPSTREAM_TERMINAL_OP: 0000 0000

}

position(input): 3

bitPosition: 6

set: 64 => 0000 0000 0000 0000 0000 0000 0100 0000

clear: 128 => 0000 0000 0000 0000 0000 0000 1000 0000

preserve: 192 => 0000 0000 0000 0000 0000 0000 1100 0000

SHORT_CIRCUIT Flag:

maskTable: {

SPLITERATOR: 0000 0000,

STREAM: 0000 0000,

OP: 0000 0001,

TERMINAL_OP: 0000 0001,

UPSTREAM_TERMINAL_OP: 0000 0000

}

position(input): 12

bitPosition: 24

set: 16777216 => 0000 0001 0000 0000 0000 0000 0000 0000

clear: 33554432 => 0000 0010 0000 0000 0000 0000 0000 0000

preserve: 50331648 => 0000 0011 0000 0000 0000 0000 0000 0000

接着就用到按位与(&)和按位或(|)的操作,假设A = 0001、B = 0010、C = 1000,那么:

A|B = A | B = 0001 | 0010 = 0011(按位或,1|0=1, 0|1=1,0|0 =0,1|1=1)A&B = A & B = 0001 | 0010 = 0000(按位与,1|0=0, 0|1=0,0|0 =0,1|1=1)MASK = A | B | C = 0001 | 0010 | 1000 = 1011- 那么判断

A|B是否包含A的条件为:A == (A|B & A) - 那么判断

MASK是否包含A的条件为:A == MASK & A

这里把StreamOpFlag中的枚举套用进去分析:

static int DISTINCT_SET = 0b0001;

static int SORTED_CLEAR = 0b1000;

public static void main(String[] args) throws Exception {

// 支持DISTINCT标志和不支持SORTED标志

int flags = DISTINCT_SET | SORTED_CLEAR;

System.out.println(Integer.toBinaryString(flags));

System.out.printf("支持DISTINCT标志:%s\n", DISTINCT_SET == (DISTINCT_SET & flags));

System.out.printf("不支持SORTED标志:%s\n", SORTED_CLEAR == (SORTED_CLEAR & flags));

}

// 控制台输出

1001

支持DISTINCT标志:true

不支持SORTED标志:true

由于StreamOpFlag的修饰符是默认,不能直接使用,可以把它的代码拷贝出来修改包名验证里面的功能:

public static void main(String[] args) {

int flags = StreamOpFlag.DISTINCT.set | StreamOpFlag.SORTED.clear;

System.out.println(StreamOpFlag.DISTINCT.set == (StreamOpFlag.DISTINCT.set & flags));

System.out.println(StreamOpFlag.SORTED.clear == (StreamOpFlag.SORTED.clear & flags));

}

// 输出

true

true

下面这些方法就是基于这些运算特性而定义的:

enum StreamOpFlag {

// 暂时忽略其他代码

// 返回当前StreamOpFlag的set/inject的bit map

int set() {

return set;

}

// 返回当前StreamOpFlag的清除的bit map

int clear() {

return clear;

}

// 这里判断当前StreamOpFlag类型->标记映射中Stream类型的标记,如果大于0说明不是初始化状态,那么当前StreamOpFlag就是Stream相关的标志

boolean isStreamFlag() {

return maskTable.get(Type.STREAM) > 0;

}

// 这里就用到按位与判断输入的flags中是否设置当前StreamOpFlag(StreamOpFlag.set)

boolean isKnown(int flags) {

return (flags & preserve) == set;

}

// 这里就用到按位与判断输入的flags中是否清除当前StreamOpFlag(StreamOpFlag.clear)

boolean isCleared(int flags) {

return (flags & preserve) == clear;

}

// 这里就用到按位与判断输入的flags中是否保留当前StreamOpFlag(StreamOpFlag.clear)

boolean isPreserved(int flags) {

return (flags & preserve) == preserve;

}

// 判断当前的Stream实体类型是否可以设置本标志,要求Stream实体类型的标志位为set或者preserve,按位与要大于0

boolean canSet(Type t) {

return (maskTable.get(t) & SET_BITS) > 0;

}

// 暂时忽略其他代码

}

这里有个特殊操作,位运算的时候采用了(flags & preserve),理由是:同一个标志中的同一个Stream实体类型只可能存在set/inject、clear和preserve的其中一种,也就是同一个flags中不可能同时存在StreamOpFlag.SORTED.set和StreamOpFlag.SORTED.clear,从语义上已经矛盾,而set/inject、clear和preserve在bit map中的大小(为2位)和位置已经是固定的,preserve在设计的时候为0b11刚好2位取反,因此可以特化为(这个特化也让判断更加严谨):

(flags & set) == set => (flags & preserve) == set

(flags & clear) == clear => (flags & preserve) == clear

(flags & preserve) == preserve => (flags & preserve) == preserve

分析这么多,总的来说,就是想通过一个32位整数,每2位分别表示3种状态,那么一个完整的Flags(标志集合)一共可以表示16种标志(position=[0,15],可以查看API注释,[4,11]和[13,15]的位置是未需实现或者预留的,属于gap)。接着分析掩码Mask的计算过程例子:

// 横向看(位移动运算符优先级高于与或,例如<<的优先级比|高)

SPLITERATOR_CHARACTERISTICS_MASK:

mask(init) = 0

mask(DISTINCT,SPLITERATOR[DISTINCT]=01,bitPosition=0) = 0000 0000 | 0000 0001 << 0 = 0000 0000 | 0000 0001 = 0000 0001

mask(SORTED,SPLITERATOR[SORTED]=01,bitPosition=2) = 0000 0001 | 0000 0001 << 2 = 0000 0001 | 0000 0100 = 0000 0101

mask(ORDERED,SPLITERATOR[ORDERED]=01,bitPosition=4) = 0000 0101 | 0000 0001 << 4 = 0000 0101 | 0001 0000 = 0001 0101

mask(SIZED,SPLITERATOR[SIZED]=01,bitPosition=6) = 0001 0101 | 0000 0001 << 6 = 0001 0101 | 0100 0000 = 0101 0101

mask(SHORT_CIRCUIT,SPLITERATOR[SHORT_CIRCUIT]=00,bitPosition=24) = 0101 0101 | 0000 0000 << 24 = 0101 0101 | 0000 0000 = 0101 0101

mask(final) = 0000 0000 0000 0000 0000 0000 0101 0101(二进制)、85(十进制)

STREAM_MASK:

mask(init) = 0

mask(DISTINCT,SPLITERATOR[DISTINCT]=01,bitPosition=0) = 0000 0000 | 0000 0001 << 0 = 0000 0000 | 0000 0001 = 0000 0001

mask(SORTED,SPLITERATOR[SORTED]=01,bitPosition=2) = 0000 0001 | 0000 0001 << 2 = 0000 0001 | 0000 0100 = 0000 0101

mask(ORDERED,SPLITERATOR[ORDERED]=01,bitPosition=4) = 0000 0101 | 0000 0001 << 4 = 0000 0101 | 0001 0000 = 0001 0101

mask(SIZED,SPLITERATOR[SIZED]=01,bitPosition=6) = 0001 0101 | 0000 0001 << 6 = 0001 0101 | 0100 0000 = 0101 0101

mask(SHORT_CIRCUIT,SPLITERATOR[SHORT_CIRCUIT]=00,bitPosition=24) = 0101 0101 | 0000 0000 << 24 = 0101 0101 | 0000 0000 = 0101 0101

mask(final) = 0000 0000 0000 0000 0000 0000 0101 0101(二进制)、85(十进制)

OP_MASK:

mask(init) = 0

mask(DISTINCT,SPLITERATOR[DISTINCT]=11,bitPosition=0) = 0000 0000 | 0000 0011 << 0 = 0000 0000 | 0000 0011 = 0000 0011

mask(SORTED,SPLITERATOR[SORTED]=11,bitPosition=2) = 0000 0011 | 0000 0011 << 2 = 0000 0011 | 0000 1100 = 0000 1111

mask(ORDERED,SPLITERATOR[ORDERED]=11,bitPosition=4) = 0000 1111 | 0000 0011 << 4 = 0000 1111 | 0011 0000 = 0011 1111

mask(SIZED,SPLITERATOR[SIZED]=10,bitPosition=6) = 0011 1111 | 0000 0010 << 6 = 0011 1111 | 1000 0000 = 1011 1111

mask(SHORT_CIRCUIT,SPLITERATOR[SHORT_CIRCUIT]=01,bitPosition=24) = 1011 1111 | 0000 0001 << 24 = 1011 1111 | 0100 0000 0000 0000 0000 0000 0000 = 0100 0000 0000 0000 0000 1011 1111

mask(final) = 0000 0000 1000 0000 0000 0000 1011 1111(二进制)、16777407(十进制)

TERMINAL_OP_MASK:

mask(init) = 0

mask(DISTINCT,SPLITERATOR[DISTINCT]=00,bitPosition=0) = 0000 0000 | 0000 0000 << 0 = 0000 0000 | 0000 0000 = 0000 0000

mask(SORTED,SPLITERATOR[SORTED]=00,bitPosition=2) = 0000 0000 | 0000 0000 << 2 = 0000 0000 | 0000 0000 = 0000 0000

mask(ORDERED,SPLITERATOR[ORDERED]=10,bitPosition=4) = 0000 0000 | 0000 0010 << 4 = 0000 0000 | 0010 0000 = 0010 0000

mask(SIZED,SPLITERATOR[SIZED]=00,bitPosition=6) = 0010 0000 | 0000 0000 << 6 = 0010 0000 | 0000 0000 = 0010 0000

mask(SHORT_CIRCUIT,SPLITERATOR[SHORT_CIRCUIT]=01,bitPosition=24) = 0010 0000 | 0000 0001 << 24 = 0010 0000 | 0001 0000 0000 0000 0000 0000 0000 = 0001 0000 0000 0000 0000 0010 0000

mask(final) = 0000 0001 0000 0000 0000 0000 0010 0000(二进制)、16777248(十进制)

UPSTREAM_TERMINAL_OP_MASK:

mask(init) = 0

mask(DISTINCT,SPLITERATOR[DISTINCT]=00,bitPosition=0) = 0000 0000 | 0000 0000 << 0 = 0000 0000 | 0000 0000 = 0000 0000

mask(SORTED,SPLITERATOR[SORTED]=00,bitPosition=2) = 0000 0000 | 0000 0000 << 2 = 0000 0000 | 0000 0000 = 0000 0000

mask(ORDERED,SPLITERATOR[ORDERED]=10,bitPosition=4) = 0000 0000 | 0000 0010 << 4 = 0000 0000 | 0010 0000 = 0010 0000

mask(SIZED,SPLITERATOR[SIZED]=00,bitPosition=6) = 0010 0000 | 0000 0000 << 6 = 0010 0000 | 0000 0000 = 0010 0000

mask(SHORT_CIRCUIT,SPLITERATOR[SHORT_CIRCUIT]=00,bitPosition=24) = 0010 0000 | 0000 0000 << 24 = 0010 0000 | 0000 0000 = 0010 0000

mask(final) = 0000 0000 0000 0000 0000 0000 0010 0000(二进制)、32(十进制)

相关的方法和属性如下:

enum StreamOpFlag {

// SPLITERATOR类型的标志bit map

static final int SPLITERATOR_CHARACTERISTICS_MASK = createMask(Type.SPLITERATOR);

// STREAM类型的标志bit map

static final int STREAM_MASK = createMask(Type.STREAM);

// OP类型的标志bit map

static final int OP_MASK = createMask(Type.OP);

// TERMINAL_OP类型的标志bit map

static final int TERMINAL_OP_MASK = createMask(Type.TERMINAL_OP);

// UPSTREAM_TERMINAL_OP类型的标志bit map

static final int UPSTREAM_TERMINAL_OP_MASK = createMask(Type.UPSTREAM_TERMINAL_OP);

// 基于Stream类型,创建对应类型填充所有标志的bit map

private static int createMask(Type t) {

int mask = 0;

for (StreamOpFlag flag : StreamOpFlag.values()) {

mask |= flag.maskTable.get(t) << flag.bitPosition;

}

return mask;

}

// 构造一个标志本身的掩码,就是所有标志都采用保留位表示,目前作为flags == 0时候的初始值

private static final int FLAG_MASK = createFlagMask();

// 构造一个包含全部标志中的preserve位的bit map,按照目前来看是暂时是一个固定值,二进制表示为0011 0000 0000 0000 0000 1111 1111

private static int createFlagMask() {

int mask = 0;

for (StreamOpFlag flag : StreamOpFlag.values()) {

mask |= flag.preserve;

}

return mask;

}

// 构造一个Stream类型包含全部标志中的set位的bit map,这里直接使用了STREAM_MASK,按照目前来看是暂时是一个固定值,二进制表示为0000 0000 0000 0000 0000 0000 0101 0101

private static final int FLAG_MASK_IS = STREAM_MASK;

// 构造一个Stream类型包含全部标志中的clear位的bit map,按照目前来看是暂时是一个固定值,二进制表示为0000 0000 0000 0000 0000 0000 1010 1010

private static final int FLAG_MASK_NOT = STREAM_MASK << 1;

// 初始化操作的标志bit map,目前来看就是Stream的头节点初始化时候需要合并在flags里面的初始化值,照目前来看是暂时是一个固定值,二进制表示为0000 0000 0000 0000 0000 0000 1111 1111

static final int INITIAL_OPS_VALUE = FLAG_MASK_IS | FLAG_MASK_NOT;

}

SPLITERATOR_CHARACTERISTICS_MASK等5个成员(见上面的Mask计算例子)其实就是预先计算好对应的Stream实体类型的所有StreamOpFlag标志的bit map,也就是之前那个展示Stream的类型和标志的映射图的"横向"展示:

前面的分析已经相对详细,过程非常复杂,但是更复杂的Mask应用还在后面的方法。Mask的初始化就是提供给标志的合并(combine)和转化(从Spliterator中的characteristics转化为flags)操作的,见下面的方法:

enum StreamOpFlag {

// 这个方法完全没有注释,只使用在下面的combineOpFlags()方法中

// 从源码来看

// 入参flags == 0的时候,那么直接返回0011 0000 0000 0000 0000 1111 1111

// 入参flags != 0的时候,那么会把当前flags的所有set/inject、clear和preserve所在位在bit map中全部置为0,然后其他位全部置为1

private static int getMask(int flags) {

return (flags == 0)

? FLAG_MASK

: ~(flags | ((FLAG_MASK_IS & flags) << 1) | ((FLAG_MASK_NOT & flags) >> 1));

}

// 合并新的flags和前一个flags,这里还是用到老套路先和Mask按位与,再进行一次按位或

// 作为Stream的头节点的时候,prevCombOpFlags必须为INITIAL_OPS_VALUE

static int combineOpFlags(int newStreamOrOpFlags, int prevCombOpFlags) {

// 0x01 or 0x10 nibbles are transformed to 0x11

// 0x00 nibbles remain unchanged

// Then all the bits are flipped

// Then the result is logically or'ed with the operation flags.

return (prevCombOpFlags & StreamOpFlag.getMask(newStreamOrOpFlags)) | newStreamOrOpFlags;

}

// 通过合并后的flags,转换出Stream类型的flags

static int toStreamFlags(int combOpFlags) {

// By flipping the nibbles 0x11 become 0x00 and 0x01 become 0x10

// Shift left 1 to restore set flags and mask off anything other than the set flags

return ((~combOpFlags) >> 1) & FLAG_MASK_IS & combOpFlags;

}

// Stream的标志转换为Spliterator的characteristics

static int toCharacteristics(int streamFlags) {

return streamFlags & SPLITERATOR_CHARACTERISTICS_MASK;

}

// Spliterator的characteristics转换为Stream的标志,入参是Spliterator实例

static int fromCharacteristics(Spliterator<?> spliterator) {

int characteristics = spliterator.characteristics();

if ((characteristics & Spliterator.SORTED) != 0 && spliterator.getComparator() != null) {

// Do not propagate the SORTED characteristic if it does not correspond

// to a natural sort order

return characteristics & SPLITERATOR_CHARACTERISTICS_MASK & ~Spliterator.SORTED;

}

else {

return characteristics & SPLITERATOR_CHARACTERISTICS_MASK;

}

}

// Spliterator的characteristics转换为Stream的标志,入参是Spliterator的characteristics

static int fromCharacteristics(int characteristics) {

return characteristics & SPLITERATOR_CHARACTERISTICS_MASK;

}

}

这里的位运算很复杂,只展示简单的计算结果和相关功能:

combineOpFlags():用于合并新的flags和上一个flags,因为Stream的数据结构是一个Pipeline,后继节点需要合并前驱节点的flags,例如前驱节点flags是ORDERED.set,当前新加入Pipeline的节点(后继节点)的新flags为SIZED.set,那么在后继节点中应该合并前驱节点的标志,简单想象为SIZED.set | ORDERED.set,如果是头节点,那么初始化头节点时候的flags要合并INITIAL_OPS_VALUE,这里举个例子:

int left = ORDERED.set | DISTINCT.set;

int right = SIZED.clear | SORTED.clear;

System.out.println("left:" + Integer.toBinaryString(left));

System.out.println("right:" + Integer.toBinaryString(right));

System.out.println("right mask:" + Integer.toBinaryString(getMask(right)));

System.out.println("combine:" + Integer.toBinaryString(combineOpFlags(right, left)));